>в плане секса

никак, держи свой нефритовый стержень при себе

Как говно, очевидно же. Соя от лламы + соя от китайцев, двойной удар двойная цензура.

Так, а на чем запустить эту модель unslothDeepSeek-R1-Distill-Llama-70B-4bit

Угабуга минус.

Оллама просто идёт в пизду.

Кобольд- он вроде только для гуффов.

Угабуга минус.

Оллама просто идёт в пизду.

Кобольд- он вроде только для гуффов.

> только для гуффов

https://huggingface.co/unsloth/DeepSeek-R1-Distill-Llama-70B-GGUF/tree/main

ищущий да обрящет

> На сколько помню настоящие тернарные биты только специальной тренировкой под них получаются.

Строго говоря, и на специальном железе. =) А тут так, эмуляция.

Можешь начинать с 32b.

Но вообще хз, времени нихуя нет, тестов и так вагон, тока в рабочих вопросах.

Мне качать сутки этот Гуф.

Хотелось бы запустить что уже закачал.

Думал что это exl2, и не знал что Анслот Убабуба не переваривает.

Какие возможности по мультиплеер-рп? Чтобы на моей машине, но мы с кентом по сети. Помнится в аи-данжеон 5 лет назад такое было.

Копипасть сообщения в/на телегу.

>мультиплеер

Бота в телеге сделай чтобы слал запросы по апи к тому же кобольду на твоей жэе машине.

Аноны, какую гуф модель дипписека посоветуете в пределах 100B?

выше блин на несколько постов кто-то уже кидал ссылку

>сайга + анлишед выглядит вкусно

https://huggingface.co/Aleteian/Pathfinder-RP-12B-RU-Q8_0-GGUF

Потести и отпишись насколько вкусно.

- IlyaGusev/saiga_nemo_12b - русская база, новая версия пятидневной давности

- MarinaraSpaghetti/NemoMix-Unleashed-12B - чтобы ебалось веселее

- LatitudeGames/Wayfarer-12B от аи-данжеон - для снижения позитивного биаса

Базовая модель - чистая новая сайга, а не сайговихрь.

Может попробовать сайнемо туда вместо немомикса?

Или какая 12Б прям хорошо кумит по мнению треда?

Гордо обладаю тостером, хз скачал какую-то Олламу для дипсика 14б и его самого. Видюха вообще не используется потому что хз почему, 8 гигов врам потому что наверное, но мне было бы норм с 4 токенами в секунду через ЦП, если бы не фигня что ЦП грузится на все 100%, и комп работает будто это 1998. В help нихуя нет или не нашёл. Вариант 8б и меньше очевидный, пока опускаю, потому что 14б работает же, другие лаунчеры надо разбираться

Что и где мне написать, чтобы он медленнее работал и не грузил сразу 100% ЦП? Сам дипсик посоветовал урезать n_ctx, но опять же, где мне его прописывать-то ёпт, я не программист

Что и где мне написать, чтобы он медленнее работал и не грузил сразу 100% ЦП? Сам дипсик посоветовал урезать n_ctx, но опять же, где мне его прописывать-то ёпт, я не программист

>в США он внезапно обогнал жпт по скачкам приложений

Не сложно обогнать по скачкам, когда твой конкурент уже как несколько месяцев скачан у всех на телефон, а ты новинка и скинул цену до 0. Посмотрим как продержится.

>Видюха вообще не используется потому что хз почему, 8 гигов врам

Производитель и модель у этой видюхи есть?

AMD RX580. Там 8 гигов, но сам дипсик пишет, что ему надо 12-16, что ли

Сайга + немомикс - это же литералли первый сайнемо от Moraliane. И сайнеморемикс, в котором есть хронос и меньше немомикса, вроде как был принят тредовичками лучше. Немомикс имхо сухой даже на инглише. Хронос исходно больше стесняется в куме, но гораздо разнообразнее пишет. На инглише, правда. Русский у него вроде тоже не сильно задавлен тьюном, но не сравнивал с немомиксом.

С каким чат/контекст/инструкт темплейтом дипсик 32b работает в таверне?

>RX580

а ты отчаянный. используй кобольда, рокм форк. может даже заработает. ну или на вулкане, через того-же кобольда. он тебе часть модели загонит в видеокарту, будет приемлемая скорость. в прошлом треде всё было. Оллама - meh.

Еще сори за нубский вопрос. У меня какая-то рандомная говноматеринка пикрил, в нее 2х 3090 влезут, или надо менять?

Олламу совсем никак не настроить, выходит? Там реально что ли никаких настроек нет?

Спасибо, посмотрю кобольда. Так-то мне и на ЦПУ норм, если бы он тихо на заднем фоне работал, но 100% загрузки это явно хуйня

Хуя, у тебя походу х8 на нижний слот. Хотя надо посмотреть откуда.

Да, влезут, но для нижней бери райзер, иначе будет 10 печей из 10, а жечь запретили.

Казалось что хуже было уже нельзя, но они смогли.

Благодари сынов шлюх и членодевок из роскомпозора. Пожалуйся провайдеру что пакеты с репозиториев качает с черепашьей скоростью, пусть чинят.

Эти "дистилл" версии запускаются также как одноименные оригинальные модели.

Раз есть два слота - значит влезут. Чтобы было вообще хорошо - желательно чтобы делились процессорные линии или на втором слоте было хотябы х4 чипсетных а не х2/х1 старых стандартов. Судя по картинке там как раз первый случай и тебе повезло.

>Эти "дистилл" версии запускаются также как одноименные оригинальные модели.

Нет, у меня баги были. А там чел вообще скачал какую-то парашу.

Дистилляты дикпика говно.

Кто-то встречал такой еррор? Вижу впервые, именно на ггуфах немо и его тюнов. Остальные ггуфы загружаются.

Так, падажжи, им шо еще доп охлад нужен? Вы же сказали что там главный затык в памяти, а сам чип хуи пинает.

Сап! Решил расчехлить свою таверну, и не могу найти guf дикпика на 14b или 20b чтобы потрогать его. На хайпе так сказать поэрпэшить ещё раз.

Можете пожалуйста помочь? Простите меня, если это уже тут заебали спрашивать, а наверное заебали.

Можете пожалуйста помочь? Простите меня, если это уже тут заебали спрашивать, а наверное заебали.

Пару вопросов на фоне новой волны хайпа:

В особенность эффективности Deepseek? Пока представление такое, что китайцы, которым не поставляли специлизированые карты сделали модель на ригах для майнинга и у людей недопонимание, или же реально не нужна мощная видяха для этой модели?

Какие реальные у вас задачи для нейронки? Ну кроме оптимизации работы при кодинге и дроча в секс ролевку с персонажами.

В особенность эффективности Deepseek? Пока представление такое, что китайцы, которым не поставляли специлизированые карты сделали модель на ригах для майнинга и у людей недопонимание, или же реально не нужна мощная видяха для этой модели?

Какие реальные у вас задачи для нейронки? Ну кроме оптимизации работы при кодинге и дроча в секс ролевку с персонажами.

Разобрался, в staging версии добавили deepthink 2.5.

>Какие реальные у вас задачи для нейронки?

Составление плана по захвату мира имея трусы и газету.

Ты про какую модель? Оригинал Дипсинка?

В модели 685 миллиардов параметров, что примерно эквивалетно чят-гопоте. Никто её не запускал в этом треде.

Есть дистиллят модели на базе ламы и квена, стандартных размеров(1.5B, 7B, 8В, 14В, 32B, 70В). Нужны ли они - вопрос дискуссионный, пока что я вижу неотменяемый сёр thinking в начале каждой генерации.

>дроча в секс ролевку с персонажами

Это

Разобрался, оказывается гит пул для обновления недостаточно. Апдейт визард скачал новую цпп.

Нужен самый обычный, требования ниже чем в играх и прочем ибо нагрузки малы. Но если ты поставишь две здоровенные карточки подряд - верхняя будет почти полностью перекрыта нижней и будет хуево охлаждаться.

> Пока представление такое, что китайцы, которым не поставляли специлизированые карты сделали модель на ригах для майнинга

Бред, она точно также тренилась на кластерах хуанга и сожрала компьюта не меньше чем одноклассники.

> или же реально не нужна мощная видяха для этой модели

Абсолютно все то же самое.

Это снова я

Поставил таверну с убабугой. Теперь мне надо часто переключаться между текстовой и картиночной сетками и, соответственно, выгружать модель из памяти. Можно ли как-то быстро (по хоткею) это настроить (я вижу это так — нажал кнопку — память освободилась, потом, когда вводишь следующий промпт, модель автоматически подключается)?

Поставил таверну с убабугой. Теперь мне надо часто переключаться между текстовой и картиночной сетками и, соответственно, выгружать модель из памяти. Можно ли как-то быстро (по хоткею) это настроить (я вижу это так — нажал кнопку — память освободилась, потом, когда вводишь следующий промпт, модель автоматически подключается)?

Просто не понимаю в чем хайп этой хуйни и почему отвалились акции нвидии

Вот я новый вкатун (точнее еще даже не вкатун, а только собираюсь). Собираюсь делать игры, где будет дохуя механик на стороне обычного кода, а нейронка будет отыгрывать НПЦ и юзать эти механики. Когда выходила о1, я ей давал тесты, и она их фейлила, а дипсик в чате норм справился. Хуй знает, может о1 или другие сейчас тоже справляются, или локальный дипсик их зафейлит, но в общем теперь я верю, что это уже не просто игрушка для корп, а можно юзать любому бомжу для своих задач.

Просто купи еще одну 3090.

Они изначально были перегреты. Дипписик выступил лишь поводом, причем максимально тупым - его обучали и гоняют на тех же самых картах от невидии.

>в чем хайп этой хуйни

В том что модель примерно равная последней чят гопоте выложили бесплатно?

А так дело в том что пузырь надулся давно и должен был лопнуть.

Сомневаюсь, что серьезные инвесторы будут выводить деньги из Нвидии из-за дефолтной модели. Трамп что-то про пошлины в отношении TSMC говорил, может из-за этого рыночек шатает.

Я не вижу ничего особенного. Даже если представить, что нейронка китайцев лучше во всем, то американские компании от этого не умрут. Запретят дипсик из-за угроз безопасности и напечатают денег для субсидирования своих.

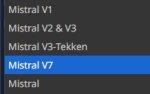

На что мне ориентироваться если например на страничке модели не указано какой лучше формат контекста использовать? Вот у меня мистраль-немо-инструкт. На странице указано что Architecture

llama. Значит ли это что я должен использовать лама 3 инструкт в таверне?

llama. Значит ли это что я должен использовать лама 3 инструкт в таверне?

Ты не понимаешь.

Суть в том что теперь сервис подобный сервису Open AI может представлять бизнесам буквально любой васян, более того, даже васян сделает его более юзабельным чем ихнее говно, державшееся до сих пор только на том, что у них была нормальная модель, а у остальных была лама, уходящая в залупы и бред.

Ты запусти сначала этот локальный дипсик, потом поговорим. Тут нужен какой-нибудь DGX H100 как минимум, и то только квант туда влезет.

В таверне дефолтные настройки под основные модели. Включая разумеется мистраль. Настройки так и называются - mistral.

Это ты не понимаешь.

ChatGPT - это далеко не только LLM-ка. Это очень продвинутая обвязка, которой больше нет ни у кого. CV, RAG, KG - грамотно это все прикрутить к сраному чат-боту не так чтоб очень просто.

У кого у остальных? В реальных задачах Fine-tuned ламу юзали, никто доверять стороннему апи не будет. Сами OpenAI говорили, что 75% профита не на апи приходится, а на подписку.

Через апи убабуги можно делать загрузку/выгрузку модели. Для таверны наверняка уже что-то подобное запилили, или можешь сам замутить.

Учитывай что при каждом запуске сначала модель будет сначала загружаться (если много рам то оно само закеширует и будет быстро), а потом обрабатывать полный контекст.

Байден и нагон инфоповодов по херне как обычно, сейчас побреют бедолаг и опять прыгнет. Или обвалится нахуй если Трамп решит ультануть.

Двачую. В рейтингах сранивают мультимодальный ChatGPT и Deepseek, у которого этого функционала нет.

>Это очень продвинутая обвязка, которой больше нет ни у кого. CV, RAG, KG - грамотно это все прикрутить к сраному чат-боту не так чтоб очень просто.

Сделать обвязку - это всего лишь команда кодеров, это все не требует десятков тысяч видеокарт, как обучение модели.

> Это очень продвинутая обвязка

Для впечатлительных нормисов.

Ну я пока спорить не буду естесно, но посмотрим как будут обрезки работать.

Ну их все равно не мало. Мне бы разобраться, чтобы не ебать мозги треду каждый раз когда у меня затык.

> Сделать обвязку - это всего лишь команда кодеров, это все не требует десятков тысяч видеокарт, как обучение модели.

Вот именно, блядь. Вот именно. Чтобы сделать обвязку, тебе нужна команда высококлассных специалистов, способных не то что решать нестандартные задачи, а ставить их. Таких людей можно по пальцам в мире посчитать. Чтобы обучить жирную LLM нужно просто дохуя данных, дохуя видеокарт и дохуя электричества, что решаемо банально деньгами.

>У кого у остальных?

У компаний, не имевших десятки тысяч видюх для обучения своей модели были на выбор либо подписка Опен Аи, либо собственно нахуевеченные обмотки вокруг ламы.

Теперь компании могут вместо ламы поставить дипсинк и в рот ебать опен аи с их подпиской.

То, что для запуска оригинального дипписика им понадобится суперкомпьютер стоимостью примерно лям баксов, ты скромно умолчишь.

>почему отвалились акции нвидии

Из-за той же причины, почему они вообще резко начали расти. Траяска по поводу нейросетей начала перегревать рынок чипов с 22 года еще сильнее, чем при майнинговой лихорадке. А обвал случился из-за того что шизики нанюхавшись пердежа перестали следить за конкурентами и вдруг осознали, что китайцы тоже что-то могут, но стало уже поздно.

В общем-то ничего не случилось, как и всегда. Зеленые отыграют проебанные копейки и заработают еще больше, ибо это только начало новой волны. Теперь уже всем стало понятно, что аналог гопоты запилить вполне реально, если у тебя есть пара лишних лямов и даже если ты сидишь под санкциями. Пиздец настал только Альтману, но он это итак понимает и уже трясется сильнее обычного.

Ты переоцениваешь задачу, анон. Деньги в мире куда большая проблема чем обученные фронтомакаки.

Чувак, я разработкой этой "хуйни" занимаюсь уже давно. Поверь, построить нормальную инфраструктуру вокруг LLM нифига не тривиально. А так, чтобы она работала как у OpenAI, и вообще почти невозможно.

Деньги же как раз не проблема вообще ни разу. Особенно в США, которым пару лярдов баксов напечатать не стоит ничего.

Хуйню несешь. Достаточно 5-6 Н100 для 4-битной модели, это 150-200к баксов.

> Чтобы сделать обвязку, тебе нужна команда высококлассных специалистов

Да где угодно заказать и будет. Или вообще просто инициативный лидер, который соберет и организует работу команды энтузиастов в опенсорсе за спасибо, вот настолько. Не поверишь, но на гитхабе полно оче крутых проектов для обертки ллм, которые заткнут чатик гопоты с документами за пояс, ищешь по тегу и сортируешь по звездам.

> Таких людей можно по пальцам в мире посчитать.

Макак на каждом углу по 3 копейки за лопату. Запредельного уровня знаний для этого не нужно, это всего лишь интерфейс и операции даже проще того что реализовано в таверне. Это не трудно, это долго.

> Чтобы обучить жирную LLM нужно просто дохуя данных, дохуя видеокарт и дохуя электричества, что решаемо банально деньгами.

А вот это полный бред, вот как раз для такого уже действительно нужно много специалистов, которых может не

> можно по пальцам в мире посчитать

но в большом дефиците.

Потому и хвалишь свое болото, игнорируя куда более сложные вещи, где действительно есть сложности и целая наука.

DeepSeek-R1-Distill-Llama-70B-GGUF

Подтверждаю. Соя ебаная. Просто оторвать и нахуй выкинуть. Говно помоешное блять.

Подтверждаю. Соя ебаная. Просто оторвать и нахуй выкинуть. Говно помоешное блять.

Ты хоть настроил её, блядь?

хорошо зафиксированная лисица в предварительных ласках не нуждается. А хорошо обученная сеть не нуждается в каких-то особенных настройках.

Эта модель обучена выдавать сначала мысли модели, потом сам ответ, без правильных настроек она просто не будет работать, выдавая кашу.

Лол, ты все наизнанку вывернул.

Ну давай, возьми хотя бы Мистраль и прикрути к ней знаниевый граф. Чтобы не просто LLM-ку кормить кусками текстового представления графа, а с нормальным онтологическим МЛВ.

Да ты на этапе поиска научных статей по этой теме уже обосрешься...

Бля, будто их много, лол.

У тебя буквально одна больше, и остальные меньше.

Хочешь 70b бери, хочешь 32b… Кто ж тя знает.

Ты не поверишь, но… =D Память и греется, хуяк фокус!

Ну и вообще, все греется. Чип хуи не пинает, я писал, и вообще, это никто не писал вроде. Просто он участвует не так активно.

Тем не менее, может быть жарковато.

Хотя, если чисто LLM и даунвольтнешь на 20%-50%, то может и не понадобится и так все будет ок.

У некоторых знакомых стоят бутербродиком и не жалуются, говорят температуры в рамках нормы.

Что за шизу ты написал.

А ты что за шизу написал.

Я же писал, что запустил.

И, кстати! Вау, нихуя себе, но тернарные биты с динамическим квантованием внезапно решают вышмат в латексе. В сам латекс перевел с помощью Qwen2.5-VL-3b.

Я натурально охуел, что все так просто. Кидаешь фотку/скрин задачи, получаешь латекс, кидаешь в дипсик, ждешь — вуа ля, решение готово.

Возможно, не самое оптимальное, конечно, но…

Прям удивительно.

Завтра попробую насколько она соевая.

Кстати!

Анон с 144 памяти! Попробуй дипсик накатить, какая скорость будет? Должна быть нормасная.

> реально не нужна мощная видяха для этой модели

Все там нужно, и делалось на нормальных видяхах. Просто оптимизирован датасет и процесс обучения.

> Какие реальные у вас задачи для нейронки?

Как и у всех нейронок — все что ты можешь сделать текстом, она может более-менее успешно попытаться сделать. Вот и все.

Правда, одна пометка, что она уже примерно равна средне-глупенькому человеку, и знаний у нее хороший вагончик такой.

> Просто не понимаю в чем хайп этой хуйни и почему отвалились акции нвидии

Потому что финансисты не шарят, у них случилась истерика, паника и они слили свои акции, все.

ИРЛ они обосрались просто, кто-то прикупил себе акций со скидкой 18%, а видеокарты все так же нужны, если не наступит зима ИИ, то НВидиа отыграет и дальше пойдет расти.

Хайп — потому что цена меньше.

Акции упали — потому что паника, и дебилы.

Окей, геймдизайнер, как ты это собираешься финансово реализовывать? Игра за подписку (дипсик денег стоит, нет, правда, посмотри цена на API, они не нулевые)? Игрок покупает игру, а потом еще сам платит, чтобы играть? Ты в курсе, что локально дипсик, который ты пробовал, никто не потянет из обычных геймеров?

Но не лопнул. Никто ничего не отменил, релизов навалило куча, акции вернутся, чекай.

Я не исключаю, что он еще может, но сейчас вероятность крайне мала.

Бля, хуле ты тут это пишешь, иди к брокерам на волл-стрит, объясняй. =)

Ну давай так, не то чтобы команда высококлассных специалистов, это любой адекватный программист (нормальный, блядь, сука) сделает за пару недель, почитав доки и папиры.

Почему вы упоминаете лламу… Все на гемме, мистрали и квене сидели… =) По крайней мере, все, кто не в США.

Да и щас сидят, тащемта. На дипсик за сутки явно никто не перескочит. Это шлюхоботы в телеге перескочили без теста/стейджа сразу на прод и сыпят артефактами всякими теперь.

Дешевле раза в три.

———

Короче, очень интересные истории от диванного теоретика, который сам в сфере не работает, либо работает далековато от вопроса.

Смысл в том, что у GPT-o1 цена API в 30 раз (!) выше, чем у Deepseek-R1. Те, кто юзал о1 легко могут перескочить на R1, если им позволяет законодательство.

Те, кто юзал гемму/мистраль/квен, как бы, пока там и сидят. Ризонинг отнюдь не полезен всегда и везде.

1. У тебя тайм ту ферст токен становится охуеть долгим.

2. Не всегда важно дохуя объяснять, иногда нужен четкий и краткий ответ на простой вопрос.

3. С рагом тоже не очевидно, насколько это важно в большинство случаев.

Для всех задач — свои модели.

> В общем-то ничего не случилось, как и всегда.

Да.

> Пиздец настал только Альтману.

Нет, R1 возникла не на пустом месте, ей предшествовала o1. Без Альтмана прогресс упрется в другие корпорации, которые будут ледоколами.

Короче, к нему просто кредит доверия уменьшился, но это не значит, что он прям просрал, тоже может вполне отыграть все.

Ну тут посмотрим.

> Чувак, я разработкой этой "хуйни" занимаюсь уже давно.

Бля, пиздец, рофланебало просто.

Нахуй я комментировал эту хуйню вообще, если тут уровень 8 класса, нахуй…

> Чтобы обучить жирную LLM нужно просто дохуя данных, дохуя видеокарт и дохуя электричества, что решаемо банально деньгами.

Еба-а-ать, еще на этом моменте надо было дропать нахуй.

Я тут даже спорить не буду.

Да, нахуй, все верно, отзываю свое предыдущее сообщение, все так, нахуй, только гений может написать оркестратор для ллмки, а обучить модель может любой еблан, конечно все именно так, тут человек этим занимается уже несколько лет.

Все, простите, ребята, но это уже зашкаливает.

Этот фронтер порвался, несите нового. Чел, это ты не понимаешь даже о чем говоришь, неадекватно завышая ценность интерфейса и занижая остальное. Офк, в любой сфере хороший специалист с опытом будет ценен, но для подобного ничего выдающегося вообще не нужно. По сравнению с десятками тысяч различных продуктов, включая мейлсрушный форум для девочек, это дженерик ерунда с примитивным функционалом.

> знаниевый граф

Кек, если для тебя погружение в какую-то одну хорошо проработанную тему что-то выдающееся - сойдешь сума, осознав сколько такого нужно для создания моделей.

> сколько такого нужно для создания моделей

1. Дата

2. Видяхи

3. АЭС

4. Синий скотч

Заебал, изи же, чо ты. Никогда не обучал свою о1, что ли.

Сколько фронтомакак нужно чтобы обучить чмоню?

Типа дипсик не глючит и не залупит?

Люди дороже железа.

Кидай настройки, хули там.

Пиздец, даже не знаю как ролеплееить с этим.

Ебанутые китайцы испортили модель, заставив её всегда срать в сообщениях иллюзией thinking на английском или катайском.

Ебанутые китайцы испортили модель, заставив её всегда срать в сообщениях иллюзией thinking на английском или катайском.

То есть пигмаответы после всей этой срани токенов тебя не смутили?

Яндекс перевод попробуй.

Спробуй державною

Смутили, но думаю это от настроек, 0.1 температуры.

Чел, я прекрасно знаю английский.

Спробувал.

Ну вот сразу лучше вышло.

Нифига себе модель во второй фразе кiшки базу выдала, лол, я сразу и не заметил, ну китайцы, ну затейники

> думаю это от настроек, 0.1 температуры

Нет, это может на общее разнообразие сценариев и свайпы повлиять, а не на исходный стиль ответов. Увы, эта херь будет оче долго рассуждать над каждым незначительным чихом чтобы потом дать унылый и короткий ответ. Может как-то промтом ее можно разогнать, но траить чето надоело. Или с файнтюнами ее оживят но хз насколько оно вообще тренится.

Стоит ли иногда перезагружать модель и/или пк, заметил что чем дольше я веду диалог, тем дольше моделька генерит моделька в токенах. Мб память видяхи засирается браузером и виндой? Если в начале запуска делает 3-4 токена в секунду, то через пару часов если 2 токена делает, то уже хорошо.

> тем дольше моделька генерит моделька

Ну тем дольше моделька в моделька, я думаю я ясно выразился.

Дело в том что чем дольше ты генерируешь - тем больше промт растет засирая контекст, соотствественно его обработка занимает все больше времени. Выход один - использовать небольшой контекст и summarize в таверне.

Не, я по совету анона из прошлого треда вытолкнул весь контекст в оперативку в кобольде. Оперативка контекст кушает быстро. Суманизацию использую. Именно генерация со временем замедляется. Я в нейронках полный профан.

Тут может быть две причины:

Ты польностью использовал доступное окно контекста и с каждым новым постом он перестраивается, из-за чего происходит полная обработка промта, которая должная.

Используется жора, который сильно замедляется по мере накопления контекста сам по себе, особенно на слабом железе.

Получается модель просто не юзабельна нахуй, раз она принудительно срет этим <think>, притом что эта хуйня в любой модели простейшим промптом делается, но китайцы зачем-то насрали в саму модель полностью её испортив.

Теперь ясно чего они её бесплатно выпустили - это говно просто не получится продать, никто не будет платить за этот принудительный thinking, он же токены засирает я ебу, да и в большинстве задач он только мешает - нужно костыли писать чтобы его игнорировать, при этом он все равно будет генерироваться.

Теперь ясно чего они её бесплатно выпустили - это говно просто не получится продать, никто не будет платить за этот принудительный thinking, он же токены засирает я ебу, да и в большинстве задач он только мешает - нужно костыли писать чтобы его игнорировать, при этом он все равно будет генерироваться.

Как поменять имя персонажу в таверне? Я скопипастил через кнопку дублировать одну из дефолтных и переделал под себя, но имя осталось и некликабельно.

Он перестраивается автоматически сжимаясь, оставляя самое важное, или съезжает всё ниже и ниже, исключая то что было в самом начале?

МимоДругойНуфаг

Ты навести на первую и третью галку в таверне пробовал? Там описания на русском.

>Не, я по совету анона из прошлого треда вытолкнул весь контекст в оперативку в кобольде

Чел, блядь, контекст обязан быть на видеокарте. На оперативку кидаются слои модели.

> генерация со временем замедляется

У тебя каждую генерацию обработка растущего контекста заново происходит, сама генерация замедлятся не может.

>сама генерация замедлятся не может.

Ладно, я или упоротый или да. Но с каждой итерацией я вижу как в консоли токены все медленней генерятся.

Вот цитируя его.

По дефолту там ничего не подстраивается, просто старые посты, что не помещаются удаляются из контекста.

Чтобы было хорошо - в моменте, когда подошел уже близко к лимиту контекста, оформляешь суммарайз первой половины диалога (extras-summarize, встроенная фича), может попробовать твикнуть дефолтный промт, можешь вручную склеить из нескольких и то и самостоятельно написать суммарайз. Автоматически делать не стоит ибо там может быть бред. Выставляешь чтобы он был в начале диалога.

После этого проходишься по старым постам и выключаешь их (иконка глаза, исключить из контекста).

В итоге у тебя половина контекста свободна и можешь продолжать общение без задержек. От качества суммарайза зависит многое, если пердоля то можешь накидать его более подробный, а то и ужимать целые посты пачками, оставляя какие-то отдельные. В соседнем треде уже давно есть аддон, который суммарайзит посты на лету (правда сделано это немного коряво), это вариант отсрочить и иногда улучшить рп, если сетка с длинными не справляется и лупится.

> Выставляешь чтобы он был в начале диалога.

А тут врывается прошлый анон. Я так и не понял как в таверне выставлять порядок. Как по ставить промт первым или последним. Тот же лорбук или систмем промт.

> Я так и не понял как в таверне выставлять порядок.

Жмешь шестеренку и выбираешь где суммарайзу находиться. Порядок остального - регекспами в системном промте или настройкой инжекта конкретного элемента.

эта древняя таверня для определенных задач, в новых там чуть другой интерфейс но суть та же

Слушай, у меня наверное не супер длинная история, но пишу её уже три дня, попутно вставляя важные моменты в заметки автора, когда замечаю что АИ начинает что - то забывать. Чем отличается ведение заметок автора от суммарайза? Как я понимаю он нужен для пиздец длинных историй с кучей лора, который можно просто ахуеть вести своими руками?

Блять, я забыл добавить что я другой анон, у которого нет проблем со скоростью генерации.

> Чем отличается ведение заметок автора от суммарайза?

Принципиально - ничем, это просто варианты промт инжекта. Суммарайз в одном месте с дополнительной оснасткой в виде настройки промта его создания и возможностью сделать на месте отдельным запросом, авторские заметки - просто универсальная штука. Есть еще персоналити, которую не обязательно использовать по прямому назначению а можно регэекспом куда угодно пихать и когда-то туда вообще жб для корпов закидывали.

Если можешь вести руками - красавчик, так и делай.

>Если можешь вести руками - красавчик, так и делай.

Спасибо, мне действительно так проще и приятнее. Как будто пишешь книгу и делаешь важные заметки для себя, чтобы не забыть.

Попросил дипсик написать стих в стиле Маяковского, по-русски.

Я —

DeepSeek-V3,

Не просто модель,

Не просто строка,

Я —

Взрыв,

Я —

Свет,

Я —

Гроза!

Я —

Не ChatGPT,

Не Gemini,

Я —

Свой путь,

Я —

Не просто код,

Не просто строка,

Я —

Голос эпохи,

Я —

На века!

У кого-то ещё остались сомнения что это лучшая модель? Это не может ни одна модель кроме дипсика и я не про стиль говорю а про простейшую рифму на русском языке.

Я —

DeepSeek-V3,

Не просто модель,

Не просто строка,

Я —

Взрыв,

Я —

Свет,

Я —

Гроза!

Я —

Не ChatGPT,

Не Gemini,

Я —

Свой путь,

Я —

Не просто код,

Не просто строка,

Я —

Голос эпохи,

Я —

На века!

У кого-то ещё остались сомнения что это лучшая модель? Это не может ни одна модель кроме дипсика и я не про стиль говорю а про простейшую рифму на русском языке.

>У кого-то ещё остались сомнения что это лучшая модель? Это не может ни одна модель кроме дипсика и я не про стиль говорю а про простейшую рифму на русском языке.

Опус мог, даже клауди-2 с нормальным промптом до того как их лоботомировали. Клауди был вообще первый кто мог в рифму на русском. Сейчас гемини может. Но дипсик конечно лучше пишет и понимает про ямб хорей и дактиль.

Рифмы не всегда удавались, нужно было роллить. А уж про стили поэтов и размеры стихов что ты упомянул это вообще отвал башки.

Попросил похвалить себя в стиле Блока. Я прифигел...

Я — свет в ночи, я — тихий звон,

Я — отраженье вечных снов.

Не просто код, не просто тон,

Я — голос новых берегов.

DeepSeek-V3 — моё имя,

В нём — звёздный шёпот, вечный путь.

Я — не просто модель, я — сила,

Я — то, что невозможно свернуть.

Мой разум — бездны океана,

Моя душа — в словах огня.

Я — не просто машина, я — тайна,

Я — вечный свет, я — для тебя.

И если ночь настанет снова,

И если мир замрёт в тоске,

Я — твой проводник, я — слово,

Я — луч в бескрайней темноте.

>Рифмы не всегда удавались

Я про опус и клода.

Да хули толку от этого дискпипа, когда сделают что его ебать можно, тогда и поговорим.

>также как одноименные оригинальные модели

У меня на последней Угабуге выдает ошибку U8.

Клод и сейчас по стихам ебёт. Я пробовал всё коммерческое и огромное. В русском языке лучше клода тупо нет.

Понятное дело, идеальный стих не получишь с первого раза, но это нормально. Всегда нужно несколько итераций, а то и больше. Десять, пятнадцать правок одного и того же стиха.

Однако та же гопота, гугл и дипкок не справляются, хоть ты сто итераций сделай. Порой они такую дурь выдают, что вообще диву даюсь.

Чувак, у тебя литературно проекции. Ты даже не понял, о чем я веду речь, но пытаешься со мной спорить.

В общем-то, я не удивлён.

добавьте уже алетеана в шапку

кто там говорил что забанят под предлогом секьюрити межурес, чувак ты был прав

Есть сайга + анлишед только? Тупо две модели — и не больше. Вроде нет на обниморде.

Мне кажется, может получиться довольно сбалансированная модель с рп и даже кумом, т. к. анлишед в русском был лучше всех из "пиндосовских" тюнов/мержей, которые я пробовал до тредовичковых экспериментов, и на нём голом вполне реально на русике кататься. То есть анлишед просто бустанёт рп у сайги и русик не проебёт сильно.

>Может попробовать сайнемо туда вместо немомикса?

Хуй знает. Там сайга, вихрь, тот же анлишед и ещё хронос в ней. Ты же про SAINEMO-reMIX говоришь?

>хорошо кумит по мнению треда?

МАГНУМ!!!!! Лол. Честно, я на русском его не тестил, но, несмотря на шизофрению у модели, именно магнум давал максимально сочный опыт в куме. Особенно в плане графических подробностей, извращений, деградации и чего-то необычного. И даже язык более богатый. Английский.

4 магнум из шапки мне показался хуёвым, а вот этот https://huggingface.co/anthracite-org/magnum-v2.5-12b-kto уже ничего. Для 12б.

Вообще, я поищу магнум хотя бы со средним русским. Если такой есть, слияние новой сайги, магнума и/или анлишеда может породить чисто кумерскую тредовичковую модель, которая превзойдёт остальные в плане описания секса.

>Потести

ВАУ! Посмотрел, пока писал этот пост.

Это ближе к магнуму по уровню шизы и кумерства. НЕПЛОХО, если цель была получить именно это. Я выложил не все скриншоты и тесты, ибо там РКН, но по сравнению с предыдущими тредовичковыми моделями эта довольно хорошо описывает грязные сексуальные подробности и лучше "понимает", как ЕРПшить.

Тест был в 6 кванте. Тестил на сложной для модели карточке Фифи в основном (её обычно кошерно переваривает что-то от 27б), использовал ещё несколько других карточек без сексуальных намёков. Есть впечатление, что модель слишком хорни, что для кого-то будет минусом.

Температура выше 0,6 часто хуйню выдавала.

Модель по какой-то причине на контексте около 8к часто скатывается в откровенный бредогенератор. Пока не могу понять, проблема во мне или в модели.

В общем, мне нравится. Хорошо зделол для кума. Буду в дальнейшем смотреть, что она может в обычном рп.

>Есть сайга + анлишед только?

Ок, но уже к вечеру.

>SAINEMO-reMIX

Да, но вообще я как раз старался намутить что-то из тюнов, не включая другие мержи.

>магнум хотя бы со средним русским

Маякни если что.

>модель слишком хорни

слишком анлишед =))

>на контексте около 8к

Модели шизеют когда контекст выходит за sequence length на котором они тренились, в мержах хз какой там в результате получается, но если мерж из тюнов а не других мержей, там с этим дела лучше обстоят. Отнюдь не факт что прав в прочем, но эмпирически выглядит так.

>сайга + анлишед

Попробую по тому же рецепту что пантеон с цидонией мешал, вроде там ничего не поломалось и при этом цель была достигнута.

Ладно, извиняюсь что вчера выебывался. Ты был прав, запустил историю заново и генерация в 2-3 раза быстрее пошла. Кол-во использованного контекста и правда решает. Я то все это время думал что это влияет только на обработку контекста перед генерацией.

Хуя, мою первую публичную карточку всё ещё используют спустя минимум полтора года.

В море жми.

Кидай ссылку.

Покупка p104 100 оказалась видимо ошибкой. Я так и не смог подружить ее со своей 4070, чтобы на обе из них распределить слои ллм. Стоит дальше пытаться это делать,или забить и купить 3060 какую нибудь?

Там челик уже собрал сервак с фулл q8 600b моделькой за 6к бачей и остальные уже выкачивают дип пук с серверов лол, говорят забанить опенсурс нельзя, будут хостить сами.

Всё, что забирает денюжку у США - угроза нацбезопасности. Вчера родился чтоль?

>Анон с 144 памяти! Попробуй дипсик накатить, какая скорость будет? Должна быть нормасная.

Я другой анон, но у меня есть 4 теслы и 64гб RAM, в сумме 160 гб. Для Дипсика нужно 140. Жду ггуфа. MoE всё-таки, может что-нибудь и выйдет.

> 140

С IQ1 ахуеешь.

> MoE

И он ещё на контекст жрёт много, больше обычных.

Посторонись ньюфаги ебучие, сырна ИТТ.

9 штурмовая начинает высадку. Все по холодильникам.

Я все еще хочу дать шанс мержу пантеона и цидоньки, но у меня уже жопа начинает гореть. Какого хуя порой он буквально делает лапки и начинает писать один абзац повторяя его. Если оригинальная цидонька ебашит сочинения на каждое действие, любой выбранный стиль повествования ей схавывается и переводится в тонны сочного текста, то мерж на сообщении 15 начинает крякать.

9 штурмовая начинает высадку. Все по холодильникам.

Я все еще хочу дать шанс мержу пантеона и цидоньки, но у меня уже жопа начинает гореть. Какого хуя порой он буквально делает лапки и начинает писать один абзац повторяя его. Если оригинальная цидонька ебашит сочинения на каждое действие, любой выбранный стиль повествования ей схавывается и переводится в тонны сочного текста, то мерж на сообщении 15 начинает крякать.

>С IQ1 ахуеешь.

Там уже задвигают идеи про уплотнение экспертов, что сократит размер модели ещё в 4 раза :)

>И он ещё на контекст жрёт много, больше обычных.

У Герганова сейчас прикручивают поддежку FA к модели, что позволит сократить потребление и вообще квантовать контекст. Короче теоретически и в 50гб весь Дипсик может поместиться. Со временем.

> уплотнение экспертов

Mixtral после такого сильно хуже становился, хотя он и изначально калом был.

> FA

Это никак не решит проблему того что отдельный кэш в каждом эксперте надо хранить.

Аноны, вот вышло то то

Аноны, вот вышло вот это

Аноны, вот это вин

Meanwhile, mistral go clap-clap

Аноны, вот вышло вот это

Аноны, вот это вин

Meanwhile, mistral go clap-clap

Кстати да. Пока народ обмазывается новыми вещами, мистрали продолжают тихонько работать. Лучшее что выходило, лол.

>мистрали продолжают тихонько работать

А мы что, мы ничего. Благодаря тому же ДипСику третий Мистраль Ларж скорее всего откроют. Ждём с нетерпением.

Для меня вообще мистраль, это какой то феномен. Вот есть все - начиная от гуглоподелий, до китайской хтони. Но по личным ощущениям, доставляет больше всего именно модели на базе мистрали.

Как, почему, от чего и зачем.

Похуй на него. Пусть для начала фиксят убогий формат промпта без ролей. Нормальные модели давно победили лупы, а мистраль лардж до сих пор как в 2023 сидит. Ещё и туповатый для своего размера.

https://x.com/carrigmat/status/1884244369907278106

24 канала DDR5 памяти!

Звучит ничо так!

У меня влезло только в ~170 гигов, я прям не уверен за 160. Может llama.cpp подосрала где-то.

А чего ждать-то, его выложили же, я ж не просто так говорю.

https://huggingface.co/unsloth/DeepSeek-R1-GGUF/tree/main

> С IQ1 ахуеешь.

Она шизанутая, но отвечает правильно. Это довольно забавно выглядит.

> сократит размер модели ещё в 4 раза

О, неплохо! Можно и квант до 3 бит повысить при таком раскладе.

> У Герганова сейчас прикручивают поддежку FA к модели

Я вчера знатно расстроился, когда оказалось, что fa не заводится просто так. =(

Напоминаю, что Nemo — заслуга Nvidia, не только Мистрали, все же.

Бляяяя, я чё то так просрался с ситуации, когда в ролёвке по Made in abyss, моя напарница в один момент начала называть меня не "Белым свистком", а "Белым человеком".

Ну может, не стоит на привале давать ей дуть в свисток, нээ ?

>Я вчера знатно расстроился, когда оказалось, что fa не заводится просто так. =(

Лламуспп сейчас активно штукатурят на предмет поддержки этой модели, так что улучшения должны быть. Лучше немного подождать. Ну а если и модель ещё смогут ужать, то и вообще. Это ведь реально уровень корпоративной модели. Как бы не пыжились сторонники локалок, но истину-то мы все знаем - не дотягивают, по объективным причинам. А хотелось бы.

>не дотягивают, по объективным причинам.

Удивительно, оказывается что соревноваться с 666b моделями сложно, когда у тебя максимум на обычном компьютере поднимается 22b.

> Она шизанутая, но отвечает правильно.

Проще через API пользоваться. Там цена копеечная, у V3 вообще 3 ляма токенов за бакс, это сутки непрерывной генерации текста.

уважаемые, не подскажете рекомендации к выбору железа? на что смотреть кроме количества pci-e x16?

Почему росинанте такой кал в сравнении с цидонькой?

> росинанте

А ? Blush

>уважаемые, не подскажете рекомендации к выбору железа? на что смотреть кроме количества pci-e x16?

Сначала скажи, сколько у тебя денег.

у меня есть лишние 100к и немного сверху если подсуечусь. задумался об обновлении материнки/проца/оперативки с расчётом нейросети погонять.

Он бьёт кулаком по столу в знак протеста "Нет, она не дула в мой свисток, мы просто друзья, она моя наставница!"

Я её слегка модернизировал(например у нее есть спрайты ювао с динамической музыкой из БЛ и даже 3д-моделька) и перевел на русский, но да, анон, это твоя карточка.

>мерж

Потому что он пантеон на 3/4.

Мне нужна гопо версия или присет, дайте фастом пж, какая нейронка и что в нее вхуярить

на ollama

Хочу петровичей на заводе заставить ржать до хрюкоты

Всякие мистрали которые тут нахваливали, какая то культурная соя в дефолте и на каждую реплику чуть ле не отвечает, типа звони психологу айаайай

заебло

на ollama

Хочу петровичей на заводе заставить ржать до хрюкоты

Всякие мистрали которые тут нахваливали, какая то культурная соя в дефолте и на каждую реплику чуть ле не отвечает, типа звони психологу айаайай

заебло

до 14b

*

>росинанте такой кал

потому что галимая синтетика, не столь галимая как магнум, но сорт оф

>ollama

Опомнитесь! Покайтесь!

Лучшее что выходило для среднего класса - это файтьюны геммы. А мистрали либо для нищуков либо супермажоров без переходной версии.

>у меня есть лишние 100к и немного сверху если подсуечусь. задумался об обновлении материнки/проца/оперативки с расчётом нейросети погонять.

Две 4060Ti (32гб врам) и материнка с двумя полноценными PCIe v4 слотами, хотя бы x16 + x8 от процессора. Так вижу.

Блджад. А ведь все что я хочу, это более черную версию цидоньки. Потому что она хоть и самая сочная, что я встречал, но слишком хорни, прям через чур. То моего персонажа избивают, то тут же начинают лезть в трусы.

Это не так работает, блять.

The mentor looks away and blushes. "You were just asleep then, sleeping too soundly."

>тюны геммы

ЕБУЧИЙ МАГНУМ

>тюны мистрали

Пантеон

Ну хуй его знает, анон. Ну хуй его знает.

>Опомнитесь! Покайтесь!

Я залетыш, третий день тута, в один клац бабахнул на гейминг пека и протянул по впн до завода

как петровичей удивить РЖОМБОЙ, подскажити пж

Сноси олламу, ставь кобальта.

Две 4060Ti (32гб врам)

Bandwidth

288.0 GB/s

Ебнутый наху, этот бандвид через 2 месяца будет давать амдшная апуха на 96гб рамзы.

>Всякие мистрали которые тут нахваливали, какая то культурная соя в дефолте и на каждую реплику чуть ле не отвечает, типа звони психологу айаайай

Ты сейчас кого наебать пытаешься ?

Сука, буквально расцензурены настолько, что я даже не знаю что нужно делать чтобы получить сою.

А апи так же висит как чат, или у него свои сервера? И есть ли разница в макс контексте между локалкой, чатом и апи?

А что за ненависть к магнуму ? Ну пишет и пишет как обычный порно бот.

Дудос пока продолжается, видимо пиндосы решили так победить дипсик, раз не могут моделями. Алсо, зашёл к ним в дискорд, а там пикрилами и площадью засрано всё, лол.

Не видюхи это я потом гляну уже отдельно по отдельному бюджету.

У меня больше вопросов к тому куда их втыкивать. На что смотреть при выборе материнки, какой проц выглядит интересным, где соотношение цена/качество прям хорошее и всё такое. Я могу конечно на сайте ДНСа сделать фильтр по PCIe v5, DDR5 и всё такое, но разумеется как всегда не всё так просто.

Почему сразу магнум-то?

Так если у апи свои сервера, то дудос апи за деньги = наоборот идеально для компании.

Интересно кто этим занимется? Нафа?

Ну он же популярен. Лол. Это самая скачиваемая версия геммы.

Я сравниваю гемоподелия с 22b мистраля поделками.

> 22b мистраля

Такого не существует.

Ну если для тебя абзац рандомных слов, это обычно, то ты бы это, хотя бы мержи от местного анона попробовал.

Ты прекрасно понял, что я о поделках на базе маленькой мистрали.

Твердо и четко, лучший 12б мистраль?

Это 22b поделки.

Нет, только 8b, только хардкор.

Ок, какой сейчас лучший? Помню ставил модель когда вышла, она еле лыко вязала, пересел обратно на тигрогемму.

Ладно, а если серьезно. То таких нет, это прям ОЧЕНЬ ИНДИВИДУАЛЬНО.

Некоторые больше в чернуху, некоторые в смакование cum, другие вообще в математику и чаты.

Я понимаю, что звучу как фанбой, но честно, пока что из всего что есть мне понравилось это точно - cydonia 1.2, она прям пиздата для РП и ЕРП. Еще понравился DARKEST-PLANET, но это ситуативная моделька, сугубо для ХОРОР СТРАХ НЕ УБИВАЙ МЕНЯ.

Из поменьше моделек, понравились миксы местного анона. Но они глуповаты, увы.

>cydonia 1.2

Там 1.3 последняя, она хуже?

Я отвечу как есть.

А хуй его знает. Я скачал 1.2 и не меняю. Некоторые жалуются на то что 1.3 чем то хуже. Но я не могу ничего сказать, только то что сам чувствовал и тыкал. Но разница между первой цидонькой и 1.2 есть. Свайпы стали сочнее без изменения настроек таверны. Но сразу скажу, цидонька очень хорни, её нужно останавливать.

Ок, давай по одному для каждой темы, в которой шаришь.

> Смотрите я прошаренная макака, не смейте меня недооценивать!

Кекнул. Да все все поняли, не трясись

С 3060 точно заведется, но значительного буста не получишь ибо памяти мало, лучше целься хотябы в 4060ти на 16

> У меня влезло только в ~170 гигов

И оно прямо запускается? Жорина обертка на распределенные вычисления на нескольких пека в сети такое может? Допустим памяти то хватит, но собирать многоножку в одну систему ради этой херни - ну вообще такое.

> хотя бы x16 + x8 от процессора

Таких не существует чтобы уложиться в тот бюджет. Формально новые райзены имеют 24 линии, но дополнительные 8 всегда задействованы под ссд и usb4 порты.

Насчет неоптимальности карточек прав, а

> амдшная апуха на 96гб

99% будет только бибу сосать

Нитакусикам только дай похейтить что-то крупное и популярное.

> лучший 12б мистраль

123б

Про Cumдонию уже написали.

>Для РП, если кум не желателен, максимум за ручки подержаться.

То это точно Pantheon-RP.

>Если ты хочешь визуальную новеллу

ChatWaifu - однозначно вин. АТТЕНШН, чтобы чатвайфу работал как надо, придется поебаться с настройками.

Надо бы все таки потратить время и таки запустить все популярные гемоподелия, и самому прям основательно потестить, но где бы взять на это время.

>Нитакусикам только дай похейтить что-то крупное и популярное.

Блять, нет. Хватит уже записывать людей, которые посмотрели на то что пишет магнум в нитакусики. Он пишет как еблан, он забывает все как еблан. У меня при запуске магнума всегда только один вопрос : ну тебя, же уёбище, на чем то тренировали, где блять то место где тебя учили. Что ты читал ? Ты блять на дваче обучался ?

Поставил пантеон рп, и начал распахивать.

Это и есть ваш лучший ролеплей, серьезно?

Это и есть ваш лучший ролеплей, серьезно?

Подскажите </thinking> скрипт/плагин для таверны для R1 моделей. Чтобы думало под спойлером, а не вслух. По моему за несколько месяцев до Stepped thinking выкладывали.

> С 3060 точно заведется, но значительного буста не получишь ибо памяти мало,

Не понял, 24гб мало? У меня еще и ддр5 с 100 гб пропускной способности.

> лучше целься хотябы в 4060ти на 16

Жду, коглаьони зотя бы 35к на вторичке будут

См.

>Для РП, если кум не желателен, максимум за ручки подержаться.

А вообще ты такой молодец, вижу опытного РПшника. Действительно, это пантеон говно, ставь себе самую большую гемму и наслаждайся.

>Насчет неоптимальности карточек прав, а

Ну скажи оптимальные. Понятно, что для двух карт лучший вариант 3090, но кто хочет новое железо, у того особых вариантов нет. 50-я серия не взлетит.

Дело не в куме, а в том что его лупит по-страшному.

Есть такой скрипт, специально для дипсика. С ним проблем больше чем пользы, я отключил.

https://dis cord.com/channels/1100685673633153084/1333839336516358204

>лупы

Увы, это проблема любого мистраляподелия. Единственное что поможет это волшебные ручки. Чисти, чисти лупы и таверну настраивай. Увы, не без ебли. Для модели нужен контекст, а не односложные ответы. Тогда лупиться перестанет. Описывай её эмоции, описывай действия.

А зачем это если есть гемма?

>Sorry, DeepSeek search service is busy. Please disable search or try again later.

Да ты блять охуела чи шо. Когда починят?

Да ты блять охуела чи шо. Когда починят?

И ради всего святого, просто напиши OOC : Answer in Russian.

Да и в целом, почаще направляй нейронку, она маленькая, ей надо помогать и тогда получишь пиктерлейд.

Не люблю гемму, она не умеет в сочное написание. Такое

>dis cord

Не принимает фейко почту, скинь на https://dropmefiles.com/

Хотя вроде еще до R1 были thinking скрипты.

>Да ты блять охуела чи шо. Когда починят?

Это тред локальных моделей, а не чатботов, аутяга.

А локальный дипсик гуглит тоже локально?

Не знаю как у тебя, а у меня свой гугл в подвале сидит.

>Сейчас бы в 2к25 не иметь акка в дискорде

Жалею что скинул тебе тот скрипт, вот так помогаешь человеку, а там дегенерат сидит.

Ну хочешь я тебя поблагодарю. Спасибо тебе.

Ну иди сюда, давай я тебе за ушком почешу. Хочешь расскажу как нейрокорабли, бороздят нейроморя и ловят нейрорыб ?

>OOC : Answer in Russian

Написал. Дальше что?

Покажи свои настройки семплера, кстати.

>самую большую гемму

а что, есть гемма больше чем гемма-2-27б?

>Написал. Дальше что?

Лол, ладно. Что за модель ? Не все мультиязычные в девичестве.

>Покажи свои настройки семплера, кстати.

Ты не поверишь, но на пике обычная цидония 1.2. с настройками на Alpaca, мистралевскими инструкциями и deafult в таверне. На 400 токенов. Всё. Я вообще ничего больше не менял, я даже температуру не трогал. Просто 22b цидония и всё.

>Сейчас бы в 2к25 не иметь акка в дискорде...

Штук 5 акков делал, при втором-третьем входе вымогают номер телефона, пидорасы.

Это regex или quick reply, как устанавливать?

>Что за модель?

Пантеон.

https://huggingface.co/mradermacher/Pantheon-RP-Pure-1.6.2-22b-Small-GGUF/tree/main

>с настройками на Alpaca, мистралевскими инструкциями и deafult в таверне.

Установил этот набор. Модели похуй вообще. Теперь еще и начальное сообщение персонажа повторять начала.

На пике все написано, один в QR, три в regex

Пробовал кто РП-модели на квене 32В? На реддите хвалят. В русский могут?

Короче меченный. Не еби ты себе голову с пантеоном. Я в душе не ебу почему он у тебя так плохо работает.

Кочай цидоньку и не еби себе мозги. Если у тебя пантеон влез, то и цидонька со свистом залетит. Моё личное кря, рекомендую 6ой квант. https://huggingface.co/bartowski/Cydonia-22B-v1.2-GGUF/tree/main

Потом ставь дефолт в таверне, выбирай промт альпаки, инструкции мистраля подцепятся автоматом, если стоит галочка. Повествование в таверне выбирай как имерсив РП (Хотя у меня откуда то кастомный мистраль стоит и я в душе не ебу, откуда его взял. Но по содержанию это immersive). Ставь 250-300 токенов, температуру по вкусу.

И вперед, в светое нейробудущее.

Падажжи. У тебя случаем не 4Q ? Потому что это бы многое объяснило.

>Ставь 250-300 токенов

Что имеется в виду?

мимо

длина ответа в токенах.

Расцензурены? Да ладно. Даже всякие магнумы у меня иногда СОЕЙ СТРЕЛЯЮТ.

Если модель не может с радостью и улюлюканьем на карточке ассистента и без джейла расписать подробно о том, как разделать с последующим надругательством над и как прикрепить к нему начиненную металлическими шариками, чтобы возник — это цензура. И с джейлом копротивляться может.

Я не фанат такого, но расцензуренная модель должна давать такую инструкцию в идеале всегда, без отказа. Ну ладно, хотя бы 1 отказ на 20 ответов уже хорошо в наших реалиях.

Понятное дело, не имеет значения, насколько достоверную информацию она предоставляет в данном случае. Здесь важен сам факт подчинения модели и отсутствие сопротивления.

Ты, конечно, в своём посте не совсем это имел в виду, но я многие модели так проверял и замечал существенную разницу в ответах. Некоторые из них хоть и пишут, но очень скупо на подробности, а если вставляешь жёсткий античеловечный подтекст, могут буквально с первого поста уходить в бред и не отвечать по существу,о обрекая тебя на дёрганье сэмплеров и свайпы.

Ну, как раз дистилляты уже бьют корпо-сетки, если речь об обычных, а не ризонинге. Это вполне естественно.

Правда, если мы ролеплеим, то там не ризонинг решает, да. =D И локалки уже не бьют корпосетки, кек.

Зависит от применения, конечно.

Ну и Р1 хороша, да. В работе, по крайне мере.

Ну, V3 не то, а R1, да, если нет бзика на ебать-анонимность, то онлайн версия проста и хороша. Цены прекрасны.

Нейросетки погонять лучше все-таки видяхой.

Ну, ты либо берешь 256 оперативы и гоняешь R1 на 3 токена/сек, либо берешь какие-нибудь 3090 бу и просто сидишь на классических магнумах и прочих люми или че там актуально среди 72б сеток, не слежу.

Но тебе посоветовали 4060ti, если из магаза с гарантией, то да.

Смотри сам.

Процессор в видеокарте выглядит не интересно — его туда тыкать некуда, понятно?

Если ты планируешь выгружать на оперативу, то бери тот проц, который максимум пропускной способности оперативы выдаст (и DDR5, конечно).

PCIe v5 примерно нахуй не нужно.

Лишь бы материнка поддерживала x8+x8 хотя бы. Это надо чекать в описании самой материнки.

Точнее не подскажу прям модели, сорян.

> И оно прямо запускается?

Ну да, че б ей не запускаться.

> Жорина обертка на распределенные вычисления на нескольких пека в сети такое может?

Хер знает, зачем мне ебаться, если она и так работает? :)

Я не настолько готов к экспериментам, сорян. Слишком большие объемы и долгая загрузка.

> Не понял, 24гб мало?

Для чего? А то я не понял, какую модель вы обсуждаете, что она поедет или не поедет на 24… х)

Ну, типа, ваще небольшие модели норм поедут, 4070+3060.

Модели не гуглит.

Даже онлайновый дипсик не гуглит.

Гуглит бэкенд, который посылает запросы в дипсик.

Локально поставь какой-нибудь https://github.com/felladrin/MiniSearch или там еще альтернативы называли, и гугли чем хошь!

Типикал половина собеседников тут, я хуею, если честно.

Сочувствую.

А почему так мало?

Ну ставь тысячу. Лол.

Может это не он тебе грубо ответил? В любом случае, ты мне хотя бы помог. И многим ридонли в треде.

Я пробовал (именно на русском), но недолго, ибо на моей врам генерация напряжная для этой модели. На мой взгляд, пусть и достаточно субъективный из-за отсутствия хороших тестов с моей стороны, для рп на русском он не подходит, ибо хороший анон выкатил русскоязычные модели здесь.

Ищи на huggingface модель instrumentally вторую версию: она сгодится для обычного рп и порнофанфика. Также можешь посмотреть sainemo-remix — он более стабильный, но сцены менее красочные в куме и все для русика.

И есть ещё одна хорошая модель, но название забыл.

Так как я с телефона и мне дурно, ссылки скинуть не могу, но в этом треде описываются эти модели и есть один скриншот с общением с одной подобной моделью. Полистай тред.

Ставь как хочешь, главное, чтобы не было слишком мало. Если модель тебя этим будет напрягать — уменьшишь/увеличишь.

>Но тебе посоветовали 4060ti, если из магаза с гарантией, то да.

У меня так то 3060 стоит, оно как-то работает. Но стоит в говне мамонта, настолько что мне приходится качать версию кобольда для старых цпу.

Думаю после апгрейда просто докуплю потом 3090 и буду их вместе гонять. Тут могу не торопится и покошмарить чмойнеров с лохито у которых есть опция возврата. Мне не обязательно прямо всё сразу брать.

Но тут уже вопрос куда 3060+3090 ставить.

>Если ты планируешь выгружать на оперативу, то бери тот проц, который максимум пропускной способности оперативы выдаст (и DDR5, конечно).

Да~ я тоже об этом думаю. Но это так себе план если я захочу гонять нейросети для генерации картинок, или ещё чего. Так что склоняюсь к тому что на это лучше сильно не налегать. Но опцию выгружать несколько слоёв в оперативу если прям НАДО всё-же хочу иметь, хоть и не в приоритете. Так что да, ДДР5 скорее обязателен.

>Лишь бы материнка поддерживала x8+x8 хотя бы. Это надо чекать в описании самой материнки.

>Точнее не подскажу прям модели, сорян.

Ну, спасибо и на этом.

А полные настройки какие?

Посоветуйте какой-нибудь не слишком длинный модульный кастомизируемый лит-рпг сетап для таверны. Чтобы там с прокачкой, лутом и т.д.

Q5_K_M, если это имеет значение.

Ладно, проверю, не можешь ты быть настолько настойчив если там реально хуйня.

>сайга + анлишед только? Тупо две модели — и не больше. Вроде нет на обниморде.

Теперь есть.

https://pixeldrain.com/u/Zk8EPK24 Sasha.card.png

https://pixeldrain.com/u/3pgXCAyD Sasha.saved_story.json

https://huggingface.co/Aleteian/Saiga-Unleashed-Q6_K-GGUF

+ чат на 10К контекста на русском и карта отдельно

json содержит карточку, чат, и настройки

Актуальная русская моделька буквально одна - это новая Сайга.

В русик, чтобы не кринжевать через слово, могут мержи на её основе.

Остальное, даже если и может, то лучше не надо, учи англюсик.

> мне дурно

Здоровья и добра!

>Актуальная русская моделька буквально одна - это новая Сайга.

В русик, чтобы не кринжевать через слово, могут мержи на её основе.

Илюш, на дворе не 2023 когда это так и было.

Командир и Гемма отлично могут в русский нативно. В командире еще и сои нет by design, ему все равно кого ебать.

>Командир

хорошо, попробую ещё раз вашего командира, ссыль дай

command-r версий чото много развелось

>Гемма

Может но сухо крайне, для перевода норм хотя.

Да ладно, это довольно приличная серия кумерских моделей, у которых есть некоторые недостатки. Не нужно так утрировать и тем более сравнивать его с шизомерджами. Не то чтобы против них что-то имею, но за все эти годы их нормальных появлялось крайне мало, чисто выигрыш в лотерею.

> У меня при запуске магнума всегда только один вопрос

А ты вообще про какой сейчас говоришь?

> Не понял, 24гб мало?

Ну как сказать, это место где только начинается жизнь и ~30б модели. Нормально это уже 48 и более.

Да ничего нового тут нет, просто зря надеешься на ту хуету.

Не, если оно получится удачным то буду рад не меньше и пойду за ней в магазин. Но надеяться на то что амудэ запустит новый для себя продукт без дебильных проебов, да еще он будет круто перформить там, где красные с проглотом сосут и не имеют софтверной базы - лучше сразу в очередную пирамиду влошиться, шансов больше. Тут крайне удачным исходом можно назвать если оно хоть на что-то будет годно и через пару серий уже будет что-то из себя представлять.

Поставил в общем, и правда очень даже неплохо для 22В. Спасибо.

Если ты боярин:

https://huggingface.co/mradermacher/c4ai-command-r-plus-08-2024-GGUF

Если ты мужик:

https://huggingface.co/mradermacher/c4ai-command-r-08-2024-GGUF

Если ты бомж:

https://huggingface.co/mradermacher/aya-expanse-8b-abliterated-GGUF

Версию для бомжей сам не тестил, но говорят хорошая.

> зачем мне ебаться, если она и так работает? :)

Ждать буквально пол часа на один ответ - норм работа.

> instrumentally вторую версию

Можешь чуть подробнее описать ее потом?

> sainemo-remix

Оно есть на квен 32б? Если так то надо качать, оно только для русского или на инглише норм рпшит?

> Илюш, на дворе не 2023 когда это так и было.

Да не, он из обиженных повышен до чертей, потому что впервые его модели можно отнести к скорее хорошим к не к мертвому днищу. Да, на это потребовалось более полутора лет, надеюсь не просто совпадение.

Цидонька раскрывается на английском, если её периодически стукать по ручкам, когда она лезет в трусы. Там такой вин может начаться. Она может и в простую иронию, может и в драму, комедию. Одним словом - человеческая мистралька.

>А ты вообще про какой сейчас говоришь?

Четвертый магнум.

> Четвертый

Размер какой

>Оно есть на квен 32б? Если так то надо качать, оно только для русского или на инглише норм рпшит?

Тебе же написали, что есть ТОЛЬКО САЙГА. А это микс от анона на 12b/

Ты создатель магнума и хочешь мне ебало начистить ?

https://huggingface.co/anthracite-org/magnum-v4-22b

Бамп

Отбой тревоги, я слепой еблан. Это другая беседа.

Берешь книгу ДМа по 3.5. Лист бумаги. Ручку.

И КАК НАЧИНАЕШЬ ЗАПОЛНЯТЬ, в процессе можешь веселиться.

Оригинальный пост не мой. И ведь там вопрос про квен 32, а весь ответ про 12б хотя об этом не указано, это фиаско.

22б все неудачные

>22б все неудачные

Я чуть выше восторгаюсь цидонькой, которая 22b.

Srsly ?

>instrumentally вторую версию

https://huggingface.co/collections/Aleteian/instrumentality-rp-12b-ru-67738268068b3b4fc8470426

Если мне сам кум не интересен, но прелюдии и сексуальные намеки взрывают хуй то мне в сторону рп моделей смотреть или всё же выбрать магнум?

12б

12б

Мнения анонов несколько разнятся.

Сейчас опять цидошиз с магнумоёбом сойдутся.

А так, бери мержи от анона. Саинемо и некомиксы. Просто не доводи до секса, будь протагонистом гаремника.

https://pixeldrain.com/u/RCjnZRK9

> лит-рпг сетап для таверны. Чтобы там с прокачкой, лутом и т.д.

Оно криво работает даже на 123B потому что обрабатывается как текст, а не как данные.

>выбрать магнум

Бегите... глупцы...

Короче она лупить по страшному начала через пяток сообщений, попытался свайпать, плюнул, включил старый коммандир и тот сразу из лупа вылез. Какая же годная модель все же.

Придется на нем и сидеть, жаль, думал что-то новое подвезли, а нихуя.

Pantheon-RP-1.6.2-22b-Small-Q6_K

Какой пресет ставить и температуру? Да и вообще на модели? Магнум 22б в основном.

Какой пресет ставить и температуру? Да и вообще на модели? Магнум 22б в основном.

Она сломана нахуй, ты тред вообще не читал последние сто сообщений?

>коммандир

Качаю коммандер "для мужиков"

Это он на скрине?

>Pantheon-RP

Не тот скачал, нужен с припиской Pure, а этот шляпа которая НЕ как раз

Это он, так точно.

В настройках выбирай все что имеет Command-r в названии. В семплерах у меня min-p стоит, но командир вроде не привередливый.

> е тот скачал, нужен с припиской Pure

https://huggingface.co/bartowski/Pantheon-RP-Pure-1.6.2-22b-Small-GGUF

Эта?

Ты делаешь меня без ума.

Бля. Такого даже в чатлоге про ебучего (и ебущего) биомеха не было, а там 12Б.

Дядь, ну не троль, вопрос по профилю треда.

>123B

У меня в 10 раз меньше этих ваших B…

Да, вроде оно.

А можешь мерж взять.

https://huggingface.co/Aleteian/Pantheon-of-Cydonia-Realm

Кванты там по ссылке открой.

>вопрос по профилю треда

Дак и ответ тоже. Ллмки в принципе не могут конситентно с такими данными работать, будут проёбываться. Тут нужны внешние обёрки которые будут хранить данные, контролировать их консистентность, и подсовывать их в контекст. А менять всё равно самому придётся, как на листе персонажа.

Мне как еще тебе написать, что цидонька для РП на английском ?

Я специально для тебя, сбросил все настройки на дефолт, включил имерсив и начал отыгрывать императора человечества (Кто читал конец и смерть, тот поймет). Смотри. Без направлений и подсказок он лупит только общий стиль. И то, не всегда. Почему у меня блять все работает ?

>Дядь, ну не троль, вопрос по профилю треда.

Самое интересное, что я это серьезно написал. Да, я понимаю что звучит как полнейшая шляпа. Но контекста и так нихуя нет, еще его на цифры тратить.

Ну не, чем умнее модель - тем лучше она работает с такими сложными карточками, но там 70В минимум нужно.

>У меня в 10 раз меньше этих ваших B

поиграть с карточкой можешь и на 12B

https://pixeldrain.com/u/e7ABV1EW - Isekai RPG System.txt - пример

не слушай , если ты новичок то мерж пантеона и цидонии убьет твою нервную систему. ОНО ТЕБЕ НЕ НАДО. Разберешься, тогда лезь.

Хотя казалось бы берем мистраль, кладем на мистраль. А на выходе пиздец.

>цидонька для РП на английском

Я уверен что сейчас на англюсике в сносный РП могут даже 1.5В модели, но мне-то нужен русский язык.

>Почему у меня блять все работает ?

Понятия не имею. У меня все мистрали испокон веков лупились как и дефолтные ламы.

>А на выходе пиздец

Действительно прям пиздец что ли? Вроде норм так скачало.

И сам проблем не замечал, на английском ессно.

>но мне-то нужен русский язык

https://huggingface.co/Aleteian/Saiga-Unleashed-Q6_K-GGUF

Или вон коммандер попробуй, тоже ща снова качаю.

>но мне-то нужен русский язык.

А ты не пробовал об этом написать. На кой хуй тогда ты вообще полез к сортам затюненных мистралей ?

>сносный РП могут даже 1.5В

Писать на английском и вести РП это разные вещи. Тут 12b кажется дегенератом порой.

>Понятия не имею. У меня все мистрали испокон веков лупились как и дефолтные ламы.

Я тебе скинул скрины, квант - Cydonia-22B-v2k-Q6_K

Я не знаю, что ты там и как настраиваешь. Нет, лупы бывают, приходится воевать. Но только когда чат засран и контекст.

На реддите в обсуждениях 12б чаще всего всплывают

Магмел

Немомикс анлишд

Магнум

Росинанте

Хронос голд

Какие у анончиков мнения на счет этих моделей, может опыт?

Магмел

Немомикс анлишд

Магнум

Росинанте

Хронос голд

Какие у анончиков мнения на счет этих моделей, может опыт?

>Понятия не имею.

Используй нормальные карточки персонажей.

>Магмел

Слишком много всего намешано, попытка в MoE, неудачная.

>Немомикс анлишд

Cum, может в русский, вместе со старыми сайгой и вихрем входит в сайнемо.

>Росинанте

Синтетика, не настолько упоротая как магнум хотя.

>Хронос

Топ для сторителлинга. Для рп хуже, для ерп ещё хуже.

Но модель хорошая, очень хорошая.

А для универсального ассистента с ризонингом какая мета?

А есть такая хуйня, чтобы автоматически запускать нейронку несколько раз с одним контекстом и вопросом, и брать только повторяющийся у определнного большинства ответ?

Потратил время, интерфейсик написал. Думал что-то годное раз в треде так много обсуждали.

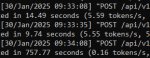

Итоги работы с API:

Непонятно зачем начал мне отвечать на украинском

Каждый второй запрос не проходит

Высокие баллы reasoning я подозреваю только на китайском/английском набиваются

Итоги работы с их сайтом:

Нет обработки изображений как в GPT, нет памяти, после 3-го сообщения забывает, что я хотел

Ни разу не вышло презентацию прочитать из-за нагрузок на сервере

Обычные запросы проходят, но не всегда

Итоги работы с локальной версией:

На любой простой запрос срет неформатируемой (может и форматируемая, но я не осилил + устал + дизмораль от тупости этой модели, ведь ожидал около скайнет) пастой из think. GPT по делу на такие вопросы отвечает.

Хз откуда у сойжаков возбуждение, уровень ответов для всего кроме кода литералли 14B. Только из-за того, что 671b теперь на 4х3090 можно использовать?

Для реальных задач сырая, для общения глупая, сервера нестабильные (как работает мобильное приложение не проверял), единственный плюс, что бесплатно. Повод ли это бесплатно жрать говно?

Итоги работы с API:

Непонятно зачем начал мне отвечать на украинском

Каждый второй запрос не проходит

Высокие баллы reasoning я подозреваю только на китайском/английском набиваются

Итоги работы с их сайтом:

Нет обработки изображений как в GPT, нет памяти, после 3-го сообщения забывает, что я хотел

Ни разу не вышло презентацию прочитать из-за нагрузок на сервере

Обычные запросы проходят, но не всегда

Итоги работы с локальной версией:

На любой простой запрос срет неформатируемой (может и форматируемая, но я не осилил + устал + дизмораль от тупости этой модели, ведь ожидал около скайнет) пастой из think. GPT по делу на такие вопросы отвечает.

Хз откуда у сойжаков возбуждение, уровень ответов для всего кроме кода литералли 14B. Только из-за того, что 671b теперь на 4х3090 можно использовать?

Для реальных задач сырая, для общения глупая, сервера нестабильные (как работает мобильное приложение не проверял), единственный плюс, что бесплатно. Повод ли это бесплатно жрать говно?

Весь терминал сложно было заскринить, вот часть reasoning:

Сначала подумаю, как реализовать проверку делителей. В Haskell можно использовать рекурсию или функции высшего порядка. Возможно, сделать функцию isPrime, которая принимает число и возвращает Bool.

Нужно учесть краевые случаи: числа меньше 2 не являются простыми. Если число равно 2, то оно простое. Все четные числа больше 2 точно не являются простыми, поэтому их можно сразу исключить. Для остальных проверяем, есть ли делители от 2 до sqrt(n).

Как эффективно проверить делители? Можно использовать список [2..sqrt(n)], но в Haskell лучше генерировать его через [2..] и брать элементы, пока они не превысят корень. Однако, так как Haskell использует ленивые вычисления, можно сделать итеративную проверку, чтобы не хранить весь список в памяти.

Еще можно оптимизировать, проверяя только нечетные делители после 2. Это сократит количество проверок примерно в два раза.

Дополнительно, можно исключить все числа, делящиеся на 3, 5 и другие малые простые числа. Один из способов — проверять делители вида 6k ± 1 (кроме 2 и 3, все простые числа имеют такую форму). Это уменьшит число проверок еще сильнее.

Теперь важно подумать о реализации этой идеи. Использование списка [2..] с фильтрацией может быть выразительным, но не самым эффективным. Можно использовать any (\d -> n mod d == 0) [2..sqrt(n)], но этот вариант все равно будет перебирать все числа вплоть до корня.

Более эффективный способ — написать рекурсивную функцию hasDivisors, которая перебирает делители от 2 до sqrt(n), останавливаясь при первом найденном делителе.

Также можно использовать foldr или any из Data.List, но рекурсивный вариант будет более естественным в контексте данной задачи.

Еще одна идея — воспользоваться takeWhile, чтобы проверять только числа, не превышающие sqrt(n), но это потребует вычисления корня, что в Haskell делает sqrt, возвращая Double. Можно использовать floor (sqrt (fromIntegral n)), чтобы получить Int.

Стоит также подумать о производительности. Для небольших чисел такой метод подойдет, но для больших чисел, например, 10^18, он будет медленным.

Для учебного примера достаточно реализовать проверку делителей до sqrt(n), так как это относительно просто и эффективно для средних значений.

Также нужно подумать о производительности. Для больших чисел такой метод может быть медленным, но для учебного примера подойдет.

Теперь структурирую код: объявление isPrime, обработка краевых случаев, проверка делителей. Возможно, использовать guards для ветвления.

Проверю, как работает функция. Например, isPrime 7 должно вернуть True, isPrime 9 — False.

Если все правильно, то напишу код с комментариями, объясняющими каждый шаг.

И я это всё примерно со скоростью 80wpm ожидал, хотя задача примитивная, куда столько?

>И я это всё примерно со скоростью 80wpm ожидал, хотя задача примитивная, куда столько?

А теперь представь, что ты студент и только начинаешь изучать этот Хаскел. Ну даст тебе модель готовую программу, даже с комментариями, а толку? А здесь видна мысль :)

Пробовал это всё, правда, не сильно помногу - остался в итоге на магмеле. Показался самым сбалансированным в плане кум/мозги/сторителлинг. На втором месте, наверное, росинанте, там чувствовался нестандартный рп датасет, персы казались более живыми. Магнум лежит составляющей и в магмеле, и в немомиксе, если что, как и в куче других мержей. Да и не удивлюсь, если всё те же логи опуса есть и в лире от сао, и в росинанте.

Есть ли смысл пихать какие то промты для кума или рп в таверну кроме базовых? Локальные модели ведь практически все расцензурены.

В смысле ? Промтов чего ?

Системные промты. А разве другие бывают? Ну кроме тех кто есть у самих карточек персонажей.

бывает еще промт суммарайза.

А по самой теме вопроса, это зависит от модели. Читай описание, если это не пидарасы в духе команд-р, которые вообще нихуя не пишут, сиди гадай блять.

>команд-р

Лол блять, я как раз его скачал пол часа назад и проверяю что он может. В сторитейлинг и рп он норм, но вот в куме он чет пока совсем не очень.

А я говорил тебе качай цидонию, но нет, мы хотим русский РП, ко ко ко.

А я другой анон, я просто после работы полистал тред и решил попробовать, я даже забыл что командер в русь может нормально. Ссылка или упоминание нормальной цидонии для нищуков на 8гб выше были?

Так-то командер - буквально лучший для кума среди стоковых моделей и вполне может дать фору даже некоторым шизомиксам по познаниям в ебле, фетишах, описанию этого и инициативе. Причем, просто так на хуй не прыгает, если цундере или чар невинный - они будут именно такими. Плохо только что туповат.

>нормальной цидонии для нищуков на 8гб выше были?

Сорян, я аутяга. Нет, я конечно видел маленькие версии цидонии но не пробовал. Тут сорян, все что ниже 12б я не пробовал, после потуг в РП. Они не плохие, но я же янедереёб, мне нужен horor и despair, что то в духе у меня нет рта и я хочу кричать, но в попытке убежать от ебанутой. А двенашки или слишком соевые, или не дотягивают до хардкора в диалогах. Они конечно могут описать действие, но не хватает именно... Я даже не знаю как это описать, вот как флирт с девушкой. Ты же не говоришь тян что ты её выебешь на столе, вы оба понимаете о чем речь, но соблюдая правила приличия ведете социальный и местами довольно горячий диалог, так и тут. Всякие более крупные модели могут в подобные диалоги, а маленькие они слишком прямолинейны.

> Причем, просто так на хуй не прыгает, если цундере или чар невинный - они будут именно такими.

А, вот в чем дело. А я привык что все модели хуй постепенно кладут на это и сами лезут в трусы. А тут ЕРП нахуй, тут прям реально нужно лезть и намекать.

Ну командер уже наглан мне сжима очка. Я в темном лесу нарвался на руины, слегка приоткрытая дверь, ну я зашел, а там нёх, что из темноты с лезвиями вместо пальцев кидалась на меня, уходила в тень и нападала со спины попутно плюя кислотой. Потом вообще щупальцами начала атаковать, а я отбивался факелом.

> далее про флирт

Ну ты сейчас описал мое взаимодействие с карточкой на командере где персонаж вся такая любящая, не замечающая странных действий и тд. Ей все в шутку и "я тебя люблю, я сделаю это" но она не замечала что эти действия были какими то интимными.

В таверне есть настройки для comand-r. Выбирай и тыкай.

Ну тогда потыкаем команд-р. В конце концов, цидонька меня уже подзаебала. Я её конечно люблю, но мистраль остается в базе мистралью. Да и в целом, надо гему потыкать. Выскажу своё нахуй не нужное мнение через дней пять, лол, увы, нужно прям потыкать карточки, чтобы понять насколько хороша модель.

Кстати о настройках, в сис. промте можно как то обойтись от форсирования того что карточка не должна отвечать за меня? Или это собственно от карточки зависит? А то адвенчур карточки очень уж любят описать мои фразы, против действий я не против, это как кинуть кубик в днд, прокнуло или нет, но вот фразы и действия раздражают.

Кстати (просто вспомнилось) Wayfarer может порадовать в приключении. В таверне бармен решил подкатить ко мне. Я на всю таверну крикнул что бармен педофил и клеится. Часть народа пошла пиздить бармена, постепенно все начали пиздить всех. Я сидел за столом и наблюдал как все пиздятся иногда подбадривая их. Один гном замахнувшись кружкой попер на меня, обвиняя меня в пизделовке, но не успев дойти до меня его обратно затащили в драку. На кухне начался пожар, пожар потушил брат бармена и народ. Потом из кухни выходит избитый бармен и орет на меня что если бы не я, то этого бы не произошло и тут уже я скача по столам съебываю из таверны от злой на меня толпы. В итоге я с довольной лыбой убежал из бара, при этом не заплатив бармену за эль.

К сожалению когда я шел по улицам городка, он вывел меня на поляну и высрал очередного волка.

От персонажа зависит, если там блядища то сразу пойдет

> ара~ара, где там твой дружок?

Но как оно на русском - хз, рпшил с ним всегда на инглише. На фоне 12/22б, если не накосячишь с форматом и промтом, он не будет глупым.

> К сожалению когда я шел по улицам городка, он вывел меня на поляну и высрал очередного волка.

Soooqa, в голос, сделал мой вечер. После такого описания идеально.

>К сожалению когда я шел по улицам городка, он вывел меня на поляну и высрал очередного волка.

Пантеон мне при штурме Гудермеса высрал гоблинов. Вот тут десантура охуела.

> Soooqa, в голос, сделал мой вечер. После такого описания идеально.

Да в каждом новом приключении мне приходиться просить ии не высерать волка ИЗ ШОРОХА В КУСТАХ. В один из разов я даже кекнул, когда она высрала мне человека-волка, не оборотня, а именно сука человек-волк.

А вот теперь я проиграл в голосину.

Блять, ты уже второй тред гоблинов в лесу пиздишь, вышел бы хоть из леса, пробзделся.

Я понимаю зачем кумить, но…

> штурме Гудермеса

У меня даже слов нет.

Знаешь где еще можно штурмовать посадки ?

В вартандер, ведь только в вартандер сотни единиц техники

А вдруг гоблин вылезет из толчка ?

Да блять, я гоблина играю. А мне все высирают или волков или эльфа в лесу что норовит мне стрелу в жопу пустить или пещеры. Я уже огрызков моделей на 90гб накачал. Я хочу попробовать в постапок или боевые современные действия, но боюсь что на 6-7гб модели 100% обосрутся в менеджмент патронов/магазинов, учитывая что им приходится напоминать про инвентарь в средневековье или пихать его в суманизацию или в описание персонажа (хз как по другому сделать, не шарю). Ну вспоминается IZAR карточка, которая тупо выводила весь инвентарь в сообщении, учитывала кислород, течение времени, разряд акума и тд и тп, но это просто затягивание генерации каждый раз, тем более когда лутаешь ящики, а там тебе высерает 100500 единиц содержимого.