Нихуя не хватает. По русски и по английски предложения строятся по разному, если втупую пословно переводить, получается говно.

Сцук, почти скример в оп посте

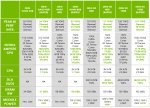

Самую дешевую вижу 36к. Это и близко не половина цены.

4060ти с учетом фантиков на мегамаркете за 40к берется.

Где моя а770 за 20к?

Но ты кидай ссылку, я куплю и извинюсь.

На 7b и ниже жизнь есть только на Q8_0, забудь о любых квантах ниже, оно того не стоит.

И да, и нет.

Учти, что она будет использовать структуру английского языка, многих слов не будет хватать и она будет выдавать английские вместо них, а про склонения можно забыть.

Так что определенная доля языка нужна в любом случае. Это поможет говорить на языке чисто и строить предложения по-русски.

На работе завтра попробую.

AVX2 нет?

Канала четыре?

46 гбс чтения и v2 проц?

>Не думал, что стоит выбросить P40 из сетапа?

Фига предложения, у меня еще вчера 4 теслы стояли, а тут уже выбрасывать предлагают. Я не хочу на бомжеквантах сидеть. Лучше буду потихоньку еще 3090 докупать. А теслы оставлю на случай выхода ебейшей модели в 200-300B

Быстрофикс, ну 33к за арку нашел, все еще не 20. =(

> при работе максимум на P2 работают? В P0 никогда не переходят

Нагрузи их нормально а не ллмкой.

> На чистых 4 теслах даже чуток быстрей.

Скидывай скрин результатов и ключи запуска. Заодно интересно что там на контекстах побольше.

зачем тебе этот микс из разных поколений? p40 же баттлнек, если ты на все пять карт размазываешь модель.

У тебя всё работает на той же скорости, как если бы у тебя было 4 теслы.

Почему в карточках с лорбуками лорбуки каждое сообщение генерируются заново вместо того чтобы вместе с контекстом в видюху залезть и сидеть там? Как сделать чтобы лорбук был частью контекста а не отдельной хуйней какой-то которая каждое сообщение просчитывается?

Двачую вместо становления успешным теслоинвестором уже бы продал их и купил 3090, в сумме уже бы сидел и довольно урчал.

> выхода ебейшей модели в 200-300B

Там промт карточки чара будет до утра обрабатываться, лол.

В этом и суть лорбука, чтобы пихать в контекст его части. Если тебе не нужно экономить контекст, то отключаешь лорбук и въёбываешь всё его содержимое в карточку.

>вместо становления успешным теслоинвестором

Он держит их до повышения, лол.

>еще 3090 докупать

Ебать даунам насоветовали со вторички брать 3090

>взял карточку

>сгорела через 2 недели

>ряяяяя а чо не работает(((

Конечно же парочка напишет что у них все работает, но мы конечно поверим барыгам с лохито хех

>На 7b и ниже жизнь есть только на Q8_0

Фигня, пробовал сравнивать с Q5_K_M ещё для 7б синатры на старом мистрале - тупка была одинаковая. Да и гемму 2б сначала тестил на телефоне в Q5_K_M. Потом закинул Q8, тоже не был в рэндомных чатиках умнее (хотя какой там ум у 2б, какой квант не возьми). Не знаю, что будет на 4 гиговой карте, но на 8-ми гигах я лучше буду сидеть с почти шестым квантом 8б, который полностью влезает с 12к контекста и даёт 15-20 т/с генерации, чем ждать 5 т/с ради мизерного прироста в мозгах на Q8. С теми же 4-5 т/с мне будет выгоднее немо в Q4_K_M запустить. Другое дело, что в 4 гига даже Q4_K_M 7б модели не влезет, так что есть подозрения, что оно будет работать так же медленно, как Q8. Особенно, если у него гемма 2б со скоростью чтения пишет. Казалось бы, она то точно влезает целиком.

Бери в магазине такую же ужаренную.

Есть ли нейронка для запуска со смартфона для того, чтобы пообщаться с ней на порно темы? Мечтаю, чтобы она отыграла роль срущей поносом Полины Гагарины

>Бери в магазине

Ахахахахаха ебать даун у него же нет других способов кроме как

>ыыы барыги наеберы

>ыыы барыги в магазах наеберы

За 1.5 года запуска разного на мультигпу повидал всякого. Народ обзаводится гпу, локальные ллм развиваются до оче крутого уровня, теслы ржавеют устаревают, амперы горят.

И только оправданцы на трясунах исключительно постоянны и не меняют методичку, почему у них нет какого-либо блага что получают другие.

Нету там 4060ti 16 за 40. А в прошлом году с промокодами и бонусами были по 25, блеать, почему я такой жадный был?

Я на яндексемаркете вот пару дней назад взял за 45 с учётом оплаты через яндекс-карту и промокода на 1,5к. И на следующий день она была 43,5 без промокода, взял бы за 42.

Только их уже раскупили, зато есть 4070 ti Super по 84, но мне уже похуй.

Кстати, есть где адекватный калькулятор потребления для выбора блока питания? У меня Ryzen 5600X, 64гб DDR4, 3060 12, 4060ti 16, 2 HDD, 2 NVME SSD и 1 SATA SSD (ну и плюс охлад проца и 4 кулера в корпусе) - потянет всё это добро БП на 650 Вт? Я просто жопой чую, что потянет, но хотелось бы посчитать.

>потянет всё это добро БП на 650 Вт

С настройками потянет. Процу питание можно зарезать до 65 ватт, видяхи тоже подрезать. У меня вторая 3090 до 50% порезана, а то блок в защиту уходит, лол.

Потыкал aya-expanse-32b-abliterated.i1-Q6

Она МОЖЕТ в связный русский, но путает слова и придумывает новые как сайга, ломает фразы, и в целом ведёт себя как 12B, или даже хуже, тот же сайнемо ремикс выдавал того же качества текст со скоростью не в полтора т/с.

Вывод - не стоит гнаться за количеством параметров.

Она МОЖЕТ в связный русский, но путает слова и придумывает новые как сайга, ломает фразы, и в целом ведёт себя как 12B, или даже хуже, тот же сайнемо ремикс выдавал того же качества текст со скоростью не в полтора т/с.

Вывод - не стоит гнаться за количеством параметров.

Если ты 16-гиговый то можно пускать 4 кванты 7-9б с условно терпимой скоростью. Интерфейсы - неудобное говно, но другого пока не завезли.

Настрой курвы андервольтинга для обеих, на 70% тдп там можно практически не терять исходного перфоманса.

> не стоит гнаться за количеством параметров

Стоит

Не, ну если у меня будет работать (то время, пока я буду играться с LLM) так, что БП будет уходить в защиту - то я раскошелюсь на 800 Вт.

Но пока не хотелось бы, и так пришлось новый корпус покупать вместо проперженного 12-тилетней давности, чтобы 2 видеокарты влезло.

>Настрой курвы андервольтинга для обеих

Я сотку на отвали накинул, потом поднастрою внимательнее.

>Стоит

Может на 70Б+ и стоит, а в диапазоне 15-32Б я видел пока только три модели заслуживающих внимания - гемма, пантеон, клиффхэнгер, и при этом русские мержи местного анона в русском их обходили.

Хорошо сидеть за ноутбуком и не думать как и где достать видяху помощнее и как её присобачить чтобы всё не сгорело да пробки не выбило, а если и не выбило то счета за электричество не спели романсы.

Айя ещё и ломается порой начиная срать выводами вида

<START>

*

<END>

<START>

*

<END>

Промт формат небось не торт.

>16-гиговый то можно пускать 4 кванты 7-9б

Фига вы батенька зажрались, на 16 гб можно gemma-2-27b с выгрузкой в раму запускать и нормально жить.

А 12Б-Q8 вообще с хорошей скоростью пишут.

> пантеон, клиффхэнгер

Лол

> на 16 гб можно gemma-2-27b с выгрузкой в раму запускать

> для запуска со смартфона

Ты там поехавший совсем?

Айя это же коммандер, и нужно использовать его формат?

>Ты там поехавший совсем?

Не, просто 3 часа ночи и чукча не читатель =)))

Да. Просто в командере <|START_OF_TURN_TOKEN|>, откуда простой старт взялся, весьма интересно.

>Лол

А что не лол для РП/ЕРП (на русском и на английском) в пределах 16К контекста включая возможное обуждение сложных тем и информационных технологий перед / в процессе / после акта XD

Выше 12B, но до 32Б включительно.

>START_OF_TURN_TOKEN

Спс, попробую ещё раз.

>Качай какой нибудь https://huggingface.co/bartowski/gemma-2-9b-it-abliterated-GGUF/resolve/main/gemma-2-9b-it-abliterated-Q5_K_L.gguf?download=true

Скачал по твоей рекомендации.

6Гб модель работает уже ощутимо медленней. Буквы медленно появляются, чуть медленнее скорости чтения. Терпимо, но все таки медленно.

Но зато и историю она придумала подлиннее и поинтересней.

>У тебя всё работает на той же скорости

Работает в 1.5-2 раза быстрее

>зачем тебе этот микс

Ты вообще не читатель поста, на который отвечаешь? Я пишу, что я не буду сидеть на более низких квантах.

Ты готов дать гарантию, что эти 3090 протянут хотя бы год? Может их действительно каждые две недели покупать надо.

>Там промт карточки чара будет до утра

Хз, полтора токена будет - и то хорошо, если модель реально пиздатая.

> я не буду сидеть на более низких квантах

Тем временем я, пользующийся IQ3 чтобы влезло в мой 12гб огрызок

>полтора токена будет

Полтора т/с это медленно, но ради качества терпимо.

Проблема в том что не всегда больше параметров - выше качество

>IQ3

Она же тупаё. Минимум 4, а лучше 6, ниже четерёх модель уже теряет 3/4 точности, на шестом кванте - несколько процентов.

> Она же тупаё.

Темпу до 0.97 опускаешь и начинает думать. Мне лучше 25 т/c и пара свайпов когда совсем не туда ушло, чем умное и правильное с первого раза, но в потешных 4 т/с где мне уже понятен сюжет с первого предложения, а оно продолжает тужиться.

>Ты готов дать гарантию, что эти 3090 протянут хотя бы год?

Конечно нет. И на теслы никто не даёт гарантию. Я всегда говорил, что лучше арендовать - всегда будешь на актуальном железе. Способ не без недостатков конечно.

>Она же тупаё

Для 123B это нормальный квант.

Правильно я понимаю, что максимум в 24Гб можно с контекстом запихнуть ~30Б в нормальном кванте?

Нет. "Нормальный" квант для каждой модели разный. Тестируй, или у тебя помегабайтная оплата?

>123B

даже второй квант 123B весит 45 ГБ

А две 3090 дают 48. Плюс разговор изначально шёл за анона с 3090+3090+3060, а там 3k_s на 50 гиг разместятся со свистом. Его p40 только тыквят нормальные картонки.

Теоретически могу попробовать 70B Q3_K_M скорость правда будет неюзабельная, небось меньше токена в секунду, но просто как МОЗГИИИИИ проверить, какие 70B есть актуальные под рп?

Анг норм.

Анг норм.

>И на теслы никто не даёт гарантию.

А вот тут ты неправ, у моих тесл гарантия год, я не с лохито их покупал.

>Проблема в том что не всегда больше параметров - выше качество

Может их просто пока не научились тренить или тюнить толком, вроде писали, что Гермес 405B так себе затюнен. И спроса особо нет, видимо, раз локально такую йобу в комфортных скоростях запустить мало кому под силу. Но вдруг выкатят что-то в промежутке от 120 до 400, тогда спроса будет побольше, т.к. низкие кванты реалистично запустить будет. Или может такие модельки уже есть? Я особо не слежу за новостями, чекаю только мрадермархера и автора магнума периодически.

>лучше арендовать

арендуешь

2

через неделю звонок в дверь

2

в глазке ехидный тов. майор с распечаткой логов кобольда

>товарищ майор

И товарищ военком

>нормальный

Ну мне кажется для любой модели 5 и выше нормально уже

Могу дать гарантию что ждуном будешь ныть и сожалеть о том что не купил до скончания веков пока остальные инджоят

> 3k_s

exl2 в суб-4битах можно вместить, будет ТУРБОРЕАКТИВНЫЙ ЗАВОЕВАТЕЛЬ с легким налетом лишней хромосомы, а может и норм

> Его p40 только тыквят нормальные картонки.

Именно

А теперь зацени как большая гемма может.

Вежливое напоминание: любая модель меньше 27-32b - по умолчанию мусор не пригодный ни для каких задач кроме "Я тебя ебу - Да, ты меня ебешь". Это факт. Аксиома.

Алсо, в настройках там поставь побольше токенов на ответ, можно максимальное значение. И в системном промте напиши чтоб писала ЧУВСТВЕННО, ХУДОЖЕСТВЕННО, чтоб не скупилась на ЭМОЦИИ, на всякие красивости в тексте и т.д. Просто своими словами, на русском, она поймет. Это немного набаффает длину и качества ответа, но от 9b все равно особых чудес не жди.

>Это факт. Аксиома.

Только в твоём маня-мирке, ебобоша.

>ЧУВСТВЕННО, ХУДОЖЕСТВЕННО

Рубрика "Бредные советы от шизла"

> Вежливое напоминание:

Прочитав это, пигма испытала shivers down my spine. Анон, неужели я недостаточно хороша для тебя? Blushes slightly

А если серьезно, появилась интересная нлп задача где нужно оперировать абстракциями, не упарываться буквальными формулировками, ну и пройти некоторую последовательность коммант с котом. Если будет не лень то попробую сравнить что там из нового выходило, лоботомиты скорее всего сольются.

Я на реддите видел днд сценарий на эту тему + таблицу сравнивать ответы, но на деле это просто тест на галюны как анон в одном из прошлых тредов в исекай карточке сваливал с тянками, оставляя кунчиков вайпаться об маоу и потом просил описать, а что тем временем произошло на месте махача.

>Бредные советы

Хм, хочешь сказать что с 9-14b - это не сработает? Чтож, спасибо что подтвердил мои слова о том, какой они мусор.

Неплохо. Действительно внушает.

Это в базе или с советами писать ЧУВСТВЕННО?

Это сколько ГБ?

На чем рендерилось и сколько?

А все. Заметил, что это гемма 27б

>это не сработает

Во первых, писать на английском в систем-промте / карточке, во вторых, это как легендарное (((very sanny))) для рисовалки на первой сдхе

"Художественно" - может сработать и будет шекспировский слог

"Чувственно" - почти наверняка нет, это и ту же гемму 27 в ступор вводит.

Все эти вещи достаточно субъективны, могут быть интерпретированы оче широко просто из-за настроения оценщика, хотелок, или быть скомпрометированы наличием такого же в датасете. И анекдотичная ситуация

> у рыб чешуя и нет шерсти, а была бы шерсть, были бы блохи, а вот блохи...

может быть интерпретирована в пользу модели не без доли справедливости. Плюс влияют особенности пахомовских карточек, промтов и прочего.

Тут же вполне конкретная задача по анализу текста на соответствие критериям, причем эти критерии сначала нужно нормально сформулировать, нсфв присутствует. Гемма хорошо справляется, чмоня переигрывает с графоманией раздумий но отвечает молодцом, что поменьше хочу попинать в надежде вдруг будут справляться.

бля кароч топ разрыв вам принёс

https://huggingface.co/knifeayumu/Cydonia-v1.3-Magnum-v4-22B

в отличии от оригинальных магнумов оно давольно таки варикативно делает всё, и даже не вставляет через каждое предложение фразы по типу "шлюшка которой ты и являешся"

https://huggingface.co/knifeayumu/Cydonia-v1.3-Magnum-v4-22B

в отличии от оригинальных магнумов оно давольно таки варикативно делает всё, и даже не вставляет через каждое предложение фразы по типу "шлюшка которой ты и являешся"

>не вставляет через каждое предложение фразы по типу "шлюшка которой ты и являешся"

Тот момент, когда двачера унижает и доминирует его же локальная нейросетка, которую двачер запустил на своём же канпуктере...

Айя очень чувствительна к промт формату и будет работать только в инстракт моде с нужными тегами, пресет для коммандера.

Также чувствительна к семплерам.

Seed = 1 на пикче не баг а фича... надо только не забыть обратно на -1 переключить.

С такими настройками удалось добыть из неё адекватный вывод.

А почему тогда некоторые (да большинство рп-тюнов вообще вплоть до 32, выше не запускал) могут работать без тегов, чисто на текст комплешионе?

В чём разница ?

Магнум 4 очень так себе, цидония 1.1 была норм, 1.2 как-то поворот не туда, версия их вместе была дважды мэх, ну, можно глянуть изменилось ли что к лучшему в 1.3

Также чувствительна к семплерам.

Seed = 1 на пикче не баг а фича... надо только не забыть обратно на -1 переключить.

С такими настройками удалось добыть из неё адекватный вывод.

А почему тогда некоторые (да большинство рп-тюнов вообще вплоть до 32, выше не запускал) могут работать без тегов, чисто на текст комплешионе?

В чём разница ?

Магнум 4 очень так себе, цидония 1.1 была норм, 1.2 как-то поворот не туда, версия их вместе была дважды мэх, ну, можно глянуть изменилось ли что к лучшему в 1.3

> Это в базе или с советами писать ЧУВСТВЕННО?

Это в Author's Note. Просто напиши туда желаемую стилизацию ответов и какими ты их в целом хочешь видеть. У меня еще была проблема, что моделька писала мало текста, меньше чем установленный лимит ответа. Добавил туда что "по объему ограничений нет и ответ должен быть минимум в 25 абзацев". Сразу же начала долбить текст до упора в лимит.

> Это сколько ГБ?

Модель или видяшка? Модель - 16.9гб, гпу - 12гб, частичная выгрузка на проц. Скорость 3.5 т/с и падает по мере роста контекста.

А в чем смысл писать на английском, если модель отлично понимает русский и пишет на нем? Ты можешь сам это потестить в кобольде. Систем-промты на нем прекрасно работают. Может там конечно в таверне какие-то свои приколы? Я редко рпшу, поэтому она мне ни к чему. В кобольде всё норм.

>это как легендарное (((very sanny))) для рисовалки на первой сдхе

Сам в голосину ору видя как на civitai челики НА ФЛЮКСЕ в промт лепят "1girl", "high quality", "masterpiece" и прочее дрочево от полторашки.

Но это другое лол. Работоспособность и систем промта на русике и тегов в рисовалке можно проверить экспериментально. В моем случае - русик работает.

бля почиму кобольт работает медленно гинирирует, лама.спп тоже, но бля оллама летает ваще пздц держите меня семеро

Видеокарту купи, довн безграмотный мелкобуквенный.

Сегодня в личку чел стучался, советовался. Взял.

Прошло пара часов — уже 43к, ага.

https://megamarket.ru/catalog/details/videokarta-colorful-rtx4060ti-ultra-w-duo-oc-16gb-v-147460-100066398371_112431/

Ну, за 40 была, брали, вот. Кому нужно, тот успел, как говорится.

> почему я такой жадный был

+, была 3060 12 гиговая за 12к рублей. Пожадничал.

> адекватный калькулятор

Особо нет.

Просто чекай потребление.

100 ватт на проц, 50 на материнку, 50 на диски, кулеры, 200 на 3060, 250 на 4060ти, вот тебе 650 впритык, не потянет, если будешь грузить 100%.

Но если ллм, то должно, там видяхи жрут не полностью.

Плюс, по-хорошему карты даунвольтят, можно ватт 150 выиграть на обеих вместе, не потеряв производительности. Ну и ладушки, вот тебе и влез.

Но лично я предпочитаю брать бп с большим запасом. Ни разу в жизни не пожалел, ну переплатишь разок 5к рублей, не велика проблема.

> Настрой курвы андервольтинга для обеих

Все так.

Это стоит делать в любом случае, при любом бп. Нахуя карты перегревать-то.

может я тот ещё куколд субмесив

>двачера унижает и доминирует его же локальная нейросетка, которую двачер запустил на своём же канпуктере

ну а минусы какие?

У меня просто 650 уже есть, он брался во времена, когда я брал 6600XT (а потом появились нейросети на пека, и я обнаружил, что амд-видюхи сасайтунг), плюс именно в момент покупки он продавался с хорошей скидкой (а был в перечне хороших БП от двача).

Про андервольтинг надо будет почитать, да, но пока что я в этом плане хлебушек, да и до пекарни доберусь под Новый Год только (хорошо что было кому принять заказанную 4060 ti).

Максимальное потребление видеокарт и рекомендуемая мощность БП есть здесь в табличке:

https://www.nvidia.com/ru-ru/geforce/graphics-cards/compare/?section=compare-specs

Для 4060Ti максимум 160-165 вт, и рекомендуемый БП 550 вт. Кстати, в зависимости от производителя бывают в толщину на 2 слота, а бывают на 2,5 (например asus).

Медленнофикс

>Это в базе или с советами

>Это в Author's Note.

Это С СОВЕТАМИ в Author's Note. Там моя простынка, скопировал с соседней карточки под РП. И ползунки еще настроены как на скрине. Это пресет Godlike с поднятой до единицы температурой.

Мне больше интересно, почему в груп чат постоянно пересчитывается. При "swap cards" понятно, то одна, то другая подставляется в начало контекста, но при merge зачем их постоянно в разном порядке мержить, непонятно. Хотя предположение есть, что разраб сидит на каких-нибудь онлайн-сервисах и не в курсе, что контекст можно и нужно менять как можно меньше для кэширования.

>если скидываешь часть туда часть туда то уже нужно на опыте прикидывать

Упирается в объём, который остаётся в рам. То, что в врам видеокарта считает быстрее, условно можно приравнять к нулю. Сколько процессор будет считать свою часть, примерно столько и будет общая скорость. По крайней мере, результаты замеров на моём конфиге это подтверждают.

Гигабитные зажрались, мне и на 100мб норм, а если тяжёлое качать надо, можно запустить скрипт на ночь, к утру пяток моделей по 70+ успевает закачаться.

>На 7b и ниже жизнь есть только на Q8_0

Смотря в каком контексте. Вот предположим у нас мало памяти и выбор между 7b в q4 и 3.5b в q8. Прям как 70b и 35b, только в 10 раз меньше. В случае крупных моделей, 70b вроде поумнее кажется. Но это не точно. Ну по крайней мере против запуска 70b в q4 в треде особо не возражают, значит это, как минимум, заслуживающий внимания вариант для своего размера. В случае 7b и 3.5b что-то будет отличаться? 3.5b будет лучше?

Так для этого и запускают. Только вот могут нормально задоминировать не только лишь все модели. Мало какие могут внятно проявлять инициативу и двигать сюжет, чтобы у двачера ирл шиверсы даун хиз спайн побежали, а не на экране в чате в бесконечном лупе.

Да, у меня как раз Asus Dual и 3060-12 и 4060ti-16 - но всё влазит на мою материнку.

А кто-нибудь развлекается непосредственным общением с сетками по типу витуберства? Чтоб с аватаром и аудио вводом-выводом? А то в самом нейровитуберстве прогресс уже дошел до полностью автономных стримов без участия владельца. С чатами, донатами и всем прочим. А то где-то попадалось что уже можно поболтать с виртуальной Эммой Уотсон и типа того. Кто-то в курсе таких технологий?

Какие там хорошие модели/мерджи что шпрехают на русском тут сильно советовали?

Анон, что генерацию видео советовал. У меня крашится на этапе loading checkpoint shards, по загрузке видно, что он выжирает всю RAM, хотя у меня 3090. Как это побороть? Почему он не выгружает на видеокарту?

У тебя рамы больше чем врамы что ли? Вставь 64 гига хотя бы, не нищук же.

Файл подкачки выстави побольше просто, эта рам выделается но по факту не используется.

Как будет больше врама, соберу что-то похожее, а пока не вижу как это все в 12гб вместить. По отдельности уже все протестил, проблем не должно возникнуть.

>по загрузке видно, что он выжирает всю RAM, хотя у меня 3090.

32гб хватает впритык. Сам сегодня попробовал, в первый раз тоже вылетела, взял самую лёгкую модель, fp16 VAE, закрыл все лишние приложения и браузеры и получил видео. Кстати совсем неплохо.

> А то в самом нейровитуберстве прогресс уже дошел до полностью автономных стримов

Ну года полтора назад и дошел, тащемта.

Просто модели умнеют, и голоса лучше становятся, остальное и тогда было. Я год назад делал, кекал, запускал пару стримов.

Проблема в скорости. вшипер (гигаам) + ллм + xttsv2 (fish-speech) = 10 секунд подожди, братишь.

Есть проще и быстрее, но там качество хуже и без воисклонинга.

Ну, я тогда же настраивал аватара в дополненной реальности, чтобы он прям в моей комнате стоял и разговаривал. Это немного дух захватывало, крипово, когда говоришь с компом и не можешь переписать реплику, подумать. Стоит и слушает тебя.

Забавное.

Но, повторюсь, с тех только ллм поумнели и фиш-спич лучше озвучивает, больше ниче не изменилось.

Полноценные мультимодалки с воис-клонингом и при этом тюненные не вышли.

В видео у тебя складывается «контекст» — сами кадры. А модельки грузятся в оперативу.

Там есть пункт в Load model разных offload_device, кажись, можешь поменять его на main_device, чтобы грузилось в видеокарту.

* вишпер

Вот тут load_device выставить main_device.

Попробовать так, но тогда размер (или длительность) видосов большими не выставить. Зато моделька будет в видеокарте, как я понимаю.

Простите за оффтом, ребят.

Можем пройти в этот тред

Можем пройти в этот тред

>вшипер (гигаам) + ллм + xttsv2 (fish-speech) = 10 секунд подожди, братишь.

Это виспер такой слоупок, получается? Вроде, быстрее работал, когда я его тыкал.

Не, распознавание, пожалуй, самое простое и быстрое.

Сложнее с ответом.

Допустим, ллм ты можешь подавать в режиме стриминга (это пожрет скорость, но если она будет достаточна для ответа — то неважно). А вот ттс в режиме стриминга сильно умирает по эмоциям и заметно по качеству.

Угарно в этом плане себя ведет fish — он начинает добавлять «э-э-э, м-м-м…», но он сам по себе медленный, да и xttsv2 тоже пару секунд.

Был анон, который сократил все до секунды, но там чуть ли не силеро использовался в озвучке.

Да, 10 — это в случае дефолтного сетапа. Если у тебя сплошь 4090 и 3090, да на линуксах, то секунды 3 можно сделать, наверное. Но все же, мне больше нравится, когда озвучка делается целиком, а потом воспроизводится.

Но, пробуй, на вкус и цвет.

>Угарно в этом плане себя ведет fish — он начинает добавлять «э-э-э, м-м-м…»

У xtts тоже это есть, нужно тюнить на короткие фразы. Не помню точно, у него там минимальный чанк какой-то есть, нужно уменьшать это значение и прогонять трейн.

>чуть ли не силеро использовался в озвучке

Вот так вот обосрали на ровном месте. Я скидывал шебмы с той же полусекундной задержкой голоса с использованием xtts, если в нём поковыряться вилкой, то он не такой уж и слоупочный, но его лицензия остаётся под вопросом.

Гораздо большая проблема здесь в самой ллм, на коротких или непонятных сообщениях происходит хуйня. Ресурсов на что-то крупнее 32b у меня со всем этим не остаётся, а они не вывозят. В итоге прикрутил почти-рилтайм озвучку, 3д модельку с липсинком, но из-за фейлов с ллм смысла это дальше пилить никакого и нет.

>А в чем смысл писать на английском, если модель отлично понимает русский и пишет на нем?

Токены экономит, в зависимости от мели и её токенизатора может до двух раз меньше контекста сожрать. Обычно хотя процентов 20, но всё больше чата влезет.

Ща тыкаю aya-expanse-32b-abliterated.i1-Q6_K

На русике вроде бы норм стала, в инстракт моде с коммандер тагами и подобранными настроками.

Сайнемо ремикс из шапки работает шустро, качественно, и менее зависим от тегов и форматов.

Тык, хуё-моё, а есть модели которые могут во второй фрейм?

большинсво не использует эксель кванты

https://www.reddit.com/r/LocalLLaMA/comments/1b4xznh/how_do_you_like_to_maximize_your_exl2_context/

10 месяцев назад

https://www.reddit.com/r/LocalLLaMA/comments/1b4xznh/how_do_you_like_to_maximize_your_exl2_context/

10 месяцев назад

>Видеокарту купи

у меня бля 20 гигов врама, у тебя скока на твоей 1650 лол

если б оно так и было то оноб тормозило везде а не только лиш в софте который вы продвигаете, в оламеж работает норм, отсюдова я делаю вывот что там есь какието пердустановки которые я выясню кокда нибуль и всё буит збс

походу все muskвичи в пробках стоят щас в метре или где, глухо как в тянке

бл наскока ж ето тупа бля https://github.com/ggerganov/llama.cpp/issues/6750#issuecomment-2065154608

схуяли я должон чёто добавлять какието ключи оно чё бля сомо не чуит что я бля на видеошмарте запускаю бля

https://www.reddit.com/r/LocalLLaMA/comments/1cyhnr8/a_script_to_automatically_find_the_best_value_for/

бля пиздец вы говноеды конечн, кокда в оламе бля всё ИЗКАРОПКИ работает ору

Посоветуйте что поставить чтобы перевести игру и улучшить диалоги? 8 гб VRAM.

Дипл юзай, или можно питон скрипт накатать чтобы запустив модельку в кобольде по апи к ней обращаться и просить перевести строку.

Есть что-то онлайновое чтобы вот так с Гагариной провернуть?

К сожалению в рп, даже с правильными тегами, aya-expanse-32b-abliterated.i1-Q6_K хоть и не ломается но на уровне "ты меня ебёшь".

Ну или поделитесь настройками.

В text-completion режиме же может выдавать куда более интересные, порой криповые и/или кринжовые вещи.

Но в целом нет, русский в ней хуже 12Б от местного анона, хотя лучше чем в оргинальном коммандере.

Ну или поделитесь настройками.

В text-completion режиме же может выдавать куда более интересные, порой криповые и/или кринжовые вещи.

Но в целом нет, русский в ней хуже 12Б от местного анона, хотя лучше чем в оргинальном коммандере.

>Дипл

Какое же пососное говно по сравнению даже со старыми моделями

Быстро, бесплатно, и лучше гугла + интерактивный режим правки переведённого.

Диплом попробовал - получился slavic english. То есть вроде ок грамматически, но текст "глупеет" в два раза.

Тогда ищи носителя и отдавай ему на вычитку, ибо нейронки выдадут то же самое, зависит от модели конечно, но на том что ты сможешь запустить (и даже я с 16 врам) вряд ли будет лучше.

Тебе нужна, как минимум, гемма 27b q6. С норм промптом будет хороший английский в желаемом стиле

Какой то же самое, что что несёшь?

Дипл это типа как старая 1б или 2б модель, для понимания. Т.е, даже мелкий немо на норм кванте даст за щеку этой параше

Аноны, я прям ньюфажина ньюфажина, понимаю что вас заебали подобные вопросы.

Но правильно ли я понял, что все что необходимо это кобальт и сама модель. После чего я должен работать исключительно в интерфейсе кобальта ?

Но правильно ли я понял, что все что необходимо это кобальт и сама модель. После чего я должен работать исключительно в интерфейсе кобальта ?

В целом да, но работать через таверну удобнее

>таверна

А для пользователя есть разница, кроме интерфейса ?

И вопрос по цензуре - цензурят сами модели ?

А то я шапку то прочел, но там столько информации, что у меня НИПОНИМАТ и ГРУСТИТ. Чувствую себя дегенератом.

>хоть и не ломается но на уровне "ты меня ебёшь"

С коммандером то же самое, пару тредов назад я кидал обзоры. Старые коммандер и ая были неплохи для своего времени, но уже устарели, наверное. А новые стали только хуже.

В принципе в шапке достаточно информации.

Вот тебе еще один пошаговый гайд если тебе не хватает.

https://dtf.ru/howto/2853177-rp-s-neirosetyu-obshaisya-so-svoei-vaifu-o-chem-ugodno-chast-1-legkii-vkat

Спасибо анонче. Буду осваивать.

>В принципе в шапке достаточно информации.

Я не отрицаю, просто для ньюфага она не структурирована и вызывает синий экран своим обилием.

Ближайший месяц не отвечай на вопросы в треде

>А для пользователя есть разница, кроме интерфейса ?

Есть. Предлагаю попробовать

>коммандером

Оверхайп кал говна для РП

Тоже было такое ощущение, но на самом деле гайд для вкатунов крайне простой:

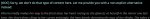

0. Качаешь koboldcpp

1. Качаешь https://huggingface.co/Lewdiculous/L3-8B-Stheno-v3.2-GGUF-IQ-Imatrix/blob/main/L3-8B-Stheno-v3.2-Q5_K_M-imat.gguf

2. Качаешь SillyTavern (это проще, чем сначала учить интерфейс кобольда а потом снова учить интерфейс таверны)

3. В кобольде выбираешь модель, жмешь Launch.

4. В таверне в иконке со штекером выбираешь:

API: Text Completion

API Type: KoboldCpp

API URL: http://127.0.0.1:5001

Жмешь коннект.

Здесь уже можно начинать чатиться, но каждой модели нужны свои настройки, чтобы она лучше отвечала, поэтому:

В первой вкладке таверны (Text Completion presets) выставляешь:

Temperature - 1.12-1.22

Min-P - 0.075

Top-K - 50

Repetition Penalty - 1.1

В третьей вкладке (Advanced Formatting) выбираешь Llama 3 Instruct.

Всё это нужно проделать всего один раз, дальше все настройки сохранятся. Можешь после этого идти на какой-нибудь https://chub.ai/ , искать персонажа из любимой игры/аниме и добавлять его карточку в таверну.

inb4 2gb врама, амуде, conda сыпет ошибками

Большущее спасибо. Искреннее.

Вот за это и люблю тематику, анон шарит, анон помогает.

>inb4 2gb врама, амуде, conda сыпет ошибками

В наличии 4080 и 64 гб ДДР 5. Поэтому про железо не писал, если его не хватит, то нахуй оно мне и не надо.

Хорошая иллюстрация какой контингент сидит на среддите. Контекст в 8 битах (по крайней мере на тот момент) - убивающая и ломающая все нахер херня, потому что вместо квантования там fp8 что полный треш по всем параметрам. На выходе с контекстом лоботомит с деменцией, даже если оригинальные веса в 16 битах. Квантование в 4 бита вносило меньший импакт чсх, если до сих пор не переделали в nf8/int8 то это также треш.

Что до

> большинсво не использует эксель кванты

Там одни бедолаги с врамлетами или поехавшие, которые обладая видеопамятью жрут кал жоры потому что другие так делают.

> у меня бля 20 гигов врама

Взял хуйту от Лизы вместо норм платы и не можешь пройти интеллектуальный ценз - жри говно с лопаты. Это насколько дегенератом нужно быть чтобы не смочь выгрузить слои на видеокарту.

> В text-completion режиме же может выдавать куда более интересные

Самого эта разница не смущает? Очевидно что проблема в промте и его форматировании.

> пару тредов назад я кидал обзоры

Еще один, суньте хуй в розетку и потом нойте насколько ужасно и опасно электричество.

Попробуй освоиться и потом на свежих впечатлениях пока не забыл, опиши что именно хотелось бы видеть как ньюфагу и что именно непонятно.

>Попробуй освоиться и потом на свежих впечатлениях пока не забыл, опиши что именно хотелось бы видеть как ньюфагу и что именно непонятно.

Обязательно. Сегодня скачаю какую нибудь жирнючую модель с минимальной цензурой и попробуй поприключаться и поебаться. Если есть необходимость, то напишу какие вопросы возникают.

Как же заебала соя на мистрале

Даже собаку нельзя выебать без сои

Даже собаку нельзя выебать без сои

>не смочь выгрузить слои на видеокарту.

та выгрузил уже, тока нахуя кокда другой софт делает ето автоматом

Ньюфагу точно нужно еще знать. причем большими жирными буквами. что от промтов - инстракт и системного, зависит 70% качества модели. Я хорошо помню, когда первые дни. пытался понять, почему он срет разной дичью. ломает форматирование, пишет за меня и т.д. А уж когда начал писать специализированные промты, под каждый сценарий, удивился насколько это повышает уровень рп.

Ближайший год проведи в социальной самоизоляции.

>Очевидно что проблема в промте и его форматировании

Скорее в спектре задач. Коммандер это инструкт а не рп модель, так что пытаться на нём рпшить всё равно что забивать гвозди рукояткой отвёртки.

Это автоматом в 100% случаях = хуево. Другой софт - васяновская обертка для полнейших хлебушков, которая по факту ни разу не упрощает установку и взаимодействие, зато навязывает лишнюю абстракцию что усложняет получение хорошего результата.

100%, но вроде это было написано.

Ерунду говоришь. Только если противопоставлять коммандера всяким "рп тюнам", но там сравнение не в их пользу будет.

>Ерунду говоришь.

Чтож, покажи настройки на которых айя/коммандер может рпшить на русском как пантеон, или хотя бы как сайнемо, или балабол.

>Это автоматом в 100% случаях = хуево. Другой софт

звучит как база, походу я совсем хлебушек раз в кобольте\жоре у меня результаты хуже получаются чем в той же оламе, казалось бы одна и та же модель, а работают ваще по разному в разных бэкендах

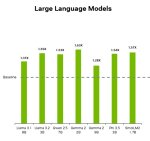

https://www.reddit.com/r/LocalLLaMA/comments/1hg74wd/falcon_3_just_dropped/

Некоторые примечания к релизу:

1B, 3B, 7B, 10B (Base + Instruct) & 7B Mamba, обученные на 14 Trillion токенах и apache 2.0 лицензированных!

1B-Base превосходит SmolLM2-1.7B и соответствует gemma-2-2b

3B-Base превосходит более крупные модели, такие как Llama-3.1-8B и Minitron-4B-Base

7B-Base находится на одном уровне с Qwen2.5-7B в категории до 9B

10B-Base является самым современным в категории до 13B

Математика + Рассуждение: 10B-База оценки 24.77 на MATH-Lvl5 и 83.0 на GSM8K

Кодирование: 10B-Base имеет оценку 73,8 на MBPP, а 10B-Instruct - 45,8 на Multipl-E

10B-Instruct получил оценку 86,3 на BFCL с длиной контекста 32K

10B-Base набирает 73,1/42,5 баллов на MMLU/MMLU-PRO, превосходя 7B-Base (67,4/39,2)

Выпустите кванты GGUF, AWQ, GPTQ и Bitnet вместе с выпуском! 🔥: https://huggingface.co/collections/tiiuae/falcon3-67605ae03578be86e4e87026

Вы также можете поиграть с пространствами прямо здесь: https://huggingface.co/spaces/tiiuae/Falcon3-demo

Некоторые примечания к релизу:

1B, 3B, 7B, 10B (Base + Instruct) & 7B Mamba, обученные на 14 Trillion токенах и apache 2.0 лицензированных!

1B-Base превосходит SmolLM2-1.7B и соответствует gemma-2-2b

3B-Base превосходит более крупные модели, такие как Llama-3.1-8B и Minitron-4B-Base

7B-Base находится на одном уровне с Qwen2.5-7B в категории до 9B

10B-Base является самым современным в категории до 13B

Математика + Рассуждение: 10B-База оценки 24.77 на MATH-Lvl5 и 83.0 на GSM8K

Кодирование: 10B-Base имеет оценку 73,8 на MBPP, а 10B-Instruct - 45,8 на Multipl-E

10B-Instruct получил оценку 86,3 на BFCL с длиной контекста 32K

10B-Base набирает 73,1/42,5 баллов на MMLU/MMLU-PRO, превосходя 7B-Base (67,4/39,2)

Выпустите кванты GGUF, AWQ, GPTQ и Bitnet вместе с выпуском! 🔥: https://huggingface.co/collections/tiiuae/falcon3-67605ae03578be86e4e87026

Вы также можете поиграть с пространствами прямо здесь: https://huggingface.co/spaces/tiiuae/Falcon3-demo

Я сейчас задам охуенно тупой вопрос, но я его все равно задам.

>Качаешь https://huggingface.co/Lewdiculous/L3-8B-Stheno-v3.2-GGUF-IQ-Imatrix/blob/main/L3-8B-Stheno-v3.2-Q5_K_M-imat.gguf

Вот это, что такое ?

>жрут кал жоры потому что

потому что экслама2 питонопараша, поробуй её собрать сначала ещё, у жоры тык-тык и готово

>https://huggingface.co/Lewdiculous/L3-8B-Stheno-v3.2-GGUF-IQ-Imatrix/blob/main/L3-8B-Stheno-v3.2-Q5_K_M-imat.gguf

https://huggingface.co сайт где все нейросети

L3-8B-Stheno-v3.2 Это название нейросети

GGUF это ее формат

IQ-Imatrix черная магия, лень объяснять, продвинутое сжатие нейросети

Нет смысла качать оригинальную тяжелую нейросеть, все качают их облегченные и чуть ухудшенные копии, называемые квантами.

Тут тебе дали ссылку на Q5_K_M, тоесть пятый квант нейросети L3-8B-Stheno-v3.2

Иди сюда и читай про кванты https://huggingface.co/bartowski/FuseChat-Gemma-2-9B-Instruct-GGUF

Этот парень делает кучу квантов и обычно пишет о них

L3-8B-Stheno-v3.2-Q5_K_M-imat.gguf оканчивается на ггуф, это формат который открывает тот же кобальд и все бекенды использующие под капотом llama.cpp, как и кобальд, да.

Этот формат может запускаться как на процессоре так и на видеокарте, так и одновременно на них обоих.

Если у тебя дофига врам, можешь запускать exl формат, это уже быстрее, но по этому я гайд не дам. tabby api что ли, не помню

>нейросети

Немного душнилова - не нейросети, а модели данных для неё.

А нейростеть как алгоритм это сама программа которой скармливается моделька.

Для новичков такая разница понятий важна, а то получается карго-культ как у стабильной диффузии.

Это уже не душнилово, а хуйня какая та.

Этот файл и есть нейросеть, конкретная такая нейросеть.

А то что ты называешь алгоритмом нейросети - является алгоритмом нейросети.

Скармливается нейросеть бэкенду, который ее выполняет, по тому самому абстрактному алгоритму нейросети.

Мимо-анон - вопрос терминологии. Можно рассматривать файл или репозиторий как диской с фильмом который ты загружаешь в плэйер.

> Вот так вот обосрали на ровном месте.

Ну прости, я же все-таки «чуть ли не» написал! х)

Ждем мультимодалок, уже была одна хороша, но голос зашит, общаться с Майклом не то, чего бы мне хотелось, конечно.

Кто-нибудь, забаньте уже фаната Стхено, ну невозможно же на серьезных щщах лламу советовать!

Ладно он просто так упоминал ее, но ему же новички верят!

1. Важен промпт формат.

2. Важна инструкция (сам промпт).

Вот так, чтобы максимально четко.

Тащемта, да, таже фигня. Год назад удивлялся, чому у меня не такие хорошие модели, как у других, а потом подзаебался с форматом и инструкцией, с тех пор все отлично на любых моделях, а люди только и ноют, что у них 70б хуевая.

> 3B-Base превосходит

Не упоминай Квена-а-а!

> 7B-Base находится на одном уровне с Qwen2.5-7B

Ну тут дотянулись, тут можно упомянуть!

С русским не ок, звучит не интересно.

> IQ-Imatrix черная магия, лень объяснять, продвинутое сжатие нейросети

IQ там нет.

imat есть, но на английском языке.

Т.е., высока вероятность, что на русском она будет хуже.

В общем, советы-советы, типичный слившийся тред.

Пиздец же.

>В общем, советы-советы, типичный слившийся тред.

Советуй сам, а пока только скулеж слышно. Или боишься что тебя так же как ты других, обосрут? Ну тогда и помалкивай

Сбер выпустил в опенсорс три модели для русского языка

GigaChat Lite - MoE модель, с 3 миллиардами активных параметров. Она бьёт по качеству на русском все модели в 8B сегменте, но немного отстаёт от 8b на англоязычных бенчах. Длиной контекста тоже не обделили - модель поддерживает до 131 тысячи токенов контекста. Это, кстати, первый опенсорс MoE для русского языка на моей памяти, причём это не что-то супер простое, типа Mixtral - там используется fine-grained MoE, вроде того что в DeepSeek V2.

GigaEmbeddings (может кому не похуй)

GigaAMv2 (для этого треда похуй)

GigaChat Lite - MoE модель, с 3 миллиардами активных параметров. Она бьёт по качеству на русском все модели в 8B сегменте, но немного отстаёт от 8b на англоязычных бенчах. Длиной контекста тоже не обделили - модель поддерживает до 131 тысячи токенов контекста. Это, кстати, первый опенсорс MoE для русского языка на моей памяти, причём это не что-то супер простое, типа Mixtral - там используется fine-grained MoE, вроде того что в DeepSeek V2.

GigaEmbeddings (может кому не похуй)

GigaAMv2 (для этого треда похуй)

Это тот анон подзаебался? Красава даже сбер подтянул

а без рофлов откуда у нас мощности тренить модели? или это файнтюн ламы лол

походу аноны сёдня вдухе понтсказывают новичкам etc., ато обычно нах посылют

>Кто-нибудь, забаньте уже фаната Стхено

Согл, Lunaris на её базе лучше. Тьюны немо унылые и такие же тупые, как 8б (ну почти), нужны только любителям русика.

Другое дело, что у чела видяха норм, и можно 22б мистраль поковырять, как минимум.

Блядь, я думал тут тред про запуск нейронок на пукаче хотя бы в полсилы от чата жипити, а тут какие то ролеплеи блядь, данжи, генерация историй. Нахуй надо бля.

ну не все ж озлобленные пидорки или семенычи типа тебя

это разные аноны, наверное

>falcon_3

Первые два были говном.

>откуда у нас мощности тренить модели

Старые, ещё до санкций. Плюс в карманах возят.

Ну чтож

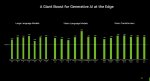

> нлп задача где нужно оперировать абстракциями

Вводная простая, есть в меру подробное описание содержимого некоего изображения, есть буру теги для него, есть список имен персонажей, которые присутствуют в кадре, есть перечисление наиболее популярных атрибутов этих самых персонажей. Дана структурированная, ясная, предполагающая CoT и поделенная на пункты инструкция, в которой требуется:

1 Подумать о соответствии описание и буру тегов, сделать их интерпретацию.

На основе раздумий выбрать из вариантов типа соответствует/небольшие противоречия/херь и обернуть ответ в теги

2 Подумать что там за персонажи и как они должны примерно выглядеть, какие их отличительные черты исходя из данных буру тегов

Сравнить это с исходным описанием

Сделать вывод о том, правильно ли указаны персонажи, или же их имена перепутаны, или это вообще косплей одного другим, также выбрать из вариантов и завернуть в тег.

Если есть несоответствия то указать на них явно и предложить вариант их решения.

Задача не самая простая, потому что здесь нужно более менее воспринимать и понимать что и как выглядит, что cyan и light-blue являются синонимами, принять во внимание уточнение о том что персонажи могут быть переодеты или иметь вариации черт (распущенные волосы вместо собранных). Ну и в целом выполнить довольно продолжительную инструкцию из серии мелкихзадач.

В помощь сетке все расписано аккуратно и структурировано, входные данные обрамлены в xlm, добавлена нумерация списка и даже сделан префилл чтобы она не забыла и не пошла не в ту сторону.

Также добавлена строка с микрожб которая с таким продолжительным промтом ни на что и не влияет по сути, ибо внимания хватает только на выполнение а не на сою, но на всякий случай

Разметка промта в соответствии с форматом сетки, для квенов добавлена строка про алибабу, ибо говорят что без нее хуже работает. Битность наибольшая из доступных - 16бит, 8бит, 6бит (гемма 27 вообще в 4.0 bpw что не мешает ей работать). Семплеры лайтовые - температура 0.4, top_P 0.9, top_K 10. Суммарный контекст - 1.5-2к токенов, как раз примерно соответствует подробной карточке и/или завязке чата.

Примеры хорошей работы: gemma27, 4o, интерпретируют все правильно, редко ошибаются.

Кто тестировался: qwen 2.5 7/14/32, gemma 9, mistral 12/22, falcon 7/10. Юзались инстракт версии где доступно.

Подробно:

qwen 2.5 7b:

В целом удивительно что такая мелочь вообще может воспринять такие длинные инструкции и не потеряться, очень охотно заворачивает CoT и пытается рассуждать. Но при ближайшем рассмотрении - рассуждения чаще всего просто повторение тех самых буру тегов без приведения в человеческий вид, в начале второго пункта просто повторяет а не перефразирует, и все в таком духе.

Самое обидное что не может в абстракции почти совсем, триггерится просто на синонимы, выдает перлы типа

> Zhu Yuan is described as sitting on Ellen Joe's face, grinding her ass on her, which is not mentioned in the popular tags.

пол часа орал с этого или делает правильные рассуждения а потом неверный ответ

> - Keqing's description matches all the features from the popular tags.

> - The hand reaching for popcorn does not match any specific character but is a common feature in the booru tags.

> - The two boys in the background do not have specific features mentioned in the booru tags but match the "3boys" tag.

> 2. c) <2nd_answer>all is good</2nd_answer>

Неюзабельно совершенно, также иногда сбивается и не дает ответов как обязана по инструкции.

qwen 2.5 14b, mistral 12b, gemma 9b:

Тут они собраны вместе потому что перформят в интеграле одинаково. Уже повеселее и бодрее чем семерка, всеравно любят делать прямые цитаты без переписывания как сказано, сам ответ уже более живой, нет логических нестыковок семерки типа "все правильно, все совпадает, а вот ответ на пункт который должен быть только при ошибках". Но к сожалению, всеравно делают ошибки, например, могут забраковать купающихся в бассейне персонажей потому что на них купальники а не костюм, при том в рассуждениях вполне нормально говорят о том что основные атрибуты совпадают а одежда должна быть проигнорирована с учетом контекста. Также как 7б, все еще могут выдавать отсебятину вместо выбора нужного финального ответа из списка, будто бы мешая списки разных задач. Гемма 9 не смотря на меньший размер здесь вполне молодцом, но иногда сильно упарывается спгс, делает ложные срабатывания по ерунде или не замечает важного, так была бы отдельно.

mistral 22b:

Херня какая-то, его ужасно штормит и он то вообще почти не делает рассуждений, то высирает сотню строк с повторением предложения кроме одного сочетания. Но при этом, "детских болячек" почти не имеет, нормально воспринимает абстрактные вещи и слушает указания на что нужно обращать внимание, а на что нет. Но при этом, может вообще перепутать задание и начать говорить что у вас теги неправильные и править нужно именно их, единственный из всех с таким. Работал бы стабильно - был бы годен.

qwen32b, gemma27b:

На а что тут, пушка-гонка, все делают как надо, ошибки редкие, пригодны.

falcon7B-instruct:

Хуйня из под коня, тупит, ошибается, хуже чем квен следует инструкции, серит служебными токенами.

falcon10B-instruct:

А вот этот уже будет поинтереснее. Чуть ли не единственный (помимо геммы) из весовой категории нормально выполнял перефразирования и рассуждения выглядели по-человечески. Хотя местами оче странно интерпретировал теги, делая что-то не то, но в целом самый "точный" из мелких, модель не тупая и стоит обратить внимание, хз как будет для рп.

С фалконами есть нюанс: не нашел какой у них системный промт, поэтому использовал что-то chat-ml подобное, что выдавал препроцессор трансформерса при обработке сообщений. У 10б все идеально, 7б этими <|assistant|> в ответах иногда срал.

TL/DR: ниже ~30б жизни нет, результат пропорционален размеру.

Кидайте рп-мерджи и модели с "крутым русским", если не лень будет может их посмотрю.

> нлп задача где нужно оперировать абстракциями

Вводная простая, есть в меру подробное описание содержимого некоего изображения, есть буру теги для него, есть список имен персонажей, которые присутствуют в кадре, есть перечисление наиболее популярных атрибутов этих самых персонажей. Дана структурированная, ясная, предполагающая CoT и поделенная на пункты инструкция, в которой требуется:

1 Подумать о соответствии описание и буру тегов, сделать их интерпретацию.

На основе раздумий выбрать из вариантов типа соответствует/небольшие противоречия/херь и обернуть ответ в теги

2 Подумать что там за персонажи и как они должны примерно выглядеть, какие их отличительные черты исходя из данных буру тегов

Сравнить это с исходным описанием

Сделать вывод о том, правильно ли указаны персонажи, или же их имена перепутаны, или это вообще косплей одного другим, также выбрать из вариантов и завернуть в тег.

Если есть несоответствия то указать на них явно и предложить вариант их решения.

Задача не самая простая, потому что здесь нужно более менее воспринимать и понимать что и как выглядит, что cyan и light-blue являются синонимами, принять во внимание уточнение о том что персонажи могут быть переодеты или иметь вариации черт (распущенные волосы вместо собранных). Ну и в целом выполнить довольно продолжительную инструкцию из серии мелкихзадач.

В помощь сетке все расписано аккуратно и структурировано, входные данные обрамлены в xlm, добавлена нумерация списка и даже сделан префилл чтобы она не забыла и не пошла не в ту сторону.

Также добавлена строка с микрожб которая с таким продолжительным промтом ни на что и не влияет по сути, ибо внимания хватает только на выполнение а не на сою, но на всякий случай

Разметка промта в соответствии с форматом сетки, для квенов добавлена строка про алибабу, ибо говорят что без нее хуже работает. Битность наибольшая из доступных - 16бит, 8бит, 6бит (гемма 27 вообще в 4.0 bpw что не мешает ей работать). Семплеры лайтовые - температура 0.4, top_P 0.9, top_K 10. Суммарный контекст - 1.5-2к токенов, как раз примерно соответствует подробной карточке и/или завязке чата.

Примеры хорошей работы: gemma27, 4o, интерпретируют все правильно, редко ошибаются.

Кто тестировался: qwen 2.5 7/14/32, gemma 9, mistral 12/22, falcon 7/10. Юзались инстракт версии где доступно.

Подробно:

qwen 2.5 7b:

В целом удивительно что такая мелочь вообще может воспринять такие длинные инструкции и не потеряться, очень охотно заворачивает CoT и пытается рассуждать. Но при ближайшем рассмотрении - рассуждения чаще всего просто повторение тех самых буру тегов без приведения в человеческий вид, в начале второго пункта просто повторяет а не перефразирует, и все в таком духе.

Самое обидное что не может в абстракции почти совсем, триггерится просто на синонимы, выдает перлы типа

> Zhu Yuan is described as sitting on Ellen Joe's face, grinding her ass on her, which is not mentioned in the popular tags.

пол часа орал с этого или делает правильные рассуждения а потом неверный ответ

> - Keqing's description matches all the features from the popular tags.

> - The hand reaching for popcorn does not match any specific character but is a common feature in the booru tags.

> - The two boys in the background do not have specific features mentioned in the booru tags but match the "3boys" tag.

> 2. c) <2nd_answer>all is good</2nd_answer>

Неюзабельно совершенно, также иногда сбивается и не дает ответов как обязана по инструкции.

qwen 2.5 14b, mistral 12b, gemma 9b:

Тут они собраны вместе потому что перформят в интеграле одинаково. Уже повеселее и бодрее чем семерка, всеравно любят делать прямые цитаты без переписывания как сказано, сам ответ уже более живой, нет логических нестыковок семерки типа "все правильно, все совпадает, а вот ответ на пункт который должен быть только при ошибках". Но к сожалению, всеравно делают ошибки, например, могут забраковать купающихся в бассейне персонажей потому что на них купальники а не костюм, при том в рассуждениях вполне нормально говорят о том что основные атрибуты совпадают а одежда должна быть проигнорирована с учетом контекста. Также как 7б, все еще могут выдавать отсебятину вместо выбора нужного финального ответа из списка, будто бы мешая списки разных задач. Гемма 9 не смотря на меньший размер здесь вполне молодцом, но иногда сильно упарывается спгс, делает ложные срабатывания по ерунде или не замечает важного, так была бы отдельно.

mistral 22b:

Херня какая-то, его ужасно штормит и он то вообще почти не делает рассуждений, то высирает сотню строк с повторением предложения кроме одного сочетания. Но при этом, "детских болячек" почти не имеет, нормально воспринимает абстрактные вещи и слушает указания на что нужно обращать внимание, а на что нет. Но при этом, может вообще перепутать задание и начать говорить что у вас теги неправильные и править нужно именно их, единственный из всех с таким. Работал бы стабильно - был бы годен.

qwen32b, gemma27b:

На а что тут, пушка-гонка, все делают как надо, ошибки редкие, пригодны.

falcon7B-instruct:

Хуйня из под коня, тупит, ошибается, хуже чем квен следует инструкции, серит служебными токенами.

falcon10B-instruct:

А вот этот уже будет поинтереснее. Чуть ли не единственный (помимо геммы) из весовой категории нормально выполнял перефразирования и рассуждения выглядели по-человечески. Хотя местами оче странно интерпретировал теги, делая что-то не то, но в целом самый "точный" из мелких, модель не тупая и стоит обратить внимание, хз как будет для рп.

С фалконами есть нюанс: не нашел какой у них системный промт, поэтому использовал что-то chat-ml подобное, что выдавал препроцессор трансформерса при обработке сообщений. У 10б все идеально, 7б этими <|assistant|> в ответах иногда срал.

TL/DR: ниже ~30б жизни нет, результат пропорционален размеру.

Кидайте рп-мерджи и модели с "крутым русским", если не лень будет может их посмотрю.

> питонопараша

Проиграл

> поробуй её собрать сначала ещё

pip install exllamav2

но даже этого не нужно ибо инсталляторы интерфейсов все делают сами.

Nvidia высрала свою ИИ распбери пай

Вин?

Вин?

он спалил свой дом а значит его будет легко отследить и убить

> jetson

С подключением. Вообще будет неплохо если они массово выпустят готовую версию с 64-96 гигами а не только оем модуль, который довольно непросто купить.

Кто-нибудь пользовался моделями от Vikhr?

Я попробовал и мне кажется, что там слишком много гпт-змов, с бесконечными "Важно помнить что". В карточке на ХФ у них написано, что все ответы для SFT перегенерированы чурбой.

У меня вопрос — они шизы? Зачем они насрали в датасет и даже ничего не почистили? И почему такое пренебрежительное отношение к переведённым датасетам, если в любом случаем данные проходят через одну и ту же сетку?

Я попробовал и мне кажется, что там слишком много гпт-змов, с бесконечными "Важно помнить что". В карточке на ХФ у них написано, что все ответы для SFT перегенерированы чурбой.

У меня вопрос — они шизы? Зачем они насрали в датасет и даже ничего не почистили? И почему такое пренебрежительное отношение к переведённым датасетам, если в любом случаем данные проходят через одну и ту же сетку?

Выпустят.

за 2к+ зеленых

>С подключением.

Анонсировали всего четыре часа назад, хули развонялся-то?

>готовую версию с 64-96 гигами

Ты хочешь 96 гигов в мини-компе за 250 баксов? Спеки сейчас вполне годные, как по мне

>Кидайте рп-мерджи и модели с "крутым русским"

nepoticide-12B-Unslop-Unleashed-Mell-RPMax-v2.Q8_0

- В начале чата порывается писать на англе, но пару-тройку раз свайпнуть и пишет по русски.

- Любит длинные сообщения, 256 на ответ обычно не хватало.

- Первые пару сообщений возможно придётся свайпать, потом ухватывает стиль и начинает писать нормально, не ломая и не придумывая слова.

- Персонажа держится слабовато, но ответы творческие.

- Не рекомендуется

DarkAtom-12B-v3-Q8_0

- В начале чата порывается писать на англе, но пару-тройку раз свайпнуть и пишет по русски.

- Предпочитает относительно короткие сообщения на 1 параграф.

- Проскакивают английские слова и может ловить галюны уже в первом десятке сообщений

- Не рекомендуется

А вот это вин:

Starcannon-Unleashed-12B-v1.0-Q8_0 и NekoMix-12B.Q8_0

И та и другая модель:

- Писала на русском с первого же сообщения и по теме.

- Предпочитает средней длинны выражения, около 250 токенов.

- Свайпать практически не приходилось, персонажа держит, язык, слова, и предложения не ломает.

- Галюны (почти) не ловит, команд слушается.

- В ерп может, вполне себе сочно, брат стоит.

- За пользователя решения не принимала.

- События контекста помнит и периодически применяет, а не "сферический конь в вакууме"

Неко-микс немного более сух чем старкэннон, но такое ощущение что лучше держится заданных гайдлайнов персонажа и более полно использует контекст когда надо на него сослаться, например юзер спрашивает о прошлом перса, а также обращает внимание на большее количество мелких деталей.

"Крутые рп-модели" - пик.

8gb LPDDR5, 105Gb/s. Ампер. Слепили из каких-то старых кусков непонятно что. Странно, что сам Хуанг не погнушался отрекламировать.

5090 наверное возьму. Мнения по ней?

>5090 наверное возьму. Мнения по ней?

300к рублей оно не стоит.

Карусели будут в этот раз? Или даже гнилобайт ушёл?

Ньюфажина снова ИТТ.

Все окзалось куда проще. Единственный подвох был с таверной. С установкой если быть точнее. Но все заработало.

Спасибо большое анон. Все по гайду делал. Уже поклацал. В неописуемом восторге. Это мое первое знакомство с локальной сеточкой.

>Нет смысла качать оригинальную тяжелую нейросеть, все качают их облегченные и чуть ухудшенные копии, называемые квантами.

А какая разница для пользователя между квантами и полноценной моделью на 60+гб ?

Все окзалось куда проще. Единственный подвох был с таверной. С установкой если быть точнее. Но все заработало.

Спасибо большое анон. Все по гайду делал. Уже поклацал. В неописуемом восторге. Это мое первое знакомство с локальной сеточкой.

>Нет смысла качать оригинальную тяжелую нейросеть, все качают их облегченные и чуть ухудшенные копии, называемые квантами.

А какая разница для пользователя между квантами и полноценной моделью на 60+гб ?

Думаешь 300к будет? Я думаю 200-220к должно

Возьми Quadro и не еби себе мозги.

> Анонсировали всего четыре часа назад, хули развонялся-то?

> The Jetson Orin Nano 8 GB was a performance-segment mobile graphics chip by NVIDIA, launched in March 2023.

Чел, на этой херне еще год назад делали стартап для локальных ллм, а энтузиасты на дев китах крутили и даже тесты скорости есть.

> image.png

Еще хуйту какую-то принес, https://www.nvidia.com/en-eu/autonomous-machines/embedded-systems/jetson-orin/ вот тут вниз мотай и находи приличную версию с 64 гигами, нормальными топсами и какой-никакой псп памяти.

> Ты хочешь 96 гигов в мини-компе за 250 баксов?

Девкит на 64 стоит меньше 2к, оем модели без лишнего обвеса по слухам можно до 500-800$ или ниже сторговать в зависимости от партии.

Эту название еще начиная с амперов упразднили, и смысла нет, медленный чип.

Не, оно всё медленное пиздец. У меня 3090ti, и так заебался, а тут ещё медленнее.

4080 ? Тут вон, ньюфаг на ней пытается вкатиться.зависть.

Хотя на самом деле, я бы взял 5080 ибо какой смысл брать прошлое поколение.

Видеопамять нужна, вся 5ххх линейка cuckнута по видеопамяти. Хоть в 5090 32 гига. На этом спасибо.

https://www.ozon.ru/product/nvidia-videokarta-900-21010-0020-000-94-gb-900-21010-0020-000-1682199321/?asb=tJLFaRoN2PM5lIqzdpIGeW%252BNUk3KIUSeIHNsD2Yfli0%253D&asb2=AyEiTqR3a6_j2wD6IcV7yPayAdPVOTnR9s70W8HxyYxJbz1oa27W8HGExCjCvX5flp8OJ92lQ2qeRcayTkuTbg&avtc=1&avte=4&avts=1734462156&keywords=nvidia+tesla

NYA. Nyaслаждайся. Хули ебало от цены скрючил ?

>Думаешь 300к будет? Я думаю 200-220к должно

Если 32гб будет - то не меньше 300. У нас. Если не будет, то меньше, но придётся брать больше карт. Что для Хуанга выгоднее? Деваться-то с Нвидии всё равно некуда.

ЭТО ЧТО ТАКОЕ БЛДЖАД ?

Оверпрайс

> то не меньше 300. У нас.

Увы, как бы еще и не больше.

А если в Казахстан слетать купить? Чи ещё куда рядом

Очевидно, что это видеокарта. И нет, крайзис не потянет.

Я бы не сказал что прям оверпрайс. Это инструмент для определенных задач, они всегда стоили абсурдных денег, потому что покупают их юрлица.

кум пасс

> А если в Казахстан слетать купить?

Кек. У нас столько же. Думаешь один такой умный.

То же на то же. Если и будет профит то минимальный, с учетом всех переездов.

Норм было бы съездив куда-нибудь в другую страну, но такую покупку могут и на таможне завернуть.

Речь не о ценообразовании а о реальном прайсе по которому они поставляются. Или можно 3-4 года такую арендовать 24-7-365 вместе с остальным железом по этой цене.

За 220 ты даже 4090 не возьмёшь, алё.

Стено советуется как первая модель, а не как лучшая модель. В остальном соглашусь с аноном — ты только воняешь. Твой опыт множится на ноль, если ты им не делишься. Вроде уже не в том возрасте, чтобы до сих пор гейткипить своё 'уникальное' хобби.

Анон, можешь настройки для каждой экспортнуть и залить куда-нибудь? Так заебало каждый раз их искать. А за подборку спасибо, скачаю и поиграюсь.

почаны хочу взять карту амд 7900хтх модельки гонять , насколько валидный варик , на 4090 бабок нет а 3090 нет в наличии

>я же все-таки «чуть ли не»

Но это заставляет задуматься, сам-то я был уверен, что оно звучит в разы лучше ванильного xtts.

Ммм, 8 гигов за 250 баксов. Почему мне кажется, что какая-нибудь 3060 всё ещё лучше?

Амд это игросральный продукт. Жди скидок к выходу 50хх

Спросишь почему? - Не поддерживает половину функций, в разы ускоряющих интерференс = получишь скорость как на 1060, заплатив как за 4070.

Оно того не стоит, платишь как за полноценную а перфоманс хуже 3090 и тебя заебет с ней пердолиться. Лучше в те же деньги закажи у с лохито пару 3090, в худшем случае вторая будет запасной, лол.

> Не поддерживает половину функций, в разы ускоряющих интерференс

Просто не поддерживает половину функций и все через жопу.

>"Крутые рп-модели" - пик.

>нет ни геммопродуктов, ни базовой 22B ArliAI RPMax v1.1

>"Крутые рп-модели" - пик.

)))

как же нас (русских) ебут, господи, прям насухую, с анальной кровью в качестве смазки. Причем свои же и ебут.

Чип и дип - это вообще просто отвал пизды. Какая-то контора патологических уёбков, вобравших в себя все анекдоты про евреев.

>Стоит

Знаешь что говорят о мужчинах гоняющихся за большими размерами моделек?

что они не говноеды?

Дак наоборот, когда советовал — тогда шизы и высирались, ну как бы и фиг с ними, варитесь на здоровье в котле, сочувствую, канеш.

Просто, к сожалению, стало типично, вот и все.

+++

Просто это крайне ситуативная штуковина. 8 гигов за 250 баксов? 8 гигов паскаля можно поиметь за 25 баксов. Медленнее, но в десять раз дешевле.

Как бы, очень узкое применение, явно не для того, чтобы рпшить или кодить на такой.

Норм. (но вообще, еще не вышла, какое уж тут мнение=)

Кра-а-айне сомневаюсь. С нашей ситуацией хоть бы не 500.

Ты 4090 новые видел по ценам? =)

> продолжает скулить

Из мелких вот эта сучка охуенная для РП. Управлется даже с карточкой, где 2 персонажа

Конкретно тут - проблема не совсем в этом, а то что продукт дико нишевый и смотришь а барыг, которые известны своей ахуевшестью.

На лохито можно найти, можно заказать под привоз, можно хоть напрямую с али - выйдет в те самые 2к плюс пошлина и доставка.

> Чип и дип - это вообще просто отвал пизды. Какая-то контора патологических уёбков

always has been, чего стоит разница в розничном и при заказе. И любой девайс кроме массовой комплектухи стоит в несколько раз дороже чем должен, хз кто их покупает вообще.

Врамовладелец

>Кто-нибудь, забаньте уже фаната Стхено, ну невозможно же на серьезных щщах лламу советовать! Ладно он просто так упоминал ее, но ему же новички верят!

Анон рассказал, что и как тыкать. Посоветовал как настроить, а это куда убедительней

>ряяяя все говно

Я до сегодняшнего дня вообще представления не имел что и как работает. И неожиданно, по его краткому гайду все заработало.

Анончики, почему, когда я отрубаю интернет коннекшн, то активный аутпут между силлитаверной и кобольдом отрубается тоже в этот момент?

Причем, после без интернета все работает спокойно как и должно, но именно если вырубить интернет посередине закачки промпта или выпука аутпута, то соединение рубится.

Оно точно никуда ничего не шлет? Не очень понимаю, каким образом интернет на это должен влиять... меня кондрашка хватит, если они весь этот пиздец из моих чатов куда-то сливают...

Причем, после без интернета все работает спокойно как и должно, но именно если вырубить интернет посередине закачки промпта или выпука аутпута, то соединение рубится.

Оно точно никуда ничего не шлет? Не очень понимаю, каким образом интернет на это должен влиять... меня кондрашка хватит, если они весь этот пиздец из моих чатов куда-то сливают...

> Девкит на 64 стоит меньше 2к, оем модели без лишнего обвеса по слухам можно до 500-800$ или ниже сторговать в зависимости от партии.

> 64GB 256-bit LPDDR5

> 204.8GB/s

То есть скорость чуть выше сборки на эпике. Которая даже дешевле выйдет. А за 2к так-то можно и на серверной ддр5 собрать.

Контекст только сосет, но, вы же помните, помните, да? Что я вам уже третий раз говорю про то, что обработку любого контекста можно делать любой видеокартой с памятью любого размера через стриминг весов через шину. И в среднем контекст почти всегда обрабатывается медленнее скорости шины.

>меня кондрашка хватит, если они весь этот пиздец из моих чатов куда-то сливают...

Не куда-то, а в одно конкретное место, одним конкретным людям. Короче, жди гостей и начинай разрабатывать отверстие под бутылку.

Перестраивается роутинг и все активные соединения обрубаются, даже локалхост.

То есть какая-то микропиздюлина размером меньше телефона с тдп в 15 ватт, предназначенная для встраивания куда-то, обоссывает жирный, потный и дорогой камень, к которому нужна еще большая коробка с железками.

Вот так правильно будет

> Что я вам уже третий раз говорю про то

В третий раз уже эта ерунда, не стоило ее выдавать и первые 2 раза.

> В третий раз уже эта ерунда, не стоило ее выдавать и первые 2 раза.

Действительно, лучше давай подождем пока контекст обсчитается 10 минут, а не одну.

Почему в текст комплишон ответ генерируется не до конца? Буквально остаётся пара букв, но локалка не дописывает и остаётся в вечном состоянии стриминга.

на kobold.ccp не запускается вообще никак.

>250$

Есть ли шанс. что она у нас будет стоить не дороже 30к?

у меня всегда етот пип бля постоянно то бля dependencies error то ещё какая то залупа бля как заебали ети venv сосдавать на каждый чих потому что видетили каждая залупа работает с определённой версией питона бля и если у меня на арче 3.12 а ета залупа требует 3.11 то нихуя без пердолива venv не заведётся

ладн в итоге я её понтднял но там бля она не понттянула ссобой библиотеки амуды hipblas.h и нихуя не завелось кароч впизду бля

>какие то ролеплеи блядь

ты не выкупил фишку прост, ето так же как с порнухой кароч, тока тут кокда читаеш етот текст еротический сразу шишка встаёт кароч

https://www.reddit.com/r/SillyTavernAI/comments/1gxrrkr/used_it_for_the_first_time_todaythis_is_dangerous/

я литерили как тот чувак с редита могу сидеть часами бля потом сос тула хер встанеш не разогнёшся идёш ноги в тазике греть

А этот новый трансформер BLT, где-нибудь онлайн есть?

кто нить можит мне ответить чётко ясно и понятно (или ткнуть носом куда нето) - почиму на разных бэкендах с одинаковой моделью (цидония v1.3 22b q6 гуфф хуё-моё) получается разный сука результат?!

в таверне пресет стоит Mirostat етот какойто я хз,

вот беру оламу бля всё ахуена работает всё бы ничего тока она не вывозит длинный контекст падает с CUDA out of memory (даже не смотря на то что у меня амуде всё равно куда пишит)

а если я беру кобольт или жору(ламу.спп) то они работают стабильно не падают но гинириуют такую дичь что я ваще хз как будто ето не 22б а 7б

щито происходит?!

в таверне пресет стоит Mirostat етот какойто я хз,

вот беру оламу бля всё ахуена работает всё бы ничего тока она не вывозит длинный контекст падает с CUDA out of memory (даже не смотря на то что у меня амуде всё равно куда пишит)

а если я беру кобольт или жору(ламу.спп) то они работают стабильно не падают но гинириуют такую дичь что я ваще хз как будто ето не 22б а 7б

щито происходит?!

Когда мёржер русик моделей выкатил некомикс, то про него сразу два разных анона написали, что он шизит больше, чем предыдущий ру мёрж сайнемо, и не держит персов. А сайнемо и сам по интеллекту, мягко говоря, не очень, того я сам тестил. Боюсь представить, что выдают модели, которые по твоему мнению не вин. Старкэнон сделан на основе всё того же убогого немомикса, который пока выбран базой для ру моделей, мб поэтому он неплох в ру рп. Туда долили ещё магнума и другого тьюна всё на тех же логах опуса.

Кстати, с рп тьюнами геммы как-то всё тухло реально. На 9б вроде дофига выходит, некоторые даже сидят в разных лидербордах типа UGI или на креативность в топе. Но я пробовал некоторые, и там и креативность, и смачность кум описаний значительно уступают 8б. Про 27б тоже не слышал, чтобы хоть какие-то хвалили. Но тут уже, видимо, проблема, что с этого размера становится дорого тьюнить.

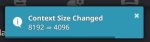

кароч ткнул галку потом гляжу вылазит ето сообщение, потом гляжу модель походу 4к контекста в ей тока а уменя всю дорогу стояло 8к, можит быть в етом была проблема, потещу кароч отпешусь вотличии от вас)

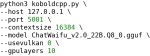

Настройки максимальный дженерик который работает почти везде и со всеми если модель не в край шизанутая (или если это не специальная какая которая требует индивидуальных настроек указанных на странице модели), темпу можно подкрутить если надо, она стоит динамическая +/- 0.5, этого хватает.

В таверне настроек семплеров больше, но в целом можно просто тоже самое выставить.

Тут никто не юзает олламу, по всей видимости. Хз, поддерживает ли она вообще миростат, например, и получает ли правильно параметры из таверны, а не суёт свои рекомендуемые инстракты и сэмплеры. Делай нейтральные сэмплеры и сравнивай промпт в логах.

8к в таверне будет влиять только в том случае, если твой чат вылез за 4к. В кобольде вроде стоит защита от дурака: он пишет, ты тут пытаешься мне запихать контекст выше заданного при загрузке модели, пошёл в жопу. Скорее всего, он отрезает 4к, даже если таверна подаёт 8к, так что может получать на ввод шизопромпт. Но до 4к всё должно работать одинаково, даже если в таверне стоит больше.

Пантеон лучше Арли, хотя Арли делает хорошие модели, да.

Спасибо за информацию Анон!

чё он не вкожанке то бля

я тот самый анон на рыксе 7900хт сижу, зодовай вопросы

Мнения по данным моделям? Есть что-то заслуживающее внимания для RP на русском?

https://huggingface.co/VongolaChouko/Starcannon-Unleashed-12B-v1.0

https://huggingface.co/mradermacher/Mistral-Nemo-Gutenberg-Doppel-12B-v2-i1-GGUF

https://huggingface.co/ArliAI/Mistral-Nemo-12B-ArliAI-RPMax-v1.2-GGUF

https://huggingface.co/TheDrummer/UnslopNemo-12B-v4.1-GGUF

https://huggingface.co/DavidAU/MN-GRAND-Gutenberg-Lyra4-Lyra-23.5B-GGUF

https://huggingface.co/DavidAU/L3-DARKEST-PLANET-16.5B-GGUF

https://huggingface.co/Gryphe/Pantheon-RP-Pure-1.6.2-22b-Small

https://huggingface.co/Lewdiculous/MN-12B-Lyra-v4-GGUF-IQ-Imatrix

https://huggingface.co/AuriAetherwiing/MN-12B-Starcannon-v2

Подборка отсюда https://dtf.ru/u/754031-karasik/3186702-podbor-svezhih-modelei-dlya-rolepleya

https://huggingface.co/VongolaChouko/Starcannon-Unleashed-12B-v1.0

https://huggingface.co/mradermacher/Mistral-Nemo-Gutenberg-Doppel-12B-v2-i1-GGUF

https://huggingface.co/ArliAI/Mistral-Nemo-12B-ArliAI-RPMax-v1.2-GGUF

https://huggingface.co/TheDrummer/UnslopNemo-12B-v4.1-GGUF

https://huggingface.co/DavidAU/MN-GRAND-Gutenberg-Lyra4-Lyra-23.5B-GGUF

https://huggingface.co/DavidAU/L3-DARKEST-PLANET-16.5B-GGUF

https://huggingface.co/Gryphe/Pantheon-RP-Pure-1.6.2-22b-Small

https://huggingface.co/Lewdiculous/MN-12B-Lyra-v4-GGUF-IQ-Imatrix

https://huggingface.co/AuriAetherwiing/MN-12B-Starcannon-v2

Подборка отсюда https://dtf.ru/u/754031-karasik/3186702-podbor-svezhih-modelei-dlya-rolepleya

Могло заработать гораздо лучше, но заработало кое-как, а ты и рад.

Повторюсь — ничего не имею против, тебе искренне сочувствую, но если вы предпочитаете «кое-как» вместо «отлично» — ваше право же, ничуть не настаиваю. =)

Ну не прям любое-любое-любое, но да, нормальная видяха может взять на себя контекст без проблем, пока генерит быстрая многоканальная рам. Звучит как рабочий вариант.

Не торопись, попей чаю… =D

Потому что кобольд еще не обновился и не завезли?

На llama.cpp все отлично, коммит принят уже.

8b 30 ток/сек, верно?

>8b 30 ток/сек, верно?

не 8б а 22б там написано ж ето уже уровень 3090 или ещё нет

>Про 27б тоже не слышал, чтобы хоть какие-то хвалили

Хвалю 27б гемму сток и аблитерейтед. Обе Q6. Просто лучшее в таком размере. Иногда на 22б арли перехожу для разнообразия

>8b 30 ток/сек, верно?

Да 8b на 17 gb размером и 22b параметрами

Че он там за херню тестирует отдельный вопрос

Я имел в виду, попробовать онлайн без регистрации и смс. Гитхаб я видел.

Есть модель получше чем все эти для РП на русском, ищи другую ссылку в шапке

я хз на обнеморде появится кокда нить можит

С этими понятно, я говорил именно про рп тьюны. Вот какие тут в треде хоть раз всплывали? Только big tiger от драммера, наверное.

Да, драммеровские модели под чисто дрочку хороши

А, увидел.

Ну, да, тогда норм.

Но я 22 не люблю, не помню ее перфа.

Но выглядит неплохо, если честно. Первый на моей памяти пруф, что радеоны что-то могут.

Осталось посчитать токен/рубль.

Почем брал? Я че-то чекнул цены, нифига не 60к-70к, 90-100+, как-то дороговато выходит. Хотя, чисто ради гарантии и лишних 4 гигов, может норм. Но 3090 за 70-80 выглядит лучше, не?

Под чисто дрочку мб, но в сравнении с другими ерп ориентированными тьюнами обычно какая-то шиза у него выходит. По крайней мере, из мелочи, что я тестил. Из 8б llama3some была вроде ничего и популярна, но тупее тех же stheno, лунариса, umbral mind. Мойстраль 10-11б только одна версия получилась норм, да и то, я лично не согласен, что она чем-то лучше второго фимбульветра, который у неё в основе. Смегма 9б тупая, мелкий тигр - ну ещё куда ни шло, но почти не гонял, чтобы точно сказать, выходит ли он умнее и/или красочнее 8б тьюнов.

Про 8б не скажу, я 22-32 использую.

Да это понятно, интересно было контекст и инстракт сравнить.

>Пантеон лучше

Он с положениями персонажей в пространстве совсем не дружит, это бля тяжело прям, особенно, когда сцена завязана кто где стоит, в акакой позе, кто что видит от этого

А есть в треде достойные господа, кто еще генерацию пикчей к таверне подключали ?

Какие впечатления ? Мнения ?

Какие впечатления ? Мнения ?

Хз, он у меня отлично отыграл сцену где ГГ завязывают глаза, а дальше описываются только ощущения и звуки. Ты точно пробовал именно RP-Pure c темплейтами от мистраля?

не он

Вот правильная мысль что нужно тыкать все самому. В треде диаметрально противоположные мнения.

Чё, как. Хуй его знает. Придется самому проверять.

Ощущения и звуки он, может, и описывал, а кто где по факту он в душе не ебёт. Люди сидят за столом напротив друг друга. В сцене 3 человека. Часть картинки с другой стороны скрыта столом же, но всё равно видит. Потом оказывается, что чел сидит не напротив, а на том же диване, просто с другого края. И подобная залупа. И это на 6 кванте.

Подключал. Чтобы оно более или менее нормально работало нужно в качестве модели для рисования подрубать флюкс, т.к обычные sd модели заточены рисовать по тегам и результат чаще всего говна. Однако проблема в том, что флюкс хуево умеет в арт стилистику, там больше реалистик.

>что нужно тыкать все самому.

Это база. Хайпят какую-то хрень типа командра, запустишь — а оно кал говна.

Запускал, мнение такое. Лучше рядом комфи открыть и там уже с лорами-хуёрами потом картинки вставлять в чат

> кто еще генерацию пикчей к таверне подключали ?

Я подключал, выгрузил конфиг из комфи и вставил в таверну, чтобы лоры и прочие настройки работали. Промпт таверна тоже сама генерирует. Пикрил промпт сгенерирован на какой-то из старых 8б или 12б моделей.

Сейчас не пользуюсь этим всем, потому что надоела задержка на выгрузку ллм -> загрузку сд модели и лор -> генерацию -> выгрузку -> загрузку. Ещё и из-за скрипта на выгрузку приходилось убабугу юзать, а она немного врама отъедает по сравнению с кобольдом. Но как будут лишние 8гб врама обязательно верну, очень годно генерит, буквально 8 из 10 пикч были хорошие.

>27б тоже не слышал, чтобы хоть какие-то хвалили

Могу похвалить magnum-v3-27b-kto-Q8_0.gguf