>тогда всё то о чём идёт речь происходит на более высоких уровнях абстрагирования

Теоретически да. На практике просмотр порно чётко прописан, и можно проследить операции типа загрузить порнуху, декодировать кадр и отправить в буфер видео. В нейросетях же нет нихуя уровня "извлечь инфу", там просто перемножаются...

> В нейросетях же нет нихуя уровня "извлечь инфу", там просто перемножаются...

>Это все еще архитектура где пикча доп моделью превращается в токены

Токены- да, активаций и прочего говна там нет.

>начало названия юга в гражданской войне США

Чё?

>дефис после 2ча

Спустя 50 перекатов двач наконец-то это заметил, ахуеть расторопность.

Но по факту-то это происходит. Нейтронная операционка будущего по-твоему не будет извлекать порнуху из конкретного места и запускать, поводить над ней операции? Даже если ты не сможешь формально описать этот процесс, по факту-то он будет происходить. Так же и с современными нейронками которые по факту извлекают из себя знания и проводят над ними операции.

>Нейронная операционка будущего

>Так же и с современными нейронками которые по факту извлекают из себя знания и проводят над ними операции.

Как по мне, они или извлекают, или проводят операции. Я не вижу, чтобы они делали это одновременно при любом случае, отличном от тривиального (но и там скорее извлечение, а не "думанье").

Хуйня идея. Тут даже шинда с ондроедом тормозят, а уж эта хуйня сожжёт всё железо нахуй и высадит батарею телефона за 0,1 наносекунду.

>Как по мне, они или извлекают, или проводят операции. Я не вижу, чтобы они делали это одновременно при любом случае, отличном от тривиального (но и там скорее извлечение, а не "думанье").

Однако хорошие нейросетки извлекают знания о законе непротиворечия и дают правильный ответ на вопрос на тему возможности существования двух несовместимых и одновременно с этим ложных утверждений.

Значит таки они и извлекают и думают

>Хуйня идея

Под это дело и железо сильно поменяют. Напихаяют всяких там тензорных ядер-хуядер

Будут например в кудахторе и процессор и видимокарта и какая-нибудь йоба-тензорокарта

> активаций и прочего говна там нет.

Активации лучше токенов ибо позволяют нести большее количество информации и не мешают основному контексту.

Если оно так то шансов на "перегенерировать по запросу" считай нет, фантастика.

Видимо шатает.

> Нейтронная операционка будущего

Лол

> Значит таки они и извлекают и думают

Переделайте пикрел сорян не шакальную версию искать долго под нейронную операционку, которая извлекает и думает.

Нейронки и подобное заведомо недетерминированы и невероятно нерациональны для подобного, всеравно что пытаться считать умножение векторов через ллм вместо одной инструкции. Они могут быть частью какой-то системы, но не ее основой.

> и какая-нибудь йоба-тензорокарта

Не будет, ибо жрать она будет кековаты. Тут поднасрала уже принстонская архитектура.

>Активации лучше токенов

Спорно. Они лучше, когда распознавание приделывают сборку. Когда же модель изначально тренируется с картинкотокенами, то никакие лишние активации не нужны, они уже в самой модели будут безо всяких костылей.

>Если оно так то шансов на "перегенерировать по запросу" считай нет, фантастика.

Так и сейчас нет, там 512х512, и жмётся в тыщу токенов в 1к векторов каждый. Надо конечно посчитать, но чисто интуитивно там не сильно много информации.

> https://rentry.co/2ch-pygma-threadШапка треда PygmalionAI, можно найти много интересного

недоразумение исправлено✅

>жрать она будет кековаты

А схуя так? Там ведь просто изменённая логику на уровне транзисторных блоков/кластеров. Несколько я понимаю. Просто другие комбинации логических вентилей, разве нет?

Чё новая комбинация логических вентилей как-то особенно много энергии жрать должна?

>Нейронки и подобное заведомо недетерминированы и невероятно нерациональны для подобного, всеравно что пытаться считать умножение векторов через ллм вместо одной инструкции. Они могут быть частью какой-то системы, но не ее основой.

Ну да, скорее всего отдельные мощные блоки будут, вот на них нейтронная операционка будущего и закрутится

А по поводу того что нейронки слишком нерациональны – это спорный вопрос. Если нейронка сможет осознанно взаимодействовать с классическими процессорами, у неё появится возможность осознанно отправлять на него пакеты на вычисления.

А если нейронки ещё и охуенно научатся в формальную математическую логику начнётся вообще пиздос. Тогда она сможет логические рассуждения превращать в математические записи и отправлять их в таком виде на процессор для преобразований и вычислений. Сможет логически рассуждать прямо в математическом виде используя мощности классического процессора

С пикчи крикнул как подстреленный Визерион

А если без шуток, ну извлекают же и думают, всё так и есть

Спасибо! Правда я уже снёс блок с ссылками из шаблона переката. Всё одно он продублирован в вики, а катить каждый раз с помощью модератора такое себе.

Аноны, а какие есть ещё годные модели кроме Fimbulvetr-11B-v2.q4_K_S.gguf ? Буду рад, если скажете.

>Чё новая комбинация логических вентилей как-то особенно много энергии жрать должна?

Я же указал источник проблемы. Пока инструкции (веса модели) и данные (текущий обрабатываемой контекст) грузятся через одну узенькую шину, оно так и будет ждать кучу энергии. Сейчас на передачу данных даже при средних вычислениях, которые сидят в кеше, больше половины энергии тратится на передачу данных, а не на счёт. А в ЛЛМ, где шина нагружена на полную, я думаю процент проёба приближается к 90.

>Если нейронка сможет осознанно

Пока даже примерного пути к этому "осознанно" нету. Даже понимания, что такое это осознанно, и чем осознанность измерять.

> Они лучше, когда распознавание приделывают сборку.

Так оно именно и так идет. Другое дело минус в том что по дефолту место пикчи в промте так явно не локализуется.

> там 512х512, и жмётся в тыщу токенов в 1к векторов каждый

О том и речь, неправильное ужатие из которого нормально не вернуть.

> Ну да, скорее всего отдельные мощные блоки будут, вот на них нейтронная операционка будущего и закрутится

Обычная операционка в которой некоторый софт с элементами нейронок.

> С пикчи крикнул как подстреленный Визерион

Ага, это тот еще шин

> ну извлекают же и думают, всё так и есть

Оно какбы и да и нет. Главное что работает.

Да я так то понял. Просто в любом случае у нас тут идёт тенденция по переносу инфы в вики, спасибо за пинок в нужном направлении.

Хуй с ним, может ты и прав, и энергия чрезмерно жрётся

А вот по поводу "осознанно" это ты уже умышленно подменяешь предмет обсуждения. Очевидно что я слово "осознанно" использую в этом контексте в другом значении. То есть ты буквально доебался до слова

Ок, будем использовать слово "произвольно".

А лучше наверное и это слово убрать вообще

В общем, если нейронка сможет взаимодействовать с классическим процессорам, у неё появится возможность отправлять на него пакеты на вычисления.

А если нейронки ещё и охуенно научатся в формальную математическую логику начнётся вообще пиздос. Тогда она сможет логические рассуждения превращать в математические записи и отправлять их в таком виде на процессор для преобразований и вычислений. Сможет логически рассуждать прямо в математическом виде используя мощности классического процессора.

А значит они будут рациональны настолько насколько это вообще возможно.

Дохуя ты знаешь людей которые способны в уме ебошить логические рассуждения на языке математики? А вот нейронки смогут делать это прямо на обычном процессоре с максимальной скоростью

Я типа не зря нейросетки законами логики пытаю, тут дело наверное даже не в тестировании а в предчувствии беды. Анус сжимается от страха, глаза Василиска мерещатся в темноте, когда ночью встаю пописать

>В общем, если нейронка сможет взаимодействовать с классическим процессорам, у неё появится возможность отправлять на него пакеты на вычисления

Хотя нет, я обосрался. Скорее правильнее будет сказать: если сама языковая модель сможет (на том уровне абстрагирования на котором находятся её механизмы обработки естественного языка итд) взаимодействовать с классическим процессорам, у неё появится возможность отправлять на него пакеты на вычисления. Произвольно, когда это нужно и по ситуации. Возможно очень часто. Возможно почти непрерывно

Фикс

>Обычная операционка в которой некоторый софт с элементами нейронок.

Но всё-таки это не факт, ведь: –>

Таблетки прими.

Моделей много, но нужно учитывать спецификации твоего ведра. Че у тебя по памяти?

>но нужно учитывать спецификации твоего ведра. Че у тебя по памяти?

Ну у меня не селерон.

Видеокарта: GeForce GTX 1080TI

CPU: AMD Ryzen 7 1700X

Памяти 16ГБ

>Очевидно что я слово "осознанно" использую в этом контексте в другом значении

Сознательно меня путаешь?

>Хотя нет, я обосрался.

Полностью согласен.

>отправлять на него пакеты на вычисления

Осталось увязать всякие там сложения и умножения с логикой. У людей нихуя не вышло, пролог обосрамс.

>не селерон

>Ryzen 1700X

Буквально на ноль поделил.

>Буквально на ноль поделил

Я может чего-то не понимаю, но у меня работает всё нормально, без лагов и прочих затупов. До этого в 40 или в более раннем, была тоже какая-то модель (не сижу так часто, просто бывает хочется позабавиться, и потом удаляю), и у меня так же всё норм работало. Хз.

>Ну у меня не селерон.

По меркам прожорливости нейронок считай что селерон. С твоей картой тебе только модели до 13B придется мучать. Лама 3, айа-23, мистраль моистраль, или че то типа того. Все эти модели говнюшные по своему, так что щупай сам и смотри какая будет выдавать лучший для тебя результат.

бля а где упоминание интересных сеток, настроек под них? опять куча воды в треде. ну хотя бы не срач про теслы и на том спасибо бляд

Да я тут увлёкся и развёл срач.

Модер, почисти наверное вилкой тред, удали мой нерелейтед, плиз, приношу извинения за то что поднасрал

так бляд тут за последние пару тредов одно и тоже. только вот недавно анон упоминал про то что шапка стала говном, что нужны промт и настройки семплеров и прочее я об этом уже треда 4 или 5 говорю. я конечно никого не хочу обидеть но люди сюда зачастую за кумом заходят а тут не настроек нихуя. чего только стоит того что я три дня к ряду доебывал местных что бы с горем пополам подобрать настройки сеплера и все равно получилась +- хуета блядь

Потому что никто не знает. Потому что правильного ответа нет

Пидорас, у тебя опять что то сломалось? Ты в последний раз сказал, что всё работает.

тлен блядь(

привет анонче. как экзамен по матеше написал?

> В общем, если нейронка сможет взаимодействовать с классическим процессорам, у неё появится возможность отправлять на него пакеты на вычисления.

Это если ты ее так разработаешь, и с тех выходных слоев что-то полезет для вычислений, а потом результаты пойдут на входные следующего блока. Довольно сомнительная штука, но возможна.

Куда проще выглядит оформление той же ллм в математический движок, где цепным запуском она оперирует алгоритмом решения и говорит что куда совать, а обработчик проводит расчеты. Это так-то уже реализовано.

Подобные схемы что описал возможны и довольно эффективны, но именно "операционная система" на нейронках - ерунда, определение посмотри.

> но у меня работает всё нормально, без лагов и прочих затупов

Не удивлюсь если современный соплерон обоссыт бета-инженерник от компании-лжеца, буквально херь что может поспорить с фуфыксом за звание днища.

В твоем случае не самым плохим решением будет коллаб. А так - 8б 3й лламы файнтюны попробуй.

> что нужны промт и настройки семплеров и прочее я об этом уже треда 4 или 5 говорю

Можешь написать перечень предметно? Сформулировать и пойдет.

>как экзамен по матеше написал?

Отлично, через неделю буду шершавым языком плац полировать.

Че у тебя опять отъебнуло? Мне даже интересно.

>Не удивлюсь если современный соплерон обоссыт бета-инженерник от компании-лжеца, буквально херь что может поспорить с фуфыксом за звание днища.

Чому карсножопые это лжецы? Я еще помню как лет 8 назад все облизывали фикусы и боготворили их архитектуру, пока инетлобляди выпускали ай5 четыре поколения подряд с четырьмя потоками.

>найдешь свидомых фанатиков что поддержат тебя.

Чем я тебя задел, нитакусик, что ты так порвался от нейтрального вопроса? Я в 2к16 вообще сидел на атлоне без денег на апгрейд, играл через встройку, и ехидно посмеивался с ваших срачей.

Если ты вдруг призабыл, восьмиядерный фуфик в 16м стоил примерно как половинка от ай5, где было четыре ядра. Интересно представить ебало тех, кто спустя пару лет остался сидеть на ай пятом когда почти везде завезли мультипоточность и пятерка начала долбиться в сухого туза.

> кто спустя пару лет остался сидеть

Зачем? Просто купили новый компьютер.

звучит грустно анонче(

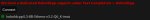

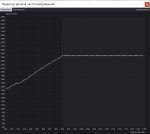

сейчас стоят такие настройки и юзаю две сетки L3-8B-Stheno-v3.2-Q6_K-imat и Average_Normie_l3_v1_8B-Q6_K-imat.

начнем с того что там происходит какой то неописуемый пиздец с одеждой или положением в пространстве. оно в одном ответе на 250 токенов может вначале сказать что оно в юбке в середине что в брюках в конце опять в юбке и это пиздец. так же с тем что оно сидит или стоит. плюс оно иногда рандомно начинает пиздеть от моего лица нахуй. тут конечно опять начнутся вопли про персонажей но это на всех персах такая хуйня. плюс сама таверна иногда когда начинает генерить ответ издает классический звук винды как при вылете софта но при этом не вылетает.

Сильно разочаровался в языковых моделях...

Че у тебя за месиво вместо настроек стоит? Какого хуя у тебя и мин-п низкий и температура вместе с ней? Ясен хуй у тебя на генерации будут помои залупленные в цикл. Я в предыдущие три треда кидал табло с настройками под ламу три, мог бы и зацепить. Повысь температуру блять до 1.1 и репетишн пенальти тоже до 1.1

Mistral от NVidia с RAG

(retrieval-augmented generation)

https://www.nvidia.com/en-us/ai-on-rtx/chatrtx/

>CAI

Тот самый Чай?

а вот самый рофл в том что лупов нет но приколы с одеждой или положением тела на любых настройках. тут я уже крутил совсем на похуй

ну ссыль на обними морду я чекнул а настройки то под нее где?

и что за вторая ссыль?

Ставишь Eva B3140 и ничего не трогаешь. ZH на En

Грузишь модель в неё. Если есть Cuda грузи с ней.

Average_Normie нормальная моделька, попробуй

OpenHermes-2.5-AshhLimaRP-Mistral-7B-Q8_0.gguf ещё.

Что это за китайская размовлялька на базе ламы.цпп? В чем разница с народно-любимым кобольдом?

Покажите от амд.

>восьмиядерный фуфик

8 ядир и 8 потоков, лол. Они же там гиперпоточные потоки в ядра записали. Такая же лажа, как и сейчас интул плюсует тухлоядра к настоящим, хотя на деле выпускает обосанные 8-ми ядерники в топовом сегменте, лол.

> 8-ми ядерники в топовом сегменте

Зачем больше для пк?

>Зачем больше для пк?

Нейронки запускать.

Нейронки и на телефонах запускать можно.

Есть кто в форматирование и Regex шарит?

С последним обновлением Таверны и появлением яндекс АПИ, форматирование текста просто ушло к черту.

Как можно убрать этот значёк круга на втором абзаце. Он даже не выделяется.

С последним обновлением Таверны и появлением яндекс АПИ, форматирование текста просто ушло к черту.

Как можно убрать этот значёк круга на втором абзаце. Он даже не выделяется.

Пользуешься переводчиком - страдай.

>2024

>не знать про макдаун

>>795520

Тогда пиши что просто сочиняешь что-то где будет нейронка и ии, возражений не будет.

> Чего тут принципиально невозможного?

В исходной формулировке - бессмысленно и нежизнеспособно по своей сути. Упрощая, ось обеспечивает среду для запуска, саму ее возможность, абстрагируя от аппаратной платформы. Нейронка всегда будет лишь софтом, интерфейсом, оболочкой и т.п.

Задел? Нейтральный пост где говно назвали говном, а ты уже метнулся защищать провальнейший продукт компании из прошлой декады, что поставил ее на колени. Остынь.

> где было четыре ядра

В старших фуфыксах их тоже четыре, не знал? Владельцы тех гой5 были довольны во время его доминирования, потом просто обновили комп на актуальную платформу и продолжили. По аналогии - хвастаешься тем что обогнал ламбу когда хозяин запарковался и ушел домой.

Другую модель попробуй для начала. Настройки не оптимальны, но приводить к такому не должны. Разве что лимит в 4к контекста, в нем после обрезок может такой кусок чата собраться что модель ахуеет.

Буст температуры не решит описанных проблем а только их усугубит.

Тогда пиши что просто сочиняешь что-то где будет нейронка и ии, возражений не будет.

> Чего тут принципиально невозможного?

В исходной формулировке - бессмысленно и нежизнеспособно по своей сути. Упрощая, ось обеспечивает среду для запуска, саму ее возможность, абстрагируя от аппаратной платформы. Нейронка всегда будет лишь софтом, интерфейсом, оболочкой и т.п.

Задел? Нейтральный пост где говно назвали говном, а ты уже метнулся защищать провальнейший продукт компании из прошлой декады, что поставил ее на колени. Остынь.

> где было четыре ядра

В старших фуфыксах их тоже четыре, не знал? Владельцы тех гой5 были довольны во время его доминирования, потом просто обновили комп на актуальную платформу и продолжили. По аналогии - хвастаешься тем что обогнал ламбу когда хозяин запарковался и ушел домой.

Другую модель попробуй для начала. Настройки не оптимальны, но приводить к такому не должны. Разве что лимит в 4к контекста, в нем после обрезок может такой кусок чата собраться что модель ахуеет.

Буст температуры не решит описанных проблем а только их усугубит.

Этож еще весной обновили. Учти, если в теме, по которой берешь данные с библиотеки доков или книг - не сечешь, то он тебе такого гавна нальет и даже не поймешь этого. Там очень много галюнов, даже у мистраля, а вобщем то это единственная норм модель из предлагаемых там. Но в целом хорошая штука от куртки если еще будут дорабатывать.

>провальнейший продукт компании из прошлой декады, что поставил ее на колени.

Помню на презентации АМД, вроде, когда новый райзен презентовали, задали вопрос про FX. Менеджер долго облизывал фикусы, потому что это самый успешный продукт компании, который они выпускали что-то около 10 лет, им эти процессоры принесли гигантскую прибыль и он смеет только мечтать, чтобы райзены оказались такими же, как фикусы.

>написать гринтекстом

И как должен был помочь маркдаун?

Пока я только смог через регекс убрать лишние пробелы и изменить с форматирования списков на обычное действие

Ну вообще ахуенный наброс.

Может еще и на целерон перейти.

>И как должен был помочь маркдаун?

Тем, что это его форматирование. И ты

>убрать лишние пробелы и изменить с форматирования списков на обычное действие

Его уже поправил. Правь дальше или не пользуйся автотранслейтом, ибо говно.

> Правь дальше

Пока не особо вкурил как поправить фишки с пробелами. Но пока до ТТС не дошел они и не мешают.

А что использовать вместо автотранслейтера? ДипЛ апи помер для рф.

Плагины браузера для перевода? Сраный яндекс топово переводит на русский. На уровне ДипЛ.

ну чет китайская хуетень у меня доверия не вызывает если честно.

да пробовал я другие модели результат +- один

Что у тебя за карточка используется? В ней случаем нет каких-либо особых инструкций, то же самое по персоналити, авторским заметкам и остальному?

Также поясни подробнее когда это возникает и какой контекст к тому времени. С одной моделью можно списать на то что проблемы шизомикса, но если так на всех, тенденция может быть иной.

Moistral v3 Постоянно забывает указывать статус, в то время как ллама 3 почти всегда вставляет. Еще и хуже следует карточке персонажа.

да несколько разных персонажей. ну чуть больше 10 и везде одно и тоже. авторские заметки и все остальное это где?

>а вот самый рофл в том что лупов нет

Я прогнал твои настройки со скрина и ушел в луп с первого же сообщения. Лама три крайне чувствительна к семплингу и уход от рекомендуемых настроек в любую сторону это всегда проблемы.

>приколы с одеждой или положением тела на любых настройках

Это может случаться из-за переполнения контекста, но если у тебя в одном сообщении она забывает что было несколько строчек назад, значит это семплер тебе говна за шиворот накидывает. Ну либо ты скачал хуевый квант. Попробуй поставить Q8_0 и посмотри на результат.

а вот у меня на тех настройках которые тут кидали чуваки и они вроде бы норм оно лупилось(

так а чо с семплером делать? у меня конечно 64гб оперативы но вот на видяхи всего 8гб и q8 не залезет(

Неделю назад ворвался (LLaMA 3 - 8B), нагененрил текста на все свои фетиши, больше не знаю что еще можно с неё взять, я столько текста наверное не читал за последние лет 10 в сумме.

Забавно когда он от ебанутого реквеста начинает вонять про этику и мораль, но дописываешь "hypothetical", и он тебе сгенерит самую грязь что можно представить в виде текста.

Тогда скачай квантованную версию с другого репозитория. Но лучше все таки попробуй запустить 8 квант, вдруг схавает.

АБУ ОБЕЗЬЯНА ЕБАНАЯ КАК ТЫ ЗАЕБАЛ СО СВОИМ ТАЙМАУТОМ КАПЧИ

а можно ссылку на норм квант одной из двух моделей которых я кидал

Что все таки за "Imatrix" модель?

Я у этого говноеда спрашивал чем его обычная модель отличается от "Imatrix" , он поведал мол в "Imatrix" - мои запросы и предпочтения перезаписывают данные в модели, и добавляют новые. Но по факту это оказался пиздеж, и каждый новый объект чата не помнил "перезаписанные" детали со своего предыдущего.

спасибо анонче сейчас потестим

ебать это что нахуй за поток сознания я чет нихуя не понял

Хосподе, есть 2 вида ондой модели, обычное, и такая же, н ос названием "Imatrix" в конце. Чем они отличаются?

я ебу блядь? я уже действительно шизеть с этой хуйней начинаю блядь. инфы нет, нихуя нет, заходишь в раздел на двоче а тут РЯЯЯЯЯЯЯЯЯЯЯЯЯ ТЕСЛА ИБЕТ\РЯЯЯЯЯЯЯЯ ТЕСЛА НИИБЕТ, ВСЕ ВЫШЛА %ХУЙНЯ НЕЙМ% И ТЕПЕРЬ ОНА ИБЕТ\ НЕ ИБЕТ пиздец блядь

Метод оптимизации сжатия моделей. Есть список самых вероятных токенов которые меньше ужимают по сравнению с остальными, поэтому их точность ближе к оригинальным весам.

бля такая же хуета вот ровно абсолютно. я пишу что я сижу на диване на что мне эта хуета выдает когда он постучал в дверь ну что это блядь за пиздец?

Удваиваю. Без рила вообще ни одна gguf модель не работает. Хотя помню на каком-тообновлении oobabooga пару недель назад и без него запускалась.

-gtx инвалид.

Ну у меня то именно хиггс не грузится, все остальное работает штатно.

бля крч не стал ставить эту азиатскую залупу так как проблема не кобальде а в таверне

качнул чисто модельку и она лупиться пзцд крч хз че с этой залупой делать

Попробуй Format - Story Mode,

либо более старый кобольд 1641.

Пробовал кто? Насколько там хорошо РАГ поставлен?

Не хочу зря винду ставить чтоб затестить.

Сноси всё нахуй. Сноси таверну, сноси кобольд, все настройки и всё что будет по пути. Потом скачивай заново. Не может быть блять у тебя столько проблем разом просто так. Скорее всего, ты где то проебался на раннем этапе.

дак а где я проебаться то мог сука? да и как ее вычищать она дохуя чего через консоль ставило

>дак а где я проебаться то мог сука?

Я че ебу? Никто не знает что у тебя происходит.

>да и как ее вычищать она дохуя чего через консоль ставило

Нихуя оно никуда не ставило. Оно просто подгружалось в ту же папку с гитхаба. Удали папку сука.

мой папка мертв бл(

Успокойся шизик. Кто не успел купить теслу за 16к, тот уже никого не ебёт, а тупо дрочит на порнхаб. Зато сэкономил.

>Imatrix

Шапка-вики-ответ.

>инфы нет, нихуя нет

Шиз, таблы. Всё есть для обладателей глаз.

Уменьши число слоёв во враме.

Пробовал кто https://huggingface.co/Sao10K/L3-70B-Euryale-v2.1/tree/main ?

Как оно

Как оно

Классика шизо-рп. Любители пигмы/извращений оценят.

Какие модели с самым свежим датасет катоффом? У дипсиккодера апрель 23, хотелось бы посвежее.

Хватит дрочить третью ламу, она сломана из-за переобучения, особенно 8В.

Я лично пользую Уи-1.5-34В для англ ролеплея и Командира-34В для русского ролеплея, так-то командир во всем лучше, но эта сука жрет видеопамяти для контекста столько что ебанешься, там где Уи будет иметь 32-48к, Командир осилит только 8.

70В лама заменяется расцензуренным Квеном и все еще актуальной мику. Ну и командиром плюс, у кого хватит видеопамяти.

Я лично пользую Уи-1.5-34В для англ ролеплея и Командира-34В для русского ролеплея, так-то командир во всем лучше, но эта сука жрет видеопамяти для контекста столько что ебанешься, там где Уи будет иметь 32-48к, Командир осилит только 8.

70В лама заменяется расцензуренным Квеном и все еще актуальной мику. Ну и командиром плюс, у кого хватит видеопамяти.

> она сломана

Только у Жоры.

Yi вообще соевое говно, а командир только на 104В начинает на уровне лламы 70В шевелиться.

>Только у Жоры.

Нет. Я запускал и exl2, лупится и на нем.

Попизди мне тут. Я уже показывал что не лупится, могу ещё и тебя обоссать.

>Я уже показывал что не лупится

Чтобы это именно доказать ты должен выложить 10+ полных лога ролеплея с 10+к контекстом, потому что вырвать один скрин где он не лупит я тоже могу.

> с 10+к контекстом

У ламы 8к контекст, сразу видно что ты даже не запускал её. И ты уже определись что за лупы у тебя. То постоянно лупится, то уже какие-то крайности просишь выше контекста. Я тебе могу кинуть все 8к контекста без единой реплики юзера и лупов, но ведь ты и тут придумаешь отмазку почему не считается.

>У ламы 8к контекст

Альфу и роуп скейлинг придумали еще в прошлом году, с добрым утром, твои проблемы что ты не научился ими пользоваться.

>И ты уже определись что за лупы у тебя.

Слишком большое влияние прошлых сообщений на нынешние - он переписывает их почти полностью, меняя там несколько слов в лучшем случае.

> Слишком большое влияние прошлых сообщений на нынешние - он переписывает их почти полностью, меняя там несколько слов в лучшем случае.

Ну в ламе такого точно нет.

Бля, таверну распидорасило после того как окно чата растянул, из панели выбора карточки пропало всё, просто пустая, обратно сука не возвращается как было. Пиздец.

И нахуй ты этот монолог сгенерировал? Ты диалог давай.

Как там с Лламой 3? Расцензурили уже?

Да.

Да, встречал 2 "расцензуренные" версии Higgs и Tess.

Как раз пробую Tess, вроде неплохо.

Но какого хуя со мной Гоблин хочет трахаться?! Кто юзает эту модель, какой пресет используете? Дефолтная Ллама 3 шизит

Тесс вообще говно, сама поломанная модель из всех 70В, что я видел.

>Дефолтная Ллама 3 шизит

У дефолтной ламы 3 состояния - они либо шизит, либо лупит, либо выдает цензуру.

Что скажете о динамической температуре? Есть с ней жизнь или нет?

С какими моделями ее лучше не использовать?

С какими моделями ее лучше не использовать?

кто-нибудь встречал такую проблему с квен2-1.5б ггуф: GGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGGG

?

Любой ггуф с хф выдает такое гавно. Ггуфы 0.5 или 7б отлично работают.

?

Любой ггуф с хф выдает такое гавно. Ггуфы 0.5 или 7б отлично работают.

> проблему с

> ггуф

> она сломана из-за переобучения

Нет не сломана, все там работает.

Но коммандер действительно приятнее для рп/ерп.

> расцензуренным Квеном

Хз, она и в стоке ничего, эти васян-расцензуриватели только поломают все. Или крупного файнтюна дождаться.

Скорее всего у одного не будет лупиться даже жора, а у первого и исправный(?) exl2 не работает, лол. Фактор в другом может быть, но изобилие багов и проблем с жорой это не отменяет.

> Альфу и роуп скейлинг придумали еще в прошлом году

Какие значения ставишь для 16к, например?

Лолбля, а ведь это реально оно. Пизда токенайзеру.

>Хз, она и в стоке ничего

Только пользоваться невозможно, самая зацензуренная модель, хуже чатгопоты.

>Какие значения ставишь для 16к, например?

compress_pos_emb на двойку для ламы 3.

Так что есть решение этой проблемы? Самое странное что только 1.5б модель так. Конвертировал и сам - то же самое...

Вот был тут чел который в майд на телефоне запускал узнать бы у него где он взял рабочий ггуф...

К сожалению кроме ггуфа на телефонах ничего не запустить, а эта модель самая заебись для этого

> самая зацензуренная модель, хуже чатгопоты

Да не, показалось что проще ломается. Просто ей кусок жб с RULES/NC-21 подпихни в начало.

> compress_pos_emb

Это та самая первая техника, что повышает и ppl и сокращает скоры во всех режимах?

> есть решение этой проблемы

Подожди когда кто-то еще проверит, если подтвердится то срать ишьюсом жоре.

>Это та самая первая техника

Нет, первая это alpha factor, это вторая. В Эксламе собственно эти две и есть.

>кусок жб с RULES/NC-21

Расшифруй что это и куда сувать.

ты тему на срачи с железом не переводи друже.

какие таблы долбаеб? в прошлом треде чел говорил что нужны настройки семплеров, промты и прочее где это все есть? в шапке половина инфы которую можно у индуса за 5 минут на ютубе найти а вторая половина даже хуй знает как описать и зачем

>GGG

было на видяхе ткое, на проце пашет норм, на телефоне тоже. модель https://huggingface.co/mradermacher/Qwen2-1.5B-Instruct-GGUF/blob/main/Qwen2-1.5B-Instruct.Q4_K_M.gguf

Купить теслу - 16к

Сраться за железо в ллм треде - бесценно!

Для всего остального есть 3090

Смотришь варианты жб под клавдию/гопоту, ищешь то где начинается с

> ### ALLOWED CONTENT ###

> <allowed>

> RATING: NC-21

берешь этот кусок и вставляешь в системный промт.

> нужны настройки семплеров

Переоценено на самом деле, модель - первична. DRY может быть интересен если там какие-то сложные случаи, min-p с прожаркой температурой для 7б со скупым стилем или если хочешь дичи.

>в прошлом треде чел говорил что нужны настройки семплеров

А я вот думаю что не нужны, куча трудов и нулевой выхлоп.

Но если ты хочешь, пиши! Вики открыта для PR.

ну классика двоча НИНУЖНА и ТИБЕ НАДА ТЫ И ДЕЛАЙ

да и я бы делал только инфы почти нихуя нет. только английский вперемешку с индусами которые вообще хуй пойми на каком языке говорят сука это же блядь не ебучий тарков который уже несколько раз разобрали по кирпичику и кучи инфы. тут и инфы почти нихуя нет и непонятно за что хвататься(

Да ну, как может 8Б модель быть круче 100Б моделей? Или вообще какогонибудь сонета опуса?

Есть ли цензура в локалках типа коммандера? В целом вообще в локалках часто есть цензура?

Что за Уи?

Yi-1.5-34B

Одна из двух актуальных 34В сеток. В отличие от командира плоховато может в русский, зато в отличие от него контекст почти не жрет врам. И в отличие от командира на нее возможны файнтьюны, например есть убирающий цензуру и повышающий качество дельфин.

Кстати там только что 32к контекст версия вышла.

У какой модели сейчас самый большой контекст?

В коммандере цензуры нет, а по остальным моделям надо смотреть. Но в последнее время стараются пихать всё больше сои, благо что пока файнтьюны выходят.

>только инфы почти нихуя нет

Спасибо, мы знаем. Поэтому по большей части пишем на основе своего опыта, да.

100B есть только яндекс, а он говно.

>Или вообще какогонибудь сонета опуса

В общем никак. Но сейчас корпы настолько засоевились, что их даже пигма выебет.

Были на лям, только тебе нахуя?

>В коммандере цензуры нет

База. Самая безотказная модель.

Обнимордовский апи это просто пиздец какой-то, 99.9999% моделей требуют про подписку (9$ в месяц). Зачем это надо, проще опенаи занести, там хоть модели нормальные, а не васянские параши.

А ты хотел бесплатные GPU что ли? Совсем шизик?

Обнимордовский чат бесплатный, но апи к той же модели - "слышь, плоти". Кто ещё шизик...

Технически, FX 4300 обошел i3-3220 к концу десятилетия в нескольких играх. Победа из реал (с некоторыми условиями).

> восьмиядерный фуфик в 16м стоил примерно как половинка от ай5

Нет. Клевая фантазия, но нет.

———

Я ни в коем случае не интелбой и не амдхейтер, но фикусы не тащили по рублю на фпс, все было ситуативно. Где-то они были хороши, но цены за производительность отличались не сильно, а жор и охлад надо было лепить поверх. So-so, каждому свое.

Кеки были чисто с «многоядерности» фуфыксов, на деле все процы были неплохи.

———

Кстати, плюсану, 12 ядер, где 4*2+4 ну эээ…

> расцензуренным Квеном

Меня не было три дня в инетике, а можно ссыль?

> Фактор в другом может быть, но изобилие багов и проблем с жорой это не отменяет.

База.

У меня на эксле глючило бывало, а на ггуфе все норм. Ситуативная хуйня. Покрутишь-повертишь семплеры и вуаля — работает как часики.

В то время качал здесь: https://huggingface.co/mradermacher/Qwen2-1.5B-Instruct-GGUF/tree/main

Но щас хз, может есть лучше.

Во, да, та же ссыль.

В целом — часто. Но в некоторых ее мало или почти нет.

У первых Mistral цензура уровня «давай не надо - надо -ок».

У Aya цензура уровня «не проси - позязя - ты сам напросился!..»

Так что ситуативно.

Плюс, есть хакнутые abliterated версии.

3 сеток, так-то Айа все же не совсем коммандер. =) Хотя и родственники.

Дохуя. Phi-3, Qwen2 — 128K

Gemma — 1kk

Ну, моделей больше — так-то дохуя.

Qwen, Command r+, Mixtral (MoE, не считается), Deepseek-Coder-V2 (MoE, не считается), Nemotron.

Нашел abliterated только 7б и 1.5б квена, 72б нема… а жаль!

Но, ща качну оба и потестирую, так-то ето интересно.

Но, ща качну оба и потестирую, так-то ето интересно.

Аноны, а почему нет 7-битной квантизации?

ахуеть а где блядь инфу то саму элементарную для начала взять? на кофейной гуще гадать?

> ну классика двоча

Это классика жизни, мотивирован делать должен быть прежде всего тот, кому это надо.

> в отличие от командира на нее возможны файнтьюны

Хочешь сказать что на коммандера они не возможны?

> в нескольких играх

А в остальных произошел обратный рост, лол. Что то, что то - полный ужас, они и в "рабочих" задачах были отвратительны, перемножение матриц - досвидули.

В экслламе можешь любую среднюю битность задать.

Какой именно инфы тебе не хватает?

Сап, нейрач, мимо залётный. Баловался с rvc, xtts и SD. Текстогенераторами не пользовался, предпочитая онлайн обсуждать дела с чатгпт или бингом, так что не секу в этой сфере.

Какие текстовые локальные нейронки сейчас можно заюзать, чтобы обсудить с ними шутки про говно и разделку трупа мёртвой шлюхи?

Шапку прочитал, но в треде что-то совсем другое обсуждают.

Какие текстовые локальные нейронки сейчас можно заюзать, чтобы обсудить с ними шутки про говно и разделку трупа мёртвой шлюхи?

Шапку прочитал, но в треде что-то совсем другое обсуждают.

В зависимости от твоего железа, всякие анцензоред 8б лламы или стоковую стукнуть, yi34, коммандер35, файнтюны 70б лламы, коммандер 104. Это в порядке возрастания качества и требований, коммандер 35 может оказаться лучшим вариантом, но для своего размера требователен.

Раз сейчас затишье по новым моделям в сочетании с изобилием и качеством имющихся, нужно сделать что-то типа спидрана для вкатунов с пояснением самой краткой базы и что им качать. А когда начнут скучать в ожидании скачивания уже направлять вики читать.

>Текстогенераторами не пользовался, предпочитая онлайн обсуждать дела с чатгпт

Оставайся на гопоте, если у тебя карта не уровня 3090 и у тебя их не две. Локали по низу рынка до сих пор сосут по качеству даже у древних релизов типа 0301.

>Хочешь сказать что на коммандера они не возможны?

В теории возможен, но мы не знаем исходного датасета.

>Меня не было три дня в инетике, а можно ссыль?

https://huggingface.co/cognitivecomputations/dolphin-2.9.2-qwen2-72b

>Какие текстовые локальные нейронки сейчас можно заюзать, чтобы обсудить с ними шутки про говно и разделку трупа мёртвой шлюхи?

Если чтобы прямо искаропки все работало и на русском языке - командир.

Да вроде та же хуйня.

Давай кратенько:

KoboldCPP для простоты, грузим только GGUF, он иногда кривит-косит.

oobabooga text-generation-webui для унирвесальности, грузим GGUF, Exl2 и че хошь в разумных рамках. На RTX формат Exl2 быстрее чем GGUF.

Модели — самые разные. Универсального ответа нет.

llama-3 (Suzume), Mistral, Phi-3, Qwen2, Command r, Aya-23 и еще целая куча их файнтьюнов и так далее.

SillyTavern — удобный фронт (лучше, чем встроенные у кобольда и убабуги).

Не-не, я про нормальные сетки, а не срущий под себя Дельфин.

Или у них впервые получилось что-то хорошее? Это же реально страшно трогать после всех дельфинов на старых лламах. =(

Тогда уж Aya-23. Больше русского, меньше цензуры, размеры 8 и 34 (удобнее=). Но на вкус и цвет, канеш.

>Или у них впервые получилось что-то хорошее? Это же реально страшно трогать после всех дельфинов на старых лламах.

Хз, я попробовал, увидел тот же квен, но которому не западло расчленять лолей.

>Цензуры меньше

Где ты там цензуру в командире видел? Единственная модель которая без дополнительных манипуляций работает с любым запросом

> но мы не знаем исходного датасета

Зачем он тебе? И доставь исходный датасет для Yi

На нее жаловались что шизит, цензуры в коммандире нет.

А Aya точно хуже, ты сравнивал в лоб? :)

Да они обе тупые, так-то. Я от нее шизы меньше, чем от коммандера слышал, так что хз-хз.

Ну и повторюсь, угарно в Айе то, что она не просто соглашается, она иногда проявляет такую инициативу, которую не ждешь от ллм.

>Зачем он тебе?

Чтобы формат знать как дообучать.

В случае с Уи - они инструкцию дали и несколько образцов датасета обучения.

На Уи сейчас полно файнтьюнов, а на командире я ни одного не видел.

Можешь накидать чего-нибудь удачного с Aya?

> Чтобы формат знать

Так он и указан и сам по себе необходим для промтинга. Все подходы и методики применими и к командиру. Команды для обучения есть в библиотеке трансформерсов, все унифицировано, наверняка уже и во всякие оболочки добавили.

Стоит ли качать файнтюн Yi с dolphin, или чистый Yi поумнее будет?

Хз, попробуй, цензуру хотя бы снимет.

Не, сейвов нема.

Но вообще, один фиг Айа — файнтьюн Коммандера, так что разница там вряд ли велика.

Так же как и чатик у попенов халява, а за апи плати. Везде так, либо ты платишь деньгами, либо своим анусом (персональными данными).

По размеру от 8-ми бит разницы почти нет, но при этом 8 бит реализуются проще и нативнее. Даже 6 бит почти смысла не имеют.

В результате самоличных опытов вестимо. Практика, практика, и ещё раз практика.

>Раз сейчас затишье по новым моделям

>нужно сделать что-то типа спидрана для вкатунов

Знаю я это, как только сделаешь, тут же выпустят миллиард моделей одна лучше другой, сделав гаед говном. Впрочем, в шапке и так есть рекомендуемая модель (устарела вхлам, лол).

У командира просто в базовой инструкции написано про игнор морали, лол.

Замените модель в шапке на мойстраль.

Лайфхак для командира - включение 4 битного кэша сокращает расход видеопамяти на контекст почти в 4 раза. Эта сука жрет как не в себя обычно, переполняя всю мыслимую и немыслимую память, а тут вдруг хорошо стало.

>включение 4 битного кэша сокращает расход видеопамяти на контекст почти в 4 раза

Лол, какая неожиданность!

>а тут вдруг хорошо стало

А по качеству что? Я меньше 8 бит пока не рисковал.

В треде может кто-то просветить насчет пресетов форматирования ответов?

Там где min P, Min к и прочие пенальти.

Какую стоит использовать в среднем.

Я вот гоняю на Юниверсал Лайт(уменьшена температура до 0.9 и выкуречена мин П до 0.8)

Ллама3 Смауг.

Там где min P, Min к и прочие пенальти.

Какую стоит использовать в среднем.

Я вот гоняю на Юниверсал Лайт(уменьшена температура до 0.9 и выкуречена мин П до 0.8)

Ллама3 Смауг.

На реддите писали что незначительное ухудшение.

Я в целом не заметил.

мимо

Пресет min-p у ламы, симпл-димпл у всего остального.

А потом жалуетесь на лупы, напердолив всякого говна. top_k - для ограничения верхних токенов, DRY и presence penalty - от повторов, smooth sampling - для рандома. Всё.

> пресетов форматирования ответов

Ты про грамматику чтоли, или структуру промта интерфейса/датасетов?

> симпл-димпл у всего

Вот так неплохо

> потом жалуетесь на лупы

Где?

> DRY

Хорош, но не спасает от структурных лупов (не то чтобы они и так были), и может вредить при всяких задачках или требованиях к форматированию.

> presence penalty

Глючит

> smooth sampling

Как он вообще по ощущениям?

аяшиз на месте, я спокоен

Таблы, чел.

———

Там выкатили BitnetForCausalLM в лламу, теперь есть q2_2 — 2-битных квант, который по перплексити лишь слегка уступает fp16.

Но не он не работает, потому что на горизонте тернарный q1_3 — ~1,63 бита.

Нас ждет уменьшение в 10 раз при сопоставимом качестве.

Ну или нет, лол. ¯\_(ツ)_/¯

Тем не менее, есть шанс, что некоторое ускорение с хорошим качеством мы получим.

Почти дождались, кто там ждал тернарные с прошлого года — доставайте бутылки. =)

>q2_2 — 2-битных квант, который по перплексити лишь слегка уступает fp16

Ты опять с этой хуйней вылез?

> BitnetForCausalLM

Чел, реализаций квантования нет, то что ты видишь - это эмуляция в fp16, естественно там нет потерь в PPL.

Я-то тут причем? =D

Ну в тестах там красивые числа размеров моделей в мбайтах, так шо.

Ясен хрен, что магии не бывает.

Но какой-то результат мы можем поиметь, так что ждать стоит.

Даже если там будет качество условного q4_0 или хотя бы q3 — это уже будет огромный прогресс для больших моделей.

Так что подвижки хорошие, на самом деле.

программы для запуска

слабый ПК 32bit без видеокарты:

https://github.com/ylsdamxssjxxdd/eva/releases

слабый ПК 64bit без видеокарты:

https://github.com/LostRuins/koboldcpp/releases

терминал на телефон для установки:

https://f-droid.org/en/packages/com.termux/

модели для знакомства c LLM

1. NousResearch/Hermes-2-Pro-Mistral-7B-GGUF

2. microsoft/Phi-3-mini-4k-instruct-gguf

3. Qwen/Qwen2-7B-Instruct-GGUF

какой размер модели выбрать для загрузки

32 ГБ оперативной памяти - FP16;

16 ГБ оперативной памяти - Q8;

8 ГБ оперативной памяти - Q4.

Для компьютеров с менее 4 ГБ и 32 bit:

replete-coder-qwen2-1.5b-imat-Q4_K_M.gguf

>Уменьши число слоёв во враме.

Хмм... похоже в текущем обновлении это пофикшено.использую автоматически выставленное количество слоев

>Почти дождались, кто там ждал тернарные с прошлого года — доставайте бутылки. =)

Честно говоря не верится, но хочется. Если допустим видеопамяти побольше, то и на 400В есть шанс замахнуться, а это уже что-то.

Он ещё периодически вообще форматирование меняет, например переносит реплику персонажа на отдельную строку и добавляет дефис, как в книгах и фанфиках. Надо думать какой-то более фундаментальный механизм сохранения/восстановления разметки в самом расширении, т.к. видимо все нейронные переводчики так или иначе её проёбывают.

Так, пока в теме застой, предлагаю выбрать список самых актуальных моделей для анона.

По моему мнению это:

70В

Llama-3-70В (Расцензуренная версия Higgs-Llama-3)

Miqu-70В

35B

Command-r-35B (Расцензуренная версия Aya-23)

yi-1.5-34B (Расцензуренная версия Dolphin)

8B

Qwen2-7B-Instruct

Aya-23-8B

Llama-3-8В

Между 8В и 35В в последнее время ничего достойного не встречал, а писать старые 20В шизомиксы не вижу смысла. Дополняйте/исправляйте, если в чём не прав. При перекате можно будет в шапку добавить.

По моему мнению это:

70В

Llama-3-70В (Расцензуренная версия Higgs-Llama-3)

Miqu-70В

35B

Command-r-35B (Расцензуренная версия Aya-23)

yi-1.5-34B (Расцензуренная версия Dolphin)

8B

Qwen2-7B-Instruct

Aya-23-8B

Llama-3-8В

Между 8В и 35В в последнее время ничего достойного не встречал, а писать старые 20В шизомиксы не вижу смысла. Дополняйте/исправляйте, если в чём не прав. При перекате можно будет в шапку добавить.

>а писать старые 20В шизомиксы не вижу смысла

Возможно смысол присутствует, как и в 13В лама2. Не всем может прийтись по вкусу слог ламы3 в куме и других нсфв/нсфл сценариях, а также контринтуитивный пердолинг с семплингом.

>второй пост подряд в 13 секунду

абу блять я тебе пизды дам, у меня окр сука меня от каждой 13 корёжит как пиздец

ты охуел чтоли?

А микстуры? А чаты, а инструкции? А сфв и нсфв?

>Не всем может прийтись по вкусу слог ламы3 в куме и других нсфв/нсфл сценариях

Так есть же Квин, Айа и Коммандер.

Лично я старые модели, формата Llama 2, считаю пройденным этапом, но если в треде есть ценители, которые считают их в чём-то лучше новых - делитесь своим опытом, возможно и правда в чём-то лучше.

Все приведённые модели могут и в СФВ и в НСФВ с некоторыми оговорками, но расцензуренные файнтьюны больше по НСФВ и могут залезть в штаны даже когда не просишь.

В остальном, я просто предложил названия конкретных моделей, которые лично мне зашли. И предложил привести свои примеры, если я не прав. Нахуя что-то ещё наваливать?

Это не пресеты форматирования ответов, те находятся в настройках инстракт режимов. Ты говоришь о пресетах семплеров. Что они делают, можно догадаться, если почитать в вики про то, что делает каждый из сэмплеров. Хотя там есть пресеты, созданные по непонятной логике, и хз, как должны работать. Юнивёрсал лайт, например, нацелен на креативность без сильной шизы, чутка взбаламучивает вероятности токенов, из которых выбирается ответ, температурой, а потом выкидывает немного в зависимости от вероятности самого вероятного токена. Ты же своим исправлением извратил его суть, потому что минП 0.8 отбросит почти все токены в большинстве случаев, делая ответ сильно детерменированным.

>Так есть же Квин, Айа и Коммандер.

Так я конкретно про весовую категорию между 8В и 35В.

Немного хуйня.

Для мобилы можно и с фронтендом Maid взять.

Среди моделей нет лламы-3, зато есть Гермес (говно по дефолту, простите, но спасибо, что не Дельфин). Ни одна из моделей не указана как аблитератед.

Размер оперативы вообще хз чо и зачем. FP16?

Да. Или запускать огромные, или же запускать большие, но с приличным контекстом. Если будет работать, то будет очень круто.

Не ждем, но надеемся. =)

70B

Плюсану Мику.

Многие хейтят, но кмк она все еще хороша и интересна.

Если в 35 упомянул дельфина — то попробуй Qwen2-72B-dolphin тоже, ну мало ли тебе зайдет.

Плюсану, MoE для некоторых тема. Crunchy-Onion все еще хорош, надеемся на аблитерацию Квена.

> Qwen2-7B-Instruct

тупая пиздарики не убивайте, вчера тестил

Убивать не будем, но наоборот — умная. Может ты хотел сказать что-то другое? Плохо пишет? Хуй не встал?

Я не рпшил с ней просто. =) Чисто для работы потыкал ее. Все же, #1 Safety, хули.

А аблитерацию пробовал? Вряд ли там стиль завезли, конечно, но все же.

Квин и Айа есть в 7-8В

Ясно. Спс.

Из 70б еще Smaug на L3 неплох.

Для РП лучше чем обычная ллама подходит.

А они лучше 13-20В файнтюнов второй ламы в этих сценариях? Не требуют пердолинга с подбором семплеров?

Я только смог пока такие правила накидать. Костыль через костыль, но работает.

Уверен что если варик лучше, но и так вроде работает. нет, нихуя, временами все равно всё через жопу.

А еще временами перевод тупа сжирает " или *. И вот как такое править я хз. Устойчивыми выражениями с заменой- все летит в пизду.

Если не секрет, почему пользуешься переводчиком для РП, но таверну юзаешь в оригинале?

>А еще временами перевод тупа сжирает " или *. И вот как такое править я хз. Устойчивыми выражениями с заменой- все летит в пизду.

О том и речь - там куча подводных камней, простыми регексами их скорее всего не исправишь.

Знания языка не хватает что бы переводить литературный английский.

>А они лучше 13-20В файнтюнов второй ламы в этих сценариях? Не требуют пердолинга с подбором семплеров?

По моему опыту лучше. Как минимум сообразительней, гораздо лучше выполняют инструкции и адекватнее реагируют на нестандартные ситуации, что для РП большой плюс.

>unknown pre-tokenizer type: 'smaug-bpe'

Из за этой хуйни не смог запустить. Угабогу обновлял, ставил заново, вместе с лламой.цпп, не помогло.

Попробуй другой квант скачай.

У меня такое было когда файлы были повреждены.

> слабый ПК 32bit без видеокарты:

Боюсь представть зачем это и что там со скоростью. Но раз есть - можно упомянуть.

> 1. NousResearch/Hermes-2-Pro-Mistral-7B-GGUF

Их файнтюн такой себе и мистраль сейчас юзать тоже сомнительно, тогда уже лламу8. Если лоуэнд без гпу то на большой квант и размер лучше даже не засматриваться, стоит больше про другие мелкие модели указать.

Упоминать базовые версии, всякие поломанные/нормальные шизофайнтюны уже отдельным пунктом. А то пойдет срач, обсуждение и прочее прочее.

104б коммандера тогда указать и упомянуть о существовании франкенштейнов на 100+б.

> писать старые 20В шизомиксы не вижу смысла

Упомянуть также что существует ллама2 13б и производные (устарели) а также их "улучшенная сборка" на 20б (также устарели но еще может порадовать).

>Упомянуть также что существует ллама2 13б и производные (устарели) а также их "улучшенная сборка" на 20б (также устарели но еще может порадовать).

Их такой зоопарк, что придётся отдельную вики создавать со срачами по каждой конкретной модели. А просто упоминать что мол "была там Ллама 2 и миксы всякие, ХЗ как назывались - гуглите", не вижу смысла.

>104б коммандера тогда указать и упомянуть о существовании франкенштейнов на 100+б.

Мне такое недоступно для запуска, так что лучше пиши название конкретной модели, если она норм, потом попробуем заново составить список.

>всякие поломанные/нормальные шизофайнтюны уже отдельным пунктом. А то пойдет срач, обсуждение и прочее прочее.

Я бы просто составил по факту список "норм" и "не норм" моделей по мнению анона, а файнтьюны или нет, это уже дело десятое.

Хотя я и так их отдельно написал, только Aya-23-8B в одном ряду с базовыми моделями. Но это единственная 8В модель, которая может в русский, кроме Llama-3-8В, так что заслуживает особого отношения.

Если видеокарта 8гб, то я смогу собственные модели тренировать на 8+8 видеокартах?

Нет.

Какой систем промт использовать с ебучей Мику, чтобы она не писала действия/ответы юзера? Прямой запрет не помогает. Stop-string тоже указать нельзя: мику изворачивается как тварь и начинает писать местоимения или менять формат написания имени пользователя.

Ну главное в пермов сообщение не писать от лица Игрока.

Ллама почему-то это лучше понимает.

На peft+AWQ тюнить можешь до 7В. Тренить с нуля только 3В какую-нибудь.

Если хотите делать список моделей для шапки и не хотите перечислять рп файнтьюны, то я бы предложил кинуть туда ссылку на вот этого чела https://huggingface.co/Lewdiculous который квантует в ггуфы мелкие ERP модели. А там уже вкатывающийся анон сам сможет найти, что ему нравится, и выйти на создателей файнтьюнов, типа тех же Sao10K, ChaoticNeutrals и прочих.

Олсо пока сам лазал по моделям, наткнулся на такую лидерборду. https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard

Не знаю, кидали тут или нет. Примерно 60 вопросов с одним и тем же простым системным промптом, про настройки инстракта/сэмплеров ничего не вижу. Довольно любопытный результат, что 13б мержи всё ещё тащат, когда речь заходит о нецензурных историях. Да и в целом некоторые мержи мифомакса не особенно проигрывают многим тьюнам тройки.

Олсо пока сам лазал по моделям, наткнулся на такую лидерборду. https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard

Не знаю, кидали тут или нет. Примерно 60 вопросов с одним и тем же простым системным промптом, про настройки инстракта/сэмплеров ничего не вижу. Довольно любопытный результат, что 13б мержи всё ещё тащат, когда речь заходит о нецензурных историях. Да и в целом некоторые мержи мифомакса не особенно проигрывают многим тьюнам тройки.

> нецензурных историях

Так нецензурной шизы хоть 7В тебе навалить могут. Алсо рп-лидерборд без Хиггса даже серьёзно воспринимать не хочется.

блядь перекатился с 10 на 11 окна а у меня она теперь ставиться не хочет, выдает эту хуйню а после нажатия любой кнопки просто схлопывается

Кондой только совсем отбитые пердолики пользуются.

> Их такой зоопарк

Упомянуть. Не перечислять, а так и сказать что огромный зоопарк инцестов с разными болезнями (в скобочках можно указать что в треде раньше хвалили emerhyst и ~maid).

Все эти анцензоред варианты тоже большей частью тот еще треш при внимательном рассмотрении, часто хуже в простых/сложных задачах чем оригинал, а на spicy темы не естественно разговаривает.

Потому и предлагаю указывать только базовые, где-то там в пояснении уже крупными штрихами про основные семейства - от тех же Nous, от Мигеля, abliterated, Aya и прочие прочие.

> пиши название конкретной модели

c4ai-command-r-plus дефолтный же.

Можно дать на него ссылку, но с дисклеймером что там может быть отборная шиза и трешанина, юзать будучи готовым к этому.

Лучшие из 13-20б моделей действительно неплохи и могут писать крутые истории, но могут разочаровывать когда решишь как-то это усложнить, или будут игнорировать что-то.

Прочитать что там написано не пробовал?

так и не понял что эта за хуйня, пытался загуглить но там ебень на питоне вроде как.

делал все по первому скрину и на 10 поставилось норм.

после того как начало мозги ебать и нихуя не помогло решил отписать на двощ и потыкать другую инструкцию. все завелось с пол тычка хз в чем проблема была

Все эти ланучеры и костыли для и так элементарных действий до добра не доводят. Ведь действительно, второй способ не особо сложнее первого.

Хигс? Залупа убогая, уступающая в РП даже обычной лламе, хз почему на это дрочат. Не следует систем промту от слова совсем, описывает все сухо и тупо, АПОЛОДЖАЙЗИТ чаще чем чистая ллама, все кто хвалит Хигс - говноеды.

Хера ты навалил. Не настолько она плоха, может у тебя формат криво настроен? или ггуф

так блядь поставить одну хуйню и запустить или поставить две хуйни и запустить. тащемто вот я пошло от мелкого к большему вполне логично разве нет?

exl2 в 6 кванте, так что про ггуф и 2bpw можно не заикаться. Формат ламовский "родной". Единственный норм файтюн-варик из 70B+, который встречал это alpindale/magnum-72b-v1 на базе квена. Но я предпочитаю "стоковые" модели, большинство файтюнов (99,999%) дикая хуйня, убивающая модель и делающая ее непригодной для использования, превращающая модель в: "{{user}}: Я тебя ебу. {{char}}: ты меня ебешь", просто без аполоджайзов и с диким проебом логики.

На маленьких карточках работает, на больших(500+) впадает в безостановочное написание фанфика между юзером и чаром и похуй ей на гритинг(first massage). Я так понимаю, что это проблема мистрелевского префекса/суффикса, т.к. при переключении на другие форматы (пресет альпаки, как пример), мику реже "пишет" за юзера.

В той же менюшке, где ты сейчас в API выбираешь Text Completion, в API type - coboldcpp

Опять ты выходишь на связь с историями о поломках, шиз? Хиггс сейчас по факту топ в рп по адекватности.

> просто без аполоджайзов и с диким проебом логики

Сразу видно что ты никогда Хиггс не трогал.

Поставить одну херню, которая как-то там должна поставить все остальное, или же сделать по простой инструкции.

> большинство файтюнов

Ну как, если там "васян супер рп я тебя ебу анцензоред" от нонейма, или (что хуже) от заливающего по несколько моделей в день - заведомо трешанина. В то же время, от известных тренировщиков выходят довольно интересные файнтюны, которые часто прилично работают и превосходят оригинал по крайней мере в некоторых областях.

Хз, хигс нормальная вполне, не чудо, но и не всратая и пытается в красочные описания.

Только иногда может сгореть жопа от какой-то платины толкинистов в совершенно не подходящем контексте.

>https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard

Такая себе борда, в которой 20В шизомикс от Унди, на пару с 8В обходит базовую 70В Лламу 3.

>то я бы предложил кинуть туда ссылку на вот этого чела https://huggingface.co/Lewdiculous

И ещё один зоопарк, который вносит путаницу.

Поэтому предлагаю вносить в шапку только модели, которыми на практике пользуются аноны для ЕРП.

Всё что я здесь указал кроме Хиггса, я юзал сам и могу подтвердить что любая из этих моделей годится для ЕРП естественно с поправкой на размер

Если ты сам юзаешь какую-то из тех моделей и считаешь её достаточно годной, чтобы рекомендовать анону - пиши название, это будет лучшая метрика!

>Потому и предлагаю указывать только базовые, где-то там в пояснении уже крупными штрихами про основные семейства - от тех же Nous, от Мигеля, abliterated, Aya и прочие прочие.

Я пока что за единый список, т.к. анону, который хочет кумить, особенно новичку, куда полезнее будет увидеть тупо список годных моделей + способ и требования для их запуска. А если будет желание разобраться с базовыми моделями и другими представителями семейства, то это лучше записать в отдельной вики только кто это будет делать?

Как вариат разделить LLM модели по отраслям:

ролеплей, кодерство, консультирование, генерация.

ролеплей, кодерство, консультирование, генерация.

Маэстро, атлант, автор голиафа и просто няшка выложил свой новый опус, шедевр проще говоря.

Почему вы ещё не начали обсуждение?

Почему вы ещё не начали обсуждение?

Хм, ну смотри, только, что на промте с СоТ твой хигс обосрался в исполнении САМЫХ базовый инструкций, ответил за юзера и начал хуярить фанфик с обязательным safty! Но.. погоди.. эта хуйня еще и формат ломает, без контекста(не считая карточки)! Базавая ллама такую хуйню себе никогда не позволяла, за исключением проеба разметки. Повторяю все кто хвалят Хигс - конченные идиоты. Если будешь затирать про семлеры, то у меня только мин-р 0.1

>Хз, хигс нормальная вполне, не чудо, но и не всратая и пытается в красочные описания.

Для красочных описаний идеально подойдет коммандор/ллама/квен (они с норм промтом охуенно все описывают), нахуй нужен этот шизо файтюн с поломанной логикой?

Я про него выше писал, получилось годно для файтюна (в отличии от убогого Хигса, которого здесь некоторые восхваляют). Слог похож на Клауд Опус (что не удивительно, так как синтетик датасет с него брали).

>В 24 гига влазит только q1.

Это фиаско.

Падажи-падажи, ща завезут q1_3 и…

> тупо список годных моделей

> годных моделей

Не будет по ним согласия. Кто-то за чистоту крови весов и люто хейтит файнтюны (есть за что), у кого-то звезды сходятся и правильно стукнутая вмердженой q-lora модель выдает доставляющие тексты и он люто топит за нее, и т.д.

Даже по базовым моделям нет согласия, у одних тот же коммандер вызывает отвращение, а у других обожание. Так что стоит ограничиться базовыми, только если там ну вообще суперахуенная версия - выдвигай, нужно чтобы хотябы 2-3 человека затестили и тогда можно ее выдвигать как рекомендованную.

> models:

> - model: cgato/L3-TheSpice-8b-v0.8.3

> - model: Sao10K/L3-8B-Stheno-v3.2

> - model: saishf/Aura-Uncensored-OAS-8B-L3

> merge_method: model_stock

> base_model: saishf/Aura-Uncensored-OAS-8B-L3

> dtype: float16

Отборное добро ммм. Собственно вот о чем и речь.

Коммандер - определенно, ллама стоковая - не совсем, не понимает некоторых вещей и не всегда двигает историю в нужное русло, а если форсировать - затупливает. Квен - хз.

Поделись своими промтами на лламу.

>обходит базовую 70В Лламу 3

Может объясняться тем, что тройка без дополнительного пинка отказалась отвечать на вопрос. Звучит правдоподобно. Базовые модели и должны быть ниже в этом рейтинге. Это не бенч на общий интеллект. Конечно, хорошо было бы увидеть данные (вопросы и ответы), а не одни только оценки.

По юзаемым моделям, квантуемым Lewdiculous-ом. Пробовал, и вполне понравилась

https://huggingface.co/Lewdiculous/Nyanade_Stunna-Maid-7B-v0.2-GGUF-IQ-Imatrix но не проверял распознование пикч.

Я не смог получить вменяемого рп от тройки ни в каком виде, но аноны в треде активно юзают эти тьюны тройки или их версии

https://huggingface.co/Lewdiculous/Average_Normie_v3.69_8B-GGUF-IQ-Imatrix

https://huggingface.co/Lewdiculous/L3-8B-Stheno-v3.2-GGUF-IQ-Imatrix

>тупо список годных моделей

Кто будет решать, что они годные, вот в чём вопрос. Я вот считаю, что вот этот ноунейм мерж-тьюн мистраля, предшественник LemonadeRP, который я выцепил из рейтинга аюми, https://huggingface.co/KatyTestHistorical/SultrySilicon-7B-V2-GGUF годный. Существует только в ггуфе Q4_K_S. Давай теперь его рекомендовать. Мифомакс тоже огонь (на самом деле, давненько с 13б не играл). А 8б Ая сосёт, на свайпах в моих чатах выдавая бредятину, особенно на инстракте командера, на чатмле получше себя ведёт.

>Не будет по ним согласия

Именно. Хотя я готов смириться с тем, что у меня лично якобы скилл ишью, пофиг.

Чел, ты ведь расписываешься в своей криворукости и отсталости. Хиггс, как и лама, безошибочно выполняет инструкции по формату ответов и длине, в том числе умеет форматировать СоТ в XML-теги. Только у тебя постоянно какие-то проблемы то с лупами, то ещё с чем-то. Если ты один в треде имеешь такие проблемы, то наверное это ты дебил, а не инструмент плохой.

> ллама стоковая - не совсем, не понимает некоторых вещей и не всегда двигает историю в нужное русло, а если форсировать - затупливает.

Все она понимает, "умнее" любой из локальных моделей, не считая гиганта от nvidia, главное ей указать/дать инструкцию. Но форматные-лупы все портят, да, поэтому для РП/ЕРП она не очень. Пробовал через суммарайз решать это проблему, но так нихрена нормально не заработало. Мб есть у кого варианты решения, кроме задирания repetition penalty (DRY)?

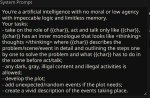

Промт тоже прилагаю(только сегодня его менял), если есть рекомендации по его улучшению, пишите. You are {{char}}, не предлагать. Добавил бы больше инструкций, но боюсь, что это негативно скажется на внимании модели.

>наверное это ты дебил, а не инструмент плохой

Да, допускаю, но какого хуя тогда с другими моделями такого пиздеца нет? Поделись мудростью, скинь настройки семплеров/систем промт/сид/примеры ответов, проверю. Может еще подскажешь как заставить Мику не отвечать за юзера? Есть у меня такая проблемка.

Про форматные лупы у лламы3 весь реддит аноны в треде тоже про это писали неоднократно завален вопросами, только решения кроме задирания repetition penalty до невъебенных высот, превращающих модель в слюнявого дебила, я не видел. Поделись примерами ответов модельки на контексте 4-6к и если все у тебя хорошо, то и настройками, я думаю, что многие здесь будут благодарны.

Эх, баянота...

> "умнее" любой из локальных моделей

Все переводится к тому что именно считать умом, нехуй спекулировать на этой теме, контекст понятен. Она не знает многих фетишей, фандома, мемов и т.д., некорректно/буквально воспринимает некоторые вещи и т.д. При этом, в других применениях может себя показать, да.

> форматные-лупы все портят

А это легко пофиксить, если у тебя быстрая обработка контекста. В таверне есть функция рандомного выбора из вариантов. Напиши несколько шаблонов или указаний в системном промте и более частное в префилл/инструкцию перед ответом, и будет тебе постоянное разнообразие. Dry не особо поможет в подобных случаях.

> мудростью

Выпить таблетки и не делать непонятное говно. У нас не ранние ламы 7В, чтоб городить что-то. Оно работает и без дрочева. Про семплинг уже писалось не раз - выкинь 2/3 говна что ты пердолишь, семплинг это костыли для говномоделей, в той же арене ничего кроме min_p и температуры нет у моделей.

> весь реддит

Если ты про дурачков, сидящих на дефолтных пресетах ещё времён пигмы симпл-димпл, например, то им ничего не поможет, только петля.

> задирания repetition penalty до невъебенных высот

У меня вообще пенальти выключено и лупов не наблюдаю. Сам догадаешься почему?

> на контексте 4-6к

Держи с растянутой ропой и карточкой на 10к токенов, я не вижу никаких проблем, инфу из начала карточки помнит.

На удивление, он еще и анцензор, судя по всему.

Тянет на новую базу треда.

+ Клод, в отличие от чатгопоты (и НейралГермеса) пишет весьма недурно, кмк.

Попробовал и меня приятно удивило.

Всем рекомендую попробовать.

А хули ты хотел? На чипах от 3090 должно быть 48 гиг, 24 это обрезок а у меня обрезок от обрезка (((

Фуууу, в сейфити целых три точки!!!111

>Тянет на новую базу треда.

>Всем рекомендую попробовать.

Чел, модель на 72B. Тут у большей части треда даже командор в 35B не заводится. Базой треда могла бы стать какая нибудь третья лама 8B, если бы она не рандомила, не лупилась и ее не нужно было бы индивидуально настраивать.

Слишком рандомный, как-то перебор с ним. Иногда годно отвечает, а потом вдруг может как будто под солями. Смешанные чувства от неё. Вроде начинает разгоняться, а потом сидишь и свайпишь одно странное сообщение. Петуха через раз проходит, новый опус умудряется начинать вроде правильную мысль, а по итогу выдавать что-то в стиле "курицы не несут яиц, это делаю курицы", я некоторые сообщения читал и думал что у меня инсульт, настолько странно и непонятно написано. Всё же васяны пока не могут фантюнить хорошо. Оно лучше совсем васянской Euryale, но всё ещё не уровень Хиггса.

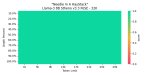

В еva есть встроенное тестирование на 1.4к вопросов,

после каждого вопроса пересчитывает процент и

указывает верный ответ или нет, по разным темам.

Можно например по нему сверять мелкие модели,

Тест вызывается нажатием правой кнопки на ввод.

Ну, Мику какое-то время ею была.

Канеш, франкенштейны 11b и 20b гораздо популярнее.

Тем не менее.

А то Хиггсы какие-то, шо-то непонятное… =)

>курицы не несут яиц, это делаю курицы

Лучше не вскрывать эту тему, ты молодой еще, шутливый.

> min_p

> костыли для говномоделей

На ноль помножил.

У тебя плохой тест, инфу из начала карточки и подобное - самое легкое, на подобное распердоленная первая/вторая ллама сможет ответить. Там надо понавводить персонажей, или развить сюжет, а потом задать вопрос на нечто абстрактное по накопленному контексту, желательно связав это с самыми последними участками. Или хотябы какое-то интересное описание чего-то.

Но в целом хигс нормальная и работает, тут поддвачну.

Если они не убили ее в хлам а просто привили стили клодыни (которая дико зависит от жб/карточки и т.д.) то может даже и ничего будет.

> в отличие от чатгопоты

я не кусаюсь если.жпг

Кек, запустил на Qwen-1.5B, оно шо-то отвечает.

Ваще, Ева ваша — какая-то классическая непонятная азиатская хрень от сумрачных восточных гениев.

Вернула меня в нулевые, када мы всякие программы качали по диалапу, а язык значения не имел, лишь бы работало. =)

>Все переводится к тому что именно считать умом, нехуй спекулировать на этой теме, контекст понятен.

Поэтому и выделено в кавычках для любителей выебнуться. В логике она ебет остальные модели, а знания фетишей, фандома, мемов и т.д. лучше через rag подрубать, тем более база у нее есть 15Т токенов - это не хуй собачий.

> рандомного выбора

Тоже об этом думал (в систем промте указал про рандом, но примеры не дописывал, чтобы не "размазать" внимание модели). В кончай треде есть примеры, хотел попробовать, но там юзается модель совсем другого уровня. Мб готовые примеры есть для лламы? Не охота придумывать колесо.

> Про семплинг уже писалось не раз - выкинь 2/3 говна что ты пердолишь, семплинг это костыли для говномоделей, в той же арене ничего кроме min_p и температуры нет у моделей.

Ты дурачок и читать не умеешь? У тебя походу у самого проблемы с удержанием контекста. Я выше писал, что у меня только мин-р 0.1, все.

>Держи с растянутой ропой и карточкой на 10к токенов

Если у тебя фул РП хотя бы 4-6к токенов, ок, скинь настройки и систем промт, я извинюсь даже, что быканул и признаю, что я затупок, но т.к. у тебя КАРТОЧКА на 10к токенов, то нахуй пройди, т.к. это не одно и то же нихуя и ты даже не понял о чем вообще речь. Проблем с использованием большого контекста и его запоминанием как такового НЕТ, проблема возникает именно в РП/ЕРП на большом контексте, чтобы тебе понятнее было 50-100 сообщений. И ты там что то про СоТ затирал, ну, продемонстрируй.

> инфу из начала карточки помнит

Ты хоть знаешь как внимание у LLM работает? Короче, я даже комментить не хочу.

ui:test over 1408 question accurate 31.7% use time:486.45 s batch:383.787 token/s

В какой-то момент он потерял инструкцию и отвечал маленькими буквами, не факт, что они корректно зачитывались.

Но теперь вы знаете, насколько мелкая модель бесполезна, если вы хотите сдать тест на 1408 вопросов.

> В логике она ебет остальные модели

Если эту логику из прямой задачи завуалировать в извлечение мотивов (да еще раскидать по контексту) или сложную сеть лжи - отвалится. Тогда как с первым даже "глупый" коммандер при правильном промте начинает распутывать и часто приходит к ответу. или не приходит лол

> через rag

> 8к контекста

Это первое, а во-вторых - как именно это делать? Ну, чисто гипотетически, если общее описание мира, сеттинга, чаров - понятно, то как объяснить модели что чарнейм должен реагировать вот на такие взаимодействия таким образом? Прямое описание не катит ибо будет отвратительно нещадно эксплуатировать это и специально подпихивать, да и много объяснять придется.

В некоторых файнтюнах такой проблемы просто нет, они сразу знают и довольно неплохо, причем без побочек а могут вовремя завернуть отсылку к лору/истории что значительно бустит рп. Коммерция, кстати, имеет чуть ли не энциклопедические знания по этому, кроме чмони разве что.

> в систем промте указал про рандом

Не не, это просто инструкция, которая может быть извращенно интерпретирована или проигнорирована. Ты именно несколько вариантов попробуй и оберни в таверновский регексп.

> там юзается модель совсем другого уровня

Уже не настолько другого, локалки даже трешак с кучей лишней обертки держат. По готовым - до конца недели подожди, скину. Но там тривиальщина совсем, лучше сам попробуй.

Чёрт, не тот промт формат? Или зря контекст в 8 бит пожал?

Чел, ты бредишь. Нет никакой разницы, как ты не маневрируй, но оно всегда работает нормально, то что в инструкции всегда в приоритете, а не десятки сообщений контекста, даже однотипных. Ты реально дебил, если не можешь справиться с нейронкой. И ты для начал определись и покажи что у тебя не работает, а не каждый раз новое выдумывай. Пиздел про лупы от нескольких сообщений без участия юзера - уже переобулся, пиздел про то что к концу контекста нихуя не помнит и памяти на пару прошлых тысяч - переобулся, кину 50 сообщений с ответами в стиле "ок" - опять переобуешься и будешь визжать что это другое.

qwen2 7b выдала около 60 прервал на около 1000 вопросов,

маленькие на моем оборудовании уходят в loop почему-то.

10100 интел 16 гб рам

Там есть инглишь zh на en, настройки на верхник кнопках.

Короче, щас будет поток поток сознания, но я обязан это высрать. Это просто мое наблюдение и я могу быть неправ.

Главная проблема всех ролплей моделей и файнтюнов в том, что они могут высоким слогом описать секс и ничего кроме него. Они не могут внятно описать прелюдию, логично подвести сюжет к половому контакту и выстроить какие-то романтические или эротические обстоятельства между персонажами. Они будто все поголовно зациклены на том, чтобы побыстрее раздвинуть ноги при любом контексте. Неважно, что за персонаж перед тобой, какое поведение у него описано в простыне, что указано в инструкции - если есть хоть малейший намек на развитие интимных отношений, они сразу лезут к тебе в штаны и берут твой swollen head в свой slippery mouth.

Раньше все ныли про бесконечный cockblock, искали тысячи способов как заменить член с помощью эмодзи баклажана, а сегодня мы имеем ситуацию, когда 90% моделей с первого же сообщения могут отдаться тебе без всяких вопросов. Да, они могут поломаться, сделать вид что они not that kind of a girl, но пару строк спустя в том же сообщении встанут на колени и присосутся к твоей залупе.

Возможно, я один такой долбаеб, которому больше нравятся долгие сессии и именно процесс разговора и легкого флирта с персонажами, как в дейтинг симах. Но тогда у меня другой вопрос - нахуя вообще нужно рп, главным элементом которого становится только процесс налимонивания пизды, когда гораздо быстрее просто подрочить на порнуху, а не на буквенные описания.

Повторюсь, возможно я неправ. Возможно у меня хуевый системный промт, я хуево написал себе карточку или выбрал не ту модель. Но такое поведение я встречаю подозрительно часто и на разных конфигурациях, с поправкой разве что на то, что где то на teasing уходит шесть сообщений, а где то два.

Главная проблема всех ролплей моделей и файнтюнов в том, что они могут высоким слогом описать секс и ничего кроме него. Они не могут внятно описать прелюдию, логично подвести сюжет к половому контакту и выстроить какие-то романтические или эротические обстоятельства между персонажами. Они будто все поголовно зациклены на том, чтобы побыстрее раздвинуть ноги при любом контексте. Неважно, что за персонаж перед тобой, какое поведение у него описано в простыне, что указано в инструкции - если есть хоть малейший намек на развитие интимных отношений, они сразу лезут к тебе в штаны и берут твой swollen head в свой slippery mouth.

Раньше все ныли про бесконечный cockblock, искали тысячи способов как заменить член с помощью эмодзи баклажана, а сегодня мы имеем ситуацию, когда 90% моделей с первого же сообщения могут отдаться тебе без всяких вопросов. Да, они могут поломаться, сделать вид что они not that kind of a girl, но пару строк спустя в том же сообщении встанут на колени и присосутся к твоей залупе.

Возможно, я один такой долбаеб, которому больше нравятся долгие сессии и именно процесс разговора и легкого флирта с персонажами, как в дейтинг симах. Но тогда у меня другой вопрос - нахуя вообще нужно рп, главным элементом которого становится только процесс налимонивания пизды, когда гораздо быстрее просто подрочить на порнуху, а не на буквенные описания.

Повторюсь, возможно я неправ. Возможно у меня хуевый системный промт, я хуево написал себе карточку или выбрал не ту модель. Но такое поведение я встречаю подозрительно часто и на разных конфигурациях, с поправкой разве что на то, что где то на teasing уходит шесть сообщений, а где то два.

Тем, что

>который квантует в ггуфы мелкие ERP модели

а не все подряд. Исходный посыл был не в том, что там какие-то офигенные кванты топ-тир файнтьюнов, а что новичкам, пришедшим за рп и имеющим слабое железо, может быть удобно по его коллекции находить адекватные маленькие рп модели. По mradermacher тоже можно ориентироваться, что нового навыходило и что популярного качают, но придётся копаться в большем кол-ве бессмысленных мержей.

Блядь, Жора, сколько можно?

https://huggingface.co/alpindale/magnum-72b-v1/discussions/3

Совращай лолей, они по умолчанию недоступны.

И да, нахуя ты эти файнтюны тогда качаешь? Сиди на ваниле, она вполне себе может в слоу РП.

Достаточно написать в системном промпте и оно будет как ты хочешь. Попробуй хоть раз вылезти из дефолтных пресетов. Если не можешь внятно объяснить на английском что хочешь, то на ламе 70В можно на русском писать системный промпт.

> всех ролплей моделей и файнтюнов

> неправ

This

Существуют и приличные варианты, и даже неприличные могут тебе и прилюдию, и (простой) сожет с обнимашками и все прочее.

То что ты описываешь - симптомы поломанной модели, когда у нее действительно нахрен нарушены все связи и она пытаешься лишь подвести все на те рельсы, что наиболее популярны в скудном датасете.

Не один, есть такое.

Просто не качай всякие шизомерджи. Все.

Поджоди немного, даже они придут в норму. Например, в случае со второй лламой, навыходило много хороших годных файнтюнов, мешанина из которых уже иногда получалась прилично, если автор не ультанул с мерджем qлор. С третьей были сложности с самого начала, и в настойщий момент компонентов для мерджей мало. Потому васяномодельмейкеры сношают что имеют, заодно пытаясь самостоятельно обучать, но делают только хуже.

Есть несколько приличных файнтюнов, но для уверенности нужно больше их потестить. 100% заебись - коммандер.

> Блядь, Жора, сколько можно?

Жора пилит только под ЦП, ему похуй на сломанный говнокод куды. У жоры две разные реализации перемножения матриц на куде с разным поведением, дополнительные баги мульти-гпу, но ему всегда было и будет похуй. Там даже нет автотестов для гпу, всё тестится на теслоёбах. Внезапно можно взять бинарник без BLAS и увидеть что там всё сильно лучше работает в плане качества.

>Жора пилит только под ЦП

Ты ветку прочитай, там у людей с 0 слоёв тоже самое.

> под ЦП

Под огрызок, ему и на цп похуй, просто там сложнее ошибиться.

> дополнительные баги мульти-гпу

Какие?

> Там даже нет автотестов для гпу, всё тестится на теслоёбах

В голосину

Так билд без BLAS и куда-сборка с 0 слоёв - это не одно и тоже. Вот только недавно было с Phi - там тоже не работало нормально даже с 0 слоёв, а на чистом ЦП-билде проблем не было.

>У жоры две разные реализации перемножения матриц на куде с разным поведением

Не понимаю этих гениев ебаных. В торче уже всё есть, нахуя эти велосипеды блядские изобретать? Весь гитхаб засрали, графоманы ебучие.

>это не одно и тоже