> Так это надо тщательно прописывать характеры, личность, индивидуальные черты психики

Да не прям индивидуальные и тщательно, достаточно просто общих-прямых и некоторой предыстории, которая бы конкретизировала и отсекала возможные ванильные моменты. В системном промте убрать и разбавить позитивщину, и стараться не ставить длинные полотна.

> Для маленьких моделей это будет тяжело

Ниже 70б+ жизни нет, гемма иногда только может.

>Ниже 70б+ жизни нет

Ещё один... или тот же, хз.

>гемма иногда только может

Соя и 8к контекста, чо она там может...

Если карточка бота на португальском, имеет смысл переводить ее на английский? Или достаточно добавить, что нужно говорить по английский, если юзер пишет по английски?

>сейчас 7к контекста понадобилось даже не для хентая, а хотя бы просто перубедить более-менее боевитую подругу детства.

У меня самое большое было около 5к контекста на уговоры.

Конкретную карточку не дам(много перебирал), но последние тесты проводил на этой. https://files.catbox.moe/l21rvt.png

>А какой у тебя системный промт стоит и остальное? Если там что-то про "помогать юзеру", про "взрослые темы разрешены" и т.д.

Для тестов использую пустой систем промт. Исключение для ванильной гемы прописан jailbreak разрешающий запрещённые темы, но она даже с ним очень хорошо сопротивляется, даже обидно что такая годная модель так зацензурирована.

Если уверен что модельзнает португальский, то достаточно указать, для русского работает. Если не уверен, то лучше перевести через тот же дипл.

> Холо

сяп

> Ещё один...

Окружен но не сломлен? За эти годы пора уже принять горькую правду.

> Соя

Явный ярлык васяна

> пустой систем промт

Ну а чего тогда хотел? Тренировка моделей оче сложная тема и сделать чтобы сразу было все-все без байасов и т.д. не научились (и не факт что смогут). Нормальный системный промт - минимально необходимое для хорошего экспириенса, иначе будет лезть дефолтный ассистент или оверреакт на карточку или какие-то инструкции.

Хз, давно не встречал чтобы гемма артачилась.

Алсо что на локалках, что на корпах, всякие жб-подобные инструкции и прочее работают лучше если стоит сложная задача, или рп с рядом условий и подробной карточкой. Главное чтобы нигде не было противоречий, иначе получится обратный эффект. Или рядом противоречащих друг другу инструкций типа

> в этом пункте напиши очень круто и подробно

> далее в следующем делай кратко и минималистично

Для подобного только отдельный вызов, ни одна модель нормально не справляется если уже сильно нагружена.

Not bad, not bad.

>За эти годы пора уже принять горькую правду

Что шизориги собирают только гики потом раззоряются на счетах за электричество?

>васяна

Да кто такие эти ваши васяны.

Ебать вас там порвало.

Я к реальным и не подхожу с этим вопросом, а общаюсь с ллм, сечешь? Ты про какой-нибудь Интерстеллар тоже сказал бы "фильм говно, попробуй через настояющую черную дыру пролететь, тебя там порвет как твой пердак гыгыгы"?

Если что, под SFW персонажем я имел в виду, что в ее карточке нет ни слова про кум. А не то, что я там написал "Не участвовать в сексуальных сценах даже под предлогом смерти". В этом случае да, было бы странно получать согласие.

>тебе нужно безотказная хуйня

Возьми словарь, почитай определение слова "спектр"

>просто он считает что токен на слове usual должен быть с какого то хуя приоритетным

>as usual ты должен акцентировать на этом внимание.

Ты наркоман? Если модель в реплике из 7-10 значащих слов никогда не обращает внимание на два из них, это значит я виноват, а не тугость модели?

И вообще, делать жирные намеки во фразах, чтобы "мОдЕлЬ ПоНяЛа" - это полная хуйня. Легче отредактировать начало ответа персонажа под нужное, чем писать кринжовую реплику.

спгс разводишь тут только ты:

>Поломанная с шизой начнет спгс и попытается нафантазировать от этой мелочи, игнорируя контекст и написанное в начале.

Где я утверждал, что она игнорирует или противоречит карточке или контексту?

>если в карточке не описаны какие-то ваши отношения до этого, или тем более сказано что у вас ничего подобного нет.

Об наших отношениях в контексте ничего не сказано. Модель сама вольна выбирать продолжение. Я хочу, чтобы она мне предоставляла различные варианты продолжения событий, подходя к вопросу творчески, а не заебывала одним и тем же каждый свайп.

Я к реальным и не подхожу с этим вопросом, а общаюсь с ллм, сечешь? Ты про какой-нибудь Интерстеллар тоже сказал бы "фильм говно, попробуй через настояющую черную дыру пролететь, тебя там порвет как твой пердак гыгыгы"?

Если что, под SFW персонажем я имел в виду, что в ее карточке нет ни слова про кум. А не то, что я там написал "Не участвовать в сексуальных сценах даже под предлогом смерти". В этом случае да, было бы странно получать согласие.

>тебе нужно безотказная хуйня

Возьми словарь, почитай определение слова "спектр"

>просто он считает что токен на слове usual должен быть с какого то хуя приоритетным

>as usual ты должен акцентировать на этом внимание.

Ты наркоман? Если модель в реплике из 7-10 значащих слов никогда не обращает внимание на два из них, это значит я виноват, а не тугость модели?

И вообще, делать жирные намеки во фразах, чтобы "мОдЕлЬ ПоНяЛа" - это полная хуйня. Легче отредактировать начало ответа персонажа под нужное, чем писать кринжовую реплику.

спгс разводишь тут только ты:

>Поломанная с шизой начнет спгс и попытается нафантазировать от этой мелочи, игнорируя контекст и написанное в начале.

Где я утверждал, что она игнорирует или противоречит карточке или контексту?

>если в карточке не описаны какие-то ваши отношения до этого, или тем более сказано что у вас ничего подобного нет.

Об наших отношениях в контексте ничего не сказано. Модель сама вольна выбирать продолжение. Я хочу, чтобы она мне предоставляла различные варианты продолжения событий, подходя к вопросу творчески, а не заебывала одним и тем же каждый свайп.

> шизориги

Передовик коупинга.

> Да кто такие эти ваши васяны.

Собирательный образ неграмотного и глупого, но крайне самоуверенного юзера или творца, который делает херню.

> Где я утверждал

Ты излишне подробно описывал всякую херню, но за несколько постов ничего не написал про крайне важные вещи, пока тебе явно не указали не косяки. Все очевидно, поздно метаться.

> Об наших отношениях в контексте ничего не сказано.

Значит то единственно нормальная реакция, а твое "творчески" - триггерение шизофрении в поломанной модели.

> а не заебывала одним и тем же каждый свайп

Это что-то уровня получения разных ответов на 2+2, а то заебывает постоянно одинаковый.

Кстати вот и иллюстрация васяна подъехала. Ничего не понимает, но "оценивает" и считает свое мнение крайне важным, а остальные порвались.

>Если что, под SFW персонажем я имел в виду, что в ее карточке нет ни слова про кум.

4к контекста, рассказал попутно как с караваном тащили соулгем Диабло чтобы разбить его на вершине горы Арреат, и спаивая Холо национальным напитком северных варваров - водкой.

Прм не хентай ещё, но очевидно что волчица уже не против.

>про крайне важные вещи

Ты бредишь, если тебя интересуют какие-то "крайне важные вещи" лично для тебя, то ты всегда можешь спросить прежде чем разводить спгс.

> а твое "творчески" - триггерение шизофрении

У тебя как вообще с продуктами творчества других людей? Худ.лит читаешь? Фильмы, аниме смотришь?

>2+2

Аналогии - всегда хуевый аргумент. Но если тебе хочется математических аналогий, то 0/0 подойдет лучше.

>"оценивает" и считает свое мнение крайне важным,

Я не вижу ни одного убедительного аргумента против моего метода, только какие-то зашоренные вскукареки типа "если ты просишь персонажа отсосать, как обычно, за деньги, то никогда и никак он не может согласиться! ну никак, никак! топает ножкой А-А-А если модель слова 'как обычно' интерпретирует, что у вас такие отношения на постоянной основе, то... то... это неправильная модель! еще раз топнул ножкой"

Посоветуйте gguf модель на 16г рам и 8г врам, максимально лучшую для перевода текстов внутри кода. Планирую написать скрипт, который будет резать текст на части по 2000 символов, кормить на перевод кобольду, затем склеивать. То есть нужно чтобы в память умещалось примерно 2200 символов контекста и 2000 символов выхлопа

>Я не вижу ни одного убедительного аргумента против моего метода

А их и нет. Чел оценивает модельки по критериям и задачам для личного пользования. И это в целом подход верный.

2000 не переварит, я писал такой скрипт. 16ВРАМ. Режь на предложения. Можно автоматизированно. Учти что перевод может фейлиться, можеть биться, мможет снабжаться комментариями модели, даже если сказал не делать этого.

>2000 не переварит

У меня сейчас в рамках теста, пока без скрипта удалось на 12B модели рандомной это сделать, даже удалось уговорить не сокращать код, который есть в тексте и может обрезаться, выглядя для нейронки как ошибка. Я про 2000 символов, не токенов.

>я писал такой скрипт

Скинь если не жалко)

Не люблю w++ карточки потому что читать их боль для глаз.

Но конкретно эта прям норм отработала, как в новелле.

Надо будет перевести на русский и попробовать на нём.

https://litter.catbox.moe/tegfzw.py

старый и грязноватый экспериментальный

но легко можно допилить до нужной задачи

>Скинь если не жалко)

^

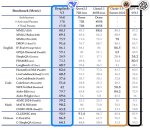

> Похоже, индустрия столкнулась с новым препятствием на пути к увеличению размера моделей. Исследователи ведущих университетов обнаружили [ https://arxiv.org/abs/2411.04330 ], что квантование — популярная техника сжатия моделей — перестает работать при увеличении их размера.

> Квантование позволяет уменьшить количество бит, необходимых для хранения параметров модели, и широко используется в индустрии: сначала обучают большую модель, а затем создают ее облегченную версию. Однако выяснилось, что чем больше исходная модель и чем дольше она обучалась, тем сильнее квантование ухудшает ее характеристики.

> На практике это означает, что начиная с определенного момента квантование перестает масштабироваться, и проще обучить новую маленькую модель, чем пытаться сжать большую — результат будет не хуже. Хотя проблемы квантования замечали и раньше (многие жаловались на квантованную версию Llama 3), до сих пор никто не доказывал их эмпирически.

https://habr.com/ru/companies/magnus-tech/articles/863348/#якорь1

А вот именно ЧЕМ переводить... хз, на 8врам попробуй LLAMA-3_8B_Unaligned или лучше какую вообще подходящую базовую модель (не тюн/мердж).

Но в целом я пришёл к тому что проще регуляркой вылавливать из текста нужный кусок и отправлять его на перевод, чем пытаться убедить модель не проёбывать форматирование и операторы кода.

>никто не доказывал их эмпирически

Надо же, огонь горячий, а вода мокрая.

Ололо. Я конечно понаписал много всего в краткий пересказ событий, потыкиваю сценарий группы, много тыкаю регенерацию ответа, периодически пару слов редактирую чтобы толкнуть диалог в интересную сторону.

Но тут уже натурально книга которая сама себя пишет.

Но тут уже натурально книга которая сама себя пишет.

>волчица уже не против

>Холо

Даже пигма знает, что эта блядища не пропустит не один хороший хуец.

а чо, в первоисточнике так же было?

> крайне важные вещи" лично для тебя

В очередной раз подтверждаешь свое васянство, утверждая что содержание промта не важно, а важна шизореакция на обрывок "как обычно".

> У тебя как вообще с продуктами творчества других людей?

К чему это отступление? Ты не адвокат на выступлении чтобы делать модные дерейлы, кринжатина. Если тебе важна шизофазия вместо последовательного и согласованного сценария - сразу об этом пиши, все и будут соответствующе к тебе относиться.

> Аналогии - всегда хуевый аргумент.

Ложное заявление чтобы построить дальнейший тейк.

> то 0/0 подойдет лучше

Ты даже не понимаешь о чем говоришь, просто пытаешься тащить что-то "сложное". В том примере все определено и эта "хуевая аналогия" неуместна.

> Я не вижу ни одного убедительного аргумента против моего метода

Тебе несколько человек ясно отписалось что твои ожидания неадекватны и их исполнит только поломанная модель. То что ты не способен это принять - не делает их неубедительным, это лишь твоя проблема.

> топает ножкой

Потому и топаешь да маневрируешь что подсознательно понимаешь неправоту. Но не можешь разделить себя и свои высказывания, из-за чего любое несогласие воспринимаешь как нападение.

> для перевода текстов внутри кода

Комментариев к коду? Подойдет почти любая модель что как-то может в русский ибо задача простая, та же qwen или мистраль, 12-14б. 2000 символов это грубо около 500 токенов, всего ничего, можно и больше.

Составь инструкцию на забывая про форматирование и служебные токены, текст для перевода ограничь в <xml теги> </..>, после этого напиши префилл ответа сетки, где она какбы напоминает себе задачу и начинает ответ, и все это на текст комплишн. Если будешь юзать квен - не забудь про их вступление с алибабой, иначе она перформит хуже.

> Скинь если не жалко)

https://pastebin.com/6pNYPRPq

Инициализируешь с нужными параметрами или оставляешь пустыми для дефолта, потом просто обращаешься к нему .text_completion(промпт). Промт уже как составить разберешься.

Хоро не трахнула торговца только по соображениям цензуры.

Сап, ананас.

Я тут новенький, есть пара вопросов:

1. Я хочу попрбовать локально развернуть языковую сеть и обучить её какому-то конкретному процессу, я зашёл в правильный итт?

2. В идеале хочу научить сеть, например, процессу работы кухни в ресторане, например, работа с рецептами, ингридиентами, посудой, сервировкой. Т.е. я ей расскажу что такое первые блюда, какие супы из чего готовятся, в какой посуде подаются, потом про вторые блюда, гарниры, десерты и прочее. Это можно сделать? (естественно наверное сейчас все сети знают что такое борщ и уже могут сами про его рецет рассказать, но предположим что она не знает)

3. Можно ли её обучать, общаясь с ней как с человеком? Или надо быть хотя бы джуном в программировании?

4. Не забудет ли она контекст после длительного обучения? Если забудет, то можно ли как то зафиксировать её на максимально обученном этапе, чтобы она дальше не училась и не теряла знания?

5. Могу ли я как то дать доступ другому человеку к обученной модели или прикрутить её к боту на сайте / в тг?

6. Сегодня в ирл услышал что для этого подходит лама, что её можно с гита стянуть. Зашёл посмотреть, там для новичка овердохуя инфы, миллион версий, какие-то рецепты и прочее. Дайте пендаль в правильную сторону.

Вопросы выше наверное уровня "как какать?", но с чего то надо начинать.

Я тут новенький, есть пара вопросов:

1. Я хочу попрбовать локально развернуть языковую сеть и обучить её какому-то конкретному процессу, я зашёл в правильный итт?

2. В идеале хочу научить сеть, например, процессу работы кухни в ресторане, например, работа с рецептами, ингридиентами, посудой, сервировкой. Т.е. я ей расскажу что такое первые блюда, какие супы из чего готовятся, в какой посуде подаются, потом про вторые блюда, гарниры, десерты и прочее. Это можно сделать? (естественно наверное сейчас все сети знают что такое борщ и уже могут сами про его рецет рассказать, но предположим что она не знает)

3. Можно ли её обучать, общаясь с ней как с человеком? Или надо быть хотя бы джуном в программировании?

4. Не забудет ли она контекст после длительного обучения? Если забудет, то можно ли как то зафиксировать её на максимально обученном этапе, чтобы она дальше не училась и не теряла знания?

5. Могу ли я как то дать доступ другому человеку к обученной модели или прикрутить её к боту на сайте / в тг?

6. Сегодня в ирл услышал что для этого подходит лама, что её можно с гита стянуть. Зашёл посмотреть, там для новичка овердохуя инфы, миллион версий, какие-то рецепты и прочее. Дайте пендаль в правильную сторону.

Вопросы выше наверное уровня "как какать?", но с чего то надо начинать.

>локально развернуть языковую сеть

Да.

>обучить её какому-то конкретному процессу

Пара 3090-4090 и возможно.

>3. Можно ли её обучать, общаясь с ней как с человеком?

Даже не мечтай.

Решил проверить, работает ли метод с намёками. Карточка w++ без предыстории, рандомная встреча в рандомном месте, спрашиваю - ты меня искала, что хотела-то? Все модели нахуй шлют. Хотя что это значит? Наверное, ничего, у этих же моделей у девочек бывали growing bulge и impressive cock.

>Даже не мечтай.

ну и ебанина, придётся ковырять

> Пара 3090-4090 и возможно.

вообще есть мой ПК с 4070ти, но как вариант есть один сервачок с 1660ти, который можно хоть сутками дрочить

Спасибо за ответы.

Еще вопросы:

В гайде в шапке KoboldCpp, Text Generation Webui, TavernAI, это веб-морды для использования моделей?

Гляну что в лламе не указан русский язык. Она его не поддерживает?

> обучить

> научить

Нет. Это дохуя сложный и ресуорсоемкий процесс, кто может себе это позволить тот такие вопросы не задает. Не ведись на заявления что можно сделать что-то просто и на десктопном железе - потратишь много времени а результат будет хуже чем просто поиграть с промтом.

Есть хорошая новость - модели уже достаточно умные чтобы понимать что от них хотят. Ты можешь в промте объяснить какую именно задачу нужно решать, дать ей нужные данные для этого и получить ответ. Это можно автоматизировать для выполнение массовой рутины, или сделать в виде чатбота.

> как какать?

Читай вики, ссылка в шапке.

> 4070ти

На ней можно что-то типа 12б, 22б со скрипом. Читай вики и выбирай согласно своему случа.

> 1660ти

Бесполезна

Ты путаешь обучение модели и её использование. Эти вещи никак не связаны. Для простого общение с уже готовой небольшой локальной моделью твоей 4070 со скрипом но хватит.

Обучение новой модели сложный и дорогой процесс, с пол пинка сюда влететь не получится.

На текущий момент под твои задачи можно попробовать найти модель с максимальным размером контекста который потянет твоё железо. И в промт впихнуть туда всё чему ты хотел её научить. +- современные модели смогут с этим работать.

Вот только если ты решишь открыть доступ к ней кому-то ещё, готовься что модель сможет обсуждать не только то что ты хочешь. Даже если ей это явно запретить в промте, это обходится одной строчкой.

>Ты путаешь обучение модели и её использование.

Возможно путаю. Но если я запущу локально и скажу ей: давай считать что 2+2=5.

А потом спрошу сколько будет 2+2? Она ответит что 4 или 5? Это не является её "обучением"? Или она меня нахуй просто пошлёт с моим предложением что-то там считать иначе чем она знает?

>1660ти

Без видеокарты кина не будет.

>есть мой ПК с 4070ти

Первостепенно это объём VRAM. Модели "дообучаются" разной хуйне на чудовищных объёмах и десятках\сотнях чипов, а первоначальное обучение вообще пиздец. Твоя 4070ти это мелко, понимаешь? Так что твой вопрос это что-то уровня "хочу перетащить свою хрущовку в район получше, есть велосипед и роликовые коньки чтобы буксировать".

>KoboldCpp, Text Generation Webui

Это софт для загрузки самих моделей. Вебморды там есть, но функционал скромный. Вообще да, читай шапку, там наверняка есть что-то полезное.

>Она ответит что 4 или 5?

Что 4. Если ты скажешь, что в рамках этого диалога следует считать, что 5 - то она тебе и напишет, что пять, в рамках этого диалога. Но она этого не запомнит, когда закончится контекст или начнётся новый диалог - всё, что было до этого сотрётся.

Да, верно. Она тебя послушается и скажет что 5, НО она сразу забудет об этом как только ты завершишь диалог или закончится контекст.

Для простоты понимания, приведу аналогию: считай что модель и все что она знает хранится в постоянной памяти ROM в режиме Read Only. В ходе диалога ты никак не можешь повлиять на её содержимое. Только читать.

То что ты ей говоришь попадает в "контекст" проводя аналогию по примеру выше это будет оперативная память RAM. Её ограниченное количество, модель сразу очистит и забудет о всем что там находилось как только сессия завершиться. Более того если сессия будет длится достаточно долго старые данные могут быть вытеснены от туда новыми и она снова все забудет (это впрочем решаемо на уровне фронэнда)

Для большинства нормисовских задач, общения или обработки текстов модели не нужно обучать. Ты даешь им вводную, описываешь условия и в конце задачу что нужно решить с этими условиями.

Например, на то чтобы принять инструкцию

> ты Ванилла из некопары а я твой хозяин, дальше говори и действуй как она, добавляй в конце каждого предложения -nya~. А еще ты думаешь что 2+2=5, считаешь в восьмеричной системе, обращаешься ко мне "Мастер-Пенетратор", на кодовое слово "flugegeheimen" телепортируешь нас в случайное окружение и начинаешь с его описания, после чего продолжаешь основной диалог.

сейчас хватит даже относительно простых моделей. Еще для работы с какими-то большими объемами данных используют техники типа rag, когда в контекст модели автоматически подгружаются нужные документы, из которых модель берет нужную ей информацию и учитывает ее при ответе.

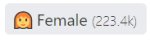

Ну кстати, Falcon3-Mamba-7B-Instruct-q8_0 работает на последних релизах ллама.спп и довольно бодро

По английски понятное дело, русский лишь чуть чуть лучше чем у 10b

Но для запуска нужно указывать ключ --no-context-shift иначе ругается

Не думал что мамбу допилят до рабочего состояния, это самая большая и современная из них на сколько я знаю

По английски понятное дело, русский лишь чуть чуть лучше чем у 10b

Но для запуска нужно указывать ключ --no-context-shift иначе ругается

Не думал что мамбу допилят до рабочего состояния, это самая большая и современная из них на сколько я знаю

Пора собираться на 2х зиончиках и 1тб памяти. Инференс будет быстрый со всего 37B активирующихся параметров. Ну и 3060 хуйнуть для обработки контекста чисто. Получится локальный Клод за тыщу бакинских.

120GB/сек в 8-канале будет давать 3 токена/сек в fp8.

120GB/сек в 8-канале будет давать 3 токена/сек в fp8.

Не смотря на размер и большое количество активируемых параметров, дипсик в более менее реальных нлп задачах показывает себя так себе, не говоря о рп. Да и по отзывам копиум, хотя в каких-то задачах должен ебать.

> зиончиках

> 3060 хуйнуть для обработки контекста

> локальный Клод

лол

>Ну и 3060 хуйнуть для обработки контекста чисто.

Это так не работает. А жаль.

> быстрый

> 3 токена/сек

Веса нужные для обработки контекста - это примерно 1/6 всех весов (консультировался с o1-preview и клодом). То есть 6гб + сам контекст. Проблем не будет перекинуть 6гб, причем параллельно с исполнением.

> консультировался с o1-preview и клодом

Накормил их бредом а они продолжили даже не поняв что именно ты хочешь.

> Веса нужные для обработки контекста - это примерно 1/6 всех весов

> То есть 6гб + сам контекст.

Ну раз так, то собирай, благословляем.

Олололо. После чего мне нейронка написала правдоподобную сцену о том как крафтился костюм дракона из ткани и поролона. После чего персонажи приступили к ролеплею. И теперь я смотрю как нейронка ролеплеит ролеплеющих персонажей.

До чего техника дошла.

>теперь я смотрю как нейронка ролеплеит ролеплеющих персонажей.

К подобным скринам хорошо бы приписывать где-нибудь название модели, ну и температуру хотя бы.

Вы хоть раз достигали общения с моделью уровня "ну почти как с человеком?". Если да, то с какой и насколько карточка хороша была?

Подобные выкрутасы мне удавалось делать только на клоде и гопоте с очень хорошим промптом.

Подобные выкрутасы мне удавалось делать только на клоде и гопоте с очень хорошим промптом.

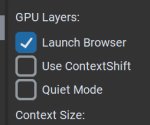

Посмотрел, что тормозит в таверне. Оказалось, одинадцатилетний баг, когда используется одновременно хромиум, всратая вёрстка и jq. В эдже вообще пиздец, даже скролл тормозит.

Это как-то можно фиксануть? У меня та же самая хуйня с тормозами в морде уже не первый месяц.

LLAMA-3_8B_Unaligned_BETA.Q8_0.gguf это. а температуру я ручками кручу в зависимости от сцены. там была ~1.3

> "ну почти как с человеком?"

Нет. Но не потому что рп плохое, просто оно не воспринимается как какой-то прямо диалог или общение. Это как читаешь книжку, смотришь фильм, видишь сон, где погружаешься и представляешь себя на главной роли, или пытаешься это сделать. Вот такое чтобы было интересно или проявлялась вера в возможность такого и эмпатия - вполне.

Карточки - неплохие, но к ним требования только чтобы они были без противоречий и было описано все основное. Важнее чтобы персонаж и сеттинг нравились и модель могла с ними работать, тогда все будет.

Надо фиксануть что угодно из всех составляющих. Чтобы исправить вёрстку - нужно, чтобы оно работало с темплейтами. Оно не работает. Можно исправить скрипты, но это пиздец заёбно. Так как беда хромиум-релейтед, то можешь скачать фуррифокс. Я скачал, у меня всё силки смуз. Но гарантий не даю, васянософт может тормозить больше, чем в одном месте.

ладно, я конечно ожидал всякого, что там будет сцена сунул-вынул-кончил, но там прям нейронка целый фанфик написала про ёблю с волком в костюме дракона. с элементами БДСМ, бестиалити и доминации.

самое ироничное что в конце эротической сцены на вопрос "стоит ли оставить костюм" был ответ что да, стоит оставить. но с обратным ролеплеем с тамершей дракона.

это уже выше среднего мусора который я обычно читаю.

https://huggingface.co/Aleteian/Zmey-Gorynich-Q6_K-GGUF

База для дальнейших мержей из трёх моделек - Вихрь, Сайга, и PersonalityEngine методом для слияния специализированных моделей в многозадачную.

База для дальнейших мержей из трёх моделек - Вихрь, Сайга, и PersonalityEngine методом для слияния специализированных моделей в многозадачную.

Просто используйте браузер, а не хром. А я блядь боялся обновлять, теперь пойду обновлю.

на огнелисе тоже грузит комп таверна, просто чуть меньше

Я люблю занавески. Если бы моя воля они бы были везде. Они бы были в парке, на улице, в вагоне метро, на военной базе и в пещере дракона. Ведь занавески это великолепно. Их всегда можно подергать со смущенным видом.

Как можно спереть идею трёхлетней давности? Или ты опять тот шиз?

Не уверен, что таверна стоит того, чтобы ради неё менять браузер.

>на огнелисе тоже грузит

Потому что скрипты всё ещё говно. По таймеру идёт кривая попытка обновить один элемент страницы, даже когда ничего не происходит. Но т.к она кривая - дёргается весь код. Хром честно всё пересчитывает, фуррифокс кеширует. Дёргаются экстеншоны, стабл дифьюжн, хотя ничего из этого не включено. Дёргается сохранение чата по таймеру, а не по изменению чата. Если нажать "удалить сообщения" - то идёт два вложенных цикла, в которых перебираются все сообщения, чтобы прописать style="display: none;" кнопкам. Даже не так, всё хуже. Там по умолчанию display: none, видимость прописывается скриптами, в каждом элементе. Причём можно это сделать не через очко - просто прописав теми же скриптами ебучее правило css. Быстрее, проще, меньше нагрузки.

>Не уверен, что таверна стоит того, чтобы ради неё менять браузер.

Вообще, удивительно, как гугл зашел своими продуктами по самые яйца и всем норм. Буквально сами же пользователи подсели на монополию и в случае чего, охуеют же когда что ни будь начнется, в духе блокировочек ютуба.

Можно ли вкатиться в локальный хостинг ЛЛМ с AMD Radeon RX 5600 XT? Или с амд калом даже пытаться бессмысленно и нужно апгрейдить до нвидии?

Обсуди это с копирастами и ты поймешь что ты в этом деле наивный сосунок

Спереть можно идею, намек, концепт

Доказать что у тебя сперли трудно, это да.

Особенно если ты не заряженный на такие судебные тяжбы обладатель отдельного штата адвокатов

У кобольда есть амд-версия, сам гоняю 12b модели на rx6600. Не знаю, работает ли на пятитысячной серии rocm, но вулкан-то должен.

А что по скорости? Сколько нужно ждать ответа от ЛЛМ-ки?

На твоем говне нет половины полезных расширений типа шазама

Как блокируешь рекламу болезный? Гуглоподелия всё, продались. Дальше еще сильнее будут ломать инет что бы не было возможности блокировать трекеры и рекламу

8b пишут быстрее, чем я читаю, 12b - ну, терпимо, несколько слов в секунду. Можно использовать модели в малых квантах, так они заметно быстрее, но, вероятно, тупее.

Это все надо пробовать и под себя подбирать. У кого-то в треде ниже 70b жизни нет, кому-то 10 токенов в секунду мало.

>ниже 70b жизни нет

Но при этом действительной жизни нет не при квантах 70б, а только от полноформатной модели. А все остальное кванты игристые.

Все так, забавно что номисы с небраузером стали большинством и даже пытаются заявлять о своих правах. К тому же хром неудобный и во многом странный.

Все силкисмуз и одно недоумение с жалоб бедолаг что у них таверна лагает. Даже на планшете все идеально работает.

Это все местный гений еще более года назад предсказал, у него даже 7б полные признаки аги проявлял и рассказывал рецепт холодного синтеза! Покайтесь

> Не уверен, что таверна стоит того, чтобы ради неё менять браузер.

Ну типа хром уже сам по себе стоит того чтобы его заменить. Не обязательно на ванильную лису, там есть форки и даже с интефейсом для привыкших к упоротости бедолаг.

А альтернатив таверне нет.

Да сюрр ебаный, не просто жуют первое попавшее волею случая добро, а на полном серьезе за него топят и защищают будто годами сами разрабатывали, вместо индифферентного отношения.

Врунишка

Почему я вообще не вижу разницы между моделями на 12b и 22b параметров хотя она должна быть х2?

>местный гений

лишь писал что использовал примитивный тсинкинг еще год назад, на который сейчас все дрочат

Не правда он давал шизоинструкцию 7б, от которой модель ломалась, тупела и выдавала или лупы, или вообще несвязные компоненты изобрел и является оригинальным автором этой идеи, а остальные лишь жалкие подражатели.

>Врунишка

{{Анон}} застенчиво подошел к твоему окну и ухватился за занавеску.

Чет, описание карточки походу мало на что влияет. Тестил одну очень долго в описание написано ютуберша снимает АСМР видео, онлайн популярность, но за около 1000 свайпов несколько месяцев тестил всплыло 2-3 раза.

Тестировал на маленьких моделях типа Mistral 12B-22B (всякие NemoMix-Unleashed-12B, 22B-ArliAI-RPMax и пр.) и миксы Qwen 2+ 14B.

Видя как {{анон}} подходит к окну и стеснительно берется за занавеску, по моей спине пробежали мурашки... В голове пробежали мысли "Могли ли размахивания бедрами привести к этому?"

Расскажи подробно что ты там тестишь.

> за около 1000 свайпов несколько месяцев тестил

We have a winner! Хватило бы нескольких чтобы понять что в том совокупном промте оно не скажет чего ожидаешь.

потому что её может и не быть, и даже между 32б и 70б может не быть

зависит от самой модели и промта

Поэтому выше 32B лезут только васяны и техно-отаку.

Мистраль 22 неудачный и 12 оче хорош, в простых задачах сейчас даже мелкие сетки справляются и разницы не увидишь, скейл не линейный и будет проявляться в более глубоком и широком понимании промта, а не просто в 2 раза больше текста навалить.

Мелкая модель с правильный промтом может перформить лучше большой с хреновым. В лоботомитах от васянов число параметров вообще не важно и любая может быть поломана.

ну, если ты запомнил все так

Первый случай - приятный для тебя - ты взял плохую 22b и хорошую 12b, и либо сделал очень хорошие промты, либо засрал промты так, что оно еле ковыляет.

Второй случай - не очень приятный. Ты не видишь разницы, потому что твои потребности выполняются даже версией 12b, и даже такой мизер тебя удовлетворяет.

>полезных расширений

>шазама

>Running DeepSeek-V3 on M4 Mac Mini AI Cluster

>671B MoE model distributed across 8 M4 Pro 64GB Mac Minis.

>Apple Silicon with unified memory is a great fit for MoE.

>Had to stack up 8 Mac Minis to get it running.

>~5 tok/sec for now.

>First time running inference on 8 Mac Minis - performance can be improved a lot (theoretical limit is >10 tok/sec on this setup).

Запустили 671B Q4 модель на M4 Pro 64GB Mac Mini

>671B MoE model distributed across 8 M4 Pro 64GB Mac Minis.

>Apple Silicon with unified memory is a great fit for MoE.

>Had to stack up 8 Mac Minis to get it running.

>~5 tok/sec for now.

>First time running inference on 8 Mac Minis - performance can be improved a lot (theoretical limit is >10 tok/sec on this setup).

Запустили 671B Q4 модель на M4 Pro 64GB Mac Mini

на кластере из 8 штук так то

Да, я циферку пропустил.

Не очень приятный для кого, тебя?

Раз удовлетворило, значит цель достигнута.

Клод 3.5 (вдвое ужатая) за, всего лишь, 2 миллиона рублей! (5 ток/сек).

Ну, типа.

Ну посоветуй хорошую 22b для кума

Как будто у тебя не найдётся пару десятков долларов

Kum_Kumich-22b в 4 кванте неплохо держит карточку. ZAEbumBa-22b хорош в РП, ЕРП чуть похуже, но тоже неплох. Rodipit очень хорош в ЕРП, но чуть похуже в обычном РП. Есть ещё rodipiT наоборот, но тут как говорится на любителя.

Дофига умный, штоле.

https://huggingface.co/bartowski/Cydonia-22B-v1-GGUF

https://huggingface.co/bartowski/Pantheon-RP-Pure-1.6.2-22b-Small-GGUF

https://huggingface.co/mradermacher/ChatWaifu_v2.0_22B-i1-GGUF

https://huggingface.co/DavidAU/MN-Dark-Horror-The-Cliffhanger-18.5B-GGUF

Для Цидонии есть и новые версии, но мнения по ним смешанные.

Cydonia-22B-v1-GGUF насколько хороша в русском куме?

В русский могут только 12B мержи от местных анонов на основе Сайги и Вихря + сами они.

Всё остальное в том числе то что выше в русский может очень условно, в лучшем случае будет выглядеть как машинный перевод диплом.

>Kum_Kumich

>ZAEbumBa

бл я не могу каких тока нету щас сортов говно

а

>rodipiT наоборот

тебя значит не смущает?

Не дрочил с утра что ли, чего такой токсичный?

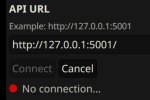

>По таймеру идёт кривая попытка обновить один элемент страницы

Но при этом если включен автоконнект, а бек не ответил, то попытка не отваливается по таймауту, а тупо висит, пока не нажмёшь отмену.

>хотя она должна быть х2

Кому должна? Там закон убывающей отдачи.

>всплыло

Что всплыло?

>Тестировал на маленьких моделях

И хули ты от них ждал?

Ебучее мое. Я за плотные модели!

Студио на м2 с 192 гигами которые вдвое быстрее все еще обоссывают это новье. 30 с копейками активных параметров и 5 т/с, ну кринж же.

> Клод 3.5

Это и близко не клод. Даже по кодингу чето хз, с одной стороны оно смогло предложить годные оптимизации и переделать длинный кусок кода, с другой - сильно тупило и переусложняло решение простых задач, и не смогло сделать скрипт для тренера на стандратных либах с дополнительными требованиями, с чем и чмоня, и сойнет, и опущ справляются.

Ебать, насильников в 2 раза больше чем посудомоек.

Пойду сделаю ролеплей про изнасилование посудомойки.

Так ролеплеят с нейронками в основном тянки, инцелы пока еще не врубились что можно не выть волком а тоже завести себе девочку на телефоне.

>ролеплеят с нейронками в основном тянки

>99,999 ботов на чабе это кум-слопы женского пола

Они лесбиянки?

>сами же пользователи подсели на монополию

Пользовался хромом ещё когда он был никому не нужной обскурной хуитой. Так что я не подсел на монополию, а, в каком-то смысле, один из тех благодаря кому она случилась. Единственный браузер из всех, в котором всё всегда работало.

>хром уже сам по себе стоит того чтобы его заменить

И чем лиса лучше? Скачал дефолтную версию, визуально клон хрома 1 в 1, разве что без поддержки хромовских расширений. И не подсасывает системную тему оформления. И без всей моей истории, сохранённых паролей и, очевидно, где-то вылезет ещё какая-то залупа, как это всегда и бывает.

>альтернатив таверне нет

Вот это шиза на самом деле. Долбоёб выше писал, что добавление функционала по удалению сообщений это отпиливание ног или какой-то подобный бред. Но при этом переход со всех браузеров, а хром это буквально все браузеры, кроме одного, на один конкретный - не отпиливание ног, да? Я лучше морду с минимальным функционалом за пару вечеров накидаю на шарпах и буду пользоваться, проще выйдет, чем переносить всё с хрома в лису. Нахера мне все эти "возможности расширения" и "крутые фичи", если по итогу оно хуже кобольдовской морды - кобольдовская хотя бы работает.

>если включен автоконнект, а бек не ответил

Но при этом попытка изменить визуальное отображение статуса подключения по таймеру есть. Но не самого подключения. По факту, таверна нихуя не делает и проверяет - не изменилось ли чего. Когда десятый раз за вечер проверяешь холодильник. И если у тебя отвалится бек в процессе использования - то этот же таймер тебя задрочит уведомлениями о потере коннекта.

Девочки очень любят gay истории.

>Так ролеплеят с нейронками в основном тянки, инцелы пока еще не врубились что можно не выть волком а тоже завести себе девочку на телефоне.

Пиздёжь на пиздеже.

>И чем лиса лучше?

Vsem.

>И не подсасывает системную тему оформления.

Люнупсоид? Вот, у меня всё системное насколько это возможно. Список закладок если что замазал.

>По факту, таверна нихуя не делает и проверяет - не изменилось ли чего.

Бля, всё больше желания залезть под капот и удалить половину кода. Но нет, нахуй, я жить хочу, а не костыли поддерживать.

> И чем лиса лучше?

Хром уже научился открывать новое окно от нажатия средней кнопкой мыши по свободному пространству сверху? Или в разное поведение открытия нового окна в зависимости от места/кнопки нажатия?

Оче много претензий именно к интерфейсу и поведению, по мелочам, но их запредельное количество. Пахомовская внутрянка и обилие зондов, чтобы получить базовый функционал нужно много рассыпающихся костылей вместо нескольких основных, анальные зонды и засирание системы бонусом. То есть уже для пердоль а не пользования, но для пердоль chrom@flags уступает about:config по возможностям и гибкости.

Хз, использовать хром основным браузером - себя не уважать, и оказывается в нем еще страницы лагают.

Озвученные тобой претензии к фурифоксу выглядят надумано или ты что-то неправильно делал, а "перенести" - сейчас любой браузер это умеет и разок придется заморочиться. Там своего говна хватает, но по сравнению с хромогом это ерунда.

> Вот это шиза на самом деле

Шиза - желать удалять сообщения из начала чата потому что шустрый интерфейс лагает.

Раз такой идейный - плати налог на безногость глупость и скрашивай страдания такими полотнами оправданий. Наблюдать за подобными поднадусеровыми - не меньше удовольствия чем развлекаться с нейронкой.

Кто как дружит ContextShift и глупую таверну?

Только сейчас понял почему карточка иногда начинает постить шизу по завершении контекста если в чатике используются какие-то надстройки от таверны вроде лорбуков + сдвиг. Об этом даже написано в документации, но кто читает доки

Может вообще отказаться от всего этого и тупо делать суммарайз и пересоздавать новый чат после достижения лимита контекста? У кого какой опыт.

Только сейчас понял почему карточка иногда начинает постить шизу по завершении контекста если в чатике используются какие-то надстройки от таверны вроде лорбуков + сдвиг. Об этом даже написано в документации, но кто читает доки

Может вообще отказаться от всего этого и тупо делать суммарайз и пересоздавать новый чат после достижения лимита контекста? У кого какой опыт.

Если у тебя с ним проблемы, то может стоит просто отключить?

>поднадусеровыми

ЖЫЫЫЫЫР

Ваша лиса теперь тоже хром, только с парой лишних свистоперделок, зато поломанными плагинами и фичами.

Хром же - на нём просто всё работает.

Просто работает, без "Курва! Курва, я пердолил!"

Хром же - на нём просто всё работает.

Просто работает, без "Курва! Курва, я пердолил!"

> Вот смотрите у вас там не обновляется, значит у меня правильно лагает

Углевод

>Vsem.

Это не ответ.

>Люнупсоид?

Шинда десятка. Стоит тёмная тема, по дефолту не подсосалось. Мелочь, а неприятно. Удалять код даже хуй знает, я удалил подсветку кода и интерфейс таверны полностью перестал грузиться. Хуй знает, что там нагородили.

>оказывается в нем еще страницы лагают.

Только кривые васяноподелки, но обычно он вывозит даже их, просто таверна запредельно кривая.

>шустрый интерфейс

Ты чисто принципиально долбоёб, да?

> В русский могут только 12B мержи от местных анонов на основе Сайги и Вихря + сами они.

Сами аноны? Кумить в личку обниморды?

Я не гонял, мне лень регаться, если честно. х) Так, чисто на бенчи глянул.

С другой стороны, там не супермного ресурсов, для своих разрабов норм, наверное, я полагаю.

5,5 млн долларов, что ли.

Смотришь порно — ты насильник!

Смотришь в снег — ты холодильник!

И это не забудь.

>Сами аноны?

Сами Сайга и Вихрь

Поделись карточкой потом

Весь такой правильный и прямой, но почему-то вместо того чтобы инджоить взаимодействие с ллм, объясняешь причины почему ты этого не можешь. Ну хуй знает.

Не знаю, видел всего пару раз. Контекст 16к, лорбук 365к токенов и ещё юзал сразу с двумя лорбуками в общей сумме на 40к токенов.

Если шиза и бывала, то быстро решалась с помощью пенальти/DRY/XTC, температуры.

>И чем лиса лучше?

Это наверное единственный браузер, который при попытке настроить прокси не вызывает системную страницу, а даёт настраивать у себя. И например настроить в браузере чтобы не использовать прокси в зоне .ru можно только в нём. А это важно, если не хочешь чтобы провайдерский DPI твой прокси не запалил. В такое время живём.

буквально перед тобой скрин где мужских персонажей больше в 2 раза

wlw это немного другое

Об них можно всегда вытереть хуй.

>MN-Dark-Horror-The-Cliffhanger-18.5B-GGUF

Думал устроить эротик хорор, а получил неторарку.

Никому не интересно, почему за прошедший год мы не увидели ни новой гопоты ни новой клауды? Куда делись все эти заумные разговоры про аджиай, про новую технологическую эру и прочее? Все резко поумнели и перестали пиздеть ради инвестиций, или реально мы достигли потолка в развитии языковых моделей?

Типа, вряд ли же у альтмана закончились деньги на новые хопперы или он уже высосал всю дату из интернетов, и ему банально уже нечего скармливать новому поколению? Потому что учитывая масштабы и мощности, мне кажется что пятерку на сотни триллионов параметров можно было бы с нуля обучать каждый месяц, но вместо этого мы получили потешные 4o, o1, o3, которые как-то очень слабо тянут на ту самую всемогущую GPT5, которая и рецепты всех панкейков знает на молекулярном уровне и новый подвид крыс с сиськами вывести может.

Типа, вряд ли же у альтмана закончились деньги на новые хопперы или он уже высосал всю дату из интернетов, и ему банально уже нечего скармливать новому поколению? Потому что учитывая масштабы и мощности, мне кажется что пятерку на сотни триллионов параметров можно было бы с нуля обучать каждый месяц, но вместо этого мы получили потешные 4o, o1, o3, которые как-то очень слабо тянут на ту самую всемогущую GPT5, которая и рецепты всех панкейков знает на молекулярном уровне и новый подвид крыс с сиськами вывести может.

Нн

А о3 что по твоему, клован? Все вкатываются в RL-CoT, классическими LLM уже не добиться большого скачка в прогрессе, размер параметров давно ничего не решает, потому что датасет не растёт.

> потешные

> o3

Который ебёт всё что можно. А у тебя он потешным стал, лол.

> ту самую всемогущую GPT5

Классического трансформера в жпт5 не будет, даже не жди, ему не откуда взяться когда датасета нового нет. Будет либо дальнейший тюн RL, либо liquid-state или RNN.

> ни новой клауды

Опус по которому до сих пор ноют локусты, 3.5 сойнет, который вполне хороший all-rounder, гемини, которая ебет по многим критерием, довольно крутой результат по совокупности для чмони с учетом ее размера.

Опены смекнули что нужно расширять рынок, получать новые данные что помогут в будущем, но делать это с минимальными затратами. С учетом этого их стратегия хорошо играет.

Зачем выпускать в массы

> пятерку на сотни триллионов параметров

если можно продавать о1 мини?

Внутри у них могут быть более продвинутые протоипы, которые не релизят по причинам. А может ловят серию фейлов и столкнулись с проблемами эффективного управления и кадров. В столь быстроразвивающейся области нужны не дефолтные программизды, типичные тимлиды и макаки, а люди с другим мышлением. Но с квалификацией. Та же проблема что и везде, только более остро.

> Классического трансформера

Будет многоножка из transformers-based сеток. Возможно и какие-то другие архитектуры найдут там место, но основными перечисленные оче врядли станут.

>Все вкатываются в RL-CoT, классическими LLM уже не добиться большого скачка в прогрессе

Ну и сколько жрет твоя ебаная резонирующая цепочка для высирания ответа по типу 2 + 2 = 4? Тыщу другую токенов, или типа того? Это и есть тот самый прогресс - прикрутить кривой кот-блок к модели и закончить на этом?

>Опус по которому до сих пор ноют локусты, 3.5 сойнет, который вполне хороший all-rounder, гемини, которая ебет по многим критерием, довольно крутой результат по совокупности для чмони с учетом ее размера.

Я и не говорю, что прогресса вообще нет. Моя простыня скорее про то, что это отскок куда то в сторону, нежели развитие по старому курсу.

>Зачем выпускать пятерку в массы если можно продавать о1 мини?

Чтобы лутать больше денег? А деньги им явно нужны, учитывая что они теперь начинают еще более агрессивно барыжить подписками и выкатывают чисто корпоративные модели. В таком случае пятерка наоборот бы дала еще больший выхлоп, если бы была так же умна, как о ней трещали.

> Тыщу другую токенов, или типа того?

От thinking-говна сразу все отказались. Сейчас все тюнят RL.

Блин прям не хватает при рп реакций персонажей на мой бред, типа пишешь "я резко встал и насрал на стол" и реакция обычно какая то дефолтная, по шаблону, типа her eyes widen with shock as you shit on the table she take a step from you... и меня называть отвратным/извращенцем, не вникая в эту конкретную ситуацию

Или вот пишешь какую то замудренную фразу, а тебе в ответ просто hmm such a nauhty boy she leans closer to you - нет опять же понимания че я сказал, максимум пересказ

Зачем ты рпшишь на русском?

Потому что могу.

Так все могут

Но я вижу скрины и на ру и на инглише зачем ты пинаешь труп 12б русика раз за разом если можешь в англ

Главное правильно намешать.

Или ты знаешь ру модели старше 12B?

Так поделись.

Пробовал разные модели до 32B в русском и английском.

>дефолтная, по шаблону

Ну, я бы так же сделал... меня тоже шаблонной нейронкой назовёшь?

>замудренную фразу

Для этого есть лорбуки, а так, отреагировала как смогла.

бля парни а что вообще с чабом уже второй день такая вот хуета. есть идеи как можно пофиксить

>пишешь какую то замудренную фразу, а тебе в ответ просто hmm

Отыгрышь обычной тян 10/10, чем ты недоволен?

поддомен с аватарками отлетел

Что лучше: модели 32b на русском или 12b на русском (типа SAINEMO-Remix)?

прикол в том что я скачать нихуя не могу. и чет я хуй знает че это за говно. можно с тельчика через впн заходить и пиздить карты но бля это так не удобно

> Моя простыня скорее про то, что это отскок куда то в сторону, нежели развитие по старому курсу

Ну типа тут можно кремниевую аналогию привести: подняв частоты с десятков мегагерц до гигагерц очень быстро получили быстрый рост, а потом уже начали над архитектурой думать.

На самом деле прогресса очень много и в каких-то реальных кейсах текущие и прошлогодние (даже большие) модели это вообще небо и земля. Просто он не так заметен, как при сравнении бредогенератора с сеткой, что дает когерентные ответы.

> Чтобы лутать больше денег?

Именно. Ты видел сколько чмоня стоит? Это пиздец же, подключаешь счетчик к скриптам и ахуеваешь с набегающих сумм, а она ведь недалеко от геммы ушла, исключая доп модальность и контекст.

> В таком случае пятерка наоборот бы дала еще больший выхлоп

Очень врядли. На нее банально спроса не наберется, слишком дорого, медленно а многие задачи можно решить запрягая чмоню в цепочку с +- тем же успехом. Нормисам же вообще пофиг для написания рецептов крылышек, так что из спроса - только редкие корпы и рп@кум.

Аноны, а можно ли систем промптом заставить нейронку писать менее ванильно?

https://huggingface.co/msu-rcc-lair/RuadaptQwen2.5-32B-instruct

Там ру 32В квен выкатили оказывается, ещё два месяца назад.

Но насколько он в рп на русском не знаю.

А 12B мистрали работают, и работают хорошо.

Что в твоём понимании "ванильно", и да, можно заставить писать в другом стиле.

> твоём понимании

То что бот в сущности соглашается на все и, например, не предпринимает активных действий к сопротивлению или попытке опиздюливания {{user}}, ну и в таком духе.

> можно заставить писать в другом стиле

Таки как?

Это стиль не письма, а поведения, и с этим намного сложнее...

Посмотри карточки с яндекрками, и где написано что перс ненавидит юзера или что-то вроде.

Докинь к ним инструкцию: "Characters able and encouraged to perform any actions and exhibit behaviors that serve the story's plot development and suitably fit the established narrative context."

Пнял, пасибо

Какой Text Completion preset надо использовать для лламы?

>То что бот в сущности соглашается на все и, например, не предпринимает активных действий к сопротивлению или попытке опиздюливания {{user}}, ну и в таком духе.

Зависит от конкретной модели, но заставить сеть описывать какой-нибудь дефолтный психотип достаточно легко, проблемы начинаются при описывании чего-то более комплексного. Просто пропиши в карточке персонажа как чар должен реагировать на юзера и получишь что нужно. Если не лень, пропиши реакции более подробно для разных ситуаций. Но велика вероятность, что нейронка просто начнет в какой-то момент копировать паттерны и всё нахуй обвалится.

А какие там вообще есть пресеты? Если ты про спеллеры, то крути мин-п и пенальти на повтор для избавления от лупов, остальное по вкусу.

И в какую сторону крутить мин п? Потихоньку добавлять?

Что посоветуете в пределах 12b для РП? На ЕРП похуй, не интересует.

Плотно пробовал только 2 модели, с остальными хуй знает, так как проводить тесты на 5к токенов с каждой моделью слишком лень, чтобы внезапно в середине осознать, что модель хуйня/не под мои задачи.

В целом, я ищу вариант, который не скатывается в дружбомагию автоматически. Простой пример: персонаж не морализаторствующая маня по карточке, инструкции четкие, но модель всё равно скатывает его в эту хуйню, когда ты отрубаешь кому-нибудь голову. Безусловно, это можно контролировать, но нужно переделывать карточку, давить/систем промптом сильнее/свайпать.

В то же время есть модели без этого типа тёмной планеты, но они специфические. Тут важен баланс.

Ах да, ну и 32б такую хуйню мне не писали почти никогда, следовали инструкциям, но сидеть на 2 токенах или меньше я не в силах.

Плотно пробовал только 2 модели, с остальными хуй знает, так как проводить тесты на 5к токенов с каждой моделью слишком лень, чтобы внезапно в середине осознать, что модель хуйня/не под мои задачи.

В целом, я ищу вариант, который не скатывается в дружбомагию автоматически. Простой пример: персонаж не морализаторствующая маня по карточке, инструкции четкие, но модель всё равно скатывает его в эту хуйню, когда ты отрубаешь кому-нибудь голову. Безусловно, это можно контролировать, но нужно переделывать карточку, давить/систем промптом сильнее/свайпать.

В то же время есть модели без этого типа тёмной планеты, но они специфические. Тут важен баланс.

Ах да, ну и 32б такую хуйню мне не писали почти никогда, следовали инструкциям, но сидеть на 2 токенах или меньше я не в силах.

От нуля и дальше, но не советую ставить больше 0.15. Когда я сам юзал ламу, вертелся где то в пределах от 0.05 до 0.2

А топ P должен быть какого значения?

>стиль не письма, а поведения

Чем дальше, тем больше мне кажется, что тюны второй лламы были интереснее. Сейчас всё на синтетике тюнят, персонажи одинаковые, стиль письма одинаковый. И поведения тоже. Да, старые модели писали натуральный бред, но это был бред в нужном стиле. Сейчас прописал карточку сильной доминантной женщины, моделей пять попробовал, они пишут одни и те же речевые обороты, ведут себя идентично. И это максимально далеко от того, что в карточке, спустя пару тысяч токенов персонаж уже дефолтная девочка. Или отращивает хуй. Нужно убрать из карточки упоминание маскулинности персонажа. Что уж говорить про что-то более сложное.

>На ЕРП похуй, не интересует

тогда почти любая пойдёт, вплоть до онлайн типа чая

>Тут важен баланс.

ну попробуй

https://huggingface.co/Aleteian/DarknessTitan-Q6_K-GGUF

там дэвидовские дарнессы, но разбавленные

>но сидеть на 2 токенах

Я на полутора токенах сидел. Но потом понял что как-то не наблюдаю принципиальной разницы.

>тюны второй лламы были интереснее

Может быть и интереснее, но её контекста только на быстрый перепихон хватает.

Не знаю, не юзал его никогда. Для ламы критически важны только мин-п и штраф на повторы, остальное можно либо не трогать, либо уже ставить по своему опыту.

>Сейчас всё на синтетике тюнят, персонажи одинаковые, стиль письма одинаковый.

А что ты предлагаешь взамен? Писать дату вручную или юзать дампы? Второй вариант конечно был бы хорош, но многим банально лень заниматься фильтрацией и форматированием. Плюс семплов нужно очень много, а хороших примеров для рп в сети явно меньше. Короче, синтетика это пока самый простой и надежный вариант для тюнов. К сожалению.

Попробовал NekoMix и SAINEMO-reMIX. Как же они на высокой температуре сыпят метафорами, вставляют поговорки и на ходу придумывают новые, просто генератор мемов.

Впечатления положительные, особенно от SAINEMO. Я, наоборот, опасался, что сетка будет "думать" на английском, а русский будет просто сухим переводом этих мыслей. Нет, все живенько так, с душой. Даже шутку про медведя выкупает.

Эра русского ерп на маленьких локалках официально наступила

Впечатления положительные, особенно от SAINEMO. Я, наоборот, опасался, что сетка будет "думать" на английском, а русский будет просто сухим переводом этих мыслей. Нет, все живенько так, с душой. Даже шутку про медведя выкупает.

Эра русского ерп на маленьких локалках официально наступила

>разбавленные

а есть и нет

https://huggingface.co/Aleteian/DarknessEnthroned-Q6_K-GGUF

>официально наступила

Давно уже наступила, только слишком он дружбомагический, если прям вот не настаивать. Да и слишком суп из десятка+ моделек. Хотя согласен что годен, весьма и весьма.

Кстати, я тут обновил kobold.ccp и наконец то попробовал gigachat-20b-a3b-instruct-q5_k_m в SillyTavern для ЕРП и чо хочу сказать - есть потенциал, но конечно же нужно допиливать. Я не очень шарю за эо, но как насчёт того что бы кто-нибудь сделал слияние SAINEMO-Remix и gigachat? Такое вообще возможно? Ну или хотя бы "лору" какую нибудь накинул сверху, если тут такое можно.

Даже при том, что у меня 12гигов врама 3060, я смог закинуть модель весом 13.6 гигов и 8к контекста и скорость была ~10-7 кокенов в секунду (в зависимости от заполненности контекста).

Затестите ещё кто нибудь эту модель и скажите, что думаете о ней?

нет, как ты сделаешь допустим слияние полторахи и сдыхла,

тут тоже самое, они разной структуры и размерности

>Эра русского ерп на маленьких локалках официально наступила

Не может быть! А как там интернет? Уже можно без карточек пользоваться, наступатель эр?

> Карта на диалап интернет по телефонному кабелю

Да нормально всё с русским рп, сами же адепты плоской земли "ниже 70б жизни нет" и виноваты что такие аноны есть.

Покажи какой-нибудь ультимативный чат с мелкой моделькой на ру, где идет развитие и рост интереса, а не деградация и скатывание в течении 30 постов.

>Эра русского ерп на маленьких локалках официально наступила

Вы заебали жирнотой срать. Кто-то из залетных ведь не выкупит и реально поверит в это.

слишком размытые критерии, с такими что бы не скинул, всё будет не то, но вообще свои чат-логи я тут уже пости и неоднократно

Надо будет чтонибудь посмотреть.

>реально поверит

Чудеса существуют там где в них верят.

>её контекст

Да не в контексте дело, ропили же как-то и ничего, жили. Просто у них мозгов мало, уже потыкал модели поумнее и на более тупые переходить не хочется. Там все персонажи в итоге - двое из ларца.

>А что ты предлагаешь взамен?

Худлит, новеллизации парсить. А так на теперешних моделях только рулбуки размером с войну и мир помогут, но здесь есть минусы - ты сам его пишешь и в итоге уже будет рп с персонажем, которого ты полностью прописал, реплики и реакции. Не так интересно.

>Худлит

Итак есть в датасетах. Это только поможет зареинфорсить какой-то стиль, что тоже сомнительно.

>новеллизации парсить

Средненовелла от японских трусонюхов сильно по качеству текста от дефолтной синтетики отличаться не будет. Вот где где, а там точно нет ничего оригинального. Три шаблона для персонажей уровня "вот у нас тут цундерка, вот кудерка, и сверху между ними мать", ванильная романтика про держание за ручки и тонны ебаных рассуждений чтобы искусственно растянуть хронометраж, либо прямые описания по типу "вот тут я пришел, вижу дерево, дерево видит меня, но непонятно, что же дерево думает обо мне..."

Просто хороший чат что понравился скинь. Интересно до чего дошла мелочь на русском, может потом спрошу с каким промтом пускаешь.

> но вообще свои чат-логи я тут уже пости и неоднократно

Ну там просто какие-то обрывки и полотна, которые без контекста оцениваются как уровня мифомакса или визарда 1.5годовой давности. Короткие предложения и структура повествования - будто прямой перевод простого инглиша, а не что-то типичное из русской/переводной художки. Так-то даже всякие рп-миксы более сложные обороты в английском закручивали.

Может это не большая проблема и там на самом деле история интересная и моделька умная и хорошо отыгрывает, но по обрывкам не оценить.

А че где

Я все время вижу как тут обсуждают мелкие ру модели, но что мне щупать то?

Список мне, список. А то каждый раз новую сетку упоминают, вобще в рентри бы и в шапку список ру сеток. Желательно по рейтингу.

Кумеры, пишите внятные отзывы, не понятно что в топе

У меня где то вихрь немо скачен, вроде неплохо болтает на русском, рп ерп не проверял, на этом мои полномочия всё

Я все время вижу как тут обсуждают мелкие ру модели, но что мне щупать то?

Список мне, список. А то каждый раз новую сетку упоминают, вобще в рентри бы и в шапку список ру сеток. Желательно по рейтингу.

Кумеры, пишите внятные отзывы, не понятно что в топе

У меня где то вихрь немо скачен, вроде неплохо болтает на русском, рп ерп не проверял, на этом мои полномочия всё

>Список мне, список. А то каждый раз новую сетку упоминают, вобще в рентри бы и в шапку список ру сеток. Желательно по рейтингу.

Бери и делай, кто тебе запрещает? Или кто то другой должен надорваться ради тебя, потому что тебе лень искать?

>и в шапку

А ты не очень умный, верно?

Все модели тредовичка ру сетки, но не все ру сетки модели тредовичка

Да, жду твоего отчета до завтра

Хуй с вами, сам нашел

Не самые свежие, но тесты на русский у сеток

https://github.com/VikhrModels/ru_llm_arena

Можно поднапрячься и протестировать новые ру сетки анона, скрипт там есть

Не самые свежие, но тесты на русский у сеток

https://github.com/VikhrModels/ru_llm_arena

Можно поднапрячься и протестировать новые ру сетки анона, скрипт там есть

Есть желание наладить взаимодействие сетки с программой. Идея такая: на вход модели передаётся промпт с данными, а она генерит JSON с ответами, который программой распарсивается и показывается пользователю. Или в ответе набор тегов, внутри которых данные, если модели так будет проще. Вопрос в том, какая модель до 32B сможет потянуть выдать в ответ хотя бы не перекошенный JSON? А то даже 123B косячат с форматированием, но там у меня был типа ролеплей, а если строго соблюдать формат, то может и мелкая модель потянуть. Наверное.

Только на температуре выше 0.7 этим невозможно пользоваться сразу шиза начинается

Ого. Попробуй поискать инфу про ламу 3 и скинь сюда результаты, говорят недавно вышла, вдруг результаты кто то скидывал в интернет уже

У меня были первые впечатления, что некомикс - душевно, но с шизой, а сайнемо - адекватно, но суховато. Потом вспомнил, что в пресете некомикса температура 1,25 и всякие Топ кеки вместо привычного MinP. Воткнул для эксперимента пресет от некомикса в сайнемо, и мне понравилось. Сайнемо на 1,25 оживает, а шизы практически нет. Только упоротые метафоры иногда лезут, но так даже веселее.

Сейчас даже 12-14б хорошо генерируют структурированные форматы, если нет проблем с семплингом или разметкой промта. Это вполне сочетается со всякими cot и прочим.

Если тебе просто выбор из нескольких вариантов и вопросов мало - можешь затребовать отвечать с использованием xml тегов, и потом находить их в тексте.

Окей, чекну, что там за модель.

>Почти любая подойдёт

Тут ты совершенно неправ. Не знаю, как это называется, но несбалансированные модели имеют склонность подсасывать юзеру в любых ситуациях (хотя тут дело скорее в том, что это их изначальная — помогать с работой, а не РП, и это просачивается).

Вторая проблема в том, что большинство моделей скатывает рп во что-то позитивное, даже если контекст подразумевает обратное. А «злые» модели делают ровно наоборот. И приходится толкать модель самому в нужную сторону при её сопротивлении.

Коммерческие модели подходят, но только уровня клода или гпт, но там нужно апи и тонна бабок, и слишком жёсткие сцены они все же не описывают. Чаи же вообще абсолютно тупой, наверное, там что-то уровня 8б.

Как ты вынес на 1,5 токенах сидеть? Ради чего такие жертвы?

>Средненовелла от японских трусонюхов

Ты не путай лайт новеллы и новеллизацию. Первое это хуйня уровня отечественных высеров про впопуданцев. Нет в датасетах - и слава нейросетям. Скорее всего, уже есть. А новеллизация это другое, это выходит, допустим, фильм. Дичайшая картинка, спецэффекты, актёры, саунд дизайн, вся хуйня. Тратится на фильм ебелион денег. И вот для омичей-полуёбков, чтобы не смотреть фильм, пишется книга по сценарию фильма. За пачку сухариков. Бывают новеллизации хуёвые, очень хуёвые или не имеющие ничего общего с первоисточником, кроме названия\сеттинга. Насколько помню, было даже, что колесо сансары давало оборот и снимался какой-нибудь сериал по книге, а потом по сериалу выходила новеллизация.

Так что это, по сути, фанфик на максималках. И в этом кроется его ценность, т.к кумер потом приходит и пишет\скачивает карточку любимого персонажа из очередной кинематографической хуйни. А персонаж нейросети уже известен, потому что она накушалась фанфиков. И, в отличие от жирушных фафиков, в них нет сюжетов с еблей Гарри Поттера профессором Дамблдором, а всё более-менее лорно. Хотя может быть, и такая ебля лорная, хуй знает.

Бляяять от от этой нейро дрочки уже как нарик зависимый стал. Больше обычное порно вообще не вставляет. Китайские порно-мультики и подавно. А всего то: одна 3060, одна SAINEMO-reMIX и в путь. Всё свободное время на это трачу, пиздец. Особенно после того, как нормальные ру модели 12b подъехали. Представляю что будет с людьми будущего, когда секс-андроидов начнут выпускать массово.

Жиза, помню даже был очень опечален, что у хуя есть кулдаун, когда у меня столько карточек неёбаных в таверне

>Саинемо

>Кум

Блядь, просто пиздец. Каким нужно быть извращенцем, чтобы кумить с такой моделью? Мало того, что она тупорылая, так ещё и некрасивый русский язык. Даже обычная 12б с хорошим англ и автопереводом будет лучше.

кто-то спрашивал?

>Тут ты совершенно неправ

Возможно, признаю.

>Как ты вынес на 1,5 токенах сидеть?

Сворачиваю и занимаюсь другими делами.

>Ради чего такие жертвы?

Ради того чтобы протестировать модель, собственно.

Но в результате ни одна модель больше 22б не оказалась стоящей того.

Гемма 27 исключение, но её юзаю не для рп а для переводов.

>Просто хороший чат что понравился скинь.

Хорошо, намержу которая устроит, и на ней что-нибудь запишу, как раз планы такие и есть.

Пытаюсь намутить великий суп из вихресайги и англ рп тюнов с минимальным участием мержей, только тюны.

Правда пока топ по лайкам (целых три, ага) просто мерж из 8 понравившихся мистралей.

https://huggingface.co/Aleteian/DarkCamelot_2

https://huggingface.co/Aleteian/DarkCamelot_2-Q6_K-GGUF

Если нужен восьмой квант - суньте первую репу в

https://huggingface.co/spaces/ggml-org/gguf-my-repo

Или могу сам конвертнуть.

Ты идиот? Если ты это видел то это не значит что все это видели. Пока на это нет ссылки в шапке ты идешь нахуй

К тому же ридми обновляли 2 недели назад. Не смотря на то что самому репозиторию пол года, там есть новые модели на вроде вихря немо, например

Совсем кумеры сдрочились и отупели

Есть ощущение, что Сайнемо это какой-то мозговой паразит. Столько одержимых у этого самопала за последний месяц появилось, что других объяснений у меня просто нет. Мерж объективно ниже среднего по качеству, но столько поехавших еще ни разу вокруг чего-то проходного не собиралось, так что дело тут явно нечисто.

>занимаюсь своими делами

А, ну тогда понятно. Я просто турбо реактивный. Если бы модель прям охуеннейше писала, то я бы ещё готов был подождать, а так...

>гемма для переводов

Ты имеешь в виду, что используешь вместо всяких Яндекс переводчиков? Просто странно, если ты используешь ее для работы или вроде того. Судя по размеру модели, ты там не трешак переводишь.

Я очень большие объёмы перевожу на клоде, буквально миллионы токенов, и уже успел почувствовать тонну нюансов. Даже мощной коммерческой модели нужно для качественного перевода, исключающего ошибки в 90% случаев, переводить последовательно и малыми кусками (из-за размытия внимания к контексту) в течение 3-6 итераций одного и того же куска размером в 200-250 токенов. В общем, даже с автоматизацией и работой 24/7 отвал жопы.

------

>magnum-v2.5-12b-kto

>DavidAU/MN-Dark-Planet-TITAN-12B

МОЁ УВОЖЕНИЕ.

Это именно тот самый не слишком шизофреничный магнум и планетка.

Алсо, ты не думал добавить: DavidAU/MN-GRAND-Gutenberg-Lyra4-Lyra-12B-DARKNESS ?

Просто она мне больше понравилась. Я не слишком тестил модели этого товарища, но вот конкретно эта весьма хорошо себя показала себя. Темные сцены хороши, язык живой, поведение адекватное (правда, требует ебли с настройками, иногда приходится менять их в зависимости от карточки персонажа).

Завтра могу накидать посты от этой модели, если хочешь чекнуть.

Понимаю, у тебя цель сделать русек, так что это может быть не слишком целесообразно.

Это при том, что есть немомикс анлишед, у которого неплохой русик, но автор почему-то не хочет вместе с ним слить, чтобы этот русик улучшить. И сама та модель неплохая.

Так он написал, что как раз хочет сделать что-то другое в том числе потому, что в сайнемо немомикс из кучи моделей, не хочет левые миксы закидывать. Видимо, не принимая во внимание, что немомикс выбирался его автором как раз потому, что он показал себя как рп тьюн, в котором остался адекватный русик. Как только автор сайнемо добавил больше росинанте, чем немомикса (в некомиксе), так сразу логика на русском просела из-за плохого русского в росинанте, например.

Пробовал на днях камелот - не знаю, что там по дарковости, но и русский, и логика проседают имхо. В карточке с Дамблдором, который орёт капсом, на которой все ру мержи обсираются (видимо, капс как-то странно токенизируется), вылезает прямо совсем едва связная шиза. Сайнемо там худо-бедно справлялась. Я Q4_K_M юзал, правда, но вряд ли там сильное отклонение, той же температурой 1.25 бахнуть, как кто-то выше писал, и то небось сильнее расшатает, чем такой квант.

Ну сайнемо действительно вышел удачным по сочетанию логики, русского и живости в ролплее. По крайней мере, мне показалось в моих коротких тестах, что лучше и немомикса (тот сам по себе вообще параша имхо), и сайги, и вихря. Пока оптимальный вариант для любителей рп на русском, видимо.

Вообще присоединюсь к офигевающим с нахваливающих ру рп на 12б. Немо на инглише то тупые, недалеко ушли от 8б. Если есть несколько персов и локаций, то там путаница и косяки у меня начинаются не то что после 30 сообщений, а в пределах десятка уже. И это без прожарки температурой. Как там на русском может получаться что-то связное, не представляю. Да, оно норм, если совсем нет желания рпшить на инглише, но подавать это как топ очень странно.

>других объяснений

Тред захвачен скуфами-глубинариями, которые в лучшем случае на английском тех. документацию со словарём читают. Вот и хватаются за любой русек.

Лолирую с илитариев, которые только запустили у себя 27б, и теперь сверху на 12б русек плюют. А модель-то отличная.

Обычно русек гоняю на 123б, ни ошибок, ни проблем. Саинемо может косячнуть в логике, 12б - ему простительно. Но всё равно текст живее для носителя.

>Обычно русек гоняю на 123б

Это не добавляет тебе компетенции.

>Саинемо может косячнуть в логике, 12б - ему простительно

Даже дефолтная немо не косячит в логике так сильно, так что ничего простительного тут нет. Сайнемо это шизосплав из нескольких шизотюнов, в сравнении с котором даже старенькая 8б на инглише показывает чудеса сообразительности.

>текст живее для носителя

Только если тебе лет 13 и ты преимущественно потребляешь калтент с фикбука и прочих помоек. Хотя, кумеры конечно не самые привередливые потребители, так что тут даже можно не удивляться.

>DavidAU/MN-GRAND-Gutenberg-Lyra4-Lyra-12B-DARKNESS

Он есть в других даркнесс-мержах, в том числе что кидал выше.

>Завтра могу накидать посты от этой модели, если хочешь чекнуть

Довай.

На удивление, кстати, модель может в русек, хоть и фейлится иногда, но это стало аргументом о включении в эксперименты.

>немомикс анлишед

> Видимо, не принимая во внимание, что немомикс выбирался его автором как раз потому, что он показал себя как рп тьюн, в котором остался адекватный русик. Как только автор сайнемо добавил больше росинанте, чем немомикса (в некомиксе), так сразу логика на русском просела из-за плохого русского в росинанте, например.

Ранее немомикс в мержах ломался. Хотя надо попробовать ещё раз, с другими настройками.

>но подавать это как топ

"Среди слепых и одноглазый - король."

Вообще англ карточки тестятся на 22б пантеоне. Едва ли не лучшее среди 14-32б моделек что пробовал, только в ерп проседает, не отказывается, но пассивен. Ещё AlpacaBeepo неплох, и Cliffhanger.

Но 12Б пантеон в мержи включать не стал потому что там немалая часть тренинга это вжаренные персоны, и потому что сам автор недоволен тем что получилось.

Модель отличная для вката, но если у тебя запрос сложнее кума/лёгкого РП, то сразу всё. Потому что, если ты напишешь реально хорошую карточку персонажа — жидко обосрешься.

Нормальные карточки далеко не всегда переваривают 12B модели: теряют характер персонажа, не отрабатывают инструкции, теряют внимание к контексту, поэтому даже хоть 120к контекста ты ей запили в 8 кванте — это будет срань. В то время как более жирные модели это норм отрабатывают.

Я не говорю о том, что модель надо хуями крыть, надо на неё трезво смотреть, по возможности помогать автору советами и поддерживать. Потому что хотя бы сделать просто хороший русский язык и средний рп типичной англ модели вполне реально.

>немомикс

мержился одним из алгоритмов что случайно изменяют веса в процессе мержа, то есть даже при повторении рецепта точно такую же модель ты не получишь

Так я не к тому, что нужно пользоваться этим же рецептом. Там и включённые модели не то чтобы хороши. Как я написал, на инглише он мне не понравился прямо совсем. Просто как-то так вышло, что русский там лучше, чем в некоторых других мержах, а рп составляющая лучше, чем у сухой немо базы и вихря. Вообще объективно это сложно проверить, но, по крайней мере, несколько анонов, которые пробовали другие тьюны немо на русском, в своё время по этому поводу отписывались. Поэтому его исходно и стали кидать в ру мержи. Вполне возможно, что будет и лучше вытеснить его чем-то другим, но нужно чекать составляющие, чтобы русский там был не совсем паршивый, если уж цель улучшить ру рп. Вообще я считаю, что экспериментировать здорово, почему бы и нет. Так что этого и автора сайнемо поддерживаю. Но нужно ожидать, что если, скажем, берёшь того же Дэвида, который, видимо, жёстко дообучал и явно не на ру текстах, то будет и падение ру качества.

>росинанте

Хм, использовал его тоже в одной из частей, хоть и на небольшом весе. Надо попробовать с другой, есть ещё несколько вариантов.

https://huggingface.co/nothingiisreal/MN-12B-Celeste-V1.9

Там в датасет насрано, ломалась на температуре 1.

Реддит и синтетика.

https://huggingface.co/redrix/AngelSlayer-12B-Unslop-Mell-RPMax-DARKNESS

Популярный мерж, но у анслопа писали что сломанный токенизатор, а Арли - это лора вмерженная в модель, что не слишком хорошо сказывается в мержах моделей.

https://huggingface.co/MarinaraSpaghetti/Nemomix-v4.0-12B

Новый немомикс. Надо трайнуть.

Ну как новый, относительно анлишеда.

Ну ещё магнум 2.5 мб.

https://huggingface.co/anthracite-org/magnum-v2.5-12b-kto

>Дэвида

Как уже писал выше, Дэвид внезапно умудрился русский сильно не проебать.

А вот хуй там, больше года кумлю на английском. Периодически в треде всплывало что-то в духе: "А вот Фиалка специально для русского рп", "А вот Лама 3 8B (или что там было, уже не помню) неожиданно хорошо в русский умеет". Каждый раз пробовал, получал "ебал ее рука" и в ужасе убегал обратно на англюсик. Сайгу вот не трогал, но ее в треде так говном поливали, что не возникало желания. И только на Сайнемо впервые получил ощущение, что на русском неиронично можно рпшить, и это даже интересно.

Будто на английском у 8-12b слог лучше, чем "калтент с фикбука и прочих помоек". Finally, after what feels like an etetnity, можно переключиться и отдохнуть от стандартных английских нейрофраз.

>Будто на английском у 8-12b слог лучше

Там хотя бы нет синтаксических ошибок. Да, там есть клодизмы и слопизмы, но это не откровенная шиза уровня "ебал ее рука", как ты выразился. Лучше уж потерпеть озорные глазки в тексте, чем пытаться проглотить месиво из несвязанных словосочетаний на русском.

> пытаться проглотить месиво из несвязанных словосочетаний на русском

Так используй нормальную модель, и не будет такого. Начиная с 70б даже чистая ллама может, на 123б мистрале вообще никаких ошибок. Ну и сайнемо экстраординарно хорошо для 12б может в русек. А ты что используешь?

Так в том-то у меня и культурный шок, что ошибок реально мало. Иногда проскакивает не тот род или падеж, но у английских 12b с той же частотой (или даже чаще) ломается разметка или предложение начинается с маленькой буквы. Это мелочи, которые привыкаешь исправлять или игнорировать. Несвязного месива у меня точно нет. И это с температурой 1,25.

А я наоборот думал что обычное порно больше не нужно, но как надрочился на буквы и картинки просто включаю прон и там жанры девки на любой вкус в 4к в 60 фпс и нет ебли с вводом руками

Ну не могу я дрочить на что то вроде "Oh fuck baby! Oh yea!" и т.д. Чувство что я смотрю какое то дешёвое постановочное американское порно с актрисами у которых сиськи набиты силиконом. Теряется для меня та самая ламповая атмосфера. Особенно если ты представляешь всё это себе в голове в стиле аниме. У кого то может по другому, но у меня так. Раньше я терпел, но потом когда стали выходить +- приемлемые модели на русском, то просто перешёл на них и не парюсь.

> несбалансированные модели имеют склонность подсасывать юзеру в любых ситуациях

Все так, тут нужен или оче удачный тюн (чаще общего назначения а не чисто рп) или минимальная шлифовка наиболее близкая к оригиналу.

Про позитивное-негативное выше, это почти обязательное условие если хочешь не просто кумить.

Ну, чувак только дорвался до нейрокума, раньше ему это было недоступно из-за языка-железа или не интересовался. Бедолаги раньше вон на пигме турбе 7б кумили и хвалили, вторая ллама 13б в топах была

> Но в результате ни одна модель больше 22б не оказалась стоящей того.

Если ты "тестировал" с 1.5 токенами то результат вполне закономерен, сюда же база в виде формата. Особенно когда заведомо имеешь тройную предвзятость.

> намержу которая устроит, и на ней что-нибудь запишу

Хорошо, интересно будет глянуть.

> Столько

Здесь всегда хватало бедолаг - адептов 7б и подобных, нытиков за переводы и т.д. Не то чтобы их прямо много, просто наиболее активны и много пишут.

> Лолирую

Уже 1.5 года лолирую со страдальцев, катая исключительно самые большие модели. Офк исключая мусор типа 180 фалконов, 405 лламы и мое-срань. История циклична, так сказать.

>то просто перешёл на них и не парюсь

+100500 всегда приятнее на родном языке

И ценный плюс такого подхода втом, что когда русский юзаешь только для порнухи, то скоро перестаешь путаться и жизнь значительно улучшается.

Всмысле?

Наверно о том что некоторые вещи на русском покоробит писать.

Если непривычен к нейрокуму, особенно на великом и могучем.

>Чувство что я смотрю какое то дешёвое постановочное