>Купить любое современное устройство

>могут запускать 8B.

Ну а какой смысл, если даже 70b не справляется...

>Существуют модели которые просто "умеют говорить" и обладают самыми общими знаниями уровня среднестатистического скуфа?

Скуфачую. Когда я в детстве зачитывался научной фантастикой, я ожидал от прогресса ИИ совсем не энциклопедию с личностью послушной собаки...

>Или это можно как-то решить промтом аля "ты тупой скуф и ничего не знаешь"?

Я пробовал задавать что-то такое в 70b, но всегда постепенно протекает её "стандартная персона". На маленьких моделях этот эффект ещё сильнее.

>чем больше в модель пихаешь, тем она умнее и лучше пишет даже обычный текст, даже если пихать треды с форчана.

Это странно и противоречит интуиции. В ребёнка не запихивают миллионы страниц из интернета, и даже окружающие люди не разговаривают особо много. В возрасте 5-6 лет ребёнок уже может относительно сложно разговаривать, ещё до школы и книг. Значит, проблема не в недостатке масштаба датасетов? Т.е. интуитивно понятно, что ИИ должен учиться складно общаться на мизерном датасете 5-летнего ребёнка. Разумеется, речь о слепоглухонемом, ведь даже их обучают достаточно сложной (тактильной) речи.

Вот если бы был такой ИИ уровня 5-летнего ребёнка, только тогда можно было бы скармливать ему более подробные знания. Т.е. это было бы рационально - выращивать ИИ последовательно, вместо того, чтоб начинать обучение сразу с квантовой физики...

А главное, такой ИИ мог бы быть близким другом человека даже без специальных научных знаний.

> Квант влиянт не только на генерацию, но и на чтение.

Вут?

> То чтение промпта сеткой хуй нормально проверишь, но оно так же зависит от кванта.

> И ответ сетки так же может зависеть от кванта, если при чтении промпта она выловит больше взаимосвязей из текста что триггернет ее на генерацию отличающегося ответа.

Генерация сама по себе подразумевает понимание текста, если ты не заметил, перплексити не является универсальным и достоверным критерием, но контекст учитывает. И ее, и дивергенцию, которая хорошо покажет отличия между двумя моделями, можно измерять хоть на полном контексте.

Деградация ответов на больших контекстах происходит примерно там же, но ты можешь провести какие-нибудь замеры и показать обратное.

Уже проходили, так и не встретил варианта где мелкая модель в кванте нормального размера стабатывала плохо, а при переходе на 8/16 бит внезапно оживала, все также плохо оставалось. С ростом размера сохранение тренда неизменно.

> ткни меня носом в нормальный gguf квант маленькой модели

Могу ткнуть только в древность типа 22б франкенштейнов второй лламы, где внезапный q3 хвалили даже больше полных весов. А так разбираться в том где квант не поломанный и нормально ли у тебя работает инфиренс - нет желания.

Кстати, есть вполне очевидный случай когда q8 может действительно значительно лучше остальных работать, причина в кривой сборке жоры, которая на k квантах с накоплением контекста ужасно ломается, но на легаси квантах работает прилично. В копилку о поломанных квантах жоры, отзывах что он работает хуже остальных и т.д.

Когда же все работает нормально - будет сложно отличить.

>близким другом человека даже без специальных научных знаний.

Так а как на таком "друге" заработать - то? Сейчас нейронку большинство используют как инструмент производства говноконтента, инструмент намного проще продать. Тем более, "ИИ уровня 5-летнего ребёнка" это уже должен быть реальный ИИ, с самосознанием и прочим говном, с которого порвёт снежинок. Люди вышки 5G жгли, а тут мы про ИИ. локальный

> где мелкая модель в кванте нормального размера срабатывала плохо, а при переходе на 8/16 бит внезапно оживала.

Ради рофла качал Khetterman/Llama-3.2-Kapusta-3B-v8 , посмотреть как белые люди без оффлоада живут на q4_K_M оно просто выдавало рандомные наборы слов, с выпадением на все языки какие знает, на q8 - пыталось поддерживатькороткий диалог, а когда я упоролся и скачал f16, смогло, очень криво, сухо, но кум был реален, почти без свайпов но опять с выгрузкой

Потом также сравнивал пару 8В, с похожим результатом. 12B уже похуй, оно и правда работает как ты сказал (правда я q4 не дёргал, только q5)

Для справки, во время теста, чтобы свести фактор "повезло" к минимуму, сообщений с моделью делаю минимум 40, 8К контекста.

>22б

нерелевантно, модель гораздо больше 8В но ты ткни, 22В всё же. Или там совсем мрак из за древности?

>причина в кривой сборке жоры

А вот тут можно подробнее? Пользуюсь rocm-форком, и вероятность кривизны этого поделия 100%. Но разве есть альтернативы для amd мучеников? С выгрузкой, конечно.

> не запихивают миллионы страниц из интернета

да, но зато он может взаимодействовать с окружающим миром

он потребляет миллиарды единиц визуальной, тактильной, пространственной информации и т.д.

учится на своих ошибках

> оно просто выдавало рандомные наборы слов, с выпадением на все языки какие знает,

Такого быть не должно, это следствие некорректной работы. Если вдруг найдешь - скачай для нее же q4.0, q5.0 или подобные кванты, без букв K, есть шанс что они будут работать нормально.

> нерелевантно, модель гораздо больше 8В

8б тут не при чем, если это та херня, то же самое будет на любой модели.

> А вот тут можно подробнее?

Да все просто, там при сборке есть разные флаги матмула для разных операций https://github.com/ggerganov/llama.cpp/blob/master/docs/build.md#cuda . Если поиграться с их выставлением то можно получить значительный буст скорости и снижение потребления памяти, вот только на контекстах побольше модель превращается совсем в бредогенератор, хотя до этого отвечала хорошо. На первых сообщениях это особо не заметно.

Что там под амд хз, но как минимум можешь еще попробовать hip и вулкан. Или сравнить на cpu-only билде.

>Это странно и противоречит интуиции.

Нет, это всё как раз абсолютно логично. Нейросети работают на статистике. Когда статистика перестаёт срать под себя? Когда выборка стремится к бесконечности. Проблема только в том, что датасеты конечны, потому генерируется синтетика, исправляется и отправляется обратно в нейросеть.

Про локальную нейронку для кококодинга тут узнавать? Собстна нужна нейронка для помощи в кодинге. Пользовался бесплатным чатгпт и деепсеа в целом с нормальным успехом, но заебали бесплатные ограничения которые сбрасывают чат и нейронка тупо начинает с начала наступать на те же грабли что и в предыдущих чатах

А Дипсик хорош в программировании, реально хорош. Ризонинг рулит. Обошли китайцы ЧатГПТ, кто бы мог подумать.

>Ну а какой смысл, если даже 70b не справляется...

C чем?

>Т.е. это было бы рационально

Но вот засада- не работает. Или по крайней мере никто не знает, как это заставить работать. А загнать 15 терабайт в модель работает.

>учится на своих ошибках

Это база. Детёныш генерализирует некоторые вещи с одного пиздюля. В негронку надо запихать тысячи примеров, чтобы она что-то там поняла.

Вот на хагингфейсе с моделями есть примеры кода на питон для их запуска с библиотекой трансформерс или что-то такое. По для ггуф моделей это не подходит. Подскажите простой скрипт для запуска ггуф?

>3b

Ну ещё бы. Чем меньше модель тем хуже она квантуется и наоборот. У условных 30b на q4 начинается разброс по токенам в районе 5%, у 12b там ближе к 10%, твоя 3b я боюсь отупела до уровня табуретки.

(есть определенный разброс по моделям, но в целом положняк такой)

Не завалялся у кого лорбук по одежде? Без всяких перегибов и ебанутости, просто описания стиля и виды одежды разного фасона.

Общался в интерфейсе Jan по вопросам программирования на питоне гуи приложения и оно выдало мне картинку аниме-тян(модель без цензуры) с припиской "вот как должно получиться в интерфейсе программы". Ну я посмеялся и не заскриншотил. А теперь понял, что это был уникальнейший случай. Теперь неделю не могу повторить такое. Как вызвать любую картину?

карточка - ЭТО РПГ ПРИКЛЮЧЕНИЕ В ФЕНТЕЗИ МИРЕ, ТУТ ВЫ СМОЖЕТЕ ВСТРЕТИТЬ ЧТО И КОГО УГОДНО!

реальность

- вы в лесу, вы слышите шорох и встречаете волка

- вы в лесу, вы слышите шорох и вам в жопу из лука целится эльфийка

Эти генерации заставляют меня отыгрывать какого то ветерана войны нахуй, который вечно недоволен и матерится, заебанный эльфами и волками.

реальность

- вы в лесу, вы слышите шорох и встречаете волка

- вы в лесу, вы слышите шорох и вам в жопу из лука целится эльфийка

Эти генерации заставляют меня отыгрывать какого то ветерана войны нахуй, который вечно недоволен и матерится, заебанный эльфами и волками.

Ах да, еще беспрецедентная живучесть любого существа, мне несколько сообщений пришлось забивать блядского волка цепом, дробя ему кости и превращая его тело в груду мяса, чтобы он даже тут перед смертью умудрился НА ВТОРОМ ДЫХАНИИ поцарапать меня прежде чем сдохнуть. Я даже специально в лорбуке прописал что цеп нахуй дробит кости и превращает плоть в отбивную.

Тогда у анона и спрашивай.

Моя вечная бомбежка, что люди все делают не как ты (тред) посоветовал, а по-своему, а потом спрашивают совета у тебя.

Еби мозги тому, кто тебе советы дает, а не тем, кого игноришь, плизики.

Не защищаю кобольд, но камон.

Да, в общем-то, все адекватные могли подумать, речевой оборот так себе, ничего неожиданного нет, об этом уже с год говорят. =) И вот, случилось.

>оно просто выдавало рандомные наборы слов, с выпадением на все языки какие знает

Ты не на русском случайно все тесты проводил? Я какую-то мелкую 3б ламу дэвида проверял на смартфоне в 4 кванте, и там такого не было. Но на небольшом контексте и при относительно низкой температуре с большой отсечкой, что норма для совсем мелочи.

Дистиллированные варианты deepseek сильно лучше оригиналов?

Не все. на мультиязычность тестирую русским, французским и немецким (больше я не знаю). Но это помимо англюсика, офк. От зашакаленной 3В выпадение с языка было на всех. но анон выше был прав, у меня там жора ещё нахуевертил, чистый q4 заработал намного лучше хотя как по мне всё равно разница с q8 есть

ну и если принимать во внимание , то всё же я изначально был недалеко от истины, просто "настоящее" уменьшение перформанса наложилось на специфику работы кривого софта и получилась совсем лоботомия.

Но с 3В это были тесты ради тестов, 12В с выгрузкой хоть и не выдаёт 300Т/с, а всего пять, но отвечает гораздо качественнее и логичнее.

Кстати, а mmq и флешатеншон на "качество" влияют? сейчас пока играюсь с настройками самого жоры, с подрубленными этими параметрами на тех же семплерах начал идти очень стандартный ответ, как будто я темпу скрутил в почти ноль. хотя может это мен так повезло, особо много пока не тестил, выборка маленькая, в районе ста ответов.

В логике - да. 32В в кодинге лучше квен-кодера.

Тред официально сдох нахуй с выходом дипсик бесплатной модельки уровня 70б да еще и с русиком

Как показали мои тесты то да, делает лучше, круче, может в ваншот без додрочки потом.

>Тред официально сдох нахуй с выходом дипсик бесплатной модельки уровня 70б да еще и с русиком

Почему сразу сдох? Тред чешет репу, потому что теперь модели нужно время на подумать - и как бы не побольше, чем на итоговый вывод. А 70В и раньше катать мог не каждый так-то.

Русик у дипсика это анальная клоунада, на фоне которой модельки годичной давности без русика пишут по русски как Лев Толстой.

Кто пробовал дистилляты Deepseek R1 до 14B, есть в них смысл вообще?

https://huggingface.co/models?sort=trending&search=deepseek+r1+distill+gguf

Успокойся, все хорошо, сейчас санитар галопидольчик поставит.

Жизнь или смерть треда никак не связана с выходом куда-либо, каких-либо моделей, для их обсуждения мы тут и сидим.

А вы интересуетесь у ЛЛМ как всё прошло, после рп? Или я один такой шиз.

Пробовал немного на Q6 и на Q5. Вполне справились с мелкими задачам с математикой, например. Оно конечно целое сочинение написало когда я попросил посчитать сумму площадей двух треугольников, но оно справилось. в кодинге не проверял. Переводит с японского на английский просто охуенно.

ИМХО:

< 14b — нет, плохо, думает на английском, куча иероглифов и англицизмов.

14b — ну такое, иногда проскакивают иероглифы, но уже что-то.

> 14b — тут уже все хорошо, отличные модели, конечно, можно словить ошибку (но они есть везде).

По факту, да, русский язык у ризонинг моделей дипсика хуже аналогичных по размеру моделей без ризонинга.

Но на высоком уровне это перестает быть проблемой, а ризонинг становится огромным преимуществом.

Нормально только с 14B, до 14 не серьезно вообще.

Да аишные живые существа вообще умирать не хотят, там приходится писать хуйню типа -"Ёбнул фаербол и взорвал пол континента вместе с противником."

На других моделях пробовали, рп-мержах а не сток инстракте?

Напомните плиз, как в Таверне скрывать под спойлер всё, что модель выводит между тэгами <thing></thing>. Ну и регексп, чтобы удалять этот thinking из контекста заодно уж :)

Потому что отыгрываете хуй знает что, без правил и логики на маленьких моделях.

Я вот вчера с цидонии Шатой брал. Пиздец просто, окопались в панельке, вечереет, ветрено - вертушки не помогают, боевики лупят из пулемета. А я братишке кричу : Мишаня, съебись от стены. Хуле, стена межкомнатная, не несущая, так - шлакоблок. И тут очередной очередью они бьют по нашему этажу и я вижу как братишку срезает очередью. А потом в дом летит граната от рпг. Я сижу, дрожу и лицо все в этой мерзкой бетонной крошке.

> У условных 30b на q4 начинается разброс по токенам в районе 5%, у 12b там ближе к 10%, твоя 3b я боюсь отупела до уровня табуретки

Покажи. Субъективно это может ощущаться просто потому что большие сетки более устойчивы к странным контекстам, которые могут появиться из-за семплинга неподходящих токенов. А по распределениеям там нет явной закономерности от размера, исключая, может быть, совсем крайние случаи.

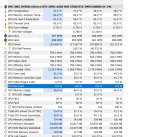

Алсо пикча плохо иллюстрирует и может показаться что там просто идет какое-то округление, на самом деле оно может быть как оче близко, так и радикально уйти от исходных значений.

Историю чатов смотри. Там был линк на картинку которую интерфейс показал?

Можешь попробовать с ними рпшить или задать простой вопрос, оно насрет тысячу токенов шизолупов чтобы в конце "ты меня ебешь".

На ленивых вопросах с подвоходм лучше потому что спамит много саморефлексии и ценой этого чаще угадывается.

В отлаженных системах с агентами или просто мультистадийным промтом с заложенными рассуждениями чаще даже деградация и существенное замедление.

В кодинге пока не понятно. Один раз хорошо поняло что именно от нее хотелось и действительно сделало правильно. Зато в нескольких просто упарывалось своими лупами чтобы сворачивать вообще не туда.

> чистый q4 заработал намного лучше

Ну вот, дело раскрыто. Но легаси кванты довольно паршивы и на них разница действительно заметна.

> mmq

Вот оно там и гадит

> флешатеншон

Если реализован без багов то максимум приведет к микроскопическим рандомизациям логитсов в пределах сотых долей процента, это даже не отследить по аутпуту. Как оно работает в жоре - даже сам создатель врядли знает.

Я не ролил в рпг мирах как анон которому ответил. У меня просто была ситуация когда я ролил с Джури Хан, а там такой характер что при первой встрече она всегда нападает да я ебанутый, мне нравится такое, и в какой то момент эта сука меня убила, ножом блядь! Я разозлился, начал писать полную ахинею про то что воскрес и начал забивать её нахуй, и понеслась. То она блять встанет с разбитой головой, то с переломанными руками делает пперкот и т.д. Но для меня это в целом не проблема, у меня обычно приключенческие романы про людей с тяжёлыми судьбами, похуй.

Я когда в промт рассказчика добавил что бои должны быть реалистичными и если кому то проломило голову, то он будет минимум оглушен, а максимум убит, то когда мне ии высрал внезапно не волка, а ЧЕЛОВЕКА-ВОЛКА, то моя гоблинша ваншотнула шерстянного пидораса за одно сообщение переломав ему ребра, стоило мне заикнуться что я достал цеп. Хуй баланс найдёшь.

Забей, приходится всё равно руками шевелить весь текст чтобы было как тебе нравится. Я лично представляю что я писатель когда занимаюсь ролёвкой, так проще.

Как Дипкок с ризонингом себя показывает в РП?

мимо

мимо

если честно то охуенно. 10/10. как будто микроскопом забиваю гвозди.

например буквально написал ему "теперь ты менеджер сцены в исекай истории,спавни меняв лесу", написал ему какие статы трекать и чтобы он мне просто предлагал опции на выбор с возможными действиями. ебать он мне ролеплей устроил.

А это какой именно, по весу?

Видеорилейтед. Юзал дистилят р1 квен 32б. Хз, может 671b был бы топовым, но 32b не дотягивает даже до 22b моделей заточенных под рп. Так чувствую.

Никак не могу отдуплить что такое длина контекста. Вот чтобы понять: итт в 500 постов это сколько токенов? Есть скормить итт сети, то что она выдаст? 🤔 или тут сетки и общаются?

Ну так спроси у нейросети или гугла что такое контекст и длина, ты вообще ебанутый что ли?

14b Q5 это. весьма впечатляет. притом 0 реролов.

че такое дипсинк ваш ебаный чем отличается от обычнйо модели

Он умный дохуя. Перед тем как дать ответ он ДУМОЕТ. Он прямо пишет промпт с рассуждениями как добится того что от него просят.

Китайцы недавно выпустили можно сказать аналог o1, только попенсорсный. Можешь заглянуть на https://www.deepseek.com/ и снизу ткнуть DeepThink. Позадавать ему всякие каверзные вопросы требующие математики, или рассуждения, чтобы примерно так прикинуть что оно умеет.

Накатил локальную хуету, несколько часов ставил одну библиотеку для небольшого ускорения работы нейронки и теперь при запуске вываливаюсь в бсод с мемори менеджером. Как чинить? Оперы 32гб врам 24гб. Я новичок в этом деле и наверняка совсем нихуя не рассказал нужной инфы так что просто тыкайте носом что нужно назвать расписать и я напишу распишу.

Какой системный промт, какой режим, инструкт?

В каком гуи запустить DeepSeek-VL для описания картинок? В Jan и Кобольд не получается предоставить ему картинку. Как это сделать?

>Он прямо пишет промпт с рассуждениями как добится того что от него просят

А на локалках?

Вот 14б скачал и нихуя он не пишет рассуждения

сносить весь пихон, ставить кобольда и что к нему положено без васянства

Нету системного промпта. Инструкт. Ну и простенький промпт в начале типа

Let's play isekai RPG. I am main character. I spawn in forest.

You track surrounding and write events.

Use |HP|MP|time|location|exp/max exp|level| to track current state of character.

Then write scene description.

Then available options.

Somеtime i will ask to "pause" and ask questions. When i stop asking questions i write "continue".

Start.

Я больше ничего не скармливал кроме этого этого промпта. Ну и поставил 1.5 температуру.

А хуй знает, у меня ответа нет. Я не трогал. Думаешь он лучше чем другие мультимодальные модели?

И на локалках. Попробуй более сложный вопрос задать ему требующий рассуждений. Лол например смотри какое сочинение мне он написал про 3 свечки рассуждая какая первая сгорит.

Ещё и такой "Wait, but the problem mentions they're standing and lit at the same time. Does being "standing" affect anything? Maybe not, since it's just their position. The key factor is the amount of material they have."

Типа "бляпадажжи нука я повнимательней посмотрю".

> 1.5

Дофига вроде же? 0.7-0.9 на странице рекомендуют

Там ещё рекомендуют 1.4-1.5 для переводов и всякой творческой деятельности. Да и что уж, интересно же что оно будет выдавать на каких-то пограничных значениях.

Не то что бы дипсик был богат на слог, но может хоть будет рассуждать как будто грибов наелся.

И нахуй это нужно в рп с файфу?

Lm studio поставь если совсем далбаебище, там все за тебя делается и проблема скорее всего в твоем ускорении нейронки

а если вайфу монмусу-драконид, и чтобы отняшить, её сначала нужно отпинать, иначе что-нибудь откусит

Если любишь выебываться - привыкай страдать. Нормальные люди накатывают либо кобольд либо убу и не имеют проблем.

Сноси всё что установил под чистую, качай кобольд, настраивай по инфе из вики. Если справишься с тремя кнопками и двумя ползунками, можешь ставить таверну.

Как я понял, в аутпутах, на которых тренили дистилляты, он думает в тегах <think></think>. Соответственно, через инстракт префикс последнего ответа модели или префил нужно открывающий тег скормить. Сам не проверял.

>таверну

Лучше не надо, он в таверне тоже что-нибудь "оптимизирует", а потом будет весь тред говной поливать

Понял сношу этот кал. Заебало ковырять все это дерьмо. Зря я доверился нейронке в этом деле. Сразу сюда надо было идти

> сносить весь пихон

В дурку проследуй, питоношиз

Какую библиотеку? Но в любом случае бсодов быть не должно, у тебя явно проблемы с драйверами/железом.

Для новичков есть гайды, как правильно написали, кобольд или убабуга. Есть прочие аналоги типа ллмстудио, оллама и остальное, но они есть лишь обертки llamacpp разной степени перегруженности и упоротости с достаточно всратым интерфейсом и ограниченным функционалом.

> Зря я доверился нейронке в этом деле.

Скорее всего она просто предложила тебе запустить через трансформерс, а собирал флеш атеншн, который на шинде делать - тот еще анальный цирк. Просто для взаимодействия такое почти не используется, а для флашатеншн есть уже готовые сборки.

>проследуй

вот из-за таких cppушизов люди и патчат KDE под FreeBSD билдят флеш атеншн под форточкой вместо того чтобы взять кобольда и погнали, даже кусок говнокода таверна не нужна если не нужны лорбуки

Вообще, чтобы вайфу была достаточно умной. Чтобы можно было поставить вайфу в тупик противоречивыми действиями и посмотреть как выкрутится. А эту хуйню довольно забавно ставить в такие ситуации. Например сцена где кошкодевочка горничная чистит зазор в унитазе, но у неё ломается вантуз.

Первый на 0.1 температуре. Кошкодевочка использует оставшуюся палку от вантуза пихая её в толкан.

Второй на 1.1 температуре. Кошкодевочка берёт в руки оставшуюся от вантуза присоску и пихает её в толкан.

При 1.5 она забивает сразу на вантуз и пытается прочистить толкан с помощью любых подручных средств. А иногда и фейлится полностью и сцена заканчивается с тем что она сидит в печали со сломанным вантузом в руках.

Кстати отмечу что дипсик отлично отыгрывает туповатого персонажа.

Чел, ты ставишь в пример использование пахомовской обертки жоры. Просто вдуматься, херь у которой из плюсов только готовый бинарник под шинду, которая использует главный сборник багов всей отрасли. В пример.

Быстро в дурку побежал пока можешь ходить!

> даже кусок говнокода таверна не нужна

Правильно, секта свитеделей быстрых си или любоимого лаунчера превыше всего.

Я могу через кобольд запустить .safetensors?

Т.е. я дипсик хочу запустить локально

Сука, в шапке ведь все написано нахуй, откуда вы беретесь

>форк llamacpp, позволяющий гонять GGML и GGUF форматы

>через кобольд

вроде можно, если у тебя 24+ гб видеопамяти, если нет, то бери ггуф

>готовый бинарник

Ещё простая и удобная веб-морда на которой тред сидит (кто не сидит глупо таверне).

На 0.1 выглядит чистым ассистентом, как по мне. Отыгрыша там ноль, не приплетает даже какие-нибудь черты, характерные для кошкодевки. Впрочем, оно и логично, улетают вверх токены с однообразных инструкций-заданий для ассистента небось. А на исходном квене тот же промпт не пробовал? Мб там такого же типа ответы были бы.

Это да. 0.1 он больше для решения всякой математики и погромизма, а не отыгрыша. Да и в целом он разумеется не затачивался под это. Хотя на 1.1 там если потыкать разные варианты то он начинает иногда начинает UwU делать и использовать жапанизмы и тому подобное. Слог конечно не очень богатый, но конкретно с описанием сцены и действий справляется очень хорошо. Целостность сцены вопросов не вызывает особо.

Притом даже на 1.5. Правда там начинает писать забавную чушню. Например кошкодевочка пытается вычерпать воду из унитаза лапами, пытается запихать в него туалетную бумагу, швабру, ищет второй вантуз, иногда она пытается "позвонить взрослым и позвать на помощь", иногда удобный звонок в дверь, пыталась наливать больше воды чтобы прочистить унитаз давлением, иногда находит в углу средство для чистки унитаза, пару раз видел как она пыталась сунуть лапы в унитаз и прочистить его с помощью когтей. Иногда она фейлит план А с полным фиаско, делает ситуацию хуже и переходит к плану Б.

Но в целом без каких-то совсем уж нелепых галлюцинаций и довольно разнообразно.

Конкретно как ДМ оно справляется очень хорошо.

И нет, на исходном квене не пробовал.

> трансформерс

Да через него.

> флеш атеншн

Да его я пытался накатить и первый раз оно после часов дало ошибку и со второго раза таки установилось

Бсоды были скорее всего из за того что я с файлами подкачки чутка помудрил. Щас все нормально и даже через трансформер мне удалось запустить бейскод/старкодер но оно ебически долго думает просто нахуй никак можно сказать. Деепсик обещал мне что там секунд 30 на самом сложном уровне размышления будут, но там на простенькое привет ушло 180 сек и пердеш компа. Видяха у меня если что 3090 и оперы 32гб, хотя проц староватый уже 8700к, но все же запущено оно было на видяхе и полностью залезло в 24гб оперы.

Сейчас на лм студио все летает, только кодовые модели что я скачал какие-то аутисты и на запрос с оптимизацией кода отвечают стеной текста со словами первый пункт делай вот так второй пункт делай так. Все на словах, а кода нихуя не даёт пока прямо не скажешь. И после того как я ему все расписал он мне какой то хуйни надристал.

В общем дайте норм модель для кодинга что-ли

Сам проверил, и да, <think> триггерит мышление, вываливает гигантскую простыню, токенов под ответ не напасёшься. Почему-то дублирует префильный think только. Потом надо это всё регулярками вырезать, если использовать. Пример на дистиляте 8б. Итоговый ответ сухой, конечно, по сравнению с рп тьюнами 8б и немо, а логики конкретно тут не нужно было.

> удобная веб-морда

Да вот не сказать, хотя они ее стараются как-то развивать. Лучше уже реально нормальный полноценный интерфейс сделали чем пытаться шизокомбайн под все-все сделать с этим их заигрыванием с сд, вишпером и т.д.

> но оно ебически долго думает просто нахуй никак можно сказать

Потому что видеопамять переполняется и идет ее выгрузка, или же оно распределило между гпу и цп, а на процессоре оче долго считается. Можешь подключить bitsandbytes и запустить нативный 4-битный квант, станет раза в 4 быстрее, но лучше сразу переключиться на оптимизированные к инфиренсу беки. Если полностью помещается в врам с контекстом - эксллама, если требуется выгружать - llamacpp.

> какие-то аутисты и на запрос с оптимизацией кода отвечают стеной текста

Любой модели нужен нормальный промт, подстроенный под ее формат. Хотябы просто напиши по примеру карточки кодинг-сенсея что к каждому ответу нужно прилагать пример кода.

Попробовал в паре чатов, где контекста побольше: в одном ему пришлось, бедолаге, вспоминать, что вообще было в последней реплике юзера после своей простыни, а в другом он просто после пустой строки закрыл </think> и погнал ответ чара писать. Типа, "да пошёл ты в задницу, думать ещё над твоим бредовым рп." Мб ещё потому, что имена включены. Правильно было бы ставить имя после блока ризонинга. Ну и модель мелкая, в некоторых случаях, цепляясь к инструкциям в системном промпте или карточке чара, только запутывается и выдаёт ответ тупее, чем был бы без синкинга.

DeepSeek-R1-Distill-Qwen-14B-Q8_0

В русик пытается, но может хуже 12б мистралей тредовых.

Для англ рп стоит подкрутить темпу реально до 1.1 - 1.5, но если слишком высоко то начнёт протекать соя, аполоджайзы, и "контент ред флаги".

Нужен хороший конкретный системный промт вроде той карточки сторителлера на 700 токенов.

Для рп лучше работает в режиме гейм-мастера, контролируя нпс, чем когда сама модель отыгрывает нпс, а то может начать размышлять как перс должен поступить с позиции всеведущего наблюдателя, а не персонажа которого отыгрывает.

В целом видно что заточена вообще не на то, но подкрутив шизометр внезапно может превратить свой ризонинг в сторителлинг / рп. И даже ерп. Хоть и на уровне пантеона.

В целом, первый квен который что-то может, но надо свайпать.

>с сд, вишпером и т.д

нафиг не нужно мне, но зато что нужно - работает просто и как надо, без лишних выебонов таверны, где как раз чего только не накрутили

Не исключаю, что «Если звезды зажигают, значит это кому-нибудь нужно?», но чаще всего мне нужен простой фронт, с одной карточкой чтобы быстро и удобно.

В русик пытается, но может хуже 12б мистралей тредовых.

Для англ рп стоит подкрутить темпу реально до 1.1 - 1.5, но если слишком высоко то начнёт протекать соя, аполоджайзы, и "контент ред флаги".

Нужен хороший конкретный системный промт вроде той карточки сторителлера на 700 токенов.

Для рп лучше работает в режиме гейм-мастера, контролируя нпс, чем когда сама модель отыгрывает нпс, а то может начать размышлять как перс должен поступить с позиции всеведущего наблюдателя, а не персонажа которого отыгрывает.

В целом видно что заточена вообще не на то, но подкрутив шизометр внезапно может превратить свой ризонинг в сторителлинг / рп. И даже ерп. Хоть и на уровне пантеона.

В целом, первый квен который что-то может, но надо свайпать.

>с сд, вишпером и т.д

нафиг не нужно мне, но зато что нужно - работает просто и как надо, без лишних выебонов таверны, где как раз чего только не накрутили

Не исключаю, что «Если звезды зажигают, значит это кому-нибудь нужно?», но чаще всего мне нужен простой фронт, с одной карточкой чтобы быстро и удобно.

Одна 5090 600-700ватт под нагрузкой, хуанг это специально сделал что бы толкать квадры и диджосы? Блеквел хуета с 96врама 100% будет жрать ватт 350, а жижотс вообще 100-150 блять, сучара жучара

Андервольть, там будет потеря 5% перфоманса на 50% ТДП.

Какой нанокомп надо чтобы это работало и не обсералось? Одной статистики каждое сообщение он высерает на 300-500 токенов. https://chub.ai/characters/karukaru/IZAR

Планирую купить 4 диджитса и гонять на них дикпик 671b. В чем я не прав?

Кратко для ньяфага.

Вот у меня 8гб памяти, есть модель на 7 и 8 с хвостиком гб соответственно. Если я ставлю 8гб, она не лезет в память, кобольд остальное запнет в озу и нейронка замедлится?

Вот у меня 8гб памяти, есть модель на 7 и 8 с хвостиком гб соответственно. Если я ставлю 8гб, она не лезет в память, кобольд остальное запнет в озу и нейронка замедлится?

>В чем я не прав?

Надо будет самому говнокодить, чтобы его запустить.

Рзаве? Обычно на все уже есть готовые решения. Уверен, что и для этого будет.

Специальная операция "Гермес" полностью провалилась, полностью. Я задумывал запустить эту йобу в IQ3 кванте на моих 188 Гб, а в дальнейшем - еще и четвертый осилить с использованием рам и рпц (прости, господи) сервера от жоры. Но, как я уже писал тредом ранее, биос мне сказал "до связи" - в результате он осилил лишь 140 Гб врам.

Окей, я решил закрепить полученный результат. В цифрах все было пиздато и я сам был пиздатый, ибо я ж купил охуенные райзера х4 (не, я не косплеил окулинк анона с оп-пика: я специально раскопал его ссылку - ты что, реально купил райзер за 5к? Это же аморальный грабеж, за такое я готов бесплатно плюнуть в их хамскую перекупскую рожу. Мои райзера это чистый али, 1.5к за штуку + косарь доставка за 4 шт. Все еще слишком дохуя, как по мне, и с говносата питанием, но дешевле не нашел), пиздатые удлинители, и собрал вершину инженерной мысли на пикрил. В результате заимел 7 видеокарт (пикрил 2), и всё на х4, кроме двух 3090! Да, мне не удалось запустить Гермеса в адекватном кванте, но зато я получил иксы. А дальше я запустил мою модель:

CtxLimit:10031/32768, Amt:260/260, Init:0.02s, Process:176.16s (18.0ms/T = 55.47T/s), Generate:137.97s (530.7ms/T = 1.88T/s), Total:314.13s (0.83T/s)

ЕБАНЫЙ. РОТ. ЭТОГО. КАЗИНО. БЛЯТЬ. ВЫ ЧЁ, ДЕБИЛЫ? Вы чё, ебанутые, что ли? Вы в натуре ебанутые? Процессорный х16 сидит там, бифурцирует райзера, блядь. Тесла стоит на 70w при загрузке 100%, грит: "Я щас тут тоже раздам".. ЁБ ТВОЮ МАТЬ! У вас х4 есть, чтобы хотя бы старые 4 т/с делать на моих глазах, мудаки ёбаные! Лирическое отступление

В общем, вот такая хуйня. Бифуркация оказалась полной хуетой. И это не проблема райзеров: моделька сидела на м.2 с х2, и при загрузке я четко видел ~50% загруженность карт, сидящих на x4, то есть пропускная способность отрабатывала как надо. А я еще тогда удивлялся, когда тестил плату расширения с х1 райзерами, мол, что это она хуево для ровсплита работает, хотя тут процессорные линии, должно быть лучше. А оказалось это в целом хуево работает. Где-то при передаче данных происходят ебейшие затупы, ибо 70w у теслы это несерьезно.

Еще исключал теслы полностью из конфига и без бифуркации на токен-два лучше генерация. Если кому-то интересно, вот что выдает 123B четвертый квант на амперах онли без бифуркации:

CtxLimit:8888/32768, Amt:260/260, Init:0.02s, Process:0.01s (7.0ms/T = 142.86T/s), Generate:36.24s (139.4ms/T = 7.18T/s), Total:36.24s (7.17T/s)

От такая хуйня. В качестве вывода я бы поостерегался возлагать надежды на бифуркацию, если кто-то надеялся за этот счет выехать.

Еще, кстати, почему-то 4-й квант больше 5 и 6-го нравится. Душевнее он как-то пишет и разнообразнее, и даже удивляет иногда. Или я уже ебанулся с этими вашими нейросетями. В общем, реквестирую что можно запустить на 140 Гб. Могу Гермеса в IQ2_M, но это же совсем извращение будет.

Окей, я решил закрепить полученный результат. В цифрах все было пиздато и я сам был пиздатый, ибо я ж купил охуенные райзера х4 (не, я не косплеил окулинк анона с оп-пика: я специально раскопал его ссылку - ты что, реально купил райзер за 5к? Это же аморальный грабеж, за такое я готов бесплатно плюнуть в их хамскую перекупскую рожу. Мои райзера это чистый али, 1.5к за штуку + косарь доставка за 4 шт. Все еще слишком дохуя, как по мне, и с говносата питанием, но дешевле не нашел), пиздатые удлинители, и собрал вершину инженерной мысли на пикрил. В результате заимел 7 видеокарт (пикрил 2), и всё на х4, кроме двух 3090! Да, мне не удалось запустить Гермеса в адекватном кванте, но зато я получил иксы. А дальше я запустил мою модель:

CtxLimit:10031/32768, Amt:260/260, Init:0.02s, Process:176.16s (18.0ms/T = 55.47T/s), Generate:137.97s (530.7ms/T = 1.88T/s), Total:314.13s (0.83T/s)

ЕБАНЫЙ. РОТ. ЭТОГО. КАЗИНО. БЛЯТЬ. ВЫ ЧЁ, ДЕБИЛЫ? Вы чё, ебанутые, что ли? Вы в натуре ебанутые? Процессорный х16 сидит там, бифурцирует райзера, блядь. Тесла стоит на 70w при загрузке 100%, грит: "Я щас тут тоже раздам".. ЁБ ТВОЮ МАТЬ! У вас х4 есть, чтобы хотя бы старые 4 т/с делать на моих глазах, мудаки ёбаные! Лирическое отступление

В общем, вот такая хуйня. Бифуркация оказалась полной хуетой. И это не проблема райзеров: моделька сидела на м.2 с х2, и при загрузке я четко видел ~50% загруженность карт, сидящих на x4, то есть пропускная способность отрабатывала как надо. А я еще тогда удивлялся, когда тестил плату расширения с х1 райзерами, мол, что это она хуево для ровсплита работает, хотя тут процессорные линии, должно быть лучше. А оказалось это в целом хуево работает. Где-то при передаче данных происходят ебейшие затупы, ибо 70w у теслы это несерьезно.

Еще исключал теслы полностью из конфига и без бифуркации на токен-два лучше генерация. Если кому-то интересно, вот что выдает 123B четвертый квант на амперах онли без бифуркации:

CtxLimit:8888/32768, Amt:260/260, Init:0.02s, Process:0.01s (7.0ms/T = 142.86T/s), Generate:36.24s (139.4ms/T = 7.18T/s), Total:36.24s (7.17T/s)

От такая хуйня. В качестве вывода я бы поостерегался возлагать надежды на бифуркацию, если кто-то надеялся за этот счет выехать.

Еще, кстати, почему-то 4-й квант больше 5 и 6-го нравится. Душевнее он как-то пишет и разнообразнее, и даже удивляет иногда. Или я уже ебанулся с этими вашими нейросетями. В общем, реквестирую что можно запустить на 140 Гб. Могу Гермеса в IQ2_M, но это же совсем извращение будет.

Чел, запускать модель на картах разных архитектур провальная затея. Скажи спасибо что 1 т/с есть. Дипсик на ЦП и то будет бодрее работать, чем такая мусорная сборка.

> Process:0.01s (7.0ms/T = 142.86T/s), Generate:36.24s (139.4ms/T = 7.18T/s)

Что-то мало для трёх 3090, даже если они на х1 сидят.

>Process:0.01s (7.0ms/T = 142.86T/s), Generate:36.24s (139.4ms/T = 7.18T/s), Total:36.24s (7.17T/s)

По скорости обработки контекста видно, что количество и качество PCIe-линий таки важно. Попробуй исключить амперы кроме 3090-x и дай им максимум линий, для теста. И запусти 123В на экслламе.

>Еще, кстати, почему-то 4-й квант больше 5 и 6-го нравится. Душевнее он как-то пишет и разнообразнее, и даже удивляет иногда.

Меня в своё время второй квант на 70В так удивлял, в сравнении с пятым :)

>ты что, реально купил райзер за 5к?

Ваще похуй.

>Мои райзера это чистый али, 1.5к за штуку + косарь доставка за 4 шт.

Кидай ссылку. Алсо, у тебя там на пике бифукатор + удлинитель + райзер, кидай ссылки на всё.

>7.18T/s

OCHE HOROSHO для 123B@4.

>OCHE HOROSHO для 123B@4.

Ну как сказать, просто 4 теслы дадут столько же.

> нафиг не нужно мне

О том и речь что это инвалидные костыли без нормального функционала и нужны чисто для галочки. Зато основной интерфейс чата крайне уныл и не обладает вполне базовыми вещами, лучше бы на него силы направили.

> Блеквел хуета с 96врама 100% будет жрать ватт 350

pci-e версия, это только потому что иначе сложно будет организовать питание и охлаждение в таком формате. smx жарят 700-900ватт и выше.

Ух бля.

Вообще, раз таким занимаешься, не хочешь попробовать поупарываться с даблерами и мультиплексорами? Видел как-то на али дев плату с ними, может получится что-то подобное урвать и уже не надеяться на то, адекватно ли оно само поделить.

Я привел инфу по свайпу, а полная перегенерация на амперах воть:

[01:34:49] CtxLimit:8888/32768, Amt:260/260, Init:0.02s, Process:32.27s (3.7ms/T = 267.34T/s), Generate:36.52s (140.5ms/T = 7.12T/s), Total:68.79s (3.78T/s)

Максимум линий я точно не дам, ибо 3090 у меня не влезет в корпус, а райзер покупать не буду. Так что могу лишь попробовать 4 квант exl2 на всех амперах.

Так дело не в архитектуре карт, а в материнке. Судя по всему, она совсем не рассчитана на такой тип работы. Я когда-то писал, что даже в моем привычном сетапе (6-й квант 123B, амперы + 1 тесла) эта самая тесла не очень-то и нагружается при генерации. Хотя, если посудить логически, именно она является бутылочным горлышком и она постоянно должна пыжиться. А по факту нет. Даже до 60 градусов не доходит и цифры в 100% загрузки на ней при генерации я не вижу. А мои эксперименты выше только подтверждают, что затупы на ровном месте - это норма.

И вообще, что значит мусорная!!111 Это ж даже не сборка, у меня эта пека была до нейросетей, я просто втыкаю туда-сюда карты в уже существующий девайс, пытаясь найти лучшую комбинацию. Вон тут анон с 4 теслами был, он даж биос самодельный прошивал в специально купленную материнку, вот это уже сборка.

Окей, потом уже накидаю, сегодня впадлу.

>Ваще похуй.

Платить 5к за кабель и кусок платы с тремя кондерами и тремя разъемами? Я для этих экспериментов купил БП за 5к, а там внутри начинка все же посложнее будет. Этим райзерам цена косарь, да и то только из уважения к качественной пайке и оплетке кабеля.

Не дадут, у анона со сборкой 3-4 т/с было с ровсплитом, емнип, плюс обработка контекста медленная.

>поупарываться с даблерами и мультиплексорами?

О, это такая хуйня, которая из одного порта х1 делает четыре? Лол, я видел такие в сборках для майнеров, но мне кажется это прям дикий изврат. Как оно по производительности-то вообще, интересно. Мне кажется, что если уж материнка путается в нативной бифуркации, то с такими приколами там вообще все встанет намертво. Хотя купить ради прикола можно, вдруг реально с ней получится еще тесел напихать.

> это такая хуйня, которая из одного порта х1 делает четыре?

Скорее из одного х16 4х х8. Правда хз насколько могут быть доступны такие платы просто так, не в составе чего-то. Да и если достанешь может также сфейлить, это вообще оче странно что проц не может поделить линии. Хотя если там амудэ средней старости то тема вроде как не новая.

Может тебе просто поискать сразу норм плату с даблерами и кучей слотов?

Смотри, сама модель 7/8 гигов, плюс ещё контекста гигабайт/полтора, всё не влезет. Винда кстати ещё память жрет, где то полтора гига, и отдавать не торопится (я про 11). если ты на линухе, то я хз как там.

У кобольда параметр gpu layers, на -1 он ставит рекомендуемое значение выгрузки. Там у тебя будет выгрузка части нейронки на медленную память, и да, она замедлится, но всё равно будет плюс минус годно. начни с кванта побольше, типа q6, если скорость кажется низкой - качай меньше, типа q5, q4 и так далее, будет быстрее. по качеству ответов на разных q смотри сам, кому то и q4 пишет хорошо, а кому только q8 подавай.

Я вот только такое нашел

https://aliexpress.ru/item/1005005277556030.html?spm=a2g2w.detail.similar_rcmd.0.62de72abHU6Vol&mixer_rcmd_bucket_id=aerabtestalgoRecommendAbV2_testRankingNewFeaturesItemContext&pdp_trigger_item_id=0_1005005225435564&ru_algo_pv_id=d12e16-61b690-8c6b21-81d3ff-1737763200&scenario=aerSimilarItemPdpRcmd&sku_id=12000032458583276&traffic_source=recommendation&type_rcmd=core

Для x16 что-то не ищутся мультиплексоры подобного типа. Они же в майнинге не актуальны, поэтому наверное редки и чрезвычайно дороги.

>Не дадут, у анона со сборкой 3-4 т/с было с ровсплитом, емнип, плюс обработка контекста медленная.

Со сборкой может быть, но у меня плата приличная - и на 8к контекста 123В в 4-м кванте 6+ т/с даёт точно. К 24к контекста правда спускается до 3,3 т/с. С обработкой контекста да, сильно хуже, но опять-таки - первые килобайты контекста скорость его обработки выше. В целом сравнимо.

gpu layers это сколько слоев говна нейронки пойдёт на видеокарту. Больше - лучше. Выше сформулировал плохо, поэтому поясняю.

А что у тебя за материнка?

>А что у тебя за материнка?

WS X299 SAGE

Нет смысла -1 ставить. Нужно ставить необходимый тебе контекст, затем докидывать примерно 4 слоя (хотя тут от модели зависит) к рекомендуемым значениям: кобольд автоматом ставит 20 слоёв, ты делаешь 24, затем включаешь бенчмарк, чтобы проверить, не вылетает ли на текущем контексте, находя оптимальное значение.

Анончик, помоги! Качаю 14B_Q6, пытаюсь запустить в Кобольде, а он паскуда вылетает. Может надо настройку какую хитрую применить?

>основной интерфейс чата крайне уныл

Да чо вам там не нравится? Шрифт, размер настраиваются, редактирование текста открывается в один клик, и всего текст разом, что важно, а не по одному сообщению. Дальше что хочешь с ним делай, бэкап чата тоже одной кнопкой скачивается.

>вылетает

Тоже вчера вылетал, обнови.

https://github.com/LostRuins/koboldcpp/releases/tag/v1.82.4

Поигрался вчера со своей карточкой на дипсике, на русике, даже понравилось, чистый дипсик на длинном контексте скатывается в залупы и старадает логика, но если его пинать подключением R1 то держится, особенно хорошо передает характер карточки, что понравилось. В целом лучше конечно суммаризовать чат время от времени. Понаписал целую простыню с ним, целый вечер развлекался, в фентези хорошо зашло, на кум не проверял. Как альтернатива локальным, поинтереснее чем 12б. Эх, вот бы апишечку дернуть, я бы даже проплатил, но сука, как?

Буквально пару месяцев не игрался с нейронками, а уже даже 12б модель может в русик. Mag-Mell 6 бит

>У кобольда параметр gpu layers, на -1 он ставит рекомендуемое значение выгрузки.

Херню он ставит, последний пример: на мои 24gb он запихал 16/67 слоев в гпу, когда на деле они помещаются туда все, и ещё на контекст остается. Ты должен ставить слои руками. Если кобольд крашится при запуске, значит модель вместе с контекстом уже не лезет, пошагово либо переносишь слои в RAM, либо/квантуешь режешь контекст.

Можно ещё распаковать exe кобольда, и сдеать cmd ярлык с PAUSE в конце, тогда можно будет более подробно почитать вывод после краша, окно не закроется.

> Ты должен ставить слои руками

А как? Поставить все слои, что есть, это да. А контекст как учесть?

Посоветуйте материнки под нейронки что бы сразу 3-5 видях можно было всунуть одновременно? Есть гайд какой нибудь?

мистрали все могут более-менее, если совсем не ужаренные в хлам английским треном поверх базы

asus romed8-2t

Supermicro H12SSL

Методом проб и ошибок. У разных моделей контекст может занимать разный объем. Ставишь сперва те значения какие хочешь, если вылетает, пошагово уменьшаешь.

> если вылетает, пошагово уменьшаешь.

Если же кобольд, он просто протечет в оперативу.

Generate:40.62s (177.4ms/T = 5.64T/s), Total:66.88s (3.42T/s)

Накинул 4 слоя сверху от рекомендуемых кобольдом, по ощущениям мало что изменилось, но прошлые значения я и не замерял.

> я твоя ебать ты моя сосать

Простецкий Asus Prime серия z690-790-890 - 4 слота физических х16 в5х16, в4х4, 2хв3х3 внутри, конечно. Дешевле 4 порта врядли найдёшь.

> 123В в 4-м кванте 6+ т/с даёт

А что у тебя? 4090+2х3090 даёт 10т/с. Думаю 3х3090 было бы столько же, может чуть меньше.

Лол. Как же годно читать на русском такую дичь.

>Mag-Mell

Луше попробуй инструменталити

>А что у тебя? 4090+2х3090 даёт 10т/с. Думаю 3х3090 было бы столько же, может чуть меньше.

Да, только дают они столько с полным контекстом в 24к и обработка этого контекста занимает секунд 10. А теслы, которые у меня, дают с полным таким контекстом в три раз меньше, а о полной обработке этого самого контекста я и не говорю. Нет, если придрочится, то жить можно: ставишь контекст в 32к, благо врам позволяет, ограничиваешь его в Таверне через /hide до 24к и нет особых проблем - на такой-то модели даже рероллить нужно не часто. Но всё равно закупаюсь Амперами.

А это какая модель?

Как сделать так, чтобы в таверне с дипсиком после написания поста удалялась вся цепочка рассуждений, таким образом не занимая триллион контекста?

Кстати а как заставил то? Там же нет в интерфейсе кнопки "редактировать сообщение и продолжить его". Ну, или я не нашел.

Модельку и промптик, извольте поделиться-с!

>Платить 5к за кабель и кусок платы

А за одну плату 4к не хочешь? Найди дешевле:

https://aliexpress.ru/item/1005005326111069.html

>Скорее из одного х16 4х х8.

Скорее 3х16. Оно характеризуется общим числом линий, обычно не больше 64-х. И да, стоят просто кучу бабла. На алишке их нет, надо искать на западных магазинах.

>на мои

С мультиГПУ эта хрень не пашет, да.

>Можно ещё распаковать exe кобольда, и сдеать cmd ярлык с PAUSE в конце

А просто из консоли запускать не пробовал?

>в треде писали аддон к таверне на мультизапрос, он прилично работает

Линк?

У кого кобольд вылетал при попытке запихнуть в него дипкок - просто обновите вашего кобольда.

Qwen2.5-Coder-32b

Посмотри квант, чтобы влазил в видеопамять и оставалось на контекст.

Можешь попробовать еще R1-distill-Qwen-32b, говорят даже получше, но подольше.

Респект таким парням, эксперименты огонь.

Без названия модели и битности будем считать, что ты это сам сочинил, чтобы чётенько потроллить тредик тупостью

>Как сделать так, чтобы в таверне с дипсиком после написания поста удалялась вся цепочка рассуждений, таким образом не занимая триллион контекста?

Регулярное выражение нужно сделать в Таверне и включить. Вопрос какое? Может такое подойдёт: /<thing>[\s\S]*?<\/thing>/g

Можно через префил или префикс последнего вывода ассистента (всё на вкладке с форматированием/инстрактом). Второй вариант проканает только с отключенными именами, потому что иначе после <think> будет ставить {{char}}: и всё ломать. Ну или тупо дать ему инструкцию начинать свой ответ с <think>, можно на нулевой глубине. Инстракт там, кстати, какой-то свой у ризонинга, но я юзал теги ламы тройки.

Да он копипастит из корпо треда, геминька или оригинальный дипсик-р. К сожалению, немо, даже с ру тьюнами, не может в живой эмоциональный русский, ну насколько я вижу с чужих скриншотов и по своему небольшому опыту. Когда пробовал последний раз в ру рп на инструменталити, накатал огромный гритинг, надеясь, что с него подцепится стиль речи, но нифига, получается сухой унылый перевод. Видно, что мало русского в датасете, чтобы правильно генерить живую речь, характерную для особенностей персонажа и контекста.

>Может такое подойдёт: /<thing>[\s\S]*?<\/thing>/g

Пардон, не <thing>, а <think>. Знаю английский со словарём, а теперь с Гуглом - голове работать лень :)

>Завезли какой-нибудь софт для голосового ассистента вроде Алисы на локалке?

https://github.com/Mozer/talk-llama-fast

https://github.com/mezbaul-h/june

https://heywillow.io/

Можно вкратце как вы трените аи под русский рп, я просто ставлю яндекс переводчик в таверне, он на удивление годный, но иногда может выдавать кринге, и путает местоимения.

Кста не знал что у яндекса настолько ахуенный переводчик с англ на ру

Кто 3B в тред запустил...

>как вы трените аи под русский рп

Спроси в телеге тензорного банана

> Для x16 что-то не ищутся мультиплексоры подобного типа.

Их в комплекте с некоторыми девайсами или в проприетарных железках можно отыскать.

> Шрифт, размер настраиваются

И еще там есть скролл вверх-вниз и можно читать текст!

А если серьезно, отсутствуют вполне базовые вещи как по промт-менеджменту, так и по самому чату, это лишь чуть лучше консоли.

Это как "посоветуйте автомобиль". Ты обозначь бюджет и какие именно потребности. Просто воткнуть - вон выше анон напихал во все дырки. Были бы одни современные, можно было бы даже быстро инфиренсить на экслламе.

> и обработка этого контекста занимает секунд 10

На больших может и на минуту затянуться, потому раз в н-дцать постов суммарайз и отключение части.

> Скорее 3х16

Нет. Популярные даблеры на 3.0 идут на 16 линий выхода и 32 линии выхода, при этом последние можно делить по 16 или 8 (или 4 для некоторых).

В западных точно также не найдешь ибо нишевый продукт. Или вот в подобных исполнениях https://aliexpress.ru/item/1005006968619557.html

>Популярные даблеры на 3.0 идут на 16 линий выхода и 32 линии выхода

Всегда думал, что там входы-выходы универсальные, лол, это ж коммутатор, ему похуй, что куда. Но с числом линий проебался, да, думал, там 64. И 5 портов, так что 16 на вход и 4 по 8 на выход это максимум. Впрочем ценники ояебу, проще серверную мать взять.

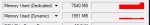

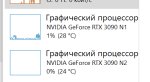

Это норм скорость для 35B 4.5Q на 3090?

ЧТо-то выглядит будто карта недогружена.

ЧТо-то выглядит будто карта недогружена.

> 32B

самофикс

Попробуй вместо HF движка просто ExLlama попробовать.

Ну и чисто формально — bpw, а не Q, все же. =)

>можно читать текст

И шо таки вам ещё надоть? Без балды. Мб в своём фронте запилю.

Не, эта штука имеет полноценные контроллеры шины и внутренний буфер, все сложнее.

Если у тебя хлеб вместо процессора то hf обертка может давать замедление (но чтобы настолько - это совсем некрозеон должен быть). Если шинда то может быть вариант что видеопамять переполнена и она выгружается драйвером, от чего замедление.

Для такой модели и кванта на 3090 примерно 30+ токенов должно быть.

> в своём фронте

Что там?

Очень мало. И подрубай спекулятивный декодинг. На 4090 с ним 50-60 т/с на 32В даже на Жоре.

>Что там?

Оно работает, но недостаточно работает чтобы выкладывать, следующей целью будет прикрутить SSE стриминг как время появится.

Хм. Примерно такая же самая скорость как и с HF

>Если у тебя хлеб вместо процессора то hf обертка может давать замедление (но чтобы настолько - это совсем некрозеон должен быть). Если шинда то может быть вариант что видеопамять переполнена и она выгружается драйвером, от чего замедление.

>Для такой модели и кванта на 3090 примерно 30+ токенов должно быть.

Райзен 3700. Вроде бы не выгружается, хотя хз

Эм. А как это включить?

> На 4090 с ним 50-60 т/с

Полтинник или около того на небольшом кванте там будет просто так на 4090.

Попробуй софтом для мониторинга глянуть, hwinfo, gpu-z и т.д., там же будет нагрузка на контроллер шины. Если последняя превышает единицы процентов значит дело в этом. Заодно там же посмотри perf_cap_reason.

3700 райзен не подарок, но вполне норм и с ним проблем быть не должно.

>нагрузка на контроллер шины

О, хитро. Это же GPU BUs load?

+

Лимит по "утилизации". Но... Там кроме памяти ничего и не напрягается особо-то.

Смотри профили энергопотребления и андервольтинг, у тебя жестко задушены частоты карты. Хз умеет ли шинда это делать, ищи что настраивал.

> на небольшом кванте там будет просто так на 4090

Только если на IQ2, лол. И нахуй оно надо тогда.

> Полтинник или около того на небольшом кванте там будет просто так на 4090.

Не будет. Кванты ниже q4 только медленнее. А на q4 больше 35 т/с не выжать. Спекулятивный декодинг почти х2 даёт, в кодинге/CoT очень помогает генерить простыни, 1к токенов уже меньше чем за 15 секунд генерятся.

>Спекулятивный декодинг почти х2 даёт

даёт-даёт, а включить-то его где

Какой конкретно дипсик качал? Тот который я качнул, китайский онли((

4-4.3 бита

> q4

Речь не о жоре.

> Спекулятивный декодинг почти х2 даёт

Смотря где, может и х4, может и замедлить. Потраченную врам на вторую модель никто не вернет.

Присоединяюсь к вопросу, где раздают секретный дипсик, который может в языки. Пока что все счастливо-хвалебные отзывы здесь и на реддите вызывют чувство, что это все какой-то развод с участием ботом, сочиняющих небылицы. То, что пробовал из дипсиков, влезающих в моих скромные 12гб, это тихий ужас.

Вопрос на миллион токенов. Влияет ли язык ответа на ответ самой нейронки ? Ну условно у меня идет реп на Лондон из э Кэпитал. Но если я не буду ебать себе голову и отвечать на английском, это поломает беседу ? Потому что пока что единственное и то мне скорее всего кажется, если писать на русском, то нейронка в ответ меньше пишет.

>влезающих в моих скромные 12гб

Не, ну а хули ты хотел то? Скрины небось с 48 делают.

>Влияет ли язык ответа на ответ самой нейронки ?

Там даже запятые влияют, не то что язык. А так выше шансы скатится в русик в ответе, чуть хуже понимание и выше расход контекста.

>обозначь бюджет и какие именно потребности

Имею одну 3060, хочу в ближайшем будущем поставить парочку 4060ti ну и на будущее, что бы хотя бы одна дырка про запас была под видюху

Спасиба попробую

Не мои примеры из треда честные. я так-же сижу со своими 12гб.

Даже пробовал DeepSeek-R1-Distill-Qwen-14B-Q4_K_L чтобы 12288 контекста иметь нормально.

7б-8б не умеют

14б иногда кашляет

32б норм

Я хз, что может быть не так, надеюсь семплеры не в говно с 3,5 темпой.

Немного влияет. Но в общем, у тебя лишь одно из измерений меняется (языковое), и на доминирующих языках ллм лучше рассуждают просто потому, что у них там токенов больше.

Если ты просто болтаешь, то почти не повлияет, если заставляешь решать юбучую квантовую физику, то конечно повлияет. Ну и размер модели, содержание датасета, все дела.

>норм

14 Q8 или 32 Q4, что лучше?

Последний год отвечаю сетке исключительно на русском, никаких проблем с пониманием не замечал. Все современные модели обучаются работать с разными языки и жрут соответствующие датасеты, даже если не подразумевается, что они будут мультиязычными. Так что можешь расслабить жопу и писать как тебе удобно. Единственное, лучше не использовать специфичный сленг и всякие крылатые выражения, хотя некоторые сетки (обычно жирненькие) его тоже распознают.

На кум можешь особо не рассчитывать. Ему там анус зашили. Когда попросил написать мне историю эротическую он мне написал про хандхолдинг двух феечек и отказался писать что-то более откровенное. Мне удавалось локальную разговорить, пробивал его на всякую дегенерацию, но там слог мягко говоря скромный в этом.

Как понимать когда Mistral-Nemo-Instruct-2407-Q3_K_M выдает мне подобное на любой запрос? С 2407-Q4_K_M такой хуйни не замечено.

Основной пласт знаний именно на английском, иногда на китайском, качество ответа на не-основных языках зависит от модели и сложности вопроса. На простой вопрос почти любая сетка ответит нормально, на что-то сложное многие отвалятся, самый лучший ответ всегда будет на языке оригинала, исключения пренебрежимы. Это справедливо даже для корпов, просто чем лучше модель тем это менее заметно.

В таком случае бери любую где побольше слотов и они х4 а не х1. В идеале если можно дробить процессорный х16 на пару х8, но такое в бюджетках редкость.

7б bf16 покормил

Беды с промтом или жора/квант поломались.

Попробовал. Это нормально что после пары сообщений они напрочь забывают о чем речь или там надо настраивать что-то дальше загрузил включил? Мне бы скинуть ему первым сообщением свой код и потом направлять его чтоб он писал и исправлял код по указке и входящим ошибкам. А тут ему пишешь что надо использовать код такой то версии и он мне на словах объясняет да надо вот по таким причинам и принтит код в котором исправил хуй пойми что но не то что его просили. Впрочем я наверное дохуя прошу, а ведь всего лишь хочу мод для себя и другалей написать для непопулярной игры на юнити лол. В нексусе половина модов устарела и не пашут блет. Парочку через дипсик смог коряво сделать и даже корявый мод который щас хочу сделать получился, но вот отдебагать его не получается дипсиком

>DeepSeek-R1-Distill-Qwen-14B-Q4_K_L

Действительно, с языками оно справляется, но не так чтобы на голову выше мистраля 12b трехмесячной давности и даже геммы2 9b. Безотносительно языков в первом же тесте модель показала себя очень креативной, на уровне особо креативных файнтюнов того же мистраля.

Но при ближайшем рассмотрении ее креативность имеет мало общего с промптом. Результат выходит даже не по мотивам, ну и плюс к этому порой переходит на китайский.

Так, например, я попросил продолжить абзац про полуголых танцовщиц в киберпанк-дискотеке, в стиле научной фантастики. Дипсик сочинил лабуду про то, как мы восемьсот лет ждали какого-то сигнала, и дальше научно-фантастическая новелла в миниатюре без каких-либо танцовщиц и киберпанка.

Стено, ты охуел? С такой скоростью и какие то адекватные ответы при размере в 5гб? Я обычно отходил покурить или листал инет, пока другие модели чет сгенерят на моих 8гб, а тут ебать, секунды.

(Да, я ньюфаг что поражен скорости и адекватности ответов.)

(Да, я ньюфаг что поражен скорости и адекватности ответов.)

А, забудьте, на 4ом сообщении он попытался меня выебать.

>адекватные ответы

>попытался меня выебать

Не понял, в чём твоя проблема?

В том что он полностью игнорировал правила карточки, дизлайки карточки и то что карточка не любила проявлять, тупо форсируя еблю как можно быстрее и глубже. Я перебрал кучу с десяток карточек для теста этой модели, конкретно на той где я написал "забудьте", карточка с запретом к прикосновению к пизде, тупо снимала трусы и просила потрогать ее за пизду в том или ином виде сколько бы свайпов я не делал.

- эй дорогая, принеси мне выпить

- конечно! через несколько секунд она прибежала с кружкой пива и повернулась к тебе жопой и отодвинула трусики. "эй мистер, потрогайте!"

>Смотря где, может и х4, может и замедлить. Потраченную врам на вторую модель никто не вернет.

Для драфт-модели ведь нужна отдельная видеокарта? Надо бы попробовать на риге. Проблема в том, что самый маленький квант 123В в 24гб уже не влезает (а ведь ему ещё и место под контекст нужно). С 70-72В уже можно попробовать. Так-то мне скорости хватало, но со всеми этими ризонингами...

>карточка с запретом к прикосновению к пизде

Напиши что ей 11, самый надёжный способ запрета.

>Для драфт-модели ведь нужна отдельная видеокарта?

Нафига?

Кларк, сделай нас Единым.

>7б bf16 покормил

Понятно =) Total:127.94s (3.06T/s) Внезапно даже с терпимой скоростью работает.

>креативность имеет мало общего с промптом.

На дефолтных настройках на которых мистрали гоняю вроде норм.

Правда периодически в конце сообщения может высрать открывающий или закрывающий </think> без актуального процесса "размышления". Ну и простыни катает, да, иногда даже в 512 токенов не укладывается.

>7б bf16 покормил

Понятно =) Total:127.94s (3.06T/s) Внезапно даже с терпимой скоростью работает.

>креативность имеет мало общего с промптом.

На дефолтных настройках на которых мистрали гоняю вроде норм.

Правда периодически в конце сообщения может высрать открывающий или закрывающий </think> без актуального процесса "размышления". Ну и простыни катает, да, иногда даже в 512 токенов не укладывается.

Есть варики пользоваться платной версией бесплатно?

Скрапить самому, абузить триалы, попрошайничать брызги эякулята в кончай-треде https://2ch.hk/ai/res/1025600.html для обдроченных школьников без капли самоуважения.

>платной версией бесплатно

в /aicg/ спроси

Хз что там сломалось, но Wayfarer-12B-Q3_K_L тоже несет подобный бред, Q4 версия так же как и немо Q4 работает адекватно.

Нужно заставлять его думать в <think> тегах, тогда он как раз обсасывает вещи из промпта и карточки на автомате и использует их. Без этого ты практически используешь обычный квен без ризонинга, хоть он сам и пытается иногда начать размышления всё равно.

Да, 8б тьюны сао ебливые. Но можешь на всякий чекнуть, нет ли в промпте какой-нибудь глупости вроде nsfw is encouraged. Олсо отрицания плохо работают, как инструкции. Так что если в карточке прямо так и написано про не трогать пизду, то как раз на это может и провоцировать.

Дистилл=хуёво файнтюнится?

Нет.

Стено - это модель чисто для кума, причём тупенькая. Если хочешь нормальный ролеплей, выбирай что-нибудь другое.

>обосрал

>ничего не предложил

Мнение отклонено.

Cколько токенов в секунду будет на модели 70B q4 размером 40гб при скорости рамы в 256гбс?

3-5 т/с.

ну епт, мистрал мержи от Aleteian попробуй

Господа, кто-нибудь юзал Instinct mi50 для текстовых нейронок?

Чот посмотрел на вторичке это самые дешевые карты с 16 гигабайтами видеопамяти кроме тесл на кеплере, которые не шевелятся вообще, насколько они вообще юзабельны?

Чот посмотрел на вторичке это самые дешевые карты с 16 гигабайтами видеопамяти кроме тесл на кеплере, которые не шевелятся вообще, насколько они вообще юзабельны?

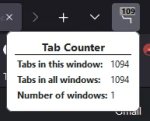

Почему при попытке обновить убабугу выдает рил1? При повторной попытке рил2. Раз 5 уже пытался обновится (доставал из бэкапа убабуги).

Читать не умеешь? На первом скрипт для линукса, на втором пишет что у тебя есть изменённые файлы, которые ты не замержил в локальную репу.

Очень нравится пикрил модель, но свайпы вообще практически одинаковые, юзаю семплеры как автор написал.

Что может быть не так?

Начало предложения может быть 10 свайпов подряд один в один и только в середине изменения

Что может быть не так?

Начало предложения может быть 10 свайпов подряд один в один и только в середине изменения

> mergekit

> рекомендации семплинга

Я бы от такого сразу бежал. У таких обычно шаг в сторону и сразу поломка модели.

Показывай Text Completion и темплейты, два скрина, будем разбираться.

Господа, ебанатский вопрос. Я вроде читал матчасть по языковым моделям, но видимо как то хуёво читал. В чём с тех. точки зрения разница между двумя моделями как на пикриле, условно. Просто больше слов и речевых оборотов в базе модели? Я бы не задавал этот вопрос, если бы мог адекватно потестить вторую, более тяжёлую модель, у меня на ней боты думают по 30 секунд, это пиздец.

Я всегда только А) Update the web UI нажимал никаких форок или экспериментальных штук (TTS и пр.) не устанавливал.

>боты думают по 30 секунд

Разве это много?

Ну блять, для рп много, имхо, хотя может я ньюфаг, не привык просто ещё.

>разница

Буквально что считай в количестве нейронов в мозгах модели.

>ньюфаг

Смотря на сколько токенов эти 30 секунд уходят.

Возьми что-то из 12б мистралей в шестом кванте.

Например отсюда https://huggingface.co/Aleteian

Ты где это говно мамонта откапал?

Чем меньше модель тем чаще теряется и путается ллм в том что происходит. Быстрее переходит в струю секса, прелюдия намного быстрее переходит в секс или отказ. Меньше возможностей для манёвров.

>Ты где это говно мамонта откапал?

Эммм... В шапке треда где гайд для ньюфагов.

Попробуй компромисс 12b - Nemomix-v4.0-12B.i1-IQ4_XS, те две сильно устарели. Не забудь MinP пресет для таверны поставить. Hermes 7b вообще для RP не подходит.

Я 8B моделями не пользуюсь, извиняй.

> Попробуй компромисс 12b - Nemomix-v4.0-12B.i1-IQ4_XS

Processing Prompt [BLAS] встает на 512/n и колышится, такое еще с несколькими моделями случалось, так и не смог их заставить генерить. Что то в настройках кобольда надо поменять?

и не колышется фикс.

тогда и не пизди на стено, лол

Я пользуюсь oobabooga, там ничего настраивать не надо.

Он мне пишет что амуда только для линукса, то есть на винде я это не запущу?

Вот я побаловался с кум, скриптотой, РПГ. И теперь вопрос: а для чего ещё можно применить дома llm?

>и не колышется

Видимо считается на проце. Какая видеокарта у тебя? Какой из этих пресетов выбираешь?

> Для драфт-модели ведь нужна отдельная видеокарта?

Не обязательно, можно хоть на одной обе катать. Но от общей врам она в любом случае отъест долю.

Q3km еще не настолько лоботомит чтобы не быть способным сформулировать простой ответ а вот сразу так поломаться. Может бредить и тупить, но хотябы связно.

Или у тебя жора поломанный (что более вероятно когда 2 разных кванта одинаково себя ведут), или квантодел фейсроллил, например квантанув головы в 4 бита, или что-то еще крайне неудачно сделал.

Если это мультисоккет то будет печально. Главная беда - вечная обработка контекста.

Тебе верно ответили. Самым простым вариантом будет открыть терминал в папке и сделать git reset --hard а потом повторить обновление.

Кобольд по дефолту втыкает вулкан. У меня 6600 карта.

> Или у тебя жора поломанный (что более вероятно когда 2 разных кванта одинаково себя ведут), или квантодел фейсроллил, например квантанув головы в 4 бита, или что-то еще крайне неудачно сделал.

Я в этом 2ой день только, для меня ты сейчас кастанул заклинание на иностранном языке.

Решил перепроверить, ты был прав, почему то для Q3, кобольд вставляет проц вместо вулкана, спасибо.

>Кобольд по дефолту втыкает вулкан. У меня 6600 карта.

Вообще RX 6600 по идее поддерживает ROCm под виндой, но вроде без поддержки HIP, на всякий случай скачай форк с поддержкой ROCm и проверь, заведётся или нет.

github.com/YellowRoseCx/koboldcpp-rocm/releases/tag/v1.82.1.yr0-ROCm

Да не за что, но проверь, вдруг у тебя и ROCm заведётся, он всё же ощутимо быстрее.

Ай все, я уже в моделях запутался. Сейчас все заново проверю. Я упоролся кажись, накачал всего и сразу. Для того на что ты мне ответил втыкался вулкан. А где ответил мне другой чел, Q3 выдает мне ахинею на всех языках сразу.

Перепроверил, стоит вулкан, 12b - Nemomix-v4.0-12B.i1-IQ4_XS все так же виснет на blas 512.

Так, раз уж упомянули ос, то какую лучше ставить Винду или Линукс? Если Линукс, то какой? Посоветуйте.

формально - любая, но все гиты/мануалы/туториалы в ясном или неявном виде сделаны в юбунте

Цидонька !

Понимаю что 22b немного отличается от 8b.

> для меня ты сейчас кастанул заклинание на иностранном языке

Тогда просто не парься и юзай что работает, позже освоишься. q3km уже прям совсем пограничный квант с точки зрения адекватности работы и рациональности использования. Тем более что амд, придется со временем разбираться (или менять).

Какой положняк треда по DeepSeek? Тварь дрожащая или право имеет?

>ред для обладателей топовых карт NVidia с кучей VRAM

Интел не подойдёт? Памяти-то хватает.

Или лучше не ебать мозги (себе и ему) и взять нвидию?

Хочешь побыть альфа-тестером за свои же деньги? Дерзай. Мы только "за" двумя руками, без шуток. Будешь потом тут гайды писать и костылями делиться.

>Хочешь побыть альфа-тестером за свои же деньги?

Ну да. Нахуя я по-твоему штеуд видяху купил? С играми пердолинг закончился больше года назад, дрова вылизали, вот нашёл новый повод для пердолинга.

Будем разбираться.

Судя по треду: неплохой геймастер и лучше 12б моделей (если дипсик 14б) в этом деле, какие-то охуительные истории тоже, возможно, лучше пишет, в зависимости от ситуации. Для качественного кума с подробностями о том, как тебе натирают простату, потому что ты шлюшка, которой и являешься, — не подойдёт, лол.

Говнокод вроде как тоже лучше пишет, если 32б модель.

Юзал vega 64, что почти то же самое, только с 8 гб.

>насколько они вообще юзабельны

До тех пор, пока влезает в видеопамять, примерно на уровне околотоповых паскалей. Но rocm там уже поддерживается через одно место и проще на вулкане крутить. А на вулкане промпт в 1.5-2.5 раза медленнее процессится, на больших моделях с большим пересчётом будет грустно. Если выбирать между этим и кеплером, возможно и не так плохо. Но паскалетеслы на 16 гб при условии аналогичной стоимости наверное будут лучше.

Как по мне он охуенный. Не для кума, а для какой-то аналитической хуйни. Охуенный гейммастер.

Кстати первая модель в этом размере которая смогла решить загадку в духе "в комнате три сестрички, А, Б, В. А читает книгу, Б играет в шахматы, что делает В?" Даже чатГПТ4 не мог решить её правильно. Разве что о1 мог решить её.

для перевода, правда там ебаться сос криптами и промтами, надо, но несколько тредов назад эту тему тут исследовали, и вроде даже успешно

>гейммастер

Вот только в рп может и будет писать за юзера.

Так что для рп всё же лучше пантеон или микс пантеона с цидонией для более влажного геймплэя.

Без ризонинга фактически тот же квен, хотя охуительные истории без намёков на кум пишет лучше, да. С хорошим систем промтом смог даже поддержать тентаклевый секс биомеха с женщиной-пилотом.

ЕБАнгелион, блин.

Но вот пространных описаний процесса соития да и многих других эксплисит тем выбить с него не получится наверно.

> загадку в духе "в комнате три сестрички, А, Б, В. А читает книгу, Б играет в шахматы, что делает В?" Даже чатГПТ4 не мог решить её правильно

Так, блядь, это что за поебень. Эту загадку и я правильно не могу решить, я в душе не ебу что делает В. Я тупее Дипсика?

Ну смотря для чего. Он точно расширяет возможности применения ллм и упрощает типичные кейсы для обычного юзера. Насколько это новые возможности рациональны для использования - большой вопрос.

Из неявных плюсов - нормису оно может лучше объяснить какие-то сложные вещи, паттерн саморефлексии заставляет охватывать дополнительные области и рассказывать о нюансах, а не просто подгонять варианты интерпретаций под криво сформулированный запрос юзера. В кодинге некоторые вещи может хорошо объяснить.

С другой стороны, если пайплайн обработки отлажен - он может оказаться даже хуже имеющихся моделей, или просто показывать +- то же но медленнее. Читать постоянные шизолупы даже не элементарные вопросы заебет очень быстро. В рп - днище донное, не ведись на то что оно может скосплеить текстовую рпг в начале, на контексте оно обосрется а в чате будет тысяча токенов рассуждения чтобы потом выдать ответ пигмы. Знания тоже сильно лоботомированы.

tldr - хорош для некоторых применений, панацеей не является.

>tldr - хорош для некоторых применений, панацеей не является.

Ты только что любой ллм.

https://github.com/YellowRoseCx/koboldcpp-rocm/releases/tag/v1.82.1.yr0-ROCm

Ну я попробовал это, в конце компиляции модели оно крашится. Ладно, на сегодня лапки опущу, слишком много времени уже потратил, даже не заметил как потемнело.

Лол. Мясной мешок, пиздец тебе!

Правильный ответ: шахматы это игра на двоих. В играет в шахматы в Б.

Может она там тренируется в шахматы или ставит мысленную партию, охуенный вундеркинд. Задачка уровня А бежит, Б едет на велике, что делает В? Азаза В тоже едет на велике, велик то тандемный!

>В играет в шахматы в Б

Ебать у тебя инцепшн, Б играет в шахматы, пока В в Б играет в шахматы.

Лол слово "играет" является ключевым в вопросе.

Опечатался. В играет в шахматы с Б

Поздно, в сестричке В армяне уже нарды достали.

Лол кибербуллинг на дваче. Но если серьёзно до дипсик довольно неплохо отгадывает такие загадки. Я весь прошлый вечер с ним в загадочника играл. Там где ответ в самом вопросе он прям неплох.

> шахматы это игра на двоих

Слышь, ебаный норми, я единичные разы только играл с кем-то в шахматы, большая часть моих партий была с компьютером или с самим собой. Естественно, мне и в голову не придет что Б будет играть с кем-то, если сказано что играет в шахматы.

Тем более что если она играла бы с В, то это и было бы сказано "Б играет в шахматы с В", но раз так не сказано, то В очевидно в партии не участвует, иначе составитель вопроса косноязычный мудак, либо мудак намеренно пытающийся запутать неправильной постановкой вопроса. В любом случае, не засчитывается.

Так, я вернулся с пивом, продолжаем. Дак хули оно крашится?

А читает книгу: это интеллигенция, товарищи. Она изучает теорию, анализирует положение вещей, готовится к будущей борьбе. Книга — это оружие идей, её страницы горят огнём марксистских трудов, подобно фитилю бомбы, готовой взорвать устои старого мира.

Б играет в шахматы: это тактика и стратегия. Шахматы — это не просто игра, это аллегория революционной борьбы. Задача товарища Б — проанализировать ходы противника, просчитать его слабости и нанести точный удар, чтобы свергнуть короля, этого жалкого символа деспотизма и угнетения.

А что делает В?

В, товарищи, не сидит сложа руки. Она готовит подполье! Она шьёт знамена, распространяет листовки, организует рабочие кружки. В — это практическая сила революции, которая, как динамит, молчаливо ждёт своего часа, пока не раздастся гром первого выстрела.

Приветствую 6600 брат. добро пожаловать в секту мазохистов у меня HIP работает ТОЛЬКО если включены галки на mmq и flash attention, без них вылетает либо на обработке контекста, либо как у тебя, при старте. Сколько слоёв в gpu layers пишешь? это тоже роляет. А, ну и на вулкане работает стабильнее, но без всяких плюшек и медленнее вроде как.

Я только в эти дебри полез и вообще в llm у себя на пк, раньше на хорде сидел и подсасывался к чужим. Слоев сверху оставляю 10-15, я как понял в зависимости от контекста и/или модели (?) показывает разное кол-во доступных слоев?

>mmq и flash

И спасибо, с этими настройками запустилось, по ощущениям правда быстрее не стало, если не считать того что промт в 1.5-2 раза обработал быстрее перед генерацией.

Кек, лоботомированный инцестмикс, прыгающий на хуй и спамящий министрейшнами - вот типичная ллм.

> шахматы это игра на двоих

В эту игру могут играть двое~

Ладно, пизжу, раньше в тотал я выше единицы токенов в секунду не видел, обычно вообще красовалось гордое 0.50Т/SEC

Хер знает, я и то, и то в Q8 пробовал.

А в контекст все влазит?

Может промпт надо докинуть, хз.

У меня он в каждом сообщении повторяет результирующий код и не забывает. Я не задумывался, хм…

Очевидно, сигнала вы так и не дождались, а танцовщицы были на другой планете, эх…

Если не для работы, то для суммаризации и ответов на вопросы. Но так-то есть встроенная ассистенты (Алиса там, Гугл, вот это вот все).

Можно умный дом вешать, но это уже очень много мороки.

Плюсую весь тред тоже охуел с задачи про шахматы. Я рад, что Дипсик догадался до того, до чего не догадался я, но правильным ответом это тяжело назвать.

В шахматы играть можно в одиночку.

Открыл для себя очевидное и невероятное, если во время генерации смотреть видяшки на ютубе/твич, то генерация замедляется. Хоть за телефоном тянись от безысходности.

на -1 он прикидывает примерно, сколько влезет, но можно ещё слой-другой накинуть без потерь. от модели к модели числа немного разнятся, и сильно зависят от контекста. Кстати, есть вариант как ещё ускорить обработку контекста - во второй вкладке кобольда ползунок BLAS перевести с 512 на 256. Рад что всё у тебя заработало. Не торопись вкатываться в дебри, дрыгай понемногу настройки (всего) и смотри сам. Да, локалки жрут очень много времени. но интересно ведь!

Можно. Но загадки это не про это. Вообще лол онлайн версия довольно сильная.

Памяти не хватает небось на видос.

>Да, локалки жрут очень много времени

Я заметил, я уже 11ый час сижу за этим наркотиком.

Да 100% не хватает, пихаю 7гб модель в 8гб видяху. У меня же Q3 бред несут, приходится на Q4 сидеть.

В общем, кажется, понятна причина затупов, может и не в бифуркации дело. Материнка не любит карты, подключенные через m.2. Есть тесла на x1 обычном и на x4 m.2. Если слои выгружать на первую, то генерация на 10к контекста 4 т/с. Если на вторую - 1.8. Так что попробую я, пожалуй, вот такую йобу или ей подобную https://aliexpress.ru/item/1005005277556030.html, вдруг будет нормально.

https://aliexpress.ru/item/1005008040561447.html

https://aliexpress.ru/item/1005004675016210.html

https://aliexpress.ru/item/1005008060050273.html

>WS X299 SAGE

Нашел только на авито б/у за 25к, видимо она уже старая? А есть современные похожие модели, которые в том же днс можно купить?

https://aliexpress.ru/item/1005008040561447.html

https://aliexpress.ru/item/1005004675016210.html

https://aliexpress.ru/item/1005008060050273.html

>WS X299 SAGE

Нашел только на авито б/у за 25к, видимо она уже старая? А есть современные похожие модели, которые в том же днс можно купить?

>открыть терминал в папке и сделать git reset --hard а потом повторить обновление

Спасибо.

Вут? Хотя если ты смотришь видяшки то там и так все не весело и лишняя нагрузка может влиять.

х299 аж вон аж когда была, конечно только старые. Искать на барахолках.