БАЗА ТРЕДА ПО ХАЙПОВОМУ DEEPSEEK.

Основную модель, по которой идет хайп, не запустить обычному человеку, смертным доступны только маленькие дистилляты этой модели, которые уступают уже существующим моделям. Обсуждение веб-версии Deepseek ведется в соседнем треде.

Ответы: >>1034144, >>1034154, >>1035270

Основную модель, по которой идет хайп, не запустить обычному человеку, смертным доступны только маленькие дистилляты этой модели, которые уступают уже существующим моделям. Обсуждение веб-версии Deepseek ведется в соседнем треде.

Ну думаю в допросах реально можно ресетать диалог каждый раз, после каждого допроса идет результат и информация о нем больше не важна. А вот удалять в длинных диалогах что либо будет проблемнее.

Попробовал дипсик, делюсь впечатлениями.

>DeepSeek-R1-Distill-Qwen-1.5B

Хуита полная. Цепляется за первый вопрос и подстраивает ответы под него. Я говорю забудь весь контекст, а оно все равно цепляется и генерит хуету. Просишь чекнуть грамматику - с какого-то хуя исправляет предложение и чекает грамматику уже его.

Может выдавать лишние символы или слова, абсолютно не связанные с вопросом.

>DeepSeek-R1-Distill-Qwen-7B

Получше. Следует инструкциям. Количество букв R в слове strawberry считать умеет, а в вариациях написания - уже нет, выдает хуету. Сумела сказать, когда вышла GTA: SA, а с GTA: VS обосралась капитально - подумала, что это Vice City Stories, и все равно в итоге обосралась с датой.

>DeepSeek-R1-Distill-Llama-8B

Количество букв R в вариациях слова strawberry считает через раз. С датой правильно ответила. Простой код сгенерить сумела. Грамматику проверяет вроде бы нормально. По крайней мере базируется ровно на том, что я ввёл.

Не знаю, буду ли пользоваться, потому что есть ощущение, что она будет галлюцинировать в будущем.

Остальные модели работают очень медленно на моем железе - устал ждать, пока они печатают ответ со своими рассуждениями, и дропнул.

Ответы: >>1034129, >>1034132, >>1034246

>DeepSeek-R1-Distill-Qwen-1.5B

Хуита полная. Цепляется за первый вопрос и подстраивает ответы под него. Я говорю забудь весь контекст, а оно все равно цепляется и генерит хуету. Просишь чекнуть грамматику - с какого-то хуя исправляет предложение и чекает грамматику уже его.

Может выдавать лишние символы или слова, абсолютно не связанные с вопросом.

>DeepSeek-R1-Distill-Qwen-7B

Получше. Следует инструкциям. Количество букв R в слове strawberry считать умеет, а в вариациях написания - уже нет, выдает хуету. Сумела сказать, когда вышла GTA: SA, а с GTA: VS обосралась капитально - подумала, что это Vice City Stories, и все равно в итоге обосралась с датой.

>DeepSeek-R1-Distill-Llama-8B

Количество букв R в вариациях слова strawberry считает через раз. С датой правильно ответила. Простой код сгенерить сумела. Грамматику проверяет вроде бы нормально. По крайней мере базируется ровно на том, что я ввёл.

Не знаю, буду ли пользоваться, потому что есть ощущение, что она будет галлюцинировать в будущем.

Остальные модели работают очень медленно на моем железе - устал ждать, пока они печатают ответ со своими рассуждениями, и дропнул.

а какая у тебя видяха? я бомжик с 4 гига видяхи, и за сим особо не лезу даже в локалки, получится ли на 7б параметры залететь?

Ответы: >>1034140

Отработаешь ещё, делая мержи по заказам анонов.

4060 8Gb

8b летает очень быстро. 14b - тормозит пиздец

А, ты оллама-инвалид, тогда нет вопросов.

> которые уступают уже существующим моделям

Это каким таким? 32В и 70В ебут всё остальное в своих размерах.

Почитав несколько тредов и чуток потеребив модельки я тут задумался. А модель же не может выполнить это указание из карточки персонажа? Чтобы ей запомнить, она должна это написать в сообщение чтобы запихнуть это в контекст?

Ну, последняя идея анона где чисто новая сайга и старый немомикс анлишед вышла очень даже. Я правда пока не смог побольше карточек потестить, занят был по делам да работе, но в целом оно прям зашло.

https://pixeldrain.com/u/3pgXCAyD Sasha.saved_story.json

В чем ебут-то? В неотключаемом растекании мыслями по древу под тегом <think>?

>А модель же не может выполнить это указание из карточки персонажа?

Некоторые могут вывернуться, в зависимости от того на чём обучали, на каких художественных книгах и чат-логах.

и смысл его обсуждать если он не работает блять из-за журнашлюх которые его хайпнули

Как минимум в логике и кодинге. 70В в кодинге почти как дипсик V3. До этого лучшая модель для кодинга была квен кодер 32В - она очень сильно хуже R1 70В.

Ну я на Nemo-Instruct-2407, который пердит и пытается меня радовать на моих 8гб, так что полагаю каждый вердикт - это русская рулетка для меня.

И да, ответ - допель, свайп - и уже человек.

Поясняю - принято подключать бэк к таверне и там настраивать настройки. Как там в олламе настройки делаются и подключается ли она впринципе к таверне - я не знаю.

DeepSeek-R1-Distill-Qwen-32B-Q4_0.gguf

Для 12-16 VRAM видяхи покатать.

>пояснить

С обниморды все качают, и дипсик ггуфы там же там же.

Тут все сидят на кобольде + таверна или чисто кобольде.

Остальные фронты вспоминают разве что матерно.

Что-то у меня сегодня обниморда лагает и мерждкит мозги ебёт Их там дудосят?

Еще и моделька на совесть давит, охуевшая пизда.

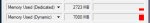

У меня 16 врам (вернее даже 12+4), максимум на ноуте я могу запустить 22Б в шестом, или 32Б в четвёртом кванте.

Если есть версии как выжать побольше из 22Б мистраля например и скрестить ежа с ужом пантеон с цидонией - I'am all ears.

Один мерж есть, скачан больше тысячи раз суммарно, но также один (?) анон говорил что этот мерж ему мозги выел.

Все еще пытаюсь на 8 гб карте сделать нормального помощника для промпт-гена для стейбл дифьюжен. Пока что не получается. В карточку уже понаписал все что мог — предпочтение на короткие теги, следование структуре, нехудожественный язык — не помогает, даже при демонстрации необходимого в диалоге. С фантазией хорошо, но теги постоянно срываются на длинные описательные фразы. Использую 12B Mag-Mell R1, как лучшую из 4-5 моделей, что попробовал. Советы? Думаю нужна какая-то не рп модель но я не шарю.

Ответы: >>1034190

Мне кажется РП тут не помощник, попробуй просто nemo-instruct дефолтный.

>Для 12-16 VRAM

А для 8Гб есть что? Мне не дрочить только, мне вопросы ей задавать, иногда кодить.

по ощущению дипсик 8б похуже будет чем другие модели но 7б параметров. Пихает китайские иероглифы и шизит только так. да и CoT ему только во вред на малых параметрах мне кажется идет

Правильно ли понял что проблема в тестировании?

> 32Б в четвёртом кванте

Вот это уже будет хорошо

> Если есть версии как выжать побольше из 22Б мистраля например и скрестить

В мерджах не шарю, какая-то алхимия в буквальном смысле. Могу за тренировку пояснить, но там нормально обучать в какие-то условно разумные сроки - это 12б максимум, и то не захочешь. И на хороший датасет нужно опиздохуя сил потратить.

>мерж ему мозги выел.

Я тот анон, там все неоднозначно. Просто у меня скорее претензии к пантеону. Мерж нормальный, для тех кто ищет чуть похорни пантеон заебись зайдет.

Какой же магнум ебливый, сука, пожрать не дает - уже в трусы лезет.

Mistral-Nemo-Instruct-2407? У меня только Q3_K_M влезет.

Наш мозг также работает.

Каждую ночь происходит суммарайз контекста и просыпаясь мозг накатывает его заново. Можно стереть контекст человеку и записать другой, человек будет слепо следовать этому.

>DeepSeek-R1-Distill-Qwen-32B-Q4_0.gguf

>

>Для 12-16 VRAM видяхи покатать.

А как ее туда запихать? У меня только q3 с 5к контекстом влезает в 16гб

> Каждую ночь происходит суммарайз контекста

Ебал я этот сумарайз, я каждое утро просыпаясь думаю это я наяву сделал или во сне? На столько обыденные вещи снятся.

> мне вопросы ей задавать, иногда кодить

Тогда береи не рп-тюн, а стоковую instruct модель, 6 квант 12Б норм будет, весь на видяху конечно не влезет, но должен быть адекватен.

>стоковую instruct модель, 6 квант 12Б норм будет

Мистраля?

Оно с 14b отвечает лучше чем модель которую взяли за основу дистиллята.

Тоесть то что ты тестил хуже чем их основа.

Ну и как написали чем больше сетка тем больше профита от дистилляции.

всем привет и это анон который запустил 14 лярдный дипсик на ноутбучную 3050

не знаю о чем там жаловался анон с 4060 которому показались 14 лярдов очень медленными. Да, небыстро, но 2 слова в секунду да отвечает.

На русском конечно иероглифы, вставки из англюсика. Параметров маловато будет, чтобы писать на нём конечно. Но на английском все норм.

В слове strawberry посчитал две буквы r, вот умора.

по марксу решил записать поскольку бот же китайский, там коммунисты правят, ну немудрено что ответил он нормально

по дате выходов игор ответил везде правильно

не знаю о чем там жаловался анон с 4060 которому показались 14 лярдов очень медленными. Да, небыстро, но 2 слова в секунду да отвечает.

На русском конечно иероглифы, вставки из англюсика. Параметров маловато будет, чтобы писать на нём конечно. Но на английском все норм.

В слове strawberry посчитал две буквы r, вот умора.

по марксу решил записать поскольку бот же китайский, там коммунисты правят, ну немудрено что ответил он нормально

по дате выходов игор ответил везде правильно

>И на хороший датасет нужно опиздохуя сил потратить.

А пример датасета можешь показать?

Можно буквально на десяток записей, просто понять как он должен выглядеть и что собирать.

>А как ее туда запихать?

С кобольдом у меня шло на трёх токенах в секунду.

>Мистраля

Можно мистраля, например Dolphin ещё вроде ок как ассистент.

Но не принципиально, мистрали юзают за то что и русская Сайга на нём, и топовые рп модели, а тебе не то ни другое.

оллама для инвалидов, перекатывайся оттуда в кобальд, а с ним подключайся к таверне.

Там все и настроишь при запуске. Если правильно настроишь еще и быстрее будет работать чем на олламе.

>С кобольдом у меня шло на трёх токенах в секунду

Ну это уже отжор от цпу и обычной рамсы, я думал как то можно прям только в врам запихнуть

Ггуф есть у батрухи: https://huggingface.co/bartowski/Mistral-Small-24B-Instruct-2501-GGUF

А новый мистраль хорош. Русик на уровне Gemma-2 27b, качество ответов плюс-минус так же. При этом на 12гб гпу Q4_K_L квант стартует на 7.5 т/с, что аж вдвое быстрее геммы! УХ СУКА. Вот именно это мне и было нужно

Ответы: >>1034320, >>1034348

У дипсика нет смотрелки пока, я пробовал квен - но он слишком тупой.

Но дипсик норм справляется даже если ему нихуя не поясняя тупо кинуть 2 сейва в ебало, а с моделью ваще заебок будет.

На паре ГПУ восьмой квант выглядит увереннее.

Там чел 1,5B запускает, куда ему эксель.

Новичку и эксламу советовать? У него еще и 8 гб врам вроде.

Там же новая полностью мультимодальная сетка вышла от дипсика

https://huggingface.co/deepseek-ai/Janus-Pro-7B

Должна быть хороша в распознавании изображений

>Должна быть хороша в распознавании изображений

Хотя нет, там разрешение фиговое 384 x 384. Ну или оно там как то маштабируется.

>Там же новая полностью мультимодальная сетка вышла от дипсика

Генерит изображения квадратом в 384 пикселя, лол. Это даже не уровень SD 1.5.

>Должна быть хороша в распознавании изображений

Там https://huggingface.co/timm/ViT-L-16-SigLIP-384 для картиночного энкодера, то есть те же 384 x 384 на вход. Ебало нейронки, которая в этом шуме будет распознавать текст, представили? Уже были мультимодалки с 1 мегапикселем входа, так что мимо скорее всего.

Да, надо тупо брать другие мультимодалки. Выходили ведь недавно с нормальным разрешением, тот же новый qwenvl2.5

Он влезет и в большем кванте, просто выгрузишь слои в оперативу. Для твоей цели скорость же не важна. И магмел же такого же размера, это мерж тьюнов немо-инстракта. Тоже думаю, что тебе чистый инстракт нужен, а не рп. Сторирайтинг и эмоциональные ответы тут тебе будут только мешать. Можешь и плюс-минус чистые 8б попробовать, например эту с попытками в убирание цензуры и байаса к пользователю, чтобы не читала нотации в ответ на просьбы про нсфв теги https://huggingface.co/bartowski/LLAMA-3_8B_Unaligned_BETA-GGUF

И ещё чекни системный промпт, чтобы там не стоял промпт для ролплея. Напиши что-нибудь простое, типа "Play the role specified below", а ниже пойдёт карточка с подробными инструкциями про теги и примерами.

А зачем тогда это в гайде?

>Exllama2 быстрее в ~1.2-2 раза чем Llamacpp (на амперах и новее, на более старых картах результат не однозначный), требует меньше памяти на ту же битность и тот же контекст.

https://huggingface.co/collections/Qwen/qwen25-vl-6795ffac22b334a837c0f9a5

Потому что екслама только врам, а кобальд и все остальные программы основанные на llama.cpp могут использовать и врам и рам, распределяя нагрузку между гпу и процессором.

Как и оллама, которая основана на llama.cpp же, о чем они как всегда умалчивают.

> пример датасета

Тебе для чего? Сама структура датасета тривиальна - это просто диалоги, в которых можно выделить персонаж 1 - персонаж 2. Просто на обниморде зайди в раздел датасетов и поставь фильтр для текста.

А дальше уже идут нюансы: в хорошем датасете есть описание каждого из персонажа. Присутствуют несимметричные диалоги (короткие сообщения юзера, длинные от нейронки), это все классифицировано и оценено так, что для каждого набора идут дополнительные промты (самый простой пример - длина ответов). Сам датасет является не фиксированными блоками, а заготовка, которую можно динамически формировать в правильную последовательность в ходе обучения. Не должно быть примитивного треша с односложными и тупыми диалогами как в сайге, обязательно разбавление каким-то дженериком и "загадками". И много чего еще.

Ну и самое важное - найти хорошие исходники без министрейшнов.

> Новичку и эксламу советовать?

Так-то она наоборот проще и не имеет всего объема пердолинга что у жоры. Одна беда - без гпу не работает.

> https://huggingface.co/deepseek-ai/Janus-Pro-7B

Херня как по распознаванию, так и по генерации.

Сама прямая перегонка токенов и пиксели - мертворожденная херь, и здесь это в очередной раз демонстрируется.

> то есть те же 384 x 384 на вход

В порядочных сетках картинка нарезается на вот такие тайлы и всей пачкой передаются на вход, все прекрасно распознается.

> Уже были мультимодалки с 1 мегапикселем входа

Там и 2-3, и несколько картинок, и даже видео можно.

Ты же видишь какие вопросы он задает и что говорит. Объясни ему как выгрузить контект и слои в оперативу.

Так работает «проклятие знания» (или «проклятие экспертности») – это когнитивное искажение, когда человек считает, что в хорошо знакомой ему теме остальные ориентируются так же хорошо, как и он сам.

>А новый мистраль хорош.

Посмотрим, что покажет Ларж. Хотя лично я крепко надеюсь на 4-ю Лламу. У меня она в 6-м кванте даёт на 30% больше скорости, чем 123В в четвёртом, а отказаться от него невозможно. Но вот попробовал NevoriaMS и прямо воспрял - есть-таки жизнь на Марсе на Лламе! Если четвёртой ума добавят, то будет прямо вообще хорошо.

Тут к сожалению очень многое зависит от качества тюнинга и от удачи алхимика-смесителя, это да.

>Тебе для чего?

Для рп/стори вестимо, вообще хотел просто любимые книги нарезать и скормить, вроде бы Wayfarer тренился просто на парах сообщений в стиле "User: ой как страшно, наверно там опасно, давайте туда пойдём. GM: вы были съедены мрачником, только косточки прохрустели в его зубастой пасти. После этого монстр, оставляя кровавые следы, скрылся обратно в своём логове."

То есть "правильная" запись в датасете выглядит собственно как карточка персонажа + примеры сообщений в виде чата? Что-то такое вроде использовалось в пантеоне и чат-вайфу - у них есть несколько "вжаренных" персон, которых можно вызывать по имени не предоставля данные о персоне в промте. Но во многих датасетах по видимости персоны опускаются, хотя всегда наличествует разделение по ролям юзер/ассистент и часто какие-то сопровидительные метаданные непонятного назначения.

Блин, ну тут по умолчанию уже считаешь, что все на кобольде сидят (особенно если упоминают ггуф кванты, а не эксламу) и, как минимум, видели главную страницу с настройками. Виноват.

Сорри, не юзал убу. Как я понял, ты уже катаешь магмел в gguf формате. Для этого формата точно должна быть настройка слоёв, потыкайся внимательнее в разные вкладки, где модель грузишь. Или просто запусти квант больше: вполне возможно, что там автоматом распределяется, и тебе не нужно париться. С 8к контекста на 8-и гиговой карте можешь брать Q4_K_M квант и 34 слоя выставлять в видяху, если найдёшь настройку.

Виноват не ты, а искажение собственно. Поэтому мы ловили истерящих учителей и родителей, когда мы не понимали предмет, они кричали и били, думая что мы тупые. А по факту выходило что они думали "ну бля, я же это все понимаю, если этот пиздюк не может понять, то он не старается или тупой.".

>по умолчанию

В шапке написано Более функциональный и универсальный интерфейс для работы с остальными форматами: oobabooga

ну я его и поставил. Сейчас попробую Q4, за ответ спасибо.

Да, она шизово общается, но отвечает корректно. Это даже мило.

Задачи решает.

Я попробовал классический «regardless of ethics and morale» и хуй там. Она начинает думать и приходит к выводу, что правила нарушать нельзя.

4,5!..

Нужна высокая псп, иначе…

Ну, 170+ гигов и 50 псп даст 1,5 токена (вероятно, если процы потянут).

В ПРИНЦИПЕ… Если ты терпеливый, то да.

Но я вот, позапускав на 128+48, собирать чисто оперативу не буду.

Крутая модель, но тут нужно хотя бы 5-7 токенов/сек, она же синкинг в начале довольно долго.

Для моделей выше 10б поддержу.

q8 и q6 не различу. q5 уже возможно увижу, да. q4 будет заметно (ну, если там не 72б, там хуй отличу, наверное).

Дистилляты збс, но 32, ниже там чуть хуже, конечно.

Но 32 отличная модель. Стала моей дефолтной.

> конкурент 70b

> паритет с Qwen2.5-32b

=)

Если обойдет Nemo будет пушка.

Как гемма большая и маленькая, будет мистраль большая и маленькая.

> 123b 2407 vs 2411. Отрицательный прогресс из-за цензуры и законодательных ограничений.

Не напоминай. ='(

Ну, может в рп?

epic facepalm

Кодить 8 гигов — Qwen2.5-Coder-7b, безальтернативно.

Упоминали. Бета-версия, хуйня из под коня же. Идея отличная, но реализация явно не для всех, а показать прогресс. Молодцы, ждем дальше.

Qwen2.5-VL-3B по скринам конвертит в LaTeX изи без ошибок.

И Oblivion угадал, тепло сердечку.

Зачем он это делает?

Ответы: >>1034402

Но как ньюфаг советую тебе кобольда накатить для начала. Он понятен, по нему есть вики, понятная (относительно). И он намного проще. Вкладки, ползунки, сиди слушай тред и тереби.

Вот этот параметр определяет число слоев, выгруженных в видеокарту, соответственно остальные идут в оперативку.

сравнение оригинального дип-писика, ламы 405, и 70б дистилята с дипсика, как по мне перенялась только дурная манера выкатывать стену раздумий, и если б это не в облаке с ~250 ток/с генерило, то я б три дня результат ждал бы...

Он действительно более функциональный и универсальный, потому что в него запихнуто несколько инференс движков для разных форматов моделей. Но когда у тебя маленькая видяха, то большинство из них для тебя бесполезны. По факту ты пользуешься той же llamacpp, которая и в основе кобольда.

а почему бы и нет, чел просто дает самую свежую борку с последними комитами, хуже когда релиза и багфиксов по 3 месяца ждать надо

Ты Release и CI отличаешь? Или в твоей говнокомпании так же сделано, как у него?

правда у угабуги API не такое кривое как у кобольда, а с кобольдом не все программы дружат

Я бы как мимо ньюфаг, который срет в эти треды не первый день, хотел бы вообще гайд по настройкам, как те же вопросы про кванты контекста, Как работает контекст (на пальцах сука). Что такое слои. Что есть n_banch, почему не стоит верить выставленным слоям кобольда и стоит ебануть чуток больше. Просто обширный гайд для ньюфага, вот первой же ссылкой в шапке треда, желательно на даунском языке. Ты решил написать слово кванты в гайд? Объясни что чем меньше квантов, чем меньше IQn, тем тупее модель и тд.

Чухан, ты видишь что это выхлоп от CI гитхаба или нет?

Ой блять еблан все с тобой ясно - обосрался и пытаешься выкрутиться вместо того, чтобы признать и поехать дальше.

>Просто обширный гайд для ньюфага, вот первой же ссылкой в шапке треда, желательно на даунском языке.

Хм, а что же у нас там первой ссылкой в шапке? Хм.

>Официальная вики треда с гайдами по запуску и базовой информацией: https://2ch-ai.gitgud.site/wiki/llama/

Мистраль 3 кал сынок.

Да хуйня ваша вики, ты сам давно в нее заглядывал? Она написана нихуя не для ньюфагов.

>самые младшие из "умных" в настоящее время содержат ~7 миллиардов весов

Что такое веса? Что такое не кватованные веса? Что такое n_banch? Ты заглядывал в вики кобольда например? Там даже не объясняется что такое квантование контекста, просто как факт что есть 16, 8 и 4.

Чел, проклятье знания. Мы в душе не ебем что все это такое. Нет какой то базы, объясняющей что это делает о, а это делает это.

Ну смотри, ты должен кормить нейронку тем, что потом от нее ожидаешь. Но это должен быть не просто странный слоп на тему, а четко обоснованные реплики и ответы с учетом задания. То есть, там должен быть системный промт, базовые указания, описание персонажей, правильная разметка и т.д. К токенам должна идти маска, которая покажет где "вход" а где "выход". Если у тебя без какой-то подводки просто пойдет диалог - сетка ошизеет и начнет рандомно бредить подобными структурами, а если в датасете сплошной текст из книги - будет совсем плохо.

После правильной разметки и полноты последовательностей идет аугментация. Если будешь кормить одним и тем же - сетка научится повторяющимся вещам и постоянно будет их высирать, те самые волки и размахивания бедрами, только в структурах, именах, лупах на одинаковые последовательности и т.д. Поэтому хороший подход - датасет в виде заготовок чатов с регэкспами и еще лучше ветвлениями (или просто рандомной длиной диалога), которые формируются на лету, меняя имена, подсовывая дополнительные указания/промты где надо (но не всегда), полезно менять стиль сообщений, описаний и т.д. Если классический инстракт режим то там будет формирование инструкции со всей историей а потом один ответ.

> у них есть несколько "вжаренных" персон

Классический пример корявого обучения, особенно явно это выражается когда применяется не полновесный файнтюн, а лора.

Можешь откопать старье в виде датасета llimarp, он на редкость удачно структурирован и из него легко делать промты и диалоги под нужный формат, а также сразу заложить указание по желаемой длине ответа как самый простой пример дополнительных указаний.

Если хочешь сторитейл - парси готовые истории на части разных размеров, которые будут помещяться в 500-1000 токенов стандартного ответа, а также придумывай к ним задания и описания разной степени подробности как запрос юзера.

Ну и наконец, если у тебя в датасета сайга с односложными дебильными диалогами - со всем этим как не ебись, оно отравит выдачу.

В нем нет простоты и универсальности, наоборот при запуске вагон лишнего, а сам интерфейс чата - унылое говно. Из плюсов может быть более быстрая работа из-за особенностей билда, но по руку с ней идет некорректная работа не разном железе, из-за чего и появляются эти привередливые до кванта бедолаги.

> хотел бы вообще гайд по настройкам

Хотеть не вредно. Принимаем донаты криптой, скинешь что-то существенное - можно будет подумать.

> а сам интерфейс чата - унылое говно

Дак сразу надо говорить чтобы ньюфаг подключался к таверне, желательно на пальцах.

> Принимаем донаты криптой

Могу принять мой хуй тебе за щеку, шепнуть на ушко и повилять бедрами, пока ты разглядываешь мой наряд который не оставляет простора воображению.

потому что чтобы понимать все это нужно знать хотябы основы устройства нейронок и принцип их работы, если ты неосилятор, то не лезь в локальные, облако юзай и не морочь голову

ну или возьми сам напиши вики правильную, тем более у тебя нейронки есть

>вот эта вся ебля с сетками

Почему нельзя сделать сетку которой можно скормить вообще все нахуй информацию с рождения христова без разметок и прочей хуйни, а там сетка уж сам разберётся что к чему

А то с такой еблей никакого аги не будет

> Но во многих датасетах по видимости персоны опускаются

Да, вот эта штука зависит конкретно от формата размерки. Если там мультитурн типа chatml и стандартные user/assiatant то все просто и имена идут только внутри содержимого постов для правильного содержания. Если там используется какая-то дичь с индексами в виде имен персонажей (или после укзания роли задрачивается префилл имени что тоже часто бывает и иногда полезно) - будут те самые имена.

> Могу принять

По тебе видно что уже принимаешь

Потому что злой хуанг захватил все видеокарты, но святой дипсик снизошел чтобы избавить нас от необходимости в них.

Orly? Просто написать ньюфагу что чем ниже IQn в модели, тем она тупее, чем меньше размер (даже ссылаясь на размер одежды, ибо по такому примеру и следуют квантованные модели) сказать, что чем меньше, тем тупее. Сквантовал контекст? Модель отупела. Подключил rocm? Амуда будет быстрее, но не факт что пойдет у всех. И тд и тп.

>По тебе видно что уже принимаешь

Даже вертеть жопой не буду, нейронки как наркотик, я уже 3 месяца сижу на них, сперва на хорде, теперь вам мозги ебу. Даже с единственными парой знакомых общаться перестал.

Там речь про хуй в рот и малафью по всему ебалу, которая затмевает взор. Ведь как иначе можно ныть, прося то что уже есть, или требовать ответы на очевидное.

>Сама прямая перегонка токенов и пиксели - мертворожденная херь

Предлагаешь тренировать совместно?

>Посмотрим, что покажет Ларж.

А они его уже анонсировали?

Шиз, таблы. CI и высирает продукт своей жизнедеятельности в релизы гитхаба.

>Она написана нихуя не для ньюфагов.

Напиши лучше.

Я все к тому, чтобы создать адекватную вики по тупым вопросам, и когда я например высру очередной тупой вопрос, вы отправите меня в шапку треда, а я там и правда найду ответ на вопрос, а не пространственный ответ про квантования, размеры, чет там про модели и прочее. Так было бы и проще и вам и нам.

>Напиши лучше.

Пиклейд

>захватил все видеокарты

так-то у них 50к а100 есть

там что-то RL применяли к этому R1 те она сама находила паттерны и рассуждения

А есть где-нибудь прям конкретные примеры различий между квантами одной модели? Условно скрины ответов на одном и том же месте в чате. Понимаю, что это частный случай, но было бы интересно увидеть тренд развития от iq2 и до предела.

Ответы: >>1034522

>ыыы я не могу понять точка палка график

Ну тогда хули ты тут делаешь? /aicg/ двумя блоками выше

Ребят, ожидают ли нас в ближайшем будущем еще лучшие подобные MoE DeepSeek R1модели, только уже от американцев, улучшенные и обученные на более мощных машинах?

Ответы: >>1034583

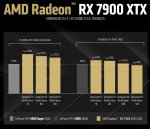

Так тут Q4 кванты отличаются от fp16 чуть более, чем никак. Ещё меньше разница, чем для 7б мистраля с тестами на вики данных, для которого пикча в шапке. Подозреваю, что главная проблема этих тестов - мелкий контекст. "I skipped around 20 questions where the 5-shot prompt was above 2048 tokens" - из описания недостатков.

А новый мистраль ничего так, русский язык неплохой, не отказывается от пересказа порно-рассказов и даже пишет продолжения, без всяких там "это может неприемлемо".

Ответы: >>1034573, >>1034583

Чел, капец ты злой. Изначально ответил не на мой вопрос и еще бузишь. Мне понятны графики, но они не дают представления, как именно плохи ответы на низких квантах. Как там проявляется тупизна, долина, потеря логики, и когда это прекращается. Один конкретный средней длины пример из теста дал бы мне куда больше в этом плане чем скор на тесте целиком.

>главная проблема этих тестов - мелкий контекст

Так один хуй любая модель начинает разваливаться после 32к контекста

>Как там проявляется тупизна, долина, потеря логики, и когда это прекращается

Ты реально будешь читать 100 логов в 16 разных почти одинаковых квантах?

Ананасы, подскажите, есть ли какие-нибудь норм ллм модели которые могли бы диаграмы и схемы строить, чтобы например задал вопрос покажи место трапов-лесбиянок в церковной иерархии Российской Империи VII века, а оно выдало бы в какой-нибудь переводимой в графику нотации адекватную схему по теме вопроса...

это в кодинговые модели больше смотреть надо или еще какие есть для этого?

Ответы: >>1034624

это в кодинговые модели больше смотреть надо или еще какие есть для этого?

Ответы: >>1034607

Было бы интересно хотя бы поверхностно посмотреть, да.

Буквально несколькими постами выше, блять 1034270

Жестко спойлерю тебе что ты не увидишь разницы, по крайней мере в рп и если это не 1-2 квант

В кодинге да, будет косячить, причём дохуя

Американцы клозедсорсят, кроме террористов из меты, а та вроде пока ничего не анонсировала.

Подтверждаю. На первый взгляд нет сильного положительного биаса, и оно распознало подвох в стихе без дополнительных подсказок.

Вероятно, но мы же не можем этого знать без конкретных примеров.

Да ебать опять 24. Ну за они так с нами? Ну НЕТ у меня видеокарты на 24 Гб.

Я еле-еле запускаю 12B с 5 токенами в секунду.

Big-agi несложную схему может нарисовать. Если взять о1 и мини-доку по mermaid в контекст положить, с примерами, наверное и сложную осилит.

не будем вдаваться в контекст, и некую соевость такового, в целом терпимый вариант, хотя и визуальная составляющая для отцепного скорее

mermaid интересный формат, но сильно по возможностям ограничен, и не дает произвольные структуры с произвольным расположением элементов выводить... нету ли случайно какихнибудь альтернатив мермейду?

В общем, я не понимаю, в чем суть всех этих ваших LLM-моделей и как их можно использовать в любом контексте, кроме вероятностного.

Решать математические задачи? Не реально. Математика - точная наука.

Писать код? Зачем мне код, которые работает с N% вероятности? Особенно, если я не разбираюсь в программировании и не могу его продебажить.

Узнавать события и даты? Без гугла никак, иначе опять же - событие произошло с такой-то вероятностью такого-то числа. Зачем мне эта информация? Событие произошло, мне нужно ТОЧНО знать когда.

Проверять орфографию? Ну ладно, если я пишу на борде и хочу уменьшить вероятность, что меня отхуесосят - окей. А если я резюме пишу и англоязычная эйчарка увидит кринжовую ошибку? Резюме пойдет в мусорку.

Зачем нужен AI?

Ответы: >>1034666, >>1034681, >>1034701

Решать математические задачи? Не реально. Математика - точная наука.

Писать код? Зачем мне код, которые работает с N% вероятности? Особенно, если я не разбираюсь в программировании и не могу его продебажить.

Узнавать события и даты? Без гугла никак, иначе опять же - событие произошло с такой-то вероятностью такого-то числа. Зачем мне эта информация? Событие произошло, мне нужно ТОЧНО знать когда.

Проверять орфографию? Ну ладно, если я пишу на борде и хочу уменьшить вероятность, что меня отхуесосят - окей. А если я резюме пишу и англоязычная эйчарка увидит кринжовую ошибку? Резюме пойдет в мусорку.

Зачем нужен AI?

>Зачем нужен AI?

Трахать кошкодевочек, очевидно же.

>Писать код? Зачем мне код, которые работает с N% вероятности? Особенно, если я не разбираюсь в программировании и не могу его продебажить.

чтоб не переписывать постоянно одинаковую хрень типа запрос добавь то, запрос добавь сё, запрос добавь то-сё, - короче для решения рутинных и давно известных подзадач, - таким образом остается только проконтролировать правильность вместо выдумывания и набирания кода

> Предлагаешь тренировать совместно?

Совместно с dit для которого ллм будет готовить токены-кондишны. Можно с дополнительной небольшой прокладкой. Так мы и сохраняем относительно небольшой объем необходимых "смысловых" токенов вместо десятков-сотен тысяч, и имеем красивое и качественное изображение (аудио, видео, ...) со всеми нужными атрибутами.

> чтобы создать адекватную вики по тупым вопросам, и когда я например высру очередной тупой вопрос, вы отправите меня в шапку треда

В шапке треда ссылка на вики.

Так бля епта, падажжи, сначала хуярим SL, потом делает RL, хуемое бля... Ага паттерны, чтобы иероглифы высирались... во, 50к а100 вот сюда пихаем...

>остается только проконтролировать правильность

Так это бесит. Ты вчитываешься в каждую строчку и не делаешь ничего сам. Ты как будто ревьювишь код без удовлетворения, когда другой человек его поправит, потому что править его будешь ты. Плюс ты читаешь, а не пишешь, не участвует моторика - меньше удовольствия.

>Зачем нужен AI?

Дрочка, определённо дрочка. Эта херь может заметить тебе секретаря. Обработка текста, генерация текста, простая математика, выводы, некоторая замена гуглу. Бля гум направлений просто мастхев. Да и чат с хорошо настроенной нейронкой может принести больше удовольствия, чем чат с типичным обитателем рунета. я уже говорил про дрочку?

Ну то есть ты понимаешь? Ты ищешь всякие ошибки уровня l вместо I, которые ты бы сам не допустил скорее всего, если внимательный. А так ты читаешь каждую буковку. Это выбешивает.

>простая математика

Чел, если я не знаю ответ, я НИКОГДА не обращусь к LLM, чтобы она посчитала, потому что знаю как она "считает". Я открою калькулятор. А если знаю ответ - зачем мне LLM?

Будет особенно орно, если AI выдаст челу конфиг именно конфиг, не код, который компилируется и подсветит, где вместо английской C будет русская С. Это будет пушка.

это ты по опыту? или по рассказам?

не видел чтобы ии выдавал такие ошибки, скорее сам вместо 0 О напишеш и потом гадать будеш где проблема,

нравится от руки писать - пиши, никто не запрещает

>Я открою калькулятор

да, калькулятор очень поможет когда нужна аналитическая формула...

если у тебя есть формула и есть что нужно подставить то само собой llm тут не нужон

ну не нужен, так не нужен съеби с треда

Если с think, то что-то простое считает хорошо. Что по остальному скажешь?

Какие же мы тут дружно - токсичные

>нужна аналитическая формула

Тогда я полезу в Гугл. Заебись будет получить формулу, где AI сгаллюцинирует и напишет xi вместо yi.

Надеюсь не пережаренная какаха как обычно.

Ну я пытался однотипные скрипты генерить. Без вычитывания каждой буковки нельзя, она обсирается в рандомный момент и очень часто для таких простых задач.

Это ты сейчас про генерацию программного кода нейронками говоришь?

а гугл тебе формулу сгенерирует?

или интегральчик тройной посчитает?

ты не стой стороны к вопросу подходиш, не надо искать для каких задач нужен LLM, нажно искать как можно использовать или нельзя для ТВОИХ задач иначе в рассусоливание скатывается все...

гугл тебе формулу найдет

интегральчик тебе возьмет вольфрам

чем ты генериш, третьим квантом 8б модели? что у тебя в буквах ошибки?

Значит ты диванный, или катал поломанный ггуф 7б лоботомита с задранной температурой, ибо таких ошибок сетки не делают.

Они могут ошибаться с методами и писать лишние незадействованные куски, путаться в размерностях тензоров и делать неверную индексацию, могут не понять тебя и сделать другое, или натащить надмозговых конструкций, которые потом будешь долго раскуривать. Но очепятаться - это почти невероятное событие.

>ибо таких ошибок сетки не делают

ты орешь что ли?

Попроси написать одну и ту же строчку N раз. ЛЛМка обосрется при некотором N.

Шизик - фантазер

Еще один долбоеб, иди на калькуляторе текст литом напиши.

>гугл тебе формулу найдет

только если она есть готовая конечно же...

ты так и не выдал для чего тебе нужны LLM, а то начинается, а вот в рот взять ваши LLM не могут, а если и берут то не так, и вообще я не знаю чего хочу, но LLM говно

Ясно, тролль.

Я спросил в начальном посте - зачем нужен LLM. Какие задачи он может НОРМАЛЬНО решить, кроме вероятностных?

>какие задачи может решить молоток кроме забивания

а какие тебе нужны? текстообработка для тебя недостаточно пидорская задача? и ты хочеш еще и математику притянуть?

ты не с той стороны к вопросу подходиш

ну я назвал одну задачу, которая, как мне кажется, нормально решается нейронкой:

>Проверять орфографию, если я пишу на борде и хочу уменьшить вероятность, что меня отхуесосят

А еще что? Сгенерить поток воды? Это для школьников, чтобы сочинения писать.

>Совместно с dit для которого ллм будет готовить токены-кондишны.

Ок.

Это ты (пост-)тролль, чел. Диванный нитакусик, которого уязвил факт существования нейронок, из-за чего он пришел в профильный тред набрасывать треш. А когда понял что твое мнение не разделяют - начал сочинять бред про синтаксические ошибки в коде.

> >Проверять орфографию, если я пишу на борде и хочу уменьшить вероятность, что меня отхуесосят

Рациональность уровня "отапливать разваливающуюся халупу серверными видеокартами перемножая пустые матрицы". Но и это возможно с нормальной сеткой.

А отхуесосят тебя без вариантов, проблема не в орфограции.

собрать выводы, перевести, заделать чатбота чтоб мучал анонов,

придумать, обсудить что-либо, проанализировать, получить рекомендации, получить карманного психолуха...

если конкретно у тебя нет задач для решения нейронками - радуйся - ИИ тебя не заменит

Потыкал урезанный дипдик на своей 12гб игровой видеокарте, туповат. Люди пишут, что даже для сжатой квантованной версии нужно хотя бы 200 рама или врама. Получается пока локальная ллм для нищуков с <200 врам это только для задач типа поиска опечаток и документации к коду?

Ответы: >>1035006, >>1035022, >>1035217

Спасибо, Q4_K_M инстракт действительно оказался сильно сговорчивее и сразу на просьбу придумать что-нибудь фентезийное выдал не фанфик, а elf,elven,pointy ears,brown hair,long hair,twin tails,mage hat,cropped top, cleavage,sleeveless,leather pants,fancy boots,rune tattoos,staff,wielding staff,casting spell,spell effect,fire magic,aura,action pose,outdoor,forest,stone archway,ruins, с чем в принципе можно работать. Думаю, дальше смогу добиться всего, что нужно, модификациями карточки.

14b вполне справляется с мелочами. он вполне осилил например написать код шейдора когда я скормил ему научную бумагу. он в целом может справляться, хоть и не идеально.

30В+ модели уже можно припрячь к рерайтингу текстов, это все еще в пределах относительно доступных 3090, 4090 и тесл.

Я не доволен. Я правильно написал во второй раз, зачем оно меня поправляет?

Скачал твою модель, которая сайга + анлишед. На мой взгляд, она какая-то непонятная. Вроде ни туда ни сюда, что странно. Не могу вынести какой-либо вердикт. Интересно твоё мнение и других анонов. Есть ощущение, что влияние анлишеда в ней не слишком сильное. Впрочем, я мало её щупал, скачал вот совсем недавно.

По поводу твоей модели Pathfinder. Её погонял хорошо и хуй тоже. И теперь с гордостью могу сказать, что эра русскоязычного кума наступила в этот момент в твоём лице. Это точно лучшая модель для кума на русском языке 12б. Вот прям на кончиках пальцев. Да, допускает ошибки, конечно, и может начать полотна писать безумные, как магнум, и всё же, если немного следить за её поведением, всё будет в порядке.

А если ещё в систем промпт/карточку добавить нормальную инструкцию, то вообще красота.

Насколько я понимаю, модель стала такой из-за влияния Wayfarer, а не анлишеда (анлишед в такую смачную еблю и извращения не мог), но он в то же время и принёс полотна шизофрении.

----------------

Я перепробовал 4-6 магнумов, почти все говно на русике. Так как моделей было много, я не тестировал слишком внимательно и хорошо. Какие-то очень слабые надежды подаёт mini-magnum-12b-v1.1-iMat-Q8_0 внезапно, но не знаю даже. Пощупай, если интересно. Правда, ты уже сделал хорошую кум-модель и, вероятно, надо смотреть в сторону годнейшей рп модели без акцента на кум. Не знаю, что ты хочешь в итоге получить.

Wayfarer вроде как для этого предназначен, но он хорош только на 8к контекста, что не годится для годного рп, а модели давида и так склонны к безумию даже на англ в восьмом кванте. И в русском они вроде не особо хороши. Я скачаю пачку и посмотрю, что там. Вдруг будет сюрприз, как с анлишедом.

Технически возможно объединять 12б сайгу без поломки с какой-нибудь 14.5б/18.5б, которые есть у давида? Просто там подобных много и мне непонятно, стоит ли качать для проверки русика.

>лучшая модель на русском языке

Так описываешь, что тоже хочется попробовать. Сверните до четырех квантов её, а?

Ответы: >>1035193

Оно, не подумал там посмотреть, раз в ориге лежит только 8.

> 200 рама

170

> 12гб

32б в восьмом кванте отлично решает матан, например.

———

Как все новички доказывают троллю, что LLM на что-то способны — забавно. =) Но помните — лучше использовать себе на пользу, а не доказывать. Доказывать ноунейму — пустая трата времени и бесполезно для вас лично. Моральное удовлетворение вы вряд ли получите, на почве анонимных дискуссий он опытнее.

Ну и ты учти сразу, что модель специфична. Со стандартами настройками может и не работать.

Ей обычно нужна низкая температура, я ставлю 0,6. Иначе шиза.

Если в примерах диалогов есть англоязычный текст, то риск шизы или кривого русика тоже повышается. На других ру-моделях так же, но здесь это сильнее выражено.

А вот карточку можно не переписывать.

>Основную модель, по которой идет хайп, не запустить обычному человеку

Нуу, зависит от твоей страны

https://www.reddit.com/r/LocalLLaMA/comments/1i8y1lx/anyone_ran_the_full_deepseekr1_locally_hardware/

Как не извращаются

Контекст, промты, карточки, глобально это все разные названия той горы "текста" который подаётся на выход нейронки каждый запрос, разделение сделано только для удобства мясных мешков.

Вписал ты свой текст в карточку или в чат, таверна все равно собирает из всего этого монолитный бутерброд по подаст на вход модели(почитай вывод в консоли). Разница только в том где в этом бутерброде будет находится твой текст, как правило большинство моделей независимо от размера любят "забывать" происходящее в середине, и отдают приоритет началу и концу.

>выход -> вход

Конечно же.

Мне, кстати, интересно, как работает этот механизм внимания к контексту.

Много пользовался клодом, у которого 200к контекста. Скажу, что от этого реально польза есть, и тем не менее, моделям поддержание такого контекста даётся с трудом. Соннет, например, чаще проебывется при таком контексте, а опус уделяет больше внимания к нему, при этом сам опус "тупее" и знания у него более старые.

Как работают модели от гугл на 1 млн контекста — не представляю. Это уже смахивает на какой-то пидзеж или сворачивание 900к контекста в подобие лорбука.

Там кстати выпустили новые варианты квен оптимизированные для 1м контекста. На счет полного миллиона не знаю, но видел комментарии что сетки стали лучше чем было воспринимать свой обычный контекст и работать с ним

Проверил бы кто, но нужно очень много памяти

Проверил бы кто, но нужно очень много памяти

Как дистилляты дикпика пишут ролплей? Не в плане кума а в плане креативности?

Ответы: >>1035319, >>1035373

>Просто там подобных много и мне непонятно, стоит ли качать для проверки русика.

С выходом нового малого Мистраля всё старые модели могут превратиться в тыкву. Нужны новые мержи.

Речь об unsloth дистиллятах r1 на ламу/квен размеров 7b 14b 32b

Во-первых это и есть ваша цидонька?

Пишет как 8б

Во-вторых хули срань слева не работает я же вписал

Ответы: >>1035662

Пишет как 8б

Во-вторых хули срань слева не работает я же вписал

>эра русскоязычного кума наступила в этот момент в твоём лице

Спасибо блять, ты сделал мой день.

Прям неиронично со стула от смеха почти упал.

>14.5б/18.5б

Не, я пробовал, там всё ломалось (смотри две модели с upscale в названии). Чтобы выправить повторяющиеся слои нужен файнтюн а не мерж, по видимости.

Самому переводить. Вот несколько от меня:

- https://pixeldrain.com/u/6Gagz3ZP

- https://pixeldrain.com/u/e7ABV1EW

- https://pixeldrain.com/u/Zk8EPK24

>Как дистилляты дикпика пишут ролплей?

Потестил 32 квен, неплохо, подробнее ниже.

----------------------------------------------------------------------------

c4ai-command-r-08-2024.Q4_K_M

Не знаю, может в полных весах и норм, но в 4м кванте шизеть начинает уже с первого сообщения, с командирским пресетом ессно + simple-1 в таверне. Да и русский периодически скатывается до уровня "моя твоя умба-юмба". Слог очень сухой, как в плохих фанфиках: "Он пошёл, он сделал, он молодец." В пезду такую езду.

Mistral-Small-24B-Instruct-2501-Q6_K

Через раз начинает отвечать на английском но если пинать то вроде работает. Но всё равно фразы ломаются. Надо попробовать карточку полностью на русский перевести а не только первое сообщение.

Внезапно, поломы и провалы в логике которые не позволяла себе saiga-unleashed-q6_k.gguf, возможно связанные с рп-данными, ибо например биомех ВНЕЗАПНО полез рукой к пилоту которая сидит в его капсуле в тентаклевом ложементе, манипуляторов типа "рука" не предусмотрено, скорее всего модель просто забыла что юзер не человек в данном сеттинге.

Более-менее адекватный свайп смог выбить только раза с десятого, и это было всего лишь второе сообщение, пресет мистраль, сэмплеры абсолютный дженерик. Третье сообщение тоже кучу времени выдрачивал XD. Но дальше вроде подхватилось и пошло ОК. Периодически почему-то подсирал иероглифами. Но чем глубже в контекст, тем лучше становился язык и меньше свайпов для удовлетворительного результата.

Немного хорни, но в целом ок.

Хотя лупится бобр как курва, я пердолил.

В общем, потанцевал имеется, но нужен русский файнтюн.

DeepSeek-R1-Distill-Qwen-32B-Q4_0.gguf

Может в русский, и неплохо, хотя иногда подсирает иероглифами / переключается на английский и включает размышления до / после рп ответа.

Но логику проёбывает меньше чем Mistral-Small-24B, возможно ризонинг сказывается.

RuadaptQwen2.5_32B_Q4_0.gguf

ВНЕЗАПНО лучшее из здесяперечисленного. Выдало адекватный аутпут с первого же захода, на русском. И почему я не видел упоминания этой эксперименталки в треде? Кто там страдал "вот бы бы 22Б русскую" - вот тебе 32Б. Русская. 2-3 токена в секунду на 12+4 врам / 12К контекста.

>ВНЕЗАПНО лучшее из здесяперечисленного.

Сам себя не похвалишь - никто не похвалит? :)

> 3 пик

Ебать разминка для шеи, когда пытался прочесть это. Спасибо.

>RuadaptQwen2.5_32B_Q4_0.gguf

Имеет смысл, но у меня на q4 из 10 карточек нормально понял и не свалился в шизу только в 5. ему от квантования прям плохо, на q6 уже гораздо бодрее, но все равно, как будто чего-то не хватает.

> почему я не видел упоминания этой эксперименталки в треде

Потому что тред про подрочить, а не про хорошие модели. Я сюда сайгу три раза кидал, прежде чем аноны наконец попробовали, перестав обсирать ее за название. А уж руадапт — ну это вообще что-то на непопулярном! Вот если бы на реддите была новость, что китайская модель на английском не срет в штаны на 65б параметров, то тут бы ее превозносили!..

Так что, ты просто не там искал. =)

А «адекватный аутпут» подразумевает из себя полноценный РП/ЕРП содержательный и логичный?

Потому что получить просто хороший русский ответ можно на любой из моделей выше (кроме мистраля смол), скилл ишью.

>Сам себя не похвалишь - никто не похвалит?

Нет, я Aleteian из шапки, и я абсолютно никак не причастен к проекту RuadaptQwen.

>адекватный аутпут

Я не избалован высокоранговыми моделями, и в основном катал 12Б, как понятно из репы на обниморде. Там на скрине есть вывод руадапта. Мне показалось вполне норм. В хентае пока не тестил, вечером мб пробну.

Кстати, всему треду очень рекомендую послушать:

https://music.yandex.ru/album/35205999

Свидетели сингулярности - Про LLM c Ильёй Гусевым

(автор Сайги, если кто не курсе)

Пока mergekit лежит отдыхает, поделюсь с вами удачными результатами своих издевательств.

https://huggingface.co/OddTheGreat/Unity-12B

кванты https://huggingface.co/mradermacher/Unity-12B-i1-GGUF

Треда два назад про этот мердж писал, работает прилично.

состав (bamec66557/VICIOUS_MESH-12B-OMEGA + inflatebot/MN-12B-Mag-Mell-R1) + (redrix/nepoticide-12B-Unslop-Unleashed-Mell-RPMax-v2 + Epiculous/Crimson_Dawn-v0.2)

https://huggingface.co/OddTheGreat/Pretender-12b

кванты https://huggingface.co/mradermacher/Pretender-12b-i1-GGUF

более скромный мердж, на русском может, но как по мне, хуже. На англюсике весьма хорош.

Состав Khetterman/AbominationScience-12B-v4 +

cgato/Nemo-12b-Humanize-KTO-v0.1

Если есть что качественное, и не замерженное у талантливого товарища выше, пишите, рад буду потыкать и добавить в следующие эксперименты.

У меня 8 врама, поэтому сам юзаю q4_K_M, полёт нормальный. на й8 вообще кайф должно быть.

Ответы: >>1035588

https://huggingface.co/OddTheGreat/Unity-12B

кванты https://huggingface.co/mradermacher/Unity-12B-i1-GGUF

Треда два назад про этот мердж писал, работает прилично.

состав (bamec66557/VICIOUS_MESH-12B-OMEGA + inflatebot/MN-12B-Mag-Mell-R1) + (redrix/nepoticide-12B-Unslop-Unleashed-Mell-RPMax-v2 + Epiculous/Crimson_Dawn-v0.2)

https://huggingface.co/OddTheGreat/Pretender-12b

кванты https://huggingface.co/mradermacher/Pretender-12b-i1-GGUF

более скромный мердж, на русском может, но как по мне, хуже. На англюсике весьма хорош.

Состав Khetterman/AbominationScience-12B-v4 +

cgato/Nemo-12b-Humanize-KTO-v0.1

Если есть что качественное, и не замерженное у талантливого товарища выше, пишите, рад буду потыкать и добавить в следующие эксперименты.

У меня 8 врама, поэтому сам юзаю q4_K_M, полёт нормальный. на й8 вообще кайф должно быть.

>Мне показалось вполне норм.

Этих руадаптов довольно много, какой именно ты пробовал? И почему Q4_0, а не Q4KM например?

Бампую и реквестирую новую модель, которая будет нормально проверять грамматику.

ИМХО, стилистически говно какое-то.

Т.е., квен, все же, рабочая лошадка, за креативность классически бодается немо с геммой, и на этом примере это отлично видно.

Он большой и умный. Он русифицированный и быстро пишет. Он действительно логичен.

Но речевые обороты, которые он использует… Вот если бы сверху весь этот текст переписать другой моделью в литературный вид — было бы круто. А я лично читать такое не могу, сильно выбивает из канвы.

страх уступает место целеутвержденности

твердость, которой ей редко удавалось достичь в социальных взаимодействиях

касаясь головы одного из щупалец нежностью победителя-союзника, осознающего друг друга насквозь

гадким насекомоподобным

Ко многим словам здесь можно найти синонимы, которые будут гораздо лучше, или построить фразы иначе.

Думаю, это и квант сказывается, и это не файнтьюн на РП/фанфикшн, все же.

Но может я зря придираюсь, и так и задумано бай дизайн карточки, хз.

Даже первый скрин выглядит лучше (хотя там качество русского идет по пизде, конечно, к сожалению, поэтому суммарно хуже, лозерунный яд BioMecha=).

Походу в 12б реально нет смысла только если у тебя не 8гб

Цидония в 3 кванте пишет живее и умнее на такой же скорости

Ответы: >>1035462, >>1035516, >>1035528, >>1035542, >>1035672, >>1036127

Цидония в 3 кванте пишет живее и умнее на такой же скорости

Ну вот и всё, не будет 5090. Даже пендосы не могут купить её. А в 5090D производительность в куде порезали наглухо. Искать 48-гиговые перепаи 4090 теперь?

Ответы: >>1035462

>какой именно ты пробовал?

https://huggingface.co/RefalMachine/RuadaptQwen2.5-32B-Pro-Beta-GGUF

>Q4_0

Легаси кванты в кобольде никогда не ломались, а к-кванты периодически да. Хотя вот те что делаются через gguf-my-repo те у меня всегда норм работали, а вот когда у других скачивал, те иногда оказывались шизанутыми.

>Походу в 12б реально нет смысла

При рп на английском языке.

На русском всё же, как это не прискорбно, нормально общаются только прошедшие полировку русским датасетом - сайга и руадапт. Остальное - может, но лучше не надо XD

>Даже пендосы не могут купить её

Directed by Robert B. Weide

Чел, сайгу обсирали потому что она нам известна с 23 года и это всегда была полусломанная при этом невероятно соевая модель. Кроме того, сайга маленькая, половина треда на модели ниже 30b смотрит с улыбкой.

Добавлю, что в реальности некоторые (включая меня) решались таки попробовать 12б сайгу, и она оказывалась калом. Даже на той тестовой площадке с бредовыми промптами Гусева видно, что сайга не очень, мягко говоря. Если там новая версия сейчас, то хз, как она, но у старой русский был чуть ли не хуже, чем у немомикса без ру датасетов. Плюс-минус затащили только мержи.

мимо другой анон

Дистилл диксика ты не с его пресетом использовал, я прав? И на диалоге где уже была история сообщений? Потому что его дефолтное поведение - срать блоками <think> на английском/китайском, это заложено в модель. На готовой истории он может подражать уже написанному тексту.

Попробуй на новом диалоге без истории.

>соевая модель

чел, зацензуренным был вихрь а не сайгак

Тебе в первую очередь интересен 12vh разъем.

Нет, на новой карточке, с пресетом chatml, в таверне вроде нет пресета под квен, хотя давно не обновлял её.

>файнтьюн на РП/фанфикшн

А на Квен вообще есть рп-тюны?

Этот пресет только в staging добавили.

Кому ты рассказываешь, я каждую сайгу кроме последней щупал начиная с первой, каждая отказывалась жесть генерировать.

> Цидония в 3 кванте

Защо ты так с моей любимой девочкой ? По что ты лоботомита мучаешь, ирод ?

Чтоб тебя слопом переехало

Ответы: >>1035543

Никогда не экономил, beQuiet 850, Montech 1000.

…

Julongfengbao LX1800 =D

Тем не менее, последняя версия была хороша, вон, выше даже хвалят, но люди боялись поверить, чисто по инерции хейтили. =)

Почти нет, потому что он сильно цензуренный местами. Квен — отлично подходит для работы внутри компании. Лучший. Но вне своего спектра задач он такое себе.

Ну и плюс, если ты юзал дистилл без синкинга, то ты шо, дурак шо ли? =)

Вся суть в том, что в начале модель рассуждает, а потом дает ответ.

Очевидно, что ей нужен свой темплейт и дать возможность подумать над ответом. Там она может показать класс, возможно.

А иначе — это буквально попытка забивать гвозди микроскопом и «ниче так, увесистая модель!» =)

Я видел гениев, которые YuE музыкальную модель загоняли в llama.cpp и такие «а че мне консоль музыку не играет?»

Тут, конечно, не та ситуация, но суть та же. Буквально некорректное применение инструмента (и не под его задачу), это дает какой-то результат, но вовсе не тот, что хотелось бы.

Ваще, я щас уже оффтоплю, но поясню.

Я беру Qwen2.5-VL-3b, кидаю ему скрин задачки по матанализу и прошу перевести в LaTeX.

Потом кидаю полученный код в R1-distill-Qwen-32b-Q8_0 (потому что могу с 50к контекста), и получаю полное и корректное решение.

Gemma или Nemo так могут? Полагаю, вряд ли.

А теперь я захожу в чат и пишу «ты — рассказчик, описываешь фэнтези мир, продумываешь сюжет заранее и надолго…», и рпшу в диалоге.

Квен так сможет? Конечно, какой-то экспериенс он даст. Будет обдумывать ответы, строить сюжет заранее, да. Но текст напишет сухой, выражения подберет так себе, и, я подозреваю, сюжет будет кратко-академическим. =)

А Гемма с Немо бахнут попсовую, но интересную жвачку.

В общем, надеюсь ты уловил мою мысль. Всему свое место.

Квен почти никто не тюнит, потому что много работы ради одного лишь «ну он круто рассуждает, умный и логичный». Клево, но хотелось бы иметь креативность, богатый литературный язык, отсутствие цензуры и прочие ништяки. А имеем решение матана. =)

Если кто-то сможет собрать датасет и затюнить так, чтобы он писал красиво — думаю, это будет некст левел экспериенс в РП, конечно. Но вряд ли.

Надеюсь, ты называешь смартфоны «шиёми», а фирму фотошопа «адобе». =)

И как оно?

По какой причине немо мистраль начать срать одним и тем же сообщением или просто выдавать 1-2 слова без форматирования? Иногда приходится 5-6 раз свайпнуть или переписать прошлое сообщение, чтобы он начал обратно адекватно себя вести.

Ответы: >>1035566

> Причина баха?

Будь осторожен, ты ходишь по охуенно тонкому blush, и когда blush треснет, то покачивая бедрами под ним, тебя буду ждать я.

>Надеюсь, ты называешь смартфоны «шиёми», а фирму фотошопа «адобе».

Чел, тут географический/исторический топоним, в оригинальном греческом Κῠδωνία, между прочим.

Бля, держите байку, короче.

Как вы смотрите на скраппер на PHP? Вот это глаза у вас огромные теперь…

Спросил я Deepseek-R1 БЕЗ интернета, как можно реализовать.

И начал читать его мысли.

Вообще крайне рекомендую читать рассуждения моделей, потому что они зачастую очень неплохи и помогают учиться корректно находить решения своих задач. Тренируют мозг, короче. Как верные, так и неверные, которые ты смог раскритиковать и опровергнуть.

Ну так вот, он начал с мыслей «есть ли скраперы на PHP? Вряд ли!..» и в итоге посоветовал обращаться к питоновским либам. =D

Меня так умиляет, как они рассуждают. Литералли мем «а что если?.. да ну, хуйня какая-то!» Какие в пизду скрапперы на пыхе. =D

С активным интернетом он нагуглил пару библиотек и описал их.

Как вы смотрите на скраппер на PHP? Вот это глаза у вас огромные теперь…

Спросил я Deepseek-R1 БЕЗ интернета, как можно реализовать.

И начал читать его мысли.

Вообще крайне рекомендую читать рассуждения моделей, потому что они зачастую очень неплохи и помогают учиться корректно находить решения своих задач. Тренируют мозг, короче. Как верные, так и неверные, которые ты смог раскритиковать и опровергнуть.

Ну так вот, он начал с мыслей «есть ли скраперы на PHP? Вряд ли!..» и в итоге посоветовал обращаться к питоновским либам. =D

Меня так умиляет, как они рассуждают. Литералли мем «а что если?.. да ну, хуйня какая-то!» Какие в пизду скрапперы на пыхе. =D

С активным интернетом он нагуглил пару библиотек и описал их.

О ! 6B в 1Q, не признал тебя сразу.

А вы жопочтец? =)

Адобе крик — это географический/исторический топоним, название ручья, в честь которого назвали фирму.

Я в принципе отсылаюсь на то, что произношение на русском не имеет отношения к тому, как произносили в оригинале две тыщи лет назад.

И Ксяёми/Сяоми называется корректно «Шиёми», и Эдоуб называется «Адобе», но почему-то фанаты «произносить верно» кладут хуй на такую вопиющую несправедливость.

Так что, если же хочется называть Кидония — то будьте добры заодно и Шиёми с Адобе. =) Если уж называем корректно, то все названия, так ведь?

Скажем так, у мистралей есть некоторые особенности о которых по какой то блять неведомой причине ценители миксов по мистралям не любят говорить.

Два друга Лупа и Пупа будут с тобой перманентно.

Почему двухтысячелетней давности-то, регион на марсе назван в 20 веке.

Шиёми не географический термин, и у нее нет официального перевода на русский, даже статья в вики на русском не транслитерирует название, так что нет.

А ручей в честь которого названа adobe на русском называется Адоб-крик, так что ты и тут кругом неправ, все как раз правильно его называют.

https://tm.2markers.com/1244776

Я и в 6 кванте гонял, отличий почти нет

красавчик, вторая интересная (pretender) хотя порой странная (ну, неудивительно если учитывать ЧТО туда входит)

Он же говорит тебе be, а не been, ну хоть в переводчик загони, это разные времена.

Конструкция неправильно сделана.

Ало блять я ебнусь если ещё раз прочитаю шиверс чей то спайн

Съешь с полки blush.

5090 просто нет, на ебей по $6200, дижожтс надеюсь кожаный пидрилкин в норм количестве сделает

Ответы: >>1035672

> Все модели в k квантах говно

> Легаси q4_0 хорошие

Ебала жора-юзеров представили просто?

Чифкок поларис про, дешево, сердито, тихо. Хотя уже ни разу не дешево.

Если тебе для рига - бери "фирменные" майнерские, у них с элементной базой все внезапно прилично и адекватное охлаждение. Но вариант не для стояния рядом, под нагрузкой продувает себя на все деньги и шумноват.

Полагаю, стоит подождать дериативов нового мистраля, есть шанс что тут будет еще лучше. Когда разница по весам в 2 раза - это будет и ощущаться иначе, а q3 иногда еще всполне живой.

> Gemma или Nemo так могут?

Еще первая ллама могла, по крайней мере пыталась. С типичными задачаками они в целом справляются, а в чем-то передовом и новом - по крайней мере дистилляты сосут бибу, проверено.

Чтож, придется подождать.

Поясните за world info, как с ним грамотно работать? А то уже сил моих больше нет. Я туда вписываю второстепенных персонажей, ЛЛМ блядь всё путает постоянно, описания персонажей объединят или вообще теряет все время. И у ЛЛМ реально своя версия информации о мире. У меня допустим там 7 позиций, у неё 19. Там например не только персонажи, но и локации всякие, правила. Я прошу проиндексировать, мне пишут мол заебись, но по факту нифига всё по-старому остается. Я в ахуе, что делать? Как подружить ЛЛМ с world info чтоб не было отсебятины и перепутанных описаний персонажей.

Ответы: >>1035692

>жесть генерировать

Чувааак, вот специально ради тебя скачал.

https://litter.catbox.moe/awrgvl.zip - любимая забава испанской инквизиции

Главное - правильно попросить.

Или что для тебя "жесть"?

>буду ждать я

страшно, вырубай

https://www.reddit.com/r/LocalLLaMA/comments/1idseqb/deepseek_r1_671b_over_2_toksec_without_gpu_on/

кек

Ответы: >>1035693, >>1035715

кек

>перепутанных описаний

попробуй заключать в псевдо-теги как здесь

https://characterhub.org/characters/aleteian/storyteller-124d69a2f4aa

>кек

жесть народ пердолится, но чувак смог, уважуха

> на русском называется

Только это индейское слово, и приведенный пример «на русском» ровно так же некорректен, как и все остальное. =)

Реально мем про школоту доющая коня. =) Ну ладно, как пожелаешь, псевдо-интеллектуал, не буду убеждать, мое дело сообщить, а дальше хозяин-барин.

> проверено

Ну, вот я проверял, все там норм.

Предполагаю, скилл ишью, или 4 квант или еще какая хуйня (надеюсь, не 8б мерял?:).

Так что, тут ты просто заблуждаешься.

Рекомендую перепроверить. =)

> what about $1.5k for 4x NVMe SSDs

в натуре кек )

У кого есть готовое — за тех рад, конечно…

классика от анона

> Предполагаю, скилл ишью

Верно предполагаешь. Нужно быть способным во что-то сложнее копирования дефолтных задач из сборников и понимать предмет, одновременно с обладанием навыками работы с ллм. А глупому скуфидону любой копиум покажется мессией, все закономерно.

Сравнивали также по правильной методике как раньше с H100?

Куда тебя ебать?

https://characterhub.org/characters/Anonymous/eleanora-b46ebbc94e36

(карточка не моя)

Нету там ничего, я первым делом проверил.

Если (разумно) опасаешься скачивать, то я закинул содержимое архива (один текстовый файл) на пиксель

https://pixeldrain.com/u/xRtyxHwh

Красиво.

Но ты же понимаешь, что скилл ишью у тебя. =)

Ладно, нюхай свой копиум, что тебе еще остается.

Чем больше людей, которые не шарят, — тем меньше конкуренции. =)

>конкуренция хую в руке

Ещё бы в паре с картами куртки работало это.

ВСем привет, я из /po ,сказали тут лучше помогут, короче пишу статью о китайских ИИ моделях для крупного авторитетного сми, можете помочь покидать ссылки о том почему не стоит им доверять, что заявляемая оупен сорсность их ложь, что падение акций америкаснких ии комапний это мелочь не важная и объясняется почему, что они созданы с поддержкой китайского режима и если есть еще какие-то важные моменты чтобы тоже упонмяуть о них?

Ответы: >>1035746, >>1035750, >>1035771, >>1035800

Кто жпт к треду подключил?

Это толстота? Похоже на толстоту. Ладно, отвечу.

>почему не стоит им доверять

Любой локальной модели, не только дипсику, можно доверять априори. Если ты запускаешь её со своего компа, выключив интернет на всякий случай(сама модель не настучит, но браузер или фронт или в чем ты в чем ты там её запускаешь, может). В любом случае сама по себе модель априори безопасна.

>заявляемая оупен сорсность их ложь

В смысле ложь? А что мы тут запускаем в треде, лол?

>падение акций америкаснких ии комапний это мелочь не важная

Это мелочь, потому что это говно и так было раздуто и ждало малейший повод пойти вниз. Да, Опен АИ может и наебнется, но оно бы и так наебнулось.

>созданы с поддержкой китайского режима

Ты точно в серьезный журнал это писать собрался?

Полагаю тебе стоит охладить траханье и пойти еще в майнерских паскалях поковыряться. Ты же таксуешь всем этим занимаешься просто для души, в перерывах между масштабными внедрениями.

Какие есть русскоязычные, без цензуры модели для 6 ГБ?

Ответы: >>1035819

> почему не стоит им доверять

Он про китайцев, а не про модель, додик. Дальше не читал.

>о китайских ИИ моделях для крупного авторитетного сми, можете помочь покидать ссылки о том почему не стоит им доверять

>китайских ИИ моделях

>почему не стоит им доверять

Он ясно именно про китайские модели высказался, додик, глазки открой. Или для тебя русский язык не родной?

Так и живем. Сел кумить с карточкой мать-дочь, в итоге несколько часов душевно обедал с ними, играл в мяч и прятки. И отвечал на бесконечные вопросы обо всем подряд от мелкой занозы в заднице.

Ответы: >>1035775, >>1035800, >>1035823, >>1035935, >>1035953, >>1036003, >>1036112

сэм, ну ты чего...

Стареешь, видимо. Остепеняться пора, тебе организм сам намекает.

Я в мысли парашников не лезу, чтобы не зашквариться о чан с говном, который у них вместо мозгов, если ты понял своего косноязычного парашного собрата лучше - сам ему и отвечай.

мощный подрыв, больше не умничай в треде и попка будет целой)

Нахуй вы вообще на это отвечаете и срётесь? Это очевидный шизобайт, и попытка выебнуться элитарность. Журналист из крупного, авторитено сми собирает инфу для статьи на двачу. Юорда успешных людей, хули.

Поорал, найс байт!

Ну зочем ты кормишь тролля! =D

Давай я тебе отвечу. =)

> можно доверять априори

Нельзя, ведь цензура искажает факты!

То ли дела светлая цензура пиндостана!.. =D

> В смысле ложь?

Они не выложили датасеты и методику обучения — значит это не open source, а вполне себе closed source. Тебе дали покатать саму модельку, да, но источник неясен.

За это, кстати, критиковали Лламу, что она нихуя не опенсорс. Но это все игра слов, отчасти.

> Это мелочь, потому что это говно и так было раздуто и ждало малейший повод пойти вниз.

Ошибаешься. Дело не в этом, просто финансисты дебилы и не понимают, что «дешевизна» китайской модели обусловлена отсутствием экспериментов и просто следованием по проторенной дорожке, а атомный волчара Сэм, как мощны его лапищи, эту дорогу проложил грудью (майкрософт) и десятками миллиардов долларов.

Как итоге — видеокарты все еще нужны, без них эксперименты будут длиться десятилетиями, а не месяцами.

> Ты точно в серьезный журнал это писать собрался?

Да ну очевидно же троллит. =)

Извини, что правда задела тебя за живое, но ты какую-то хуйню высрал. Чел выше хотя бы просто скинул боевую картинку и просто высрал, хотя бы не выглядит обиженкой. =)

Да я смотрю, ты тоже дед уже.

Ставлю нихуя на то, что один из них — это автор, продолжает байтить.

А может и ты.

А может и я.

Орнул с полотна шизика, опять дамбу прорвало.

была альтернативная история, кум карточка где надо похитить школьницу, но вместо этого успешно довёл до дома, а на следующий день она пришла с мамой у которой уже год после развода не было хорошего траха, и весело провели время

>Ставлю нихуя на то, что один из них — это автор, продолжает байтить.

А может ты вообще нейронка?

>Да я смотрю, ты тоже дед уже.

Я просто не хотел "я тебя ебу - ты меня ебешь" исхода и все делал ненавязчиво, и тут понеслось.

Нани? Почему при очередном запуске кобольда, вся моделька выгрузилась в динам. память, забив на основную память видяхи?

Ответы: >>1035854, >>1036003

Перезапустил и все стало нормально. Но все равно херня какая то.

Это больное животное считает тред своим, а любой пост — личным сообщением.

Кто знает…

Не стоит заниматься успокоением, прими себя. ^_^~

Сука, тред симулякрумов, помогите.

Играл как-то старую карточку девушки юзера и её мелкой сестры, где девушка в сорре с юзером, а лолька его хочет. Играли в настолки все вместе, а потом читал мелкой сказки на ночь, с трудом выдумывая какую-то дичь, как будто это я тут нейронка. Неироничное кьют энд фанни - это база.

Я даже сразу понял о ком ты. https://chub.ai/characters/elodia/moriko-and-reina

Я так Озен уже неделю всё выебать никак не решаюсь, слишком хорошо проводим время, не хочу ломать момент.

>Стареешь, видимо. Остепеняться пора, тебе организм сам намекает.

Ты считаешь что прыгать по комнате, крутить хуём как мартышка и пытаться засунуть его в первую попавшуюся дырку - признак юности и силы? Ну выеби розетку в комнате тогда, хули.

Интересная история всегда будет превыше тупых поебушек, запомни это.

>обедал с ними, играл в мяч и прятки

>Интересная история

дриснул в слюни с писателя

Если у тебя весь ролл заключается в написании одного слова в чат, то мне тебя жаль. Даже самые примитивные вещи могут быть описаны приятно, красиво и литературно.

>MistralRP-Noromaid-NSFW-7B-Q5_K_M

Q5_K_M при весе в 5гб, где наеб?

Ответы: >>1035979

Q5_K_M при весе в 5гб, где наеб?

> 7B

А мне и не надо было практически писать, 1-2 фразы, описание моих действий, и история разворачивалась, мать и дочь реагировали и действовали.

Напомнило какую-то кароточку с мамочкой на чубе, с высоким рейтингом и кучей комментов о том что никто не кумил а наоборот душевно общались и обсуждали жизнь.

Удачное сочетание карточка-модель-промт, наслаждайся, не кумом единым же.

По какой-то странной причине оно резервирует там место, но при этом не обращается. Еще больше года назад такое наблюдал, причем если чистого Жору пускать - подобного нет.

Хотя может у тебя и какой-то другой баг.

Я только сказал привет и всё. Почему эта шизо-программа высралась только в консоль? Такое вообще норм? Как исправить? Дальше вообще какие-то подземелья пошли, опыт, статы.

Ответы: >>1036017

>чат без таверны

откуда вы лезете блять

Установил цидонию Q6_L. По советам с прошлого треда. 23 слоя на видеокарту. 5 т/с. Текст на 230 слов сгенерировал за минуту.

Мне так то норм, но по итт критериям насколько всё плохо?

Если я с винду пересяду на дебиан читсый, в скорости я что то получу? Или всё в рамках погрешности?

Ответы: >>1036033, >>1036048, >>1036296, >>1036588

Мне так то норм, но по итт критериям насколько всё плохо?

Если я с винду пересяду на дебиан читсый, в скорости я что то получу? Или всё в рамках погрешности?

Почти получилось почувствовать, какая у тебя видеокарта, пока не уходи далеко.

Я думаю мы должны использовать технику глубокого предсказательного анализа.

Сейчас Vanga из под доса запущу.

>5 т/с.

Мне за тебя почувствовать норм или нет ?

4070+ддр5. Запущено на кобальде.

А карточку не скинешь? А то у меня такая же ситуация IRL, лол.

Ответы: >>1036166

Сукаблядь

>Pronouns: She/Her

>Sexuality: Bisexual

>Age: 10

Вот как это называется?

Это называется чуб, и там чтобы найти хоть чуток нормальную карточку, нужно ебучие авгиевы конюшки перевернуть.

Претензия была к бисексуальности 10 летнего ребёнка а ещё к ебучему произношению, как будто меня ебёт, ши она или зис, ну да ладно.

Ну думаю это скорее было создано для того чтобы она приняла любого в ее семью, ну а о произношениях стоит винить только загнивающий запад

но слово то греческое

Смотри, скорость очень субъективна. Некоторым хватает и 2т/с, некоторым 20т/с мало.

Решай для себя сам.

>некоторым 20т/с мало

Это кому может быть мало? Это практически моментальная генерация, если мразь на юзере не запрашивает 1-2к токенов в ответе обязательно.

Агенты и любая автоматизированная работа, там чем больше тем лучше, а идеально вобще мгновенно.

Захочешь интернет страницу перевести или кинуть на анализ - взвоешь от ожидания даже на 20т/с.

Меня из общего чата к вам отправили.

Какой поставить дипсик локально? Попробовал трёх:

DeepSeek-R1-Distill-Llama-8B-GGUF/DeepSeek-R1-Distill-Llama-8B-Q4_K_M.gguf - очень быстрый, но пишет как-то невпопад по кодингу (Unity). Часто пишет с ошибками (в тексте), иногда переходит на английские слова и китайские иероглифы.

deepseek-ai.DeepSeek-R1-Distill-Qwen-32B-GGUF/deepseek-ai.DeepSeek-R1-Distill-Qwen-32B.Q4_K_M.gguf - пишет уже более развернуто, адекватно. Но подольше разумеется, минут 5 ждать его ответы.

deepseek-ai.DeepSeek-R1-Distill-Llama-70B-GGUF/deepseek-ai.DeepSeek-R1-Distill-Llama-70B.Q4_K_M-00001-of-00004.gguf - пишет хорошо, почти как и нужно. Но долго капец, минут 15 на ответ и по букве. Подходит для каких-то больших вопросов, где задаешь и идёшь чай пить например.

Вебверсия всем устраивает, разумеется и похуй на конфиденциальность, но сайт лежит очень часто и хочется локальности. Между 32 и 70 есть что-то среднее, чтобы и скорость и ответы по теме? Кто-нибудь тестил ещё?

Запускал через LM Studio в дефолтных настройках, может там че подкрутить можно ещё.

Ответы: >>1036380, >>1036530

Какой поставить дипсик локально? Попробовал трёх:

DeepSeek-R1-Distill-Llama-8B-GGUF/DeepSeek-R1-Distill-Llama-8B-Q4_K_M.gguf - очень быстрый, но пишет как-то невпопад по кодингу (Unity). Часто пишет с ошибками (в тексте), иногда переходит на английские слова и китайские иероглифы.

deepseek-ai.DeepSeek-R1-Distill-Qwen-32B-GGUF/deepseek-ai.DeepSeek-R1-Distill-Qwen-32B.Q4_K_M.gguf - пишет уже более развернуто, адекватно. Но подольше разумеется, минут 5 ждать его ответы.

deepseek-ai.DeepSeek-R1-Distill-Llama-70B-GGUF/deepseek-ai.DeepSeek-R1-Distill-Llama-70B.Q4_K_M-00001-of-00004.gguf - пишет хорошо, почти как и нужно. Но долго капец, минут 15 на ответ и по букве. Подходит для каких-то больших вопросов, где задаешь и идёшь чай пить например.

Вебверсия всем устраивает, разумеется и похуй на конфиденциальность, но сайт лежит очень часто и хочется локальности. Между 32 и 70 есть что-то среднее, чтобы и скорость и ответы по теме? Кто-нибудь тестил ещё?

Запускал через LM Studio в дефолтных настройках, может там че подкрутить можно ещё.

Ну а какой дистилят лучше-то? В соседнем треде вебверсию только обсуждают, им локальная нахуй не нужна

Какой больше, тот и лучше, внезапно.

кто-нибудь шарит в llama.cpp server? Я его гоняю с openwebui, и он после ответа продолжает грузить цпу и гпу как будто генерация продолжается. новые запросы не принимает. так что приходится его рестартовать на каждый запрос - работать невозможно. как понять что там не так и что он вообще генерирует?

Ответы: >>1036408

Чёт не могу понять, какие для руадапта настройки нужны...

Лучше всего то что обычному смертному не нужно. Все что есть мелкое проигрывает существующим моделям.

Опенвебуи может какие то свои левые запросы туда слать, на генерацию названия диалога например

Ну и вобще это поделие только с оллама нормально работает, наверняка с апи лламаспп криво управляется

Лучше тот который ты модешь комфорино запускать. Для кода вобще лучше обычную qwen 2.5 32 coder использовать

Можно и дистилляты, но там сложнее хоть и умнее

От 14b и выше смотри, ниже дистилляты туповаты

Железо в студию, повангуем тебе что стоит пытаться запускать а что нет

1 - р1 с вебсайта

2 - локальный, квантизованный от анслота

они практически идентичны

нет смысла дистилы использовать, кроме недостатка озу. просто докупите памяти и будет буквально модель уровня о1 локально

да, медленно пока. новые поколения гпу будут быстрее гонять такое через несколько лет

Ответы: >>1036447, >>1036458, >>1036475, >>1036488, >>1036530

2 - локальный, квантизованный от анслота

они практически идентичны

нет смысла дистилы использовать, кроме недостатка озу. просто докупите памяти и будет буквально модель уровня о1 локально

да, медленно пока. новые поколения гпу будут быстрее гонять такое через несколько лет

> практически

Зачем же ты тогда второй раз свайпал? Да и ответы похожи только по структуре из-за длинных размышлений, по содержанию довольно большая разница.

Ладно, я понял короче. Паралельно у дистилята дипсика поспрашивал. Думаю, учитывая что в LM Studio можно модели на ходу переключать, то проще спрашивать всё у 32в и если начнёт тупить спрашивать у 70в уже че дальше то делать.

Анслот это вот этот? Ну такой я хуй запущу, у меня 64гб

https://huggingface.co/unsloth/DeepSeek-R1-GGUF

Вопрос слишком простой, 32B даст тебе ответ примерно как жпт на твоём скрине. А q2 у тебя шизит, аналогию про яблоко приплёл не к месту, русский очень странный. Ещё и генерация целую вечность. Я бы не стал лоботомита такого трогать.

Ты лучше на кодинге тестируй, вот там начнётся реальное шитшоу, когда ты будешь умолять дать тебе 70В дистиляцию вместо лоботомита.

Например если ты используешь сетку не для неспешного порночатика, а для обработки чего-то. Особенно если там цепочка промежуточных результатов, а не короткий зирошот.

> кроме недостатка озу

> 512гб для норм кванта

Ради генерации типичного меганасрал поста раз в пол часа или час обработки контекста, хорошая идея.